【论文阅读】RestorerID: Towards Tuning-Free Face Restoration with ID Preservation

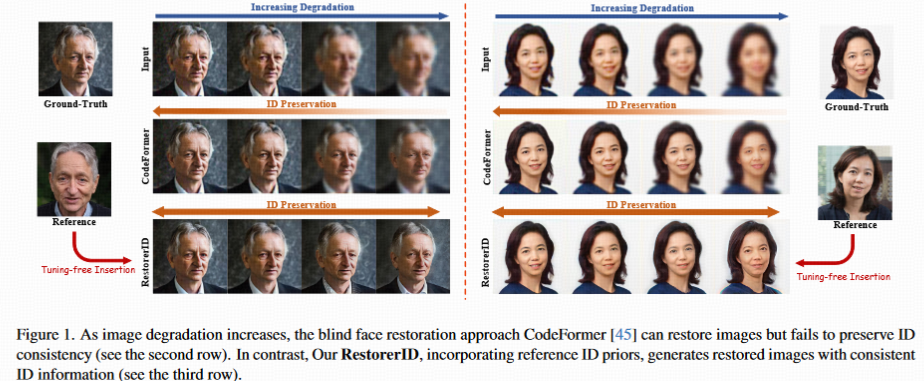

人脸恢复在严重退化情况下(如重度模糊或压缩)仍难以有效保留身份信息。现有参考引导方法(如基于对齐或个性化调优的方案)存在精度不足或耗时过长的问题。为此,本文提出RestorerID,一种基于扩散模型的无调优方法,通过以下创新实现身份信息与图像质量的双重保障:

统一框架设计

将身份注入与基础盲恢复模型结合,通过独立提取低质量(LQ)图像的结构特征和参考图像的身份特征,分别通过残差块(ResBlock)和注意力模块(Attention)注入扩散 UNet,确保特征融合无参数冲突。FIR-Adapter 模块

针对 LQ 与参考图像因光照、姿态差异导致的内容不一致和轮廓错位,设计自适应平衡模块,通过特征交互增强潜在表示,减少信息冲突。自适应 ID 比例调整策略

根据退化程度动态调整身份注入强度,确保在不同退化场景下均能生成最优结果。

参考引导方法的局限

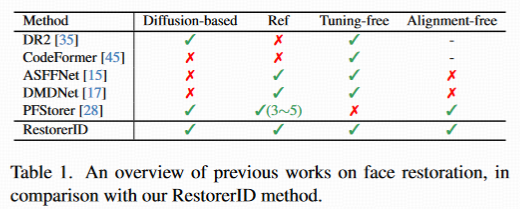

基于对齐的方法(如 ASFFNet、DMDNet)依赖精确对齐,易受姿态差异影响,导致融合效果不佳。

无对齐方法(如 PFStorer)通过个性化模型学习身份表示,避免对齐,但需耗时调优(单身份超 10 分钟 + 3-5 张图),且存在隐私风险。

核心挑战与解决方案

挑战 1:结构与身份信息的融合

- LQ 图像提供结构信息,参考图像提供身份信息,需在统一框架中精准提取并注入,避免特征混淆。

- 解决方案:采用独立空间模型和身份模型,通过 ResBlock 和注意力模块分别注入扩散 UNet,实现特征并行融合。

挑战 2:信息冲突的平衡

- LQ 与参考图像因姿态、光照差异产生冲突,直接注入身份信息会破坏结构。

- 解决方案:设计 FIR-Adapter 模块,通过特征交互动态平衡两类信息,避免轮廓错位和内容失真。

RestorerID 的创新点

扩散模型驱动:利用 UNet 的多尺度特征处理能力,结合残差和注意力机制实现精细化恢复。

自适应策略:根据退化程度调整 ID 注入强度,确保鲁棒性。

无调优与无对齐:相比 PFStorer,无需个性化训练,显著提升效率和隐私保护。

表 1 对比显示,RestorerID 是唯一同时满足无调优、无对齐、高保真恢复的方法。其核心贡献包括:

提出统一框架,实现多退化场景下的身份保留与高质量恢复。

设计 FIR-Adapter 和自适应策略,有效解决信息冲突和退化差异问题。

实验验证在多数据集上超越 SOTA,尤其在严重退化场景中表现突出。

3. Method

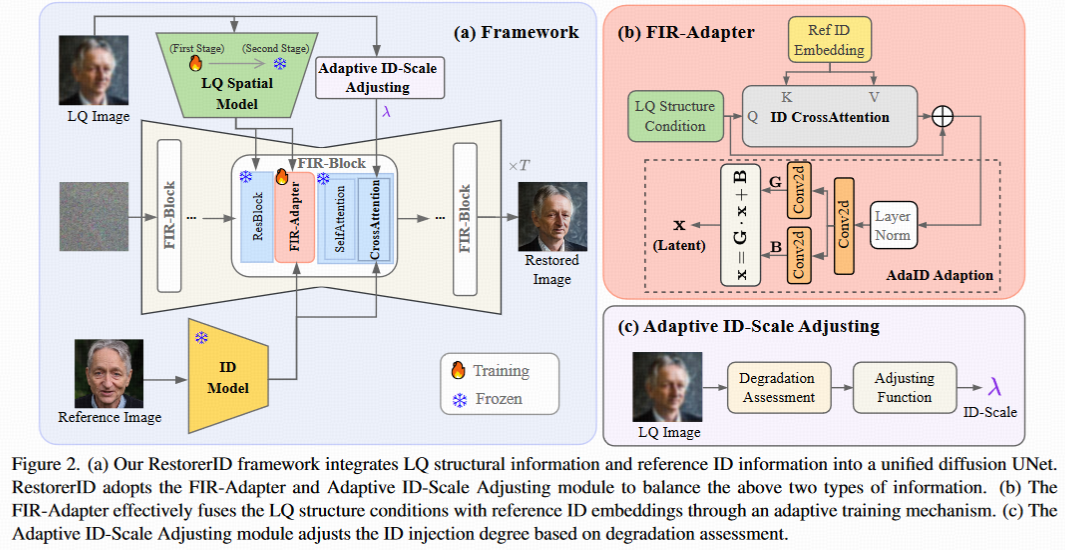

RestorerID 的核心是一个融合参考图像身份先验的人脸恢复框架,主要包含 5 个关键组件:

- Stable-Diffusion(SD)UNet:作为基础扩散模型,负责图像去噪和恢复的主过程;

- LQ 空间模型(LQ Spatial Model):提取低质量(LQ)图像的多尺度结构特征(\(F_{lq}\)),支撑基础恢复任务;

- ID 模型(ID Model):从参考图像中提取身份特征(\(F_{ref}\)),通过解耦交叉注意力(decoupled cross-attention)注入 UNet;

- FIR-Adapter:位于 ResBlock 和 Attention 层之间,用于平衡结构信息与身份信息,解决冲突;

- 自适应 ID 比例调整模块(Adaptive ID-Scale Adjusting):根据退化程度动态调节身份注入强度,优化恢复效果。

Preliminaries

Stable Diffusion 是一种基于扩散过程的生成模型,核心组件包括:

- CLIP 文本编码器:提取文本嵌入(用于文本引导生成);

- VAE(变分自编码器):含编码器(E)和解码器(D),E 将图像压缩到低维潜空间(\(z_t\)),D 从潜向量重建图像;

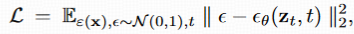

- UNet:在扩散过程中预测噪声,优化目标为噪声预测损失:

图像提示适配器(Image Prompt Adapter) 以 IP-Adapter [39] 为例,其通过解耦交叉注意力将图像嵌入(如身份特征)注入 SD 的 UNet:

Face Restoration Base Model

基础模型是身份保留恢复的核心支撑,需具备强盲恢复能力。

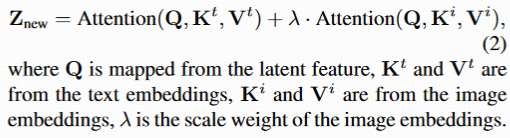

模型构建 参考 PFStorer [28],将 SD 与 StableSR [30] 的 LQ 空间模型结合,重新训练以适配人脸恢复任务。优化目标为:

合成退化数据 为生成高质量(HQ)- 低质量(LQ)训练对,采用二阶退化模型 [34],包含模糊、缩放、加噪、JPEG 压缩等退化步骤。为更贴近真实场景,额外通过 ISP 模型 [7] 将图像从 sRGB 域转换到 RAW 域后加噪,模拟相机成像的真实噪声生成过程。

ID Preservation

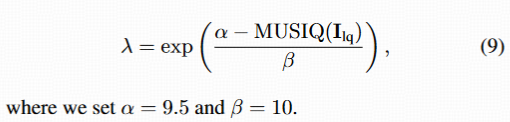

直接注入身份的问题 :参考图像与 LQ 图像可能存在姿态、表情、装饰差异,直接通过 IP-Adapter 注入身份嵌入会导致:

- 面部轮廓错位(如姿态不一致);

- 内容错误(如错误复制参考图像的细节,忽略 LQ 的结构)。 如图 3 所示,注入身份后,恢复结果的结构完整性反而下降。

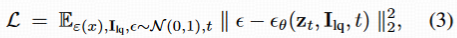

FIR-Adapter 设计:为解决上述问题,设计人脸身份再平衡适配器(FIR-Adapter),通过特征交互平衡结构与身份信息,具体包含两个模块:

ID 交叉注意力(ID Cross-Attention):让 LQ 结构特征 F_lq 与参考身份特征F_ref 交互

AdaIn 适应模块:通过 LayerNorm 和卷积层生成增益 Gi 和偏置 Bi,线性增强潜码 xi 的细节与轮廓:

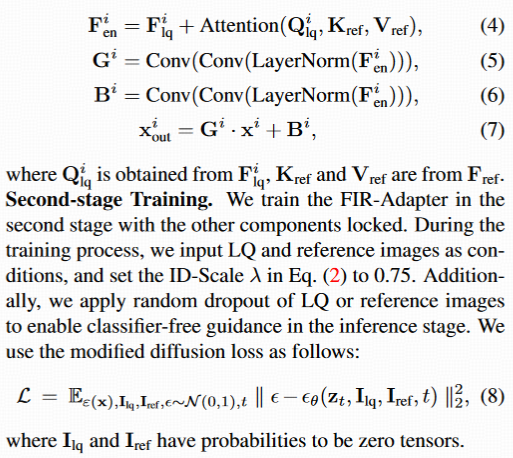

第二阶段训练 冻结基础模型(SD UNet、LQ 空间模型、ID 模型),仅训练 FIR-Adapter。训练时:

- 输入 LQ 图像和参考图像作为条件;

- 固定 ID 比例\(\lambda=0.75\);

- 随机 dropout LQ 或参考图像,支持推理时的分类器 - free 引导(提升生成鲁棒性);

- 损失函数为:

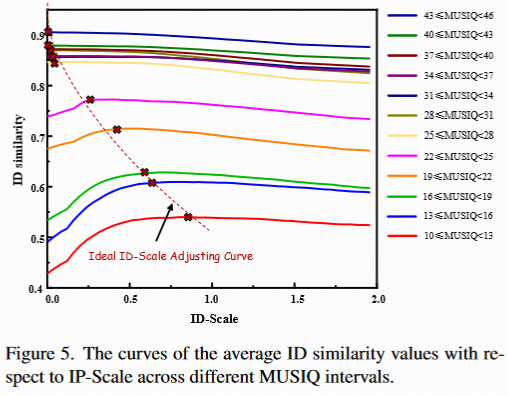

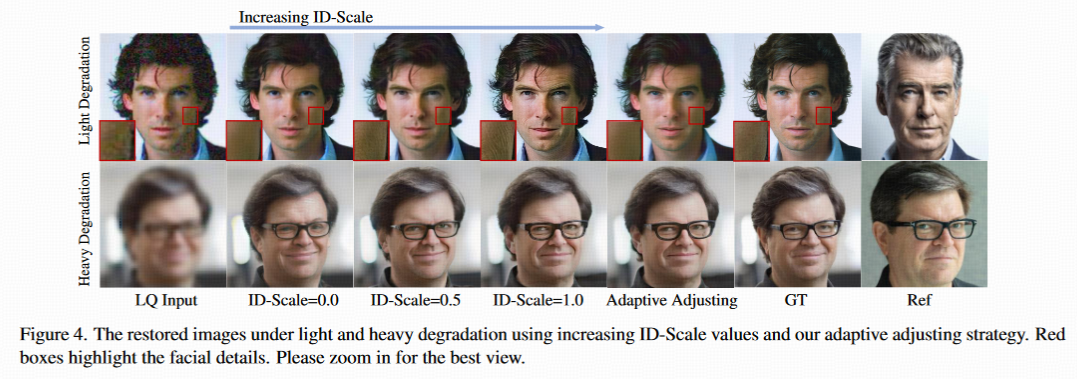

Adaptive ID-Scale Adjusting

ID 比例\(\lambda\)(控制身份注入强度)对恢复效果影响显著:

- 轻度退化时,高\(\lambda\)易导致细节错误(如无中生有皱纹);

- 重度退化时,低\(\lambda\)无法有效保留身份。

因此,需根据退化程度动态调整\(\lambda\),规则为:退化越严重,\(\lambda\)越大。

退化程度量化 采用 MUSIQ metric [12]:值越高,退化越轻;值越低,退化越重。

\(\lambda\)计算公式 通过实验拟合最优\(\lambda\)与 MUSIQ 的关系:

Experiments

本章通过系统的实验验证了 RestorerID 的有效性,包括实验设置、性能对比与消融研究,全面评估其在不同退化场景下的表现。

Experimental Settings

Datasets

- 训练集:

- 基础模型训练:使用 FFHQ [11](高质量人脸)和 VGGFace2 [2](多身份人脸);

- FIR-Adapter 训练:从 VGGFace2 和 Celeb-Ref [16] 中筛选 9,384 个身份,每个身份 5-40 张图像,并用 ArcFace [5] 过滤低质量图像。

- 测试集:

- 合成数据:从 Celeb-Ref 剩余数据中选 50 个身份,每个身份 2 张图(1 张作为真值,1 张作为参考图),生成轻度和重度两种退化的 LQ 图像;

- 真实世界数据:从互联网收集 20 个身份的 LQ 和 HQ 图像,验证实际场景性能。

- 训练集:

Implement Details

- 基于 Stable Diffusion v1.5-base 构建;

- 训练:基础模型迭代 60,000 次,FIR-Adapter 迭代 30,000 次,批次大小 16,优化器 AdamW [19],学习率 5×10⁻⁵;

- 硬件:2 块 NVIDIA 48G-A6000 GPU,训练分辨率 512×512;

- 推理:采用 DDIM [25] 采样(50 步),分类器 - free 引导(λcfg=7.5)。

Evaluation Metrics

- 图像质量:PSNR(峰值信噪比,越高越好)、SSIM(结构相似性,越高越好)、LPIPS [42](感知相似度,越低越好)、MUSIQ [12](图像质量评分,越高越好);

- 结构与身份:LMSE(关键点 MSE,越低越好,衡量轮廓一致性)、ID(ArcFace [5] 余弦相似度,越高越好,衡量身份保留)。

Comparing Methods

- 参考引导方法:ASFFNet [15]、DMDNet [17](需对齐)、PFStorer [28](测试调优,用 5 张参考图);

- 盲恢复方法:CodeFormer [45]、DR2 + SPAR [35](无参考)。

Performance Comparison

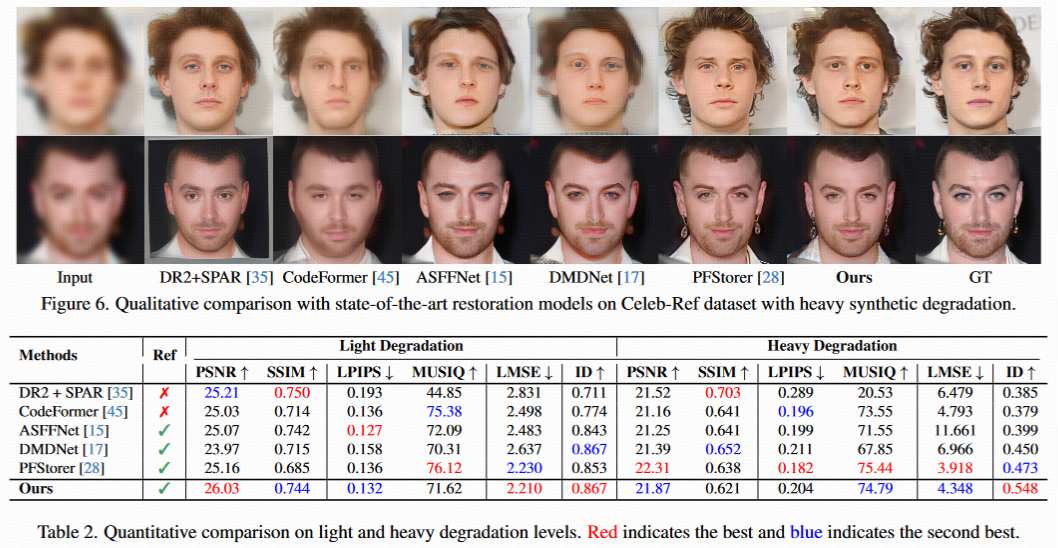

Quantitative

表 2 显示,RestorerID 在不同退化场景下的核心优势体现在身份保留(ID 指标) 上:- 轻度退化:ID 指标领先,PSNR(26.03)等质量指标处于前列;

- 重度退化:ID 指标达 0.548,远超第二名(0.473)0.075,证明其在极端退化下仍能精准保留身份;

- 补充说明:盲恢复方法(如 DR2+SPAR)在 SSIM 上表现更好,但 SSIM 侧重结构清晰度,忽略面部细节自然度和身份保真度,而 RestorerID 在视觉质量与身份保留的平衡上更优。

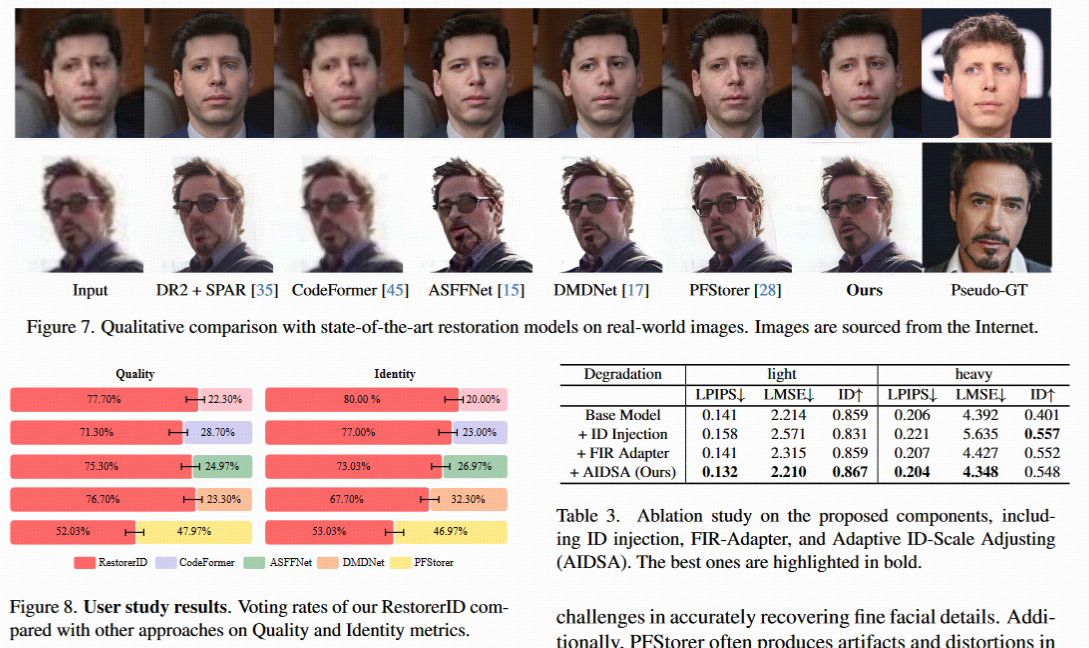

Qualitative

- 重度退化场景(图 6):当 LQ 图像因模糊(如眼、鼻特征丢失)难以识别时,RestorerID 恢复的人脸在身份细节(如眼部轮廓、鼻梁形状)上比盲恢复方法更精准,且优于 PFStorer(减少 artifacts);

- 真实世界场景(图 7):RestorerID 在身份保留和图像质量上均领先,而对比方法(如 CodeFormer、PFStorer)存在细节失真或 artifacts(如面部区域扭曲)。

Ablation Studies

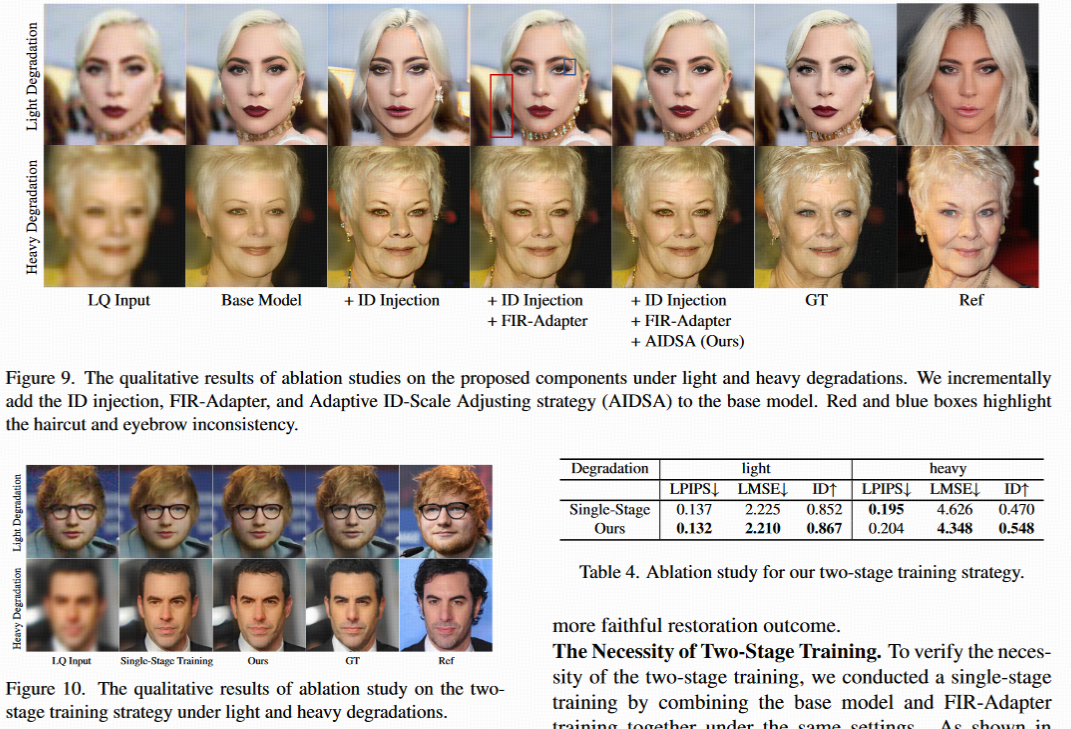

通过逐步添加组件,验证各模块的必要性:

核心组件有效性(表 3):

- 仅基础模型:ID 指标低(重度退化 0.401),无法保留身份;

- 基础模型 + ID 注入:ID 指标提升(重度退化 0.557),但图像质量下降(如 LMSE 升高);

- 基础模型 + ID 注入 + FIR-Adapter:平衡质量与身份(轻度退化 ID 达 0.859,重度退化 LMSE 从 5.635 降至 4.427);

- 全模型(+AIDSA):效果最优,自适应策略进一步优化不同退化下的表现(图 9 显示减少内容不一致,如红 / 蓝框标注的细节错误)。

两阶段训练的必要性(表 4):

- 单阶段训练(同时训练基础模型和 FIR-Adapter)性能全面劣于两阶段训练:重度退化下 ID 指标 0.470(vs 两阶段 0.548),LMSE 4.626(vs 两阶段 4.348);

- 原因:两阶段训练分别专注于盲恢复能力(基础模型)和信息平衡(FIR-Adapter),避免参数冲突;单阶段训练易导致面部细节(如胡须、眼睛)失真(图 10)。