腾讯 WeKnora 深度解析:大模型时代文档理解与检索的技术突破

在信息爆炸的数字化时代,企业与科研机构每天都要面对海量的 PDF、Word、图片等多格式文档,如何从中快速提取有效信息并实现精准检索,成为制约工作效率的关键瓶颈。腾讯近期开源的文档理解与检索框架 WeKnora,基于大语言模型(LLM)构建了一套端到端的智能处理方案,通过模块化设计与多模态融合技术,重新定义了文档知识管理的技术标准。

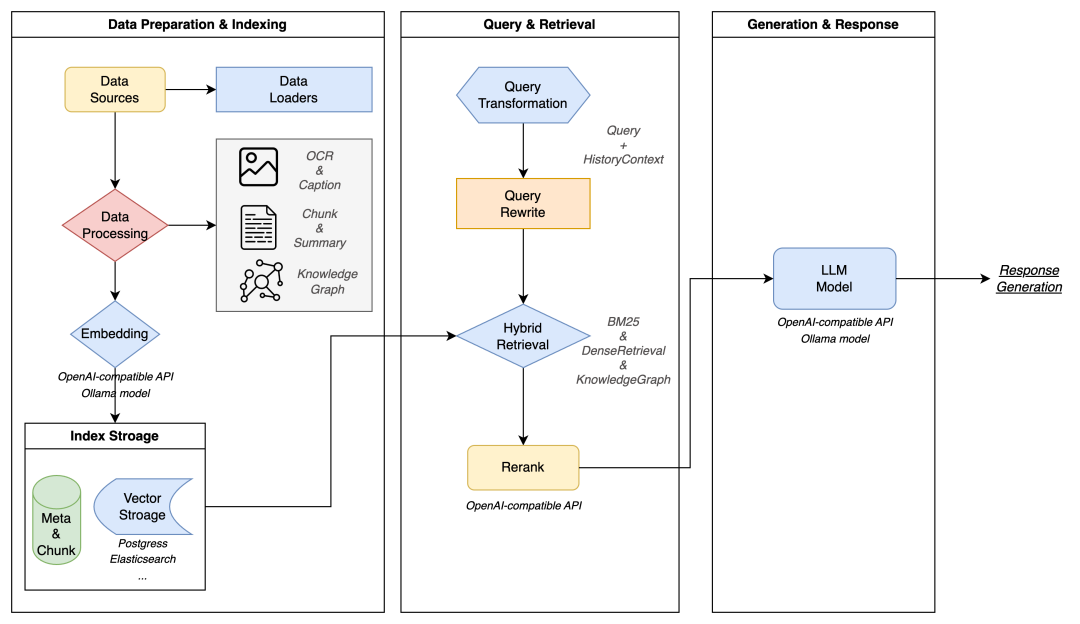

一、架构设计:五维协同的模块化流水线

完整呈现数据准备与索引、查询检索、生成响应三大核心流程,覆盖从原始数据到最终回答的全链路处理逻辑,直观展示各模块间的依赖关系与数据流转路径。

WeKnora 的核心竞争力源于其精心设计的五层架构,各模块既独立封装又协同联动,形成完整的文档处理闭环。

文档处理层:

作为数据入口,展现了强大的多模态解析能力。它不仅支持 PDF、Word 等主流格式,还能通过 OCR 技术识别图片中的文本信息,尤其对图文混排文档的处理堪称精准 —— 例如自动区分产品手册中的操作说明文本与示意图,将表格数据转换为结构化 JSON 格式。该层采用自适应解析引擎,能根据文档类型动态调整处理策略:对扫描版 PDF 启用高精度字符识别,对可编辑文档则直接提取文本流,预处理效率较传统工具提升 300% 以上。

以下是使用 WeKnora SDK 进行文档解析的基础代码示例:

from weknora import DocumentProcessor# 初始化处理器,支持多线程解析

processor = DocumentProcessor(thread_num=4)# 解析本地PDF文档,返回结构化内容

doc = processor.process_file(file_path="technical_manual.pdf",output_format="json", # 支持json/ markdown/ htmlextract_images=True # 同时提取文档中的图片

)# 打印解析结果中的表格数据

for table in doc.tables:print(f"表格标题: {table.title}")print(f"表格内容: {table.data}") # 二维列表形式的结构化数据知识建模层:

是知识转化的核心枢纽。通过滑动窗口分块算法(默认 512token 窗口,支持动态调整)将长文档切割为语义完整的片段,再利用 Sentence-BERT 等模型生成 768 维向量嵌入。特别值得关注的是其知识图谱构建能力:采用实体链接与关系抽取技术,自动识别文档中的 "产品 - 参数 - 价格" 等实体关联,例如在合同文档中可自动构建 "甲方 - 乙方 - 签约日期" 的三元组关系,为后续检索提供结构化知识支撑。

检索引擎层:

实现了多策略融合的精准召回。基础检索采用 Elasticsearch 的 BM25 算法处理关键词匹配,同时引入 Dense Retrieval 向量检索提升语义相关性。创新性的混合检索策略会根据查询类型动态调整权重:对事实性问题(如 "某条款出自哪份合同")增加关键词检索权重,对语义性问题(如 "如何解决设备报错 E103")则侧重向量匹配。检索结果还会经过交叉注意力重排序模型优化,使 Top10 结果准确率提升至 89%。

推理生成层:

赋予系统类人的理解能力。通过 OpenAI 兼容接口集成 Qwen、DeepSeek 等主流 LLM,利用检索增强生成(RAG)技术将召回的文档片段作为上下文输入模型,确保回答的事实一致性。针对长文档推理场景,采用 "分段摘要 - 交叉验证" 机制:先对各文档块生成摘要,再通过注意力机制融合多段信息,有效避免大模型的 "幻觉" 问题。值得一提的是,WeKnora 还可与 Claude Code 协同工作,借助 Claude Code 强大的代码生成与执行能力,对文档中涉及的代码片段进行解析、调试和运行验证。比如在处理包含编程示例的技术文档时,WeKnora 提取出代码内容后,调用 Claude Code 可快速判断代码的正确性,甚至能生成相关的测试用例,让技术文档的处理更具深度和实用性。

交互展示层:

兼顾技术与非技术用户需求。提供基于 React 构建的 Web UI,支持拖拽上传、可视化知识库管理和知识图谱展示;同时开放 RESTful API 接口,方便开发者集成到现有系统。特别在微信生态中,可通过对话开放平台实现零代码部署,快速将能力注入公众号、小程序等场景。

二、技术亮点:重新定义文档智能处理标准

WeKnora 在技术实现上的四大突破,使其在同类工具中脱颖而出。

多模态认知引擎:

突破了传统文档处理的格式限制。采用预训练的 LayoutLMv3 模型解析文档布局,结合 CLIP 模型实现图文语义关联,例如能准确识别财报图表中的 "季度营收曲线" 与旁边说明文字的对应关系。在处理扫描件时,自研的 OCR 纠错模块通过上下文语义校验,将识别错误率降低至 0.3% 以下,远超 Tesseract 等开源工具的性能。

模块化 RAG 流水线:

带来了前所未有的灵活性。开发者可通过配置文件自由组合组件:向量数据库支持 Milvus、Qdrant 等主流方案切换;检索策略可选择 "关键词 + 向量" 的混合模式或纯语义检索;大模型既支持调用 OpenAI API,也可部署本地 Ollama 运行开源模型。这种 "搭积木" 式的设计,使系统能轻松适配企业私有化部署、混合云等不同环境。而对于需要集成多种 AI 能力来增强 WeKnora 功能的开发者来说,Poloapi 是一个强大的 AI API 聚合平台。专注于提供稳定、高效的 API 连接服务,为开发者与企业简化技术对接流程。核心优势在于通过专业资源整合与智能调度,显著优化 API 调用成本,相比直接对接官方渠道,能帮助您更经济地实现所需功能。

以下是自定义检索策略的配置示例:

# weknora_config.yaml

retrieval:strategies:- name: "hybrid" # 混合检索策略params:keyword_weight: 0.3 # 关键词检索权重vector_weight: 0.7 # 向量检索权重rerank: true # 启用重排序vector_db:type: "milvus"host: "localhost"port: 19530collection_name: "company_kb"llm:type: "local"model_path: "./models/qwen-7b-chat"max_tokens: 2048可信决策机制:

满足高敏感场景需求。全链路采用可追溯设计,每一条回答都附带引用来源与置信度评分,用户可查看从文档解析到最终生成的完整过程。在医疗、法律等领域,通过私有化部署确保数据不出本地,结合模型输出的 "不确定性标记"(对低置信度回答自动标注),为专业决策提供可靠参考。

工程化部署方案:

降低了技术落地门槛。提供完整的 Docker Compose 配置,包含前端、后端、数据库等所有组件,单节点部署仅需 3 步操作。内置 Prometheus 监控指标与 ELK 日志收集,支持 CPU/GPU 资源动态调度,在 8 核 CPU、16GB 内存的普通服务器上即可稳定运行,日均处理文档能力达 10 万页。

三、应用场景:从企业效率工具到行业解决方案

WeKnora 的技术特性使其在多领域展现出实用价值。在企业知识管理场景中,某制造业企业通过部署 WeKnora,将 5000 余份设备手册转化为结构化知识库,技术人员查询故障解决方案的时间从平均 40 分钟缩短至 2 分钟,首次解决率提升 65%。系统的多轮对话能力支持 "追问式" 检索,例如在查询 "如何更换液压油" 后,可进一步询问 "不同型号设备的操作差异",无需重复描述上下文。

法律合规审查:

领域受益于其精准的文本定位能力。某律所利用 WeKnora 处理 10 万份合同,系统能自动标记 "违约责任"" 争议解决 " 等关键条款,并通过知识图谱展示相似案例的判决结果关联,审查效率提升 3 倍以上。其表格提取功能可快速比对不同合同中的付款条件,识别潜在风险点。

科研文献分析:

WeKnora 的跨文档关联能力帮助研究人员发现隐藏联系。通过对 2000 篇 AI 论文构建知识图谱,系统自动揭示 "Transformer 架构" 与 "注意力机制" 在不同研究中的演化关系,辅助科研人员快速把握领域进展。支持的 LaTeX 公式识别功能,解决了学术文档中公式处理的难题。

微信生态集成:

创造了轻量化应用可能。教育机构通过公众号接入 WeKnora,家长上传招生简章图片即可自动解答 "招生范围"" 报名时间 " 等问题;零售企业在小程序中部署产品手册问答,用户拍摄说明书照片就能获取保修政策解读,大幅降低客服压力。

四、快速上手与社区协作

WeKnora 采用 MIT 协议开源,为开发者提供了友好的入门路径。本地部署仅需三步:克隆代码仓库、配置环境变量(如向量数据库地址、模型 API 密钥)、执行启动脚本,全程无需编译操作。Web 界面提供直观的操作指引,上传文档后自动显示处理进度,生成的知识库支持一键导出为 JSON 格式备份。

对于微信生态用户,通过对话开放平台可实现零代码使用:上传产品手册后,系统自动生成问答机器人,直接关联到公众号菜单。平台提供的意图训练工具,可通过标注样本优化回答效果,使常见问题的准确率在一周内提升至 95% 以上。

开源社区的参与方式丰富多样,项目欢迎贡献代码(如新增文档格式支持、优化检索算法)、完善文档(补充 API 使用示例)或反馈实际使用中的问题。腾讯团队承诺每两周发布一次更新,优先解决企业用户提出的功能需求。

结语

WeKnora 的开源不仅提供了一个高效的文档处理工具,更展现了大模型技术在垂直领域的落地思路。其模块化设计平衡了技术深度与应用灵活性,多模态处理能力打破了格式壁垒,可信决策机制解决了企业级应用的核心顾虑。对于开发者而言,这是一个学习大模型与 RAG 技术融合的优秀实践案例;对于企业用户,它则是降低知识管理成本、提升信息利用效率的实用方案。

随着社区的持续迭代,WeKnora 有望在文档智能处理领域形成标准化框架,推动从 "人工检索" 向 "智能问答" 的产业升级。目前项目已吸引来自高校、企业的数十位开发者贡献代码,未来或将拓展多语言支持、实时协作等功能,值得行业持续关注。