什么是爬虫协议?

什么是爬虫协议?

爬虫协议(Crawl Protocol)是指为了有效地收集网页内容而建立的一些规定和标准,用以指导网络爬虫如何在互联网上抓取信息。

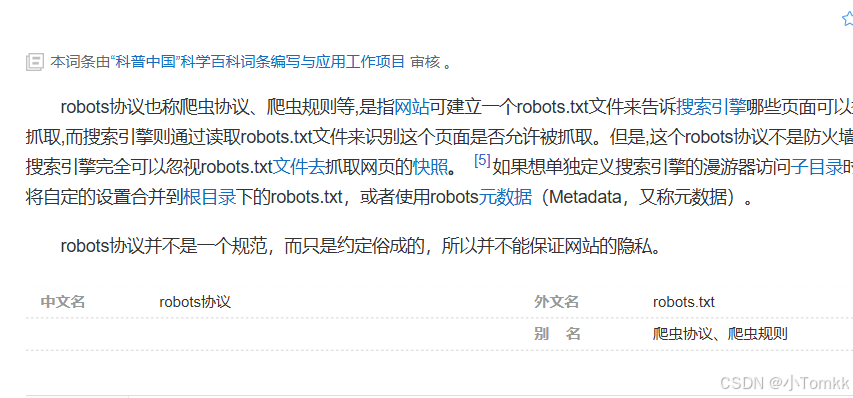

爬虫协议主要指的是Robots协议(Robots Exclusion Protocol),是网站和网络爬虫之间的一套"君子协定",用来规范爬虫的访问行为。

根据 百度百科的定义

基本语法规则

# 注释行,以#开头

User-agent: * # 指定爬虫类型,*表示所有爬虫

Disallow: /private/ # 禁止访问的路径

Allow: /public/ # 允许访问的路径(可选)

Crawl-delay: 10 # 建议的访问间隔时间(秒)

Sitemap: https://example.com/sitemap.xml # 网站地图位置

| 指令 | 含义 | 示例 |

|---|---|---|

User-agent | 指定目标爬虫 | User-agent: Googlebot |

Disallow | 禁止访问的路径 | Disallow: /admin/ |

Allow | 明确允许的路径 | Allow: /public/ |

Crawl-delay | 访问间隔建议 | Crawl-delay: 5 |

Sitemap | 网站地图位置 | Sitemap: /sitemap.xml |

文章目录

- 什么是爬虫协议?

- 1. 爬虫协议robots.txt

- 2. User-Agent

- 3. Crawl-delay

- 4. HTTP 标头协议

- 5. IP 限制与反爬虫机制

- 6. 验证码与挑战

- 7. API 限制

- 8. 法律和道德

- 9. 示例说明

- 一个爬虫案列

- 总结

1. 爬虫协议robots.txt

功能: robots.txt 是网站放置在根目录下的一个文本文件,用来指定哪些内容允许被搜索引擎的爬虫抓取,哪些内容不允许被抓取。

robots协议,全称是Robots Exclusion Protocol,是网站用来告诉网络爬虫哪些页面可以访问,哪些不能访问的标准。它通过网站根目录下的robots.txt文件来实现。

工作原理: 爬虫在访问网站时会先请求 robots.txt 文件,检查是否有访问限制。

常见规则:

User-agent: 指定爬虫的名称。

Disallow: 指定不允许爬虫抓取的路径。

Allow: 指定允许爬虫抓取的路径。

例子:

User-agent: *

Disallow: /private/

Allow: /public/

2. User-Agent

功能: User-Agent 是一种 HTTP 请求头,标识了发出请求的客户端(通常是浏览器或爬虫)的信息。网站可以通过 User-Agent 来识别和限制不同的爬虫。

工作原理: 网站可以根据爬虫的 User-Agent 来拒绝或限制某些爬虫的访问,避免过多流量或滥用。

常见做法: 网站可能会禁止某些爬虫,或者根据爬虫的身份提供不同的内容。

3. Crawl-delay

功能: 这是 robots.txt 中的一个指令,用来告诉爬虫在访问每个页面后应该等待多少秒才可以继续抓取下一个页面。

工作原理: 通过设置 Crawl-delay,网站管理员可以控制爬虫访问频率,避免过度抓取导致服务器负担过大。

例子:

makefile

复制

编辑

User-agent: Googlebot

Crawl-delay: 10

4. HTTP 标头协议

功能: HTTP 请求头中包含的信息,如 Referer, Host, Accept 等,爬虫需要根据这些协议来构造自己的请求,以确保模拟一个正常用户的浏览行为,避免被检测和屏蔽。

工作原理: 通过伪造真实的 HTTP 请求头,爬虫可以避免被检测为非正常用户访问。

例子:

makefile

复制

编辑

User-Agent: Mozilla/5.0 (Windows NT 10.0; Win64; x64)

Referer: https://www.example.com

5. IP 限制与反爬虫机制

功能: 许多网站通过检查 IP 地址来限制爬虫的访问,过度抓取可能会导致 IP 被封禁。

工作原理: 如果爬虫的请求频率过高,服务器可能会将其 IP 地址列入黑名单,阻止其继续访问。为了绕过这种限制,爬虫可能需要使用代理池。

常见做法: 反爬虫技术会通过分析访问模式、请求头等信息来识别和拦截爬虫。

6. 验证码与挑战

功能: 为了防止自动化爬虫的行为,许多网站会在登录、提交表单或访问特定页面时显示验证码(CAPTCHA)。

工作原理: 爬虫需要通过人工或自动破解 CAPTCHA 来继续抓取数据,但这一过程复杂且常常导致爬虫的失败。

常见类型: 图片验证码、滑动验证码、行为验证码等。

7. API 限制

功能: 许多网站提供公开的 API 供开发者使用,但有时会对 API 请求进行限制,例如请求次数、请求频率等,以防止滥用。

工作原理: 使用 API 时,通常会有一定的速率限制(Rate Limiting),当请求超过限制时,API 会返回错误或暂时阻止访问。

8. 法律和道德

功能: 许多国家或地区对爬虫的使用有法律约束,特别是爬取用户数据或个人信息时。

工作原理: 爬虫需要遵循相关的法律法规,并遵守网站的隐私政策以及数据使用协议。

9. 示例说明

我们是可以访问

https://www.python.org/robots.txt

# Directions for robots. See this URL:

# http://www.robotstxt.org/robotstxt.html

# for a description of the file format.User-agent: HTTrack

User-agent: puf

User-agent: MSIECrawler

Disallow: /# The Krugle web crawler (though based on Nutch) is OK.

User-agent: Krugle

Allow: /

Disallow: /~guido/orlijn/

Disallow: /webstats/# No one should be crawling us with Nutch.

User-agent: Nutch

Disallow: /# Hide old versions of the documentation and various large sets of files.

User-agent: *

Disallow: /~guido/orlijn/

Disallow: /webstats/

那我们在分析一下这个段什么意思

主要分 5部分

1.开头的注释部分

# Directions for robots. See this URL:

# http://www.robotstxt.org/robotstxt.html

# for a description of the file format.

这个注释有什么作用?

这是标准的文档说明,指向了robots协议的官方规范。作为技术管理者,您应该知道这种文档化的重要性——它帮助开发者理解协议的标准用法。

2.对特定User-agent的限制(HTTrack, puf, MSIECrawler)

User-agent: HTTrack

User-agent: puf

User-agent: MSIECrawler

Disallow: /

为什么要专门禁止这些爬虫?

这是基于历史经验的决策:

HTTrack:网站复制工具,可能会下载整个网站

puf:可能是某个有问题的爬虫

MSIECrawler:微软的早期爬虫,可能有兼容性问题

Disallow: / 表示禁止访问整个网站。

3.对Krugle爬虫的特殊允许

# The Krugle web crawler (though based on Nutch) is OK.

User-agent: Krugle

Allow: /

Disallow: /~guido/orlijn/

Disallow: /webstats/

白名单机制

这里为什么给Krugle特殊待遇?

Krugle是一个代码搜索引擎,对Python社区有益。注意这里的策略:

Allow: / - 基本允许访问

但仍然禁止访问私人目录和统计数据

4.对Nutch爬虫的禁止

技术决策:Nutch的禁止

# No one should be crawling us with Nutch.

User-agent: Nutch

Disallow: /

为什么单独禁止Nutch?注释说得很直接。

Nutch是Apache的开源爬虫框架,但Python.org显然有过不好的经验。

可能是因为:

默认配置过于激进

缺乏适当的限速机制

或者曾导致服务器负载问题

5.对所有爬虫的通用规则

User-agent: *

Disallow: /~guido/orlijn/

Disallow: /webstats/

两个目录有什么特殊性?

/~guido/orlijn/ - 这是Guido van Rossum(Python创始人)的个人目录,显然包含私人内容

/webstats/ - 网站统计数据,属于内部信息

一个爬虫案列

使用 Trea cn 设计 爬虫程序 so esay

总结

爬虫协议是为了确保网络爬虫能够合法、有效地从互联网上抓取信息的规则。遵守这些协议不仅可以避免法律风险,还能确保爬虫行为不对目标网站造成过多负担。在进行爬虫抓取时,始终应当尊重网站的 robots.txt 文件、爬取频率及使用API接口时遵循相关的限制。