华为昇腾×绿算全闪存缓存释放澎湃潜能

人工智能正以前所未有的速度重塑世界:从千亿级大模型到多模态生成,算力已成为驱动AI跃迁与产业革新的核心引擎。算力每提升一个量级,模型能力通常伴随一次显著跃迁,AI落地边界随之向外扩展。在这场全球竞赛中,华为昇腾凭高密互联、极致能效与开放生态,稳居中国AI算力基座,为澎湃需求持续供能。

【算力洪流下的暗礁】

算力与模型规模同步激增,训练数据量级随之跃迁,存储带宽却未能同频扩张,导致昂贵算力长时间处于数据等待状态,投资回报率被显著拉低。华为昇腾虽凭高密互联与高能效构筑强劲引擎,亦受限于现有存算耦合架构。业界正将封闭存储节点解耦为独立资源池,通过高速协议直连算力节点,以缩短数据路径、提升并发吞吐,为下一轮算力跃升扫清I/O障碍。

【Cache双塔:零等待数据引擎】

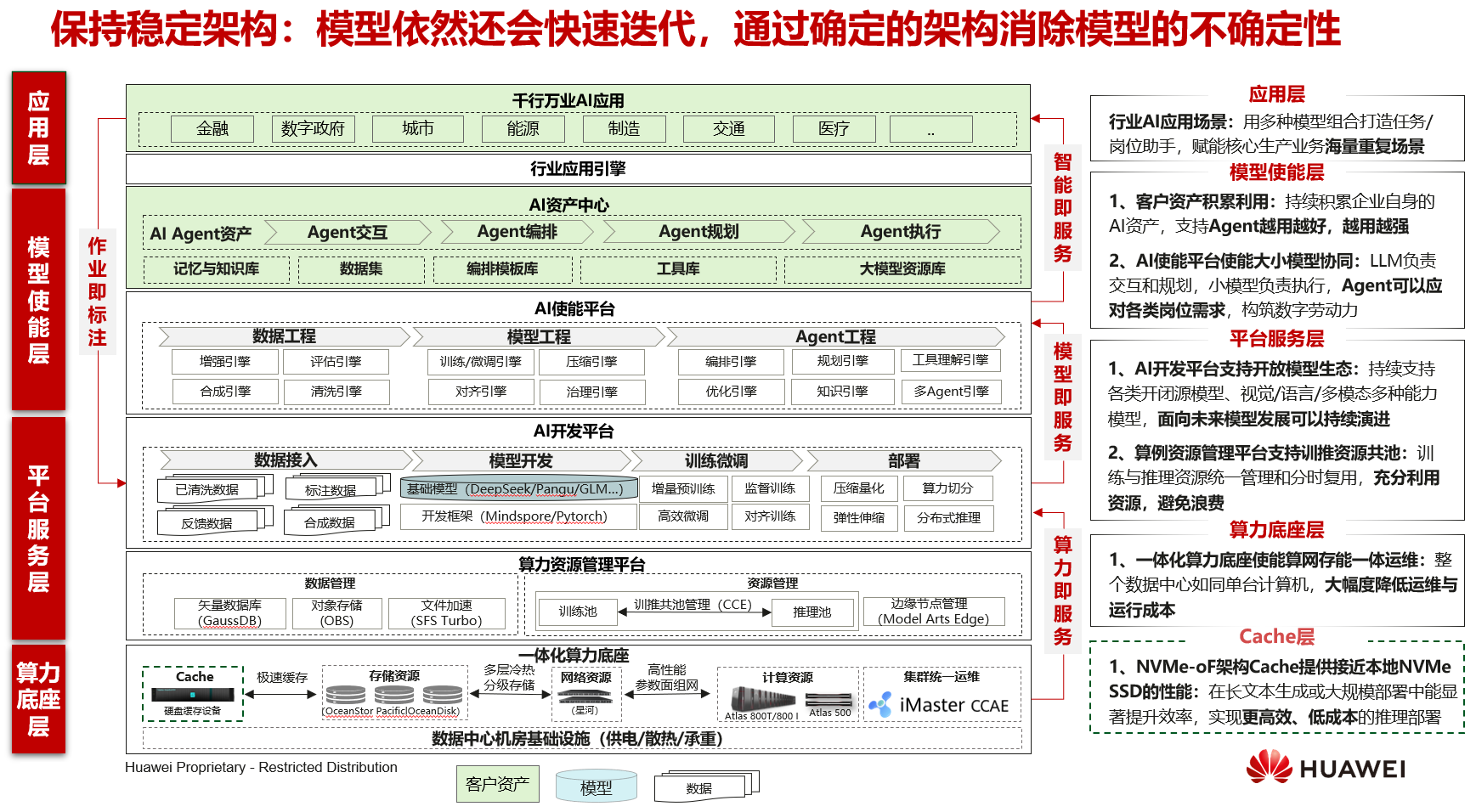

昇腾大模型逻辑架构图

当大模型进入万亿参数阶段,Checkpoint回写与权重热加载常令昇腾算力空转。绿算全闪存硬盘缓存以NVMe-oF为轴,构建“Cache双塔”:横向直连Atlas训推池,纵向对接OBS对象仓与SFS Turbo,完成冷热数据分层和模型切片按需挂载。训练启动时间显著缩短,推理扩容更加灵活,GPU/昇腾利用率稳步提升,运维压力同步下降,整体TCO持续优化。

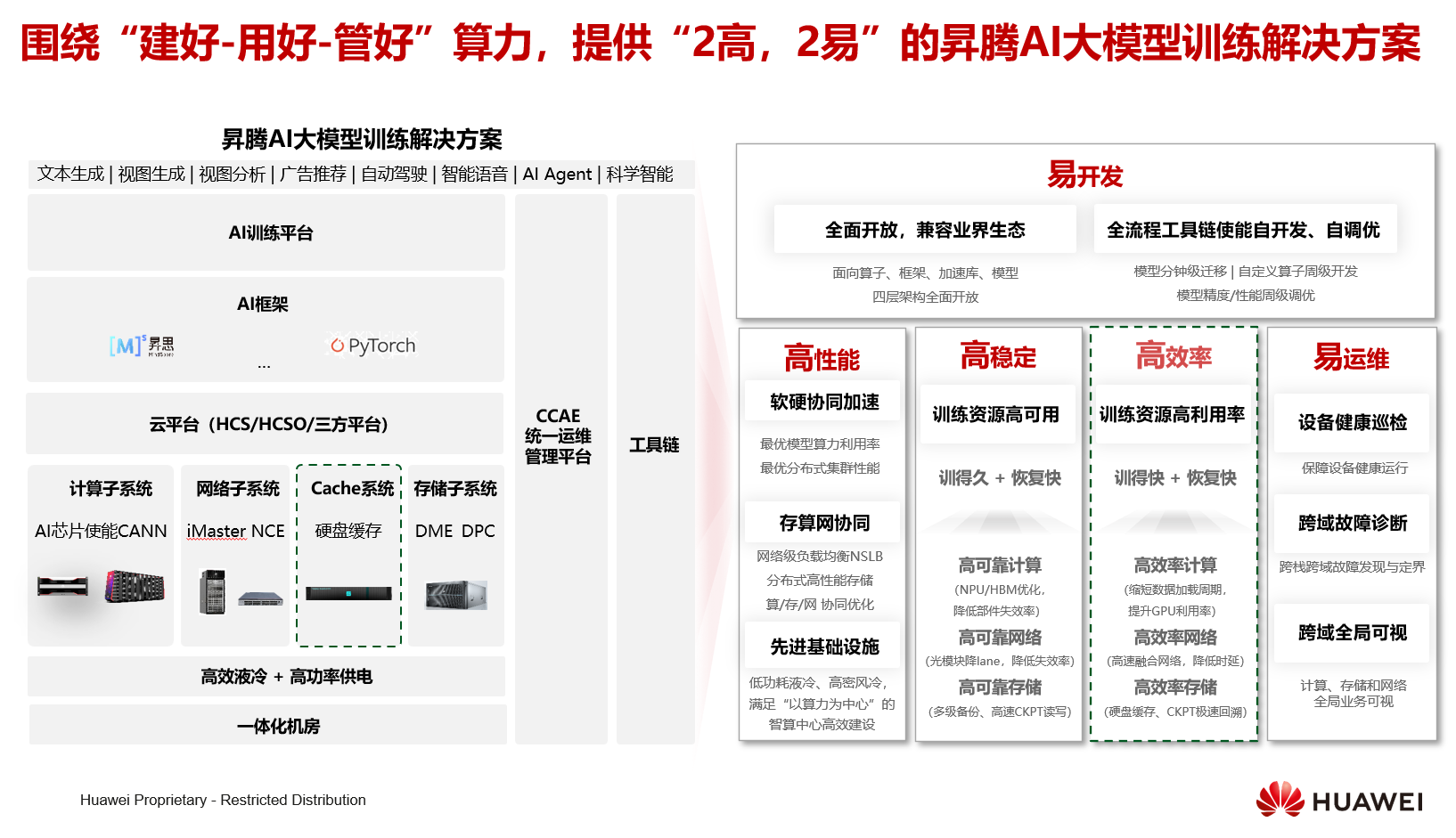

【建好-用好-管好:华为昇腾×绿算缓存-算存双环智算底座】

围绕“建好-用好-管好”全生命周期,华为昇腾作为算力中枢。建好阶段,昇腾AI芯片与绿算全闪存硬盘缓存、华为分布式高性能存储共同构成“算存双环”,实现多级备份和极速回写,千卡训练“训得快、恢复快”。用好阶段,昇腾CANN软硬协同,训练平台分钟级模型迁移、周级算子调优,长文本、自动驾驶等场景直接在昇腾算力上高效运行。管好阶段,iMaster NCE全局可视,实时巡检Cache健康与网络负载,让昇腾集群在一体化机房中持续高可靠、高效率、易运维地运转。

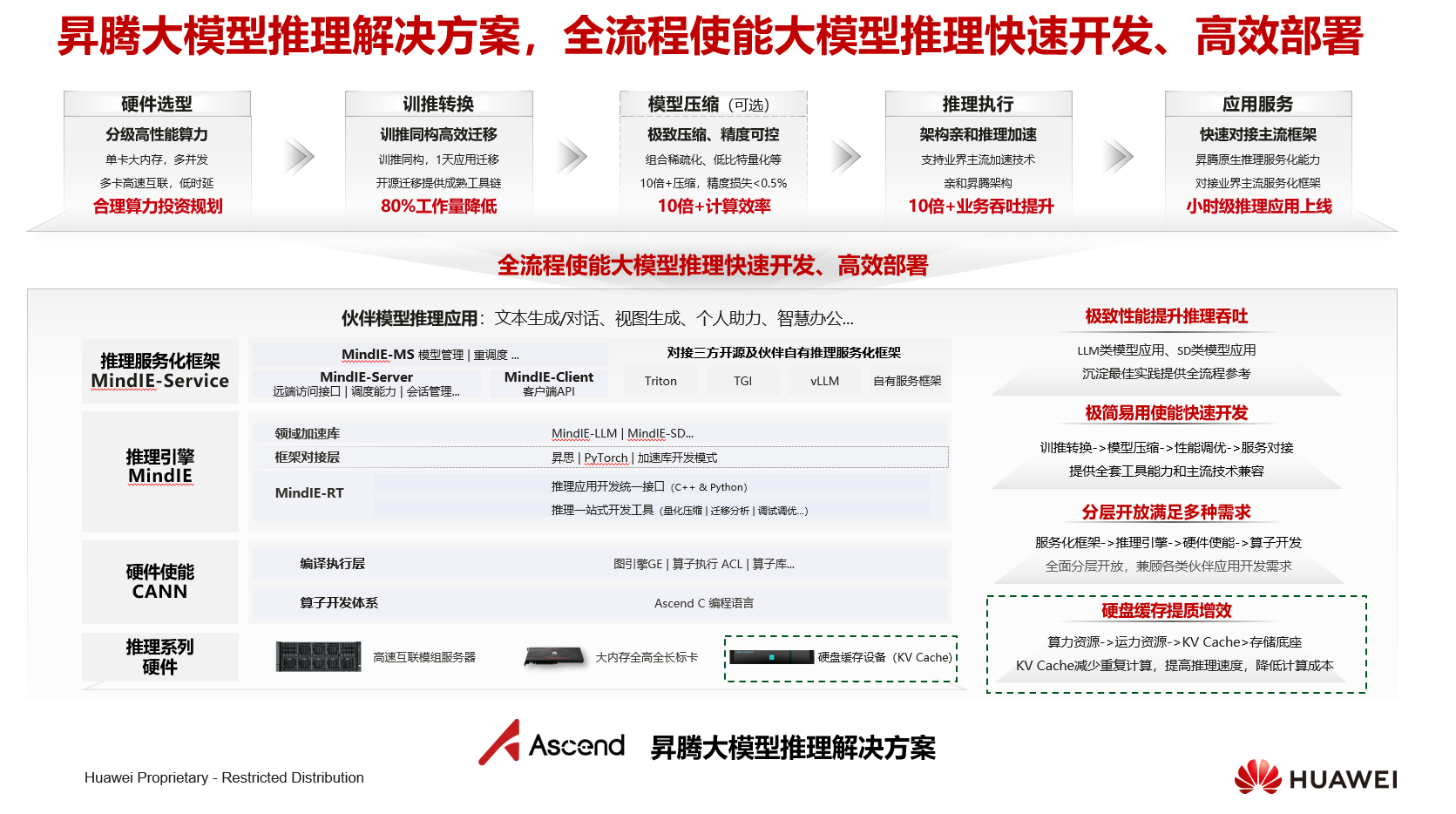

【昇腾大模型推理底座全景】

华为昇腾以“训推同构”为轴心,将绿算全闪存硬盘缓存纳入KVCache-运力-算力一体化底座:缓存层通过NVMe-oF直连推理节点,实现KV缓存的高速换入换出,显著减少重复计算;配合MindIE-Service一键压缩、量化、部署,单卡即可支撑大内存多并发,小时级完成应用迁移。服务化框架(MindIE-Server/Triton/VLLM)与CANN加速库协同,使文本生成、视图生成等典型场景吞吐提升十倍以上;统一运维平台实时监控缓存健康与网络负载,保障推理服务 7×24 高可靠、高效率、易运维运行。