Unity3D + VR头显 × RTSP|RTMP播放器:构建沉浸式远程诊疗系统的技术实践

一、背景:远程医疗迈入“沉浸式协同”的新阶段

过去,远程医疗主要依赖视频会议系统,实现基础的远程问诊、会诊或术中指导。虽然初步解决了地域限制问题,但其单视角、平面化、缺乏沉浸感与交互性的特征,已无法满足临床协作、手术示教、康复管理等复杂医疗场景的需要。

随着VR头戴设备(HMD)的普及、Unity3D引擎在可视化和交互场景构建中的深入应用,以及5G与实时音视频传输技术的突破,远程诊疗正逐步迈向“沉浸式协同”的新阶段:

-

医生可身临其境地观察术野画面,围绕患者构建三维诊疗空间;

-

远端专家可同步进入虚拟场景,进行多视角观摩、标注、指导;

-

患者则可在家通过头显设备参与复健动作训练,并实时获取反馈;

-

教学过程中,学生通过 VR 重现手术过程,实现更深层次的感知与理解。

这一转变对底层视频播放与互动系统提出了前所未有的挑战:更低的延迟、更高的清晰度、更稳定的多协议播放能力,以及对头显平台的深度适配与交互支持,成为构建下一代医疗系统的技术基石。

二、技术挑战:医疗级 VR 远程播放的五大关键难题

相比一般的视频播放,医疗级远程诊疗对音视频系统提出了更为严苛的技术要求。无论是延迟控制、图像质量,还是设备兼容性与交互能力,稍有不足都可能直接影响诊疗效果。在将视频播放引入 VR 头显设备的过程中,主要面临以下五大技术挑战:

⏱ 1. 延迟控制难度大

远程医疗强调实时反馈与操作协同,而传统播放器的端到端延迟通常在 800ms 以上,远超医疗交互所需的 150~200ms 范围。一旦画面延迟过高,会导致医生无法准确判断术野变化、患者动作或指导反馈,从而影响操作安全与诊疗效率。

🧩 2. Unity3D 引擎集成复杂

Unity 是构建 VR 医疗场景的主流引擎,但大多数通用播放器难以直接与 Unity 渲染管线融合。在视频解码完成后,如何将图像高效映射到 Unity 的材质系统中,进而实现头显左右眼同步渲染,是实现沉浸式体验的关键技术门槛。

📶 3. 协议源类型多样,兼容性要求高

医疗系统中常见的设备如内窥镜、高清摄像头通常采用 RTSP 协议进行推流,而远程教学或云端转播又常使用 RTMP。一套播放系统必须同时支持多种协议,并在不同网络条件下稳定运行,这对播放器内核的兼容性与适应性提出了更高要求。

🧠 4. VR 头显硬件资源受限

当前大多数 VR 设备基于 Android 系统,受限于 CPU 性能、GPU 带宽及内存容量。若播放器设计不够精简,容易导致解码卡顿、发热升温、功耗过高等问题,直接影响佩戴体验与系统稳定性。因此,必须实现轻量级、高效能的视频解码与渲染路径。

🎯 5. 多源视频同步与多视角空间组织复杂

在临床教学或远程手术协同中,往往需要同时展示多个视频流:术野主画面、医生讲解、辅助视角、图文标注等。这些画面既要时序同步,又要在 VR 空间中合理排布,并支持用户自由切换或组合观看,极大增加了渲染与交互设计的复杂度。

总结来说,医疗级 VR 视频播放不仅仅是“能播”这么简单,更是对低延迟能力、渲染融合、协议支持、资源优化与交互体验的全方位考验。唯有构建专为医疗场景打造的视频处理架构,才能真正支撑起沉浸式远程诊疗的落地需求。

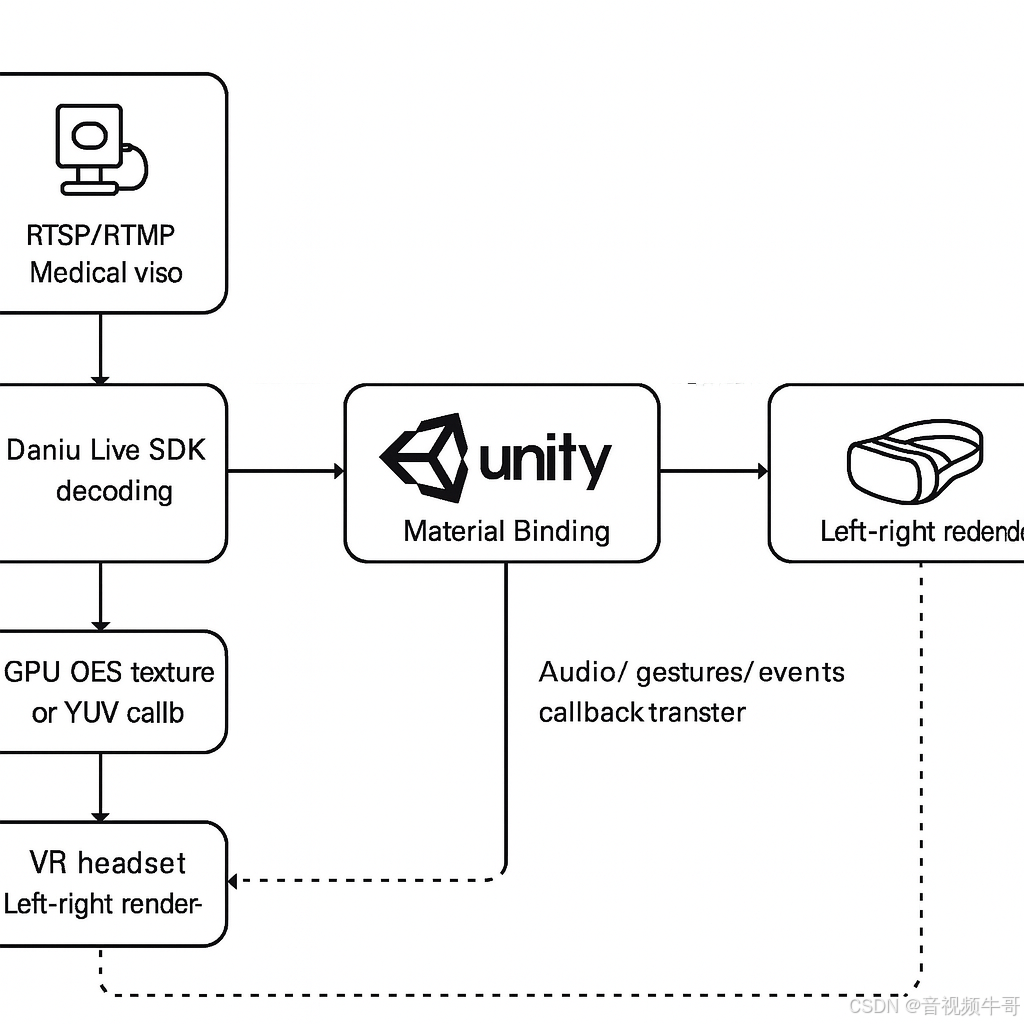

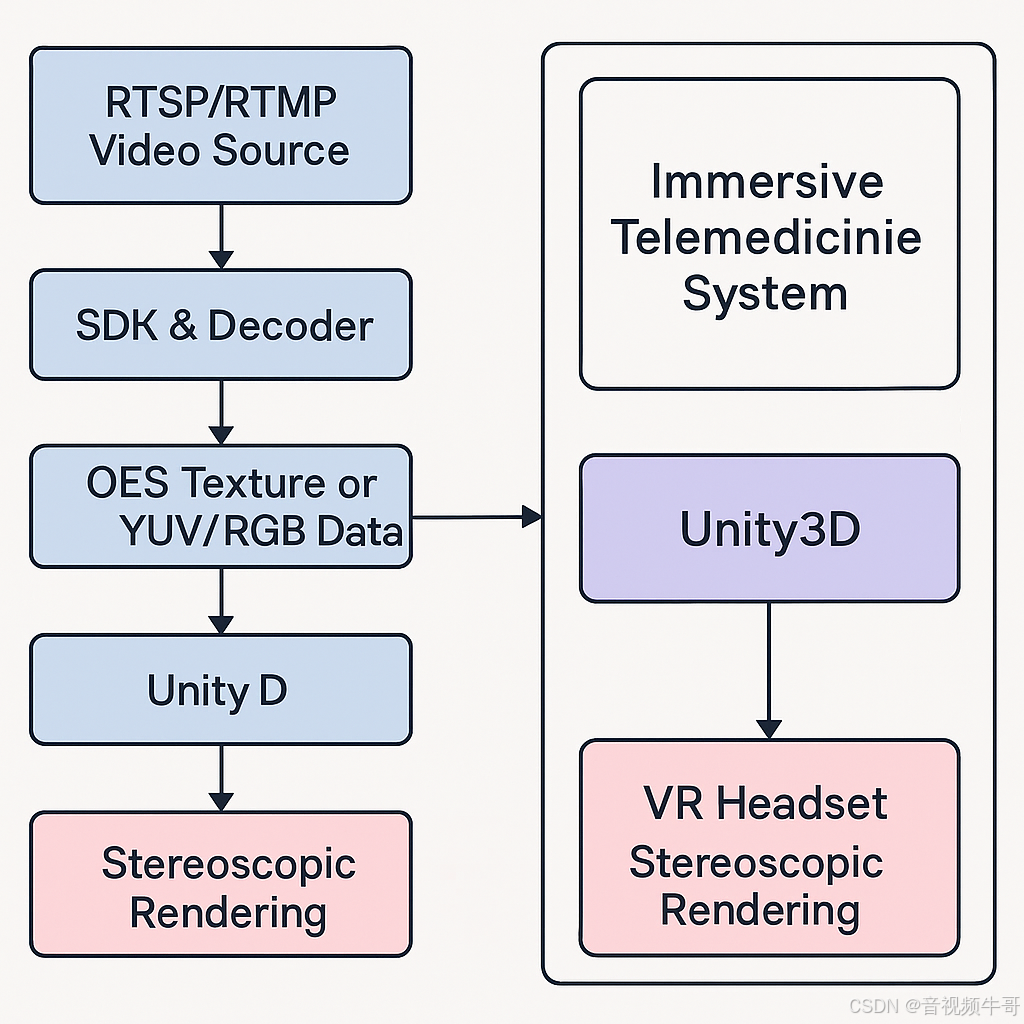

三、解决方案:大牛直播SDK × Unity3D × VR头显 的融合架构

为了满足远程医疗在 VR 场景下对“低延迟、高稳定、强交互”的多重要求,采用大牛直播SDK与 Unity3D 的深度融合架构,构建了一个高效、可扩展、可跨平台的沉浸式视频播放方案。该方案在底层播放能力、引擎渲染、设备适配、交互控制等多个维度进行了系统优化,有效解决了医疗级 VR 播放中的核心难题。

Android平台Unity共享纹理模式RTMP播放延迟测试

✅ 1. 播放器内核:原生多协议、低延迟、高并发

大牛直播SDK 具备成熟稳定的 RTSP / RTMP 播放能力,支持软硬解码动态切换,并对医疗场景常见的视频源做了深度适配:

-

协议支持全面:支持 RTSP(UDP/TCP)、RTMP可无缝切换,兼容主流医疗视频系统与云端平台。

-

低延迟优化:内置超低延迟模式,端到端延迟最低可达 100~200ms,满足手术示教与远程协作的实时性需求。

-

高稳定性播放:支持断流重连、动态码率适应、流状态监听等机制,保障长时间稳定运行。

✅ 2. 引擎融合:Unity3D 插件化接入,支持头显双目渲染

在 Unity 平台下,通过将大牛直播SDK 封装为可复用的插件组件,支持与 Unity 渲染管线深度对接:

-

原生接口封装:支持 Android、Windows 等平台的 JNI / C# 接口调用,快速集成至 Unity 项目。

-

纹理绑定高效:通过

SurfaceTexture+ExternalTexture实现视频纹理与 Unity 材质的 GPU 零拷贝绑定。 -

头显适配良好:支持 VR 模式下的左右眼分屏渲染,保证沉浸式视觉体验不受破坏。

-

多画面支持:支持多个视频流在同一 Unity 场景中同步渲染,可灵活部署主视角、辅视角、讲解层等区域。

✅ 3. 渲染管线:全流程 GPU 加速 + 零拷贝优化

为提升帧率与播放流畅性,整个渲染管线以“低功耗 + 高性能”为目标进行了系统优化:

[RTSP/RTMP 视频源]↓

[大牛直播SDK 解码(支持 H.264/H.265)]↓

[OES 纹理输出 or YUV/RGB 数据回调]↓

[Unity 材质绑定 ExternalTexture]↓

[头显左右眼同步渲染显示]

该流程具备以下优势:

-

GPU 直接接管解码纹理,避免 CPU↔GPU 的频繁数据传输;

-

内部缓存机制优化首帧加载速度与播放平滑度;

-

可扩展支持图像增强、边缘叠加、AI 标注层等图层叠加。

✅ 4. 医疗场景专属优化能力

针对远程医疗的特殊需求,大牛直播SDK + Unity3D 的组合还提供如下关键能力:

-

多音视频流同步播放:支持多个手术/讲解视角的时间轴同步控制,确保场景一致性。

-

空间交互集成:与 Unity XR Interaction Toolkit 无缝融合,可加入手势识别、语音控制等交互方式。

-

全平台支持:适配主流 VR 设备(如 Pico、Quest 系列)以及移动端/PC端的辅助查看终端。

-

可录制、可截图、可转推:支持本地录像、实时截图、转推流等能力,便于教学与数据归档。

✅ 5. 模块化架构,便于扩展与集成

该方案以模块化插件结构设计,可根据不同项目需求灵活裁剪与扩展:

-

📦 播放内核可独立更新,无需重构主项目;

-

🧩 多协议模块可按需启用;

-

🧠 可无缝接入 AI 图像识别、事件检测模块;

-

☁️ 支持边缘计算节点部署与云端协同转码。

总结来看,大牛直播SDK 与 Unity3D 的深度融合不仅解决了远程医疗中高质量视频播放的技术瓶颈,还打通了 VR 设备与医疗系统之间的互动通道,真正实现了“可落地、可扩展、可演进”的沉浸式远程诊疗基础架构。

四、典型应用场景落地:打造沉浸式医疗协同体验

在远程医疗的多元化发展过程中,传统的视频通话方案逐渐无法满足新型医疗协同的体验诉求。以大牛直播SDK 为核心的视频能力叠加 Unity3D 的三维渲染与交互能力,构建的沉浸式播放系统已在以下典型场景中实现落地应用,并展现出显著的实用价值:

🎓 1. 手术示教与医学教学

应用方式:

通过 Unity3D 构建虚拟手术室场景,集成 RTSP 推流的术野画面、医生讲解流、PPT 叠加等多源内容,实时同步播放至学生头显设备中。

技术要点:

-

多画面同步渲染(主视角 + 辅视角 + 解说)

-

支持空间定位讲解与图层标注

-

支持课后录像回放与素材导出

价值体现:

提升医学教育沉浸感与参与度,让学生“进入手术现场”,突破传统教室教学的视觉与空间限制。

🧠 2. 多院远程会诊与协同决策

应用方式:

远程专家通过头显进入统一的虚拟会诊空间,实时观看患者术前检查图像、实时影像数据流,同时与本地医生展开空间化互动讨论。

技术要点:

-

远程 RTSP 画面与 Unity 场景融合

-

支持语音通话、注释与图层同步

-

可引入 AI 模型实时辅助分析(如肿瘤勾画)

价值体现:

打破时空壁垒,提升会诊效率,构建高质量、多学科协同的临床决策环境。

🩹 3. 居家康复训练与慢病随访

应用方式:

患者在家佩戴 VR 头显进入康复训练场景,观看康复视频流或医生远程指导画面,并根据提示完成指定动作;医生端实时接收头显反馈,给予针对性调整。

技术要点:

-

RTMP 实时视频远程推流

-

Unity 中接入动作捕捉与行为监测模块

-

支持远程语音指令控制与交互反馈

价值体现:

提升患者依从性与训练效果,降低随访成本,增强康复过程可视性与互动性。

🧪 4. 手术过程直播与术后复盘分析

应用方式:

在关键手术过程中,系统可将术野视频流实时转码为 RTMP,推送至 VR 教学空间或专家复盘场景中;术后可通过录像回放进行多角度分析。

技术要点:

-

支持原始码流无损录制

-

多流同步录像与时间轴跳转分析

-

可叠加术中注释与图像标记

价值体现:

提升教学价值与术后评估精度,形成可持续沉淀的知识资料库。

🧬 5. AI + VR 远程图像分析平台

应用方式:

将远程视频画面通过大牛直播SDK 拉流至本地,实时进行图像识别(如病灶检测、行为分析),分析结果可叠加至 Unity 场景中显示或触发交互逻辑。

技术要点:

-

播放器支持 YUV/RGB 数据回调接口

-

Unity 层接入视觉 AI 模型

-

支持识别结果空间化可视呈现

价值体现:

实现智能分析与视觉反馈闭环,提升远程医疗的精准性与智能化水平。

总结来看,无论是术中教学、远程会诊,还是康复指导与智能分析,大牛直播SDK + Unity3D + VR头显所构建的沉浸式视频播放架构,正在不断拓展远程医疗的应用边界,为智慧医疗体系注入可感知、可互动、可进化的新能力。

五、技术亮点全景图

| 技术维度 | 关键能力描述 | 实际价值体现 |

|---|---|---|

| 🔁 多协议兼容 | 原生支持 RTSP(TCP/UDP)、RTMP等主流流媒体协议 | 无需第三方适配器,轻松接入医院设备与云平台 |

| ⏱ 超低延迟播放 | 内置低延迟模式,RTMP、RTSP端到端延迟控制在 100~200ms | 满足术中远程协作、教学同步、AI辅助诊断等场景 |

| 🧩 Unity3D 插件化集成 | 支持 Unity 调用原生解码,纹理零拷贝绑定材质,兼容 XR 管线 | 快速构建三维沉浸式场景,无需重写渲染框架 |

| 🎥 多画面多视角支持 | 支持多路视频同时接入与空间布置(术野+讲解+辅助视角) | 满足手术示教、会诊分析等多视角同步需求 |

| 🧠 VR头显优化 | 解码+渲染资源开销控制,支持双目立体显示、断网重连、低功耗运行 | 提升播放流畅度与头显佩戴体验,避免发热卡顿 |

| 📊 YUV/RGB 数据回调 | 播放器支持裸数据帧回调,可供 AI 图像识别、边缘分析、自动标注等处理流程使用 | 构建智能诊疗与图像增强流程的底层输入通道 |

| 💬 音视频交互回传 | 可以通过APP上层逻辑实现支持语音通话、手势控制、交互事件传递回 Unity 逻辑层 | 增强医生与患者/学生的沉浸式交互能力 |

| 📱 跨平台部署能力 | 支持 Android(头显)、iOS、Windows、Linux 等全平台播放端部署 | 满足多终端同步观看与混合现实医疗教学部署场景 |

六、未来扩展方向:打造智慧医疗的实时感知中枢

随着远程医疗持续向“智能化、沉浸化、协同化”方向演进,以大牛直播SDK 为核心的 VR 视频处理架构,将在未来承担更丰富的角色,逐步从“视频播放”演进为“实时感知中枢”。在此基础上,可进一步拓展如下能力:

🔍 1. AI 模块集成:从被动观看到智能感知

-

自动识别术中关键事件:如出血、组织切割等,通过 YUV/RGB 数据回调对接 AI 模型;

-

智能图像增强与标注:自动勾勒病灶边界,进行实时叠加显示;

-

边缘推理计算协同:结合边缘端推理芯片,实现视频内容本地识别,提升处理效率并降低延迟。

🌐 2. 跨端协同:VR 医疗体验轻量化

-

多终端混合同步:支持 VR 头显 + 平板 + PC 同步观看,适配不同角色需求;

-

远程注解与权限控制:专家可在视频画面上远程标注、调阅资料、发布操作指令。

🧠 3. 数字孪生医疗空间构建

-

基于真实数据复现手术流程与空间布置;

-

结合传感器数据、视频流、设备模型进行空间建模;

-

构建“医疗场景 + 视频流 + 控制流”三位一体的可交互数字医疗系统。

☁️ 4. 云边协同与私有化部署能力

-

支持边缘节点缓存转发、推流调度,保障大规模医院或集团使用;

-

私有化部署支持医疗数据合规要求(如 HIPAA、GDPR)。

✅ 结语:从视频播放到医疗协作的数字基建

大牛直播SDK 与 Unity3D 在 VR 远程医疗中的融合应用,不仅仅是一个播放器集成方案,而是一套面向未来医疗场景的“视频能力平台”。

它打通了:

-

多协议音视频的超低延迟采集与播放路径;

-

三维交互与沉浸式空间的深度集成方式;

-

AI 辅助识别、远程协同、跨端适配等智能化能力接口。

在教学、诊断、协作、康复等多场景中,它已经不仅是传输图像的通道,更是数字医疗系统的交互窗口、数据入口与感知桥梁。

随着 VR 医疗的不断发展,这一融合架构将承载起越来越多的智能协作任务,助力医疗体系真正走向数字化、空间化、泛在化的新阶段。

📌 如果你正在寻找一套高效稳定、功能强大、可持续演进的医疗级 VR 视频集成方案,大牛直播SDK 是值得信赖的核心选择之一。