大模型 认知能力 生物学启发

用第一性原理拆解“大模型transformer的注意力”在神经网络里的秘密,让你看到从生物到算法的跨界共振。

1 注意力Query-Key-Value

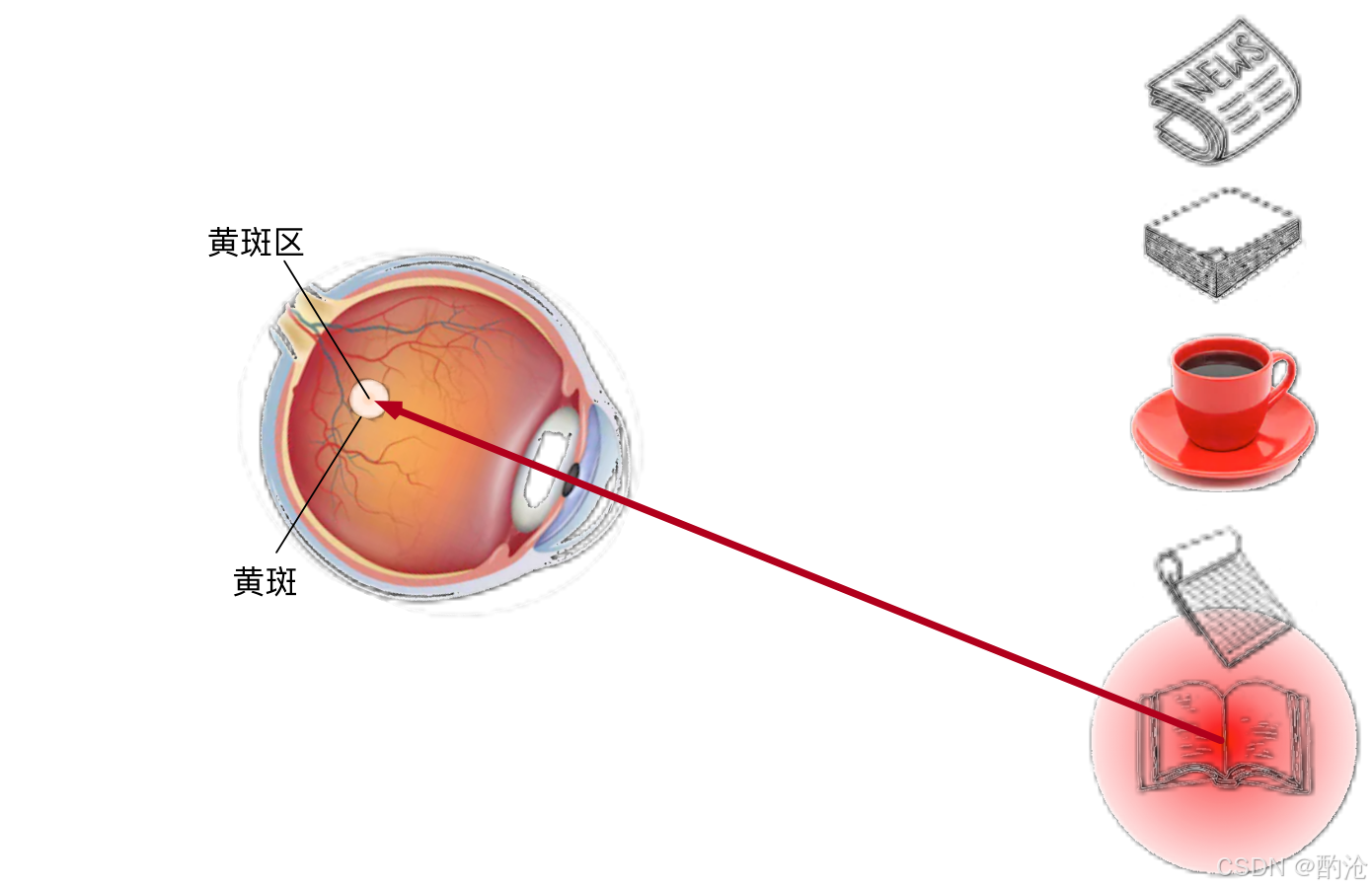

📊 想看书 注意力被自主引导到书上,忽略其他。在信息爆炸时代,人类注意力既稀缺又昂贵。⏳ 经济学把它视作可交易资源:要么花钱屏蔽广告,要么用注意力“付款”。

在深度学习里,模型同样需要在海量特征中挑选“值得看”的部分。

非自主性提示靠外部突出性吸睛;

自主性提示(意图 🧠)则由任务目标驱动。

两者共同构成“注意力提示”框架,为后续的算法打地基。

在 Transformer 的自注意力层里,“Q – K – V” 是贯穿始终的三元组

| 符号 | 来自哪里 | 作用 | 数学形式 |

|---|---|---|---|

| Q (Query) | 当前 token 的向量经线性变换 | 像“主动提问者”——它想知道自己该关注谁 | 𝐐 = 𝐗 WQ |

| K (Key) | 序列中每个 token 的向量经同一变换 | 好比“身份标签”——被别人拿来匹配 | 𝐊 = 𝐗 WK |

| V (Value) | 同一批 token 再过一套权重 | 承载真正要汇聚的信息 | 𝐕 = 𝐗 WV |

📊 Q = “我是谁,要找什么”;K = “我有哪些特征,别人拿什么来找我”;V = “一旦被找到,我能提供什么内容”。

1️⃣ 匹配

先做点积 Q·Kᵀ 并按维度 √dk 缩放→ 得到相似度矩阵;这一步就像问卷匹配问答者。

2️⃣ 归一化

对每行做 softmax,让每个 query 的注意力权重 ∈ [0,1] 且总和为 1。

3️⃣ 汇聚

权重矩阵再乘 V,把“被选中的价值”按比例叠加——得到新的表示 𝐙。

公式: Attention(Q,K,V) = softmax(Q Kᵀ / √dk) V

多头注意力只是把这套流程拆成 h 份并行子空间,让模型同时在“颜色、形状、语义、位置…”等不同角度做匹配,再把结果拼接回来,获得更丰富的表示。

这样,Transformer 不依赖固定卷积核或递归链,就能在 O(n²) 感受野里灵活地建立 任何两 token 间的长距离依赖——这正是其序列建模威力的源泉。

2 生物学的注意力模型

威廉·詹姆斯 19 世纪提出的“双组件框架”至今仍闪耀:👁️ 视觉系统每秒接收约 10⁸ bit,但大脑只能精处理极少片段。生物选择用 “先天突出性 + 后天意图” 两级滤波节省能量。神经网络借鉴这一思路,用分层结构模拟从视网膜到大脑皮层的焦点切换,实现对输入特征的分配式供血。

| 环节 | 生理器官/对应层 | 作用 |

|---|---|---|

| 视觉初筛 | 视网膜 / key 向量 | 检测颜色/边缘 |

| 意图调制 | 前额叶 / Query 向量 | 根据任务重加权 |

| 聚焦执行 | 眼球转动 / Attention Pooling | 汇聚目标特征 |

📊 表格把生物通路映射到网络组件,一一对应。当我们盯紧“红咖啡杯”,视网膜捕获颜色差异,而 Attention 则像大脑下达“看杯子”的指令。算法并非凭空创造,而是对生物过程的数据化迁移。🔥

📊 在注意力机制下,自主性提示被称为查询(query)。给定任何查询,注意力机制通过注意力汇聚将选择引导至感官输入。在注意力机制中这些感官输入被称为值(value)。每个值都与一个键(key)配对,这可以想象为感官输入的非自主提示。通过设计注意力汇聚的方式,便于给定的查询(自主性提示)与键(非自主性提示)进行匹配,这将引导得出最匹配的值(感官输入)。

📊 演示 Q-K-V 工作流。权重矩阵 W 是可视化 Attention 的核心产物;在多头场景下,模型相当于同时戴上多副“专注眼镜”,每副聚焦不同语义。😂Q 引导“看哪里”,K 提供“看什么”,V 给出内容本身;三者拆分让注意力层天然支持并行与多头扩展。

3 Transformer组件与大脑知觉

| 机制 | 工程实现 (数学/代码) | 生物学对照 | 本质机理 | 🔥关键作用 |

|---|---|---|---|---|

| Self-Attention | 软性权重 ![Q · Kᵀ / √d],随梯度实时更新 | 皮层突触短时增益调制 (横向抑制 + 突显放大) | 在 O(n²) 感受野内分配“注意力能量”,动态路由信息 | 赋予网络“可区分且可组合”的选择性 |

| Multi-Head Attention | 并行 h 路子空间投影,线性层共享值 V | 视觉通路中并行特征图 (颜色/方向/运动…) | “一事多视角”,减少单视角偏差 → 更丰富特征表征 | 提升表示多样性与鲁棒性 |

| Positional Encoding | 正余弦嵌入或学习型相对位置 | 内嗅皮层 Grid Cell 网格放电 | 将离散 token 排成“认知地图”,保持序列拓扑 | 让纯注意网络拥有时空坐标系 |

| Feed-Forward (FFN) | 逐位置 Linear → 非线性 → Linear | 受体-中间-投射神经元 | 局部非线性变换,构筑高阶交互 | 把“加权汇聚”转为“抽象重组” |

📊 该表把 Transformer 的核心组件与大脑注意-知觉回路的一一对应关系做了对比,突出其 进化共性 与工程实现差异。自注意力可视为“可微的突触增益”;多头机制则像将 V1-V4 的并行通道塞入同一层网络,彼此投票决定关注区域。位置编码弥补了“注意无序”的天然缺陷,相当于给突触连接加上 GPS 坐标。残差与归一化像大脑中的神经稳态,使得深层网络不会因兴奋/抑制失衡而“痉挛”。

共性** 与工程实现差异。自注意力可视为“可微的突触增益”;多头机制则像将 V1-V4 的并行通道塞入同一层网络,彼此投票决定关注区域。位置编码弥补了“注意无序”的天然缺陷,相当于给突触连接加上 GPS 坐标。残差与归一化像大脑中的神经稳态,使得深层网络不会因兴奋/抑制失衡而“痉挛”。