大型语言模型(LLM)的技术面试题

大型语言模型(LLM)的技术面试题

目录

- 大型语言模型(LLM)的技术面试题

- 一、提示校准:减轻提示学习中的偏见

- 二、矢量存储的适用场景

- 三、模型与人类价值观对齐的技术

- 四、RLHF中的Reward Hacking

- 五、微调效果的关键影响因素:预训练模型架构与大小

- 六、Transformer自注意力机制:衡量单词重要性

- 七、子词算法(如BPE、WordPiece):限制词汇量

- 八、Adaptive Softmax:利用Zipf定律提升效率

- 九、推理参数“温度(Temperature)”:控制输出随机性

- 十、跨GPU训练技术:FSDP(Fully Sharded Data Parallel)

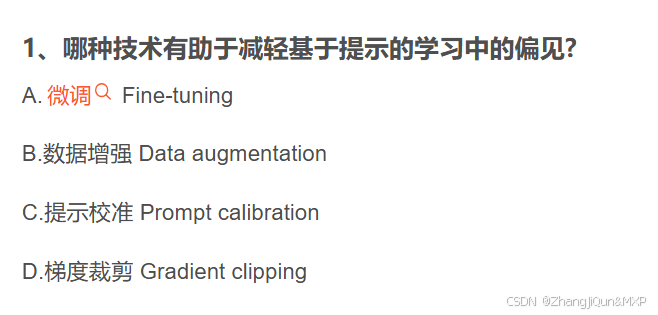

一、提示校准:减轻提示学习中的偏见

原理:提示校准(Prompt calibration)通过调整提示词的表述方式,减少模型输出中的固有偏见,而非修改模型本身或训练数据。它聚焦于优化输入指令的中立性和精确性,从而引导模型生成更公平的结果。

举例:若要通过LLM筛选简历,原始提示可能包含“优先考虑年轻候选人”,这隐含年龄偏见。通过提示校准,可调整为“根据岗位要求匹配候选人技能,不考虑年龄因素”,使模型输出更符合公平原则。

二、矢量存储的适用场景

原理:矢量存储用于存储文本的语义向量(捕获语义信息),主要支持需要外部知识检索的任务(如RAG系统)。但并非所有文本任务都需要——仅依赖文本自身上下文即可完成的任务无需矢量存储。

无需矢量存储的场景举例