1 Studying《Systems.Performance》7-13

目录

7 Memory

7.1 Terminology

7.2 Concepts

7.3 Architecture

7.4 Methodology

7.5 Analysis

7.6 Tuning

8 File Systems

8.1 Terminology

8.2 Models

8.3 Concepts

8.4 Architecture

8.5 Methodology

8.6 Analysis

8.7 Experimentation

8.8 Tuning

9 Disks

9.1 Terminology

9.2 Models

9.3 Concepts

9.4 Architecture

9.5 Methodology

9.6 Analysis

9.7 Experimentation

9.8 Tuning

10 Network

10.1 Terminology

10.2 Models

10.3 Concepts

10.4 Architecture

10.5 Methodology

10.6 Analysis

10.7 Experimentation

10.8 Tuning

11 Cloud Computing

11.1 Background

11.2 OS Virtualization

11.3 Hardware Virtualization

11.4 Comparisons

12 Benchmarking

12.1 Background

12.2 Benchmarking Types

12.3 Methodology

12.4 Benchmark Questions

13 Case Study

13.1 Case Study: The Red Whale

13.2 Comments

13.3 Additional Information

7 Memory

系统主内存存储应用程序和内核指令,它们的工作数据和文件系统缓存。在许多系统中,用于存储这些数据的辅助存储设备是主要存储设备-磁盘,其操作速度比主内存慢几个数量级。一旦主内存填满,系统可能开始在主内存和存储设备之间切换数据。这是一个缓慢的过程,通常会成为系统瓶颈,大大降低性能。系统还可能终止最大的内存消耗进程。

其他需要考虑的性能因素包括分配和释放内存的CPU开销、内存复制以及管理内存地址空间映射的开销。在多处理器架构中,内存局部性可能成为一个因素,因为连接到本地插槽的内存比远程插槽具有更低的访问延迟。

本章分为五个部分,前三个部分提供了内存分析的基础知识,后两个部分展示了其在基于Linux和Solaris的系统中的实际应用。各部分内容如下:

- 背景介绍了与内存相关的术语和关键的内存性能概念。

- 架构提供了硬件和软件内存架构的通用描述。

- 方法论解释了性能分析方法论。

- 分析描述了内存分析的性能工具。

- 调优解释了调优和示例可调参数。

关于CPU上的内存缓存(一级/二级/三级缓存,TLB)在第6章《CPU》中有介绍。

7.1 Terminology

在本章中使用的与内存相关的术语如下:

- 主内存:也称为物理内存,描述了计算机的快速数据存储区,通常以DRAM形式提供。

- 虚拟内存:主内存的抽象,(几乎)是无限的,且非争用的。虚拟内存并非真实的内存。

- 驻留内存:当前驻留在主内存中的内存。

- 匿名内存:没有文件系统位置或路径名的内存。它包括进程地址空间的工作数据,称为堆。

- 地址空间:内存上下文。每个进程和内核都有虚拟地址空间。

- 段:一个标记为特定目的的内存区域,例如用于存储可执行或可写入页面。

- OOM:内存耗尽,当内核检测到可用内存较少时发生。

- 页:操作系统和CPU使用的内存单元。在历史上,它通常是4或8 K字节。现代处理器支持多种页面大小,用于更大的尺寸。

- 缺页:无效的内存访问。这些在使用按需虚拟内存时是正常发生的。

- 分页:在主内存和存储设备之间转移页面。

- 交换:来自Unix,这是在主内存和交换设备之间传输整个进程。Linux通常使用交换来指代向交换设备(交换页面的传输)。在本书中,使用了原始的定义:交换是指整个进程的交换。

- 交换区:用于分页匿名数据和交换进程的磁盘区域。它可以是存储设备上的区域,也称为物理交换设备,或者是文件系统文件,称为交换文件。一些工具使用交换术语来指代虚拟内存(这是令人困惑和不正确的)。

本章还介绍了其他术语。词汇表中包含了基本的术语供参考,包括地址、缓冲区和DRAM。此外,还请参阅第2章和第3章的术语部分。

7.2 Concepts

以下是关于内存和内存性能的一些重要概念的精选。

7.2.1 Virtual Memory

虚拟内存是一种抽象概念,为每个进程和内核提供了一个大型、线性且私有的地址空间。它简化了软件开发,将物理内存的分配交给操作系统来管理。它还支持多任务处理,因为虚拟地址空间通过设计进行了分离,同时也支持超额订阅,因为正在使用的内存可以扩展到主内存之外。虚拟内存在第3章的操作系统中介绍过。有关历史背景,请参考[Denning 70]。

图7.1显示了对于一个带有交换设备(辅助存储)的系统的进程而言,虚拟内存的作用。一个内存页面被展示出来,因为大多数虚拟内存实现都是基于页面的。

进程的地址空间由虚拟内存子系统映射到主内存和物理交换设备。内存页面可以根据需要在它们之间由内核移动,这个过程称为分页。这使得内核可以超额订阅主内存。

内核可能对超额订阅设置限制。在基于Solaris的内核中,限制是主内存和物理交换设备的大小之和。内核将拒绝试图超过此限制的分配。这样的“虚拟内存耗尽”错误一开始可能会让人困惑,因为虚拟内存本身是一个抽象资源。

Linux可以配置为支持相同的行为,但它也允许其他行为,包括不对内存分配设置任何限制。这称为过度承诺,并且在以下关于分页和需求分页的部分之后进行描述,这些部分对于过度承诺的工作是必要的。

7.2.2 Paging

分页是指将页面在主内存之间移动,分别称为页面调入(page-ins)和页面调出(page-outs)。它最早由Atlas计算机于1962年引入[Corbató 68],使得:

- 部分加载的程序能够执行

- 大于主内存的程序能够执行

- 程序在主内存和存储设备之间进行高效移动

这些功能至今仍然存在。与交换整个程序不同,分页是一种细粒度的管理和释放主内存的方法,因为页面大小单位相对较小(例如,4 K字节)。

通过BSD引入了带有虚拟内存的分页(分页虚拟内存)到Unix[Babaoglu 79],并成为标准实践。

随着后来引入文件系统页面缓存用于共享文件系统页面(参见第8章,文件系统),出现了两种不同类型的分页:文件系统分页和匿名分页。

File System Paging

文件系统分页是由于对内存映射文件中的页面进行读写而引起的。对于使用文件内存映射(mmap())的应用程序以及使用页面缓存的文件系统(大多数文件系统都使用;请参阅第8章,文件系统)来说,这是正常行为。它曾被称为“良好”分页[McDougall 06b]。

在需要时,内核可以通过将一些页面调出来释放内存。在这里术语会有点复杂:如果一个文件系统页面在主内存中被修改过(“脏”),则页面调出将需要将其写入磁盘。相反,如果文件系统页面没有被修改过(“干净”),则页面调出仅释放内存以便立即重用,因为磁盘上已经存在一份副本。由于这个原因,术语“页面调出”意味着页面被移出内存——这可能涉及或不涉及向存储设备的写入(您可能会看到这个定义有所不同)。

Anonymous Paging

匿名分页涉及进程私有的数据:进程堆和栈。它被称为匿名,是因为在操作系统中没有具体的命名位置(即没有文件系统路径名称)。匿名页面调出需要将数据移动到物理交换设备或交换文件。Linux使用术语"swapping"来指代这种类型的分页。

匿名分页会影响性能,因此被称为"不良"分页[McDougall 06b]。当应用程序访问已经调出的内存页面时,它们会阻塞在磁盘I/O上,以便将页面读回主内存。这就是匿名页面调入,它给应用程序引入了同步延迟。匿名页面调出可能不会直接影响应用程序性能,因为它们可以由内核异步执行。

性能最好的情况是没有匿名分页(或交换)。这可以通过配置应用程序保持在可用主内存范围内,并监视页面扫描、内存利用率和匿名分页,以确保不再出现内存不足的迹象。

7.2.3 Demand Paging

支持需求分页的操作系统(大多数都支持)根据需要将虚拟内存页映射到物理内存,如图7.2所示。这样做推迟了创建映射的CPU开销,直到它们真正被需要和访问,而不是在内存范围首次分配时进行。

图7.2中显示的序列始于对新分配的虚拟内存页的写入,导致按需映射到物理内存。当虚拟内存到物理内存之间最初没有页面映射时,会发生页面错误。

在已映射文件的情况下,第一步也可以是读取,该文件包含数据但尚未映射到该进程地址空间。

如果映射可以从内存中的另一页满足,则称为次要错误。这可能发生在将新页从可用内存映射到过程中(如图所示)。它还可以发生在将另一页映射到另一页,例如从映射的共享库读取一页。

需要访问存储设备(本图未显示)的页面错误,例如访问非缓存的内存映射文件,称为主要错误。

虚拟内存模型和按需分配的结果是,任何虚拟内存页可能处于以下状态之一:

A. 未分配

B. 已分配,但未映射(未填充且尚未错误)

C. 已分配,并映射到主内存(RAM)

D. 已分配,并映射到物理交换设备(磁盘)

如果由于系统内存压力而将页面调出,则达到状态(D)。从(B)到(C)的转换是一个页面错误。如果需要进行磁盘I/O,则是一个主要页面错误;否则是一个次要页面错误。

从这些状态中,还可以定义两个内存使用术语:

居住集大小(RSS):已分配主内存页的大小(C)

虚拟内存大小:所有已分配区域的大小(B + C + D)

通过BSD,Unix引入了需求分页,以及分页虚拟内存。

7.2.4 Overcommit

Linux支持超额分配的概念,允许分配比系统实际存储的内存更多的内存,即超过物理内存和交换设备的总和。它依赖于按需分页和应用程序不使用其已分配内存的倾向。

有了超额分配,应用程序对内存的请求(例如malloc())将在本应失败时成功。应用程序员可以慷慨地分配内存,之后根据需要稀疏地使用,而不是保守地分配内存以保持在虚拟内存限制范围内。

在Linux上,超额分配的行为可以通过可调参数进行配置。有关详细信息,请参阅第7.6节“调整”。超额分配的后果取决于内核如何管理内存压力;请参阅第7.3节“体系结构”中对OOM killer的讨论。

7.2.5 Swapping

交换是将整个进程在主内存和物理交换设备或交换文件之间移动的过程。这是管理主内存的最初Unix技术,也是“交换”一词的起源(Thompson 78)。

要交换出一个进程,必须将其所有私有数据写入交换设备,包括线程结构和进程堆(匿名数据)。来自文件系统且未被修改的数据可以被丢弃,并在需要时重新从原始位置读取。

被交换出的进程仍然由内核知晓,因为一小部分进程元数据始终驻留在内核内存中。要将进程交换回来,内核会考虑线程优先级、在磁盘上等待的时间以及进程的大小。长时间等待和较小的进程会受到青睐。

交换严重影响性能,因为已被交换出的进程需要大量的磁盘I/O才能再次运行。在早期的Unix系统中,如PDP-11型号的机器,最大进程大小为64K字节时,这种做法更为合理(Bach 86)。

虽然基于Solaris的系统仍然可以进行交换,但只有在分页无法快速释放足够的内存以满足应用程序需求时才会这样做(因为分页受页面扫描速率的限制;请参阅第7.3节“体系结构”)。Linux系统根本不交换进程,而只依赖分页。

当人们说“系统正在交换”时,他们通常指的是分页。在Linux中,“交换”一词指的是分页到交换文件或设备(匿名分页)。

7.2.6 File System Cache Usage

系统启动后内存使用量增长是正常的,因为操作系统利用可用内存来缓存文件系统,从而提高性能。原则是:如果有多余的主内存,则将其用于某些有用的事情。这可能会让幼稚的用户感到困扰,因为他们在启动后不久就看到可用空闲内存几乎降至零。但对应用程序来说并不构成问题,因为内核应该能够在应用程序需要时快速从文件系统缓存中释放内存。

关于可能占用主内存的各种文件系统缓存的更多信息,请参阅第8章《文件系统》。

7.2.7 Utilization and Saturation

主内存利用率可以计算为已使用内存与总内存的比值。文件系统缓存使用的内存可以视为未使用,因为这部分内存可以被应用程序重新利用。

如果对内存的需求超过了主内存的容量,主内存就会饱和。操作系统可以通过使用分页、交换和在Linux上使用OOM killer(稍后描述)来释放内存。这些活动中的任何一项都是主内存饱和的指标。

如果系统对所愿意分配的虚拟内存量设定了限制(Linux的过度承诺除外),也可以根据容量利用率来研究虚拟内存。如果是这样,一旦虚拟内存耗尽,内核将无法进行分配;例如,malloc() 函数返回 ENOMEM。

需要注意的是,系统当前可用的虚拟内存有时会(令人困惑地)称为可用交换空间。

7.2.8 Allocators

虚拟内存处理物理内存的多任务处理,而在虚拟地址空间内的实际分配和放置通常由分配器处理。这些分配器可以是用户空间库或基于内核的例程,为软件程序员提供了一个简单的内存使用接口(例如malloc()、free())。

分配器对性能有显著影响,系统可能提供多个用户级分配器库供选择。它们可以通过使用诸如每线程对象缓存等技术来提高性能,但如果分配变得碎片化和浪费,它们也可能损害性能。具体示例在第7.3节“体系结构”中有详细介绍。

7.2.9 Word Size

正如第6章介绍的那样,CPU处理器可能支持多种字长,例如32位和64位,允许软件在其中任一种上运行。由于地址空间大小受到字长可寻址范围的限制,需要超过4GB(通常略少)的应用程序对于32位地址空间来说太大了,需要编译为64位或更高位。

根据CPU架构的不同,使用更大的位宽可能会提高内存性能。在数据类型具有未使用位的情况下,可能会浪费少量内存。

7.3 Architecture

这一节介绍了内存架构,包括硬件和软件,还有处理器和操作系统的具体内容。这些主题被总结为性能分析和调优的背景知识。更多细节请参阅本章末尾列出的供应商处理器手册和操作系统内部的相关文献。

7.3.1 Hardware

内存硬件包括主存储器、总线、CPU高速缓存和内存管理单元(MMU)。

主存储器

如今常用的主存储器类型是动态随机存取存储器(DRAM)。这是一种易失性存储器,即在断电时会丢失其内容。DRAM提供了高密度存储,因为每个位只需要使用两个逻辑组件来实现:一个电容器和一个晶体管。电容器需要定期刷新以保持电荷。

企业服务器根据其用途配置不同数量的DRAM,通常范围从1GB到1TB甚至更大。这些数量可能使得云计算实例的内存相形见绌,后者通常在512MB到64GB之间。然而,云计算旨在将负载分布到一组实例上,因此它们可以共同为分布式应用程序提供更多DRAM,尽管这会带来更高的一致性成本。

延迟

主存储器的访问时间可以通过列地址选通(CAS)延迟来衡量:发送所需地址(列)到内存模块并且数据可以被读取之间的时间。这取决于内存类型(对于DDR3大约为10纳秒)。对于内存I/O传输,该延迟可能会在内存总线(例如64位宽)多次发生,以传输一个缓存行(例如64字节宽)。还有其他与CPU和MMU相关的延迟,用于读取新可用的数据。

主存储器架构

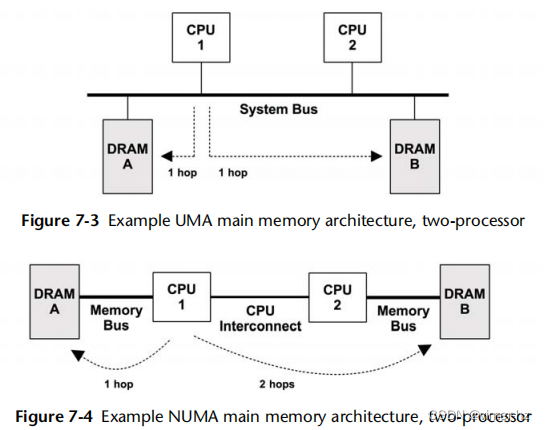

图7.3展示了一个通用的双处理器统一存储访问(UMA)系统的示例主存储器架构。

每个CPU通过共享系统总线对所有存储器具有统一的访问延迟。当由单个操作系统内核实例管理,并且在所有处理器上均匀运行时,这也是一种对称多处理(SMP)架构。

作为比较,在图7.4中显示了一个双处理器非均匀存储访问(NUMA)系统的示例,该系统使用的CPU互连成为存储器架构的一部分。对于这种架构,主存储器的访问时间取决于其相对于CPU的位置。

CPU 1可以通过其内存总线直接对DRAM A进行I/O。这被称为本地内存。CPU 1通过CPU 2和CPU互连(两次跳跃)对DRAM B执行I/O。这被称为远程内存,并具有更高的访问延迟。

连接到每个CPU的内存块被称为内存节点,或简称节点。操作系统可能根据处理器提供的信息意识到内存节点的拓扑结构,从而使其能够分配内存并根据内存局部性安排线程,尽可能偏向本地内存以提高性能。

总线

主存储器如何物理连接到系统取决于先前描绘的主存储器架构。实际实现可能涉及在CPU和存储器之间的额外控制器和总线,并以以下一种方式访问:

共享系统总线:单处理器或多处理器,通过共享系统总线、内存桥控制器,最终是内存总线。这在UMA示例图7.3中有所描述,并且在第6章CPU的图6.9中作为英特尔前端总线示例有所描述。该示例中的内存控制器是北桥。

直接:单处理器通过内存总线直接连接的内存。

互连:多处理器,每个处理器通过内存总线直接连接的内存,并且处理器通过CPU互连连接。这在前面作为NUMA示例的图7.4中有所描述;CPU互连在第6章CPU中有所讨论。

如果您怀疑您的系统不属于上述任何一种类型,请查找系统功能图并沿着CPU和内存之间的数据路径,注意沿途的所有组件。

DDR SDRAM

无论是哪种架构,内存总线的速度通常由处理器和系统主板支持的内存接口标准决定。自1996年以来,一种常见的标准是双倍数据速率同步动态随机存取存储器(DDR SDRAM)。双倍数据速率指的是数据在时钟信号的上升沿和下降沿上传输(也称为双倍泵送)。同步一词表示内存与CPU同步时钟。

表7.1显示了一些示例DDR SDRAM标准。

DDR4接口标准于2012年9月发布。这些标准通常以“PC-”开头,后面跟着以每秒兆字节为单位的数据传输速率的名称,例如PC-1600。

多通道

系统架构可能支持并行使用多个内存总线,以提高带宽。常见的倍数包括双通道、三通道和四通道。例如,英特尔Core i7处理器支持最多四通道DDR3-1600,最大内存带宽为51.2 G字节/秒。

CPU缓存

处理器通常包括片上硬件缓存,以提高内存访问性能。缓存可能包括下面逐渐降低速度和增加大小的级别:

第1级:通常分为独立的指令缓存和数据缓存

第2级:用于指令和数据的缓存

第3级:另一个更大的缓存级别

第1级通常由虚拟内存地址引用,而第2级及更高级别则由物理内存地址引用,具体取决于处理器。

这些缓存在第6章CPU中进一步讨论。本章还讨论了另一种类型的硬件缓存TLB。

MMU

内存管理单元负责虚拟地址到物理地址的转换。这些转换是按页执行的,页面内的偏移直接映射。MMU在第6章CPU中引入,与附近的CPU缓存相关。

图7.5显示了一个通用的MMU,包括CPU缓存和主存储器级别。

多种页面大小

现代处理器支持多种页面大小,允许操作系统和MMU使用不同的页面大小,例如4K字节、2M字节、1G字节。基于Solaris的内核支持多种页面大小以及动态创建更大页面大小,称之为多页面大小支持(MPSS)。

Linux具有一个名为huge pages的功能,它为特定的大页面大小(如2M字节)保留了一部分物理内存。提前保留大页面不如Solaris的动态分配方法灵活,但也避免了内存碎片化问题,使得无法动态分配更大的页面。

TLB

图7.5中的MMU使用TLB作为第一级地址转换缓存,然后是主存储器中的页表。TLB可以分成分别用于指令和数据页面的独立缓存。

由于TLB对映射的条目数有限,使用较大的页面大小扩大了可以从其缓存中进行转换的内存范围(其覆盖范围),从而减少了TLB未命中,并改善了系统性能。TLB还可以进一步分成每种页面大小的独立缓存,提高了在缓存中保留较大映射的概率。

以TLB大小为例,典型的Intel Core i7处理器提供了表7.2所示的四个TLB [Intel 12]。

这个处理器具有一个数据TLB级别。英特尔Core微体系结构支持两个级别,就像CPU提供多个主存储器缓存级别一样。

TLB的具体组成取决于处理器类型。请参考供应商的处理器手册,了解您的处理器中的TLB详细信息以及它们的运行方式。

7.3.2 Software

内存管理软件包括虚拟内存系统、地址转换、交换、分页和分配。本节包括与性能相关性最高的主题:释放内存、空闲列表、页面扫描、交换、进程地址空间和内存分配器。

释放内存

当系统上可用内存变得不足时,内核可以使用各种方法来释放内存,并将其添加到空闲页面列表中。

这些方法如图7.6所示,按照可用内存减少的一般顺序使用。

这些方法包括:

- 空闲列表:未使用的页面列表(也称为空闲内存),可立即分配。通常实现为多个空闲页面列表,每个用于一个局部群组(NUMA)。

- Reaping(收割):当低内存阈值被越过时,内核模块和内核slab分配器可以被指示立即释放任何可以轻松释放的内存。这也被称为收缩。

在Linux上,具体方法包括:

- 页面缓存:文件系统缓存。一个名为swappiness的可调参数设置了偏向从页面缓存中释放内存而非交换的程度。

- 交换:这是由页面输出守护进程kswapd进行的分页,它会找到最近未被使用的页面并将其添加到空闲列表中,包括应用程序内存。它们被分页出去,可能涉及写入基于文件系统的交换文件或交换设备。只有在配置了交换文件或设备时才可用。

- OOM killer:内存耗尽终结者将通过查找并终止一个牺牲进程来释放内存,该进程是通过select_bad_process()找到的,然后通过调用oom_kill_process()进行终止。这可能会记录在系统日志(/var/log/messages)中作为“内存不足:终止进程”消息。

在特定的基于Solaris系统上,方法包括:

- 循环页面缓存:这包含一个有效但当前未引用的文件系统页面列表,称为cachelist,根据需要可以将其添加到空闲列表中。这避免了页面扫描的开销。

- ZFS ARC:ZFS文件系统将检测到系统可能很快开始进行页面扫描,并将使用arc_kmem_reap_now()执行自己的收割以释放内存。

- 分页:由页面输出守护程序(也称为页面扫描器)执行,找到最近未被使用的页面并将其添加到空闲列表中,包括应用程序内存。它们被分页出去,可能涉及写入文件系统或交换设备。

- 交换:仍然存在于基于Solaris系统上,它将整个进程移动到交换设备,并是处理主内存压力的原始Unix方法。

- 硬交换:卸载未激活的内核模块,并顺序地将进程交换到交换设备。

这些系统之间的比较很有趣。在基于Solaris系统上,文件系统缓存在分页发生时应为空。Linux提供了一种平衡这种行为的方式:swappiness,一个介于0和100之间的参数(默认值为60),更高的值偏向通过分页应用程序释放内存,而较低的值则通过从页面缓存中回收内存(类似于基于Solaris系统的行为)。这允许通过保留热文件系统缓存而分页出冷应用程序内存来改善系统吞吐量。

如果两个系统上都没有配置交换设备或交换文件,这也很有趣。这将限制虚拟内存大小,因此除非使用超额分配,否则内存分配会更早失败。在Linux上,这也意味着可能更早地使用OOM killer。

考虑一个具有无限内存增长的应用程序问题。有了交换空间,这可能首先成为由于分页而导致的性能问题,这是实时调试问题的机会。没有交换空间,就没有分页的宽限期,所以应用程序要么遇到“内存耗尽”错误,要么OOM killer终止它。如果问题只在几个小时的使用后才出现,这可能会延迟调试问题。

接下来的部分将更详细地描述Linux和Solaris操作系统中的空闲列表、收割以及页面分页守护程序。

空闲列表

最初的Unix内存分配器使用了内存映射和首次适配扫描。随着BSD引入分页虚拟内存,添加了一个空闲列表和一个页面分页守护程序。空闲列表允许立即定位可用内存,如图7.7所示。

释放的内存被添加到列表的头部,以供将来分配使用。由页面分页守护进程释放的内存——可能仍包含有用的缓存文件系统页面——被添加到列表的尾部。如果在有用页面被重新使用之前出现对这些页面的未来请求,则可以重新获取并从空闲列表中删除该页面。

一种空闲列表形式仍然被Linux和基于Solaris的系统使用,如图7.6所示。空闲列表通常通过分配器(例如内核的slab分配器和用户空间的libc malloc)进行消耗。它们会消耗页面,然后通过其分配器API将其公开。

拥有一个单一的空闲列表也是一种简化;如何实现这一点取决于内核类型和版本。

Linux

Linux使用伙伴分配器来管理页面。这为不同大小的内存分配提供了多个空闲列表,遵循以2为底的方案。伙伴这个术语指的是找到相邻的空闲内存页面,以便它们可以一起分配。有关历史背景,请参阅[Peterson 77]。

伙伴空闲列表位于以下层次结构的底部,从每个内存节点pg_data_t开始:

- 节点:内存块,支持NUMA

- 区域:用于特定目的的内存范围(直接内存访问(DMA)、正常、高内存)

- 迁移类型:不可移动的、可回收的、可移动的等

- 大小:以2为底的页数

在节点的空闲列表内进行分配可以改善内存局部性和性能。

Solaris

基于Solaris的系统针对不同的内存位置(mnodes)、页面大小和页面着色使用多个空闲列表。它们也以一种类似伙伴的方式行事,将页面分组为更大的页面大小。这些列表在vm_dep.h中声明。

页面着色是虚拟页地址和物理页地址之间的映射关系,可以使用散列、轮询或其他方案。这是另一种提高访问性能的策略。

回收

回收主要涉及从内核slab分配器缓存中释放内存。这些缓存包含以slab大小为单位的未使用内存块,准备重用。回收将此内存返回给系统以进行页面分配。

在Linux上,内核模块还可以调用register_shrinker()函数来注册用于回收其自己内存的特定函数。

在基于Solaris的系统中,回收主要由kmem_reap()驱动的slab分配器完成。

页面扫描

通过页面分页方式释放内存由内核页面守护进程管理。当空闲列表中的可用主内存下降到阈值以下时,页面分页守护进程开始进行页面扫描。

页面扫描仅在需要时发生。一个通常平衡的系统可能不会经常进行页面扫描,而只在短时间内进行。而基于Solaris的系统在进行页面扫描之前会使用其他机制释放内存,如前面所示,超过几秒钟的页面扫描通常是内存压力问题的迹象。

Linux

页面分页守护进程称为kswapd(),它扫描处于非活跃和活跃内存的LRU(最近最少使用)页面列表以释放页面。它根据空闲内存和两个阈值唤醒,以提供滞后效应,如图7.8所示。

一旦空闲内存达到最低阈值,kswapd会以同步模式运行,根据请求释放内存页面(内核免除此要求)[Gorman 04]。这个最低阈值是可调的(vm.min_free_kbytes),其他阈值根据它进行缩放(乘以2倍、3倍)。

页面缓存有专门的列表用于存储非活跃页面和活跃页面。它们以LRU(最近最少使用)的方式运作,使得kswapd能够快速找到空闲页面。这些列表如图7.9所示。

kswapd首先扫描非活跃列表,如果需要的话再扫描活跃列表。扫描这个术语指的是在遍历列表时检查页面:如果页面被锁定或者是脏页,则不能释放。在原始的页面分页守护进程中,"扫描"一词有着不同的含义,它会扫描整个内存,在基于Solaris的系统中仍然存在。

Solaris

页面扫描循环遍历内存中的所有页面,找到最近最少使用的页面,然后安排将它们移动到物理交换设备上。这最初是在带有分页虚拟内存的BSD系统中添加的[Babaoglu 79],后来改进为使用两个指针来扫描内存,如图7.10所示(这种类似时钟的表示方法可以追溯到Multics系统[Corbató 68])。

第一个hand在每个页面上设置一个位,指示该页面尚未被访问。当页面被访问时,这个位会被清除。第二个hand会检查这个位是否仍然被设置。如果是,页面扫描器就知道该页面最近没有被使用,可以被换出。两个hand之间的距离是可调的(handspreadpages)。

页面扫描的速率是动态的,根据可用的空闲内存而变化。这在图7.11中以一个128GB系统为例进行了说明,同时列出了可调的名称(基于[McDougall 06a])。

当可用内存降到desfree以下,然后是minfree以下时,页面换出守护进程会更频繁地被唤醒以扫描页面。如果可用内存连续30秒低于desfree,内核也会开始进行交换。

这些可调参数在setupclock()函数中初始化,根据主内存的比例进行设置。例如,lotsfree被设置为1/64。赤字参数是动态的,当内存消耗快速增加时会增长,这样内核就能更早地增加空闲列表。

对于较大的系统而言,页面扫描变得昂贵,因此添加了循环页面缓存,以便可以快速找到页面。这类似于Linux页面换出守护进程查找页面的方式。

7.3.3 Process Address Space

由硬件和软件共同管理,进程虚拟地址空间是一系列根据需要映射到物理页面的虚拟页面。这些地址被分割成称为段的区域,用于存储线程堆栈、进程可执行文件、库和堆。图7.12展示了32位进程的示例,适用于x86和SPARC处理器。

程序可执行段包含单独的文本和数据段。库也由单独的可执行文本和数据段组成。这些不同的段类型包括:

- 可执行文本:包含进程的可执行CPU指令。它是从文件系统上的二进制程序的文本段映射而来。它具有只读和可执行的权限。

- 可执行数据:包含从二进制程序的数据段映射而来的初始化变量。它具有读/写权限,因此可以在程序运行时修改变量。它还具有私有标志,以便修改不被刷新到磁盘上。

- 堆:这是程序的工作内存,是匿名内存(没有文件系统位置)。它根据需要增长,并通过malloc()进行分配。

- 栈:正在运行的线程的堆栈,映射为可读/写。

库的文本段可以被使用相同库的其他进程共享,每个进程都有一个私有副本的库数据段。

堆的增长

一个常见的困惑源于堆的无限增长。这是否意味着内存泄漏?

对于大多数分配器来说,不会将内存归还给操作系统;相反,它会保留内存以便为未来的分配提供服务。这意味着进程的常驻内存只会增长,这是正常的。进程减少内存的方法包括:

- 重新执行:从一个空地址空间重新开始

- 内存映射:使用和,它们会将内存归还给系统

一些分配器支持mmap作为一种操作模式。请参阅第8章文件系统中的第8.3.10节,内存映射文件。

7.3.4 Allocators

有各种用户级和内核级分配器用于内存分配。图7.13展示了分配器的作用,包括一些常见类型。

页面管理在之前的第7.3.2节“空闲列表”中有所描述。

内存分配器的特性可以包括:

- 简单的API:例如,`malloc`、`free`。

- 高效的内存使用:当为各种大小的内存分配提供服务时,内存使用可能会变得分散,存在许多未使用的区域浪费内存。分配器可以努力合并未使用的区域,使较大的分配能够利用它们,提高效率。

- 性能:内存分配可能频繁发生,在多线程环境下,由于同步原语的竞争,性能可能表现不佳。分配器可以被设计为尽量少地使用锁,并且利用每个线程或每个CPU的缓存来提高内存局部性。

- 可观察性:分配器可以提供统计信息和调试模式,显示它的使用方式以及哪些代码路径负责分配。接下来的章节将描述内核级分配器——slab和SLUB,以及用户级分配器——libmalloc、libumem和mtmalloc。

Slab(页框)

内核slab分配器管理特定大小对象的缓存,使它们能够在无需分配页面的情况下快速回收。这对于内核分配特别有效,因为内核分配通常是针对固定大小的结构体。

作为内核中的一个示例,以下两行代码摘自ZFS arc.c:

第一个函数`kmem_alloc()`展示了一种传统样式的内核分配,其大小作为参数传递。内核根据该大小将其映射到一个slab缓存(或者是一个超大尺寸区域)。第二个函数`kmem_cache_alloc()`直接在自定义的slab分配器缓存上操作,在这种情况下是`(kmem_cache_t *)hdr_cache`。

Solaris 2.4中引入了这一机制[Bonwick 94],后来通过每CPU缓存(称为magazines)进行了增强[Bonwick 01]:

我们的基本方法是给每个CPU分配一个包含M个对象的缓存,称为magazine,类比于自动武器。每个CPU的magazine可以在CPU需要重新加载之前满足M次分配——也就是说,将其空的magazine换成一个满的magazine。

除了高性能外,Solaris为slab分配器提供了各种调试和分析工具。其中包括审计功能,可以跟踪分配细节,包括堆栈信息。

slab分配器在Linux的2.2版本中引入,多年来一直是默认选项。最近的内核版本提供SLUB作为选项或默认选项。

SLUB

Linux内核的SLUB分配器基于slab分配器,并旨在解决slab分配器的各种问题,特别是其复杂性。这些包括移除对象队列和每个CPU缓存,将NUMA优化留给页面分配器(参见上文的自由列表部分)。

SLUB分配器在Linux 2.6.23中成为默认选项[2]。

libc

Solaris的用户级分配器由libc提供,它简单且通用。尽管通常是默认的分配器(取决于编译器配置),但man页不建议使用它(malloc(3C)):

这些默认的内存分配例程对于多线程应用程序是安全的,但不具备可扩展性。通过使用一个锁,多个线程的并发访问是单线程化的。对于大量使用动态内存分配的多线程应用程序,应链接使用为并发访问设计的分配库,如libumem(3LIB)或libmtmalloc(3LIB)。

除了性能问题外,该分配器是基于堆的,并且随着时间的推移可能会受到碎片化的影响。

glibc

GNU libc分配器基于Doug Lea的dlmalloc。其行为取决于分配请求的大小。小型分配从内存块中提供服务,这些内存块包含相似大小的单位,可以使用伙伴算法合并。较大的分配可以使用树查找来高效地找到空间。而非常大的分配则切换到使用mmap()。其结果是一个性能优秀的分配器,充分利用了多种分配策略的优势。

libumem

在基于Solaris的系统中,libumem是slab分配器的用户空间版本。可以通过链接或预加载库来使用,并为多线程应用程序提供改进的性能。

libumem从一开始就设计为可扩展,并具有以最小的时间和空间开销为代价的调试和分析功能。其他内存分析工具在分析模式下会减慢目标速度,有时甚至导致问题不再发生,而且通常会使它们不适合在生产环境中使用。

mtmalloc

这是另一个针对基于Solaris的系统的高性能多线程用户级分配器。它使用每个线程的缓存来处理小型分配,并使用单个超大区域来处理大型分配。每个线程的缓存避免了传统分配器中的锁争用问题。

7.4 Methodology

本节介绍了用于内存分析和调优的各种方法和练习。这些主题在表7.3中进行了总结。

请参阅第2章“方法论”了解更多策略以及对其中许多内容的介绍。

这些方法可以单独使用,也可以组合使用。我建议首先按照以下顺序使用以下策略:性能监控,USE方法和使用特征化。

第7.5节“分析”展示了应用这些方法的操作系统工具。

7.4.1 Tools Method

工具方法是一个迭代使用可用工具,检查它们提供的关键指标的过程。虽然是一种简单的方法,但它可能忽视那些工具无法提供良好或没有可见性的问题,并且执行起来可能耗时。

对于内存问题,工具方法可以包括检查以下内容:

- 页面扫描:查看持续的页面扫描(超过10秒)是否表示内存压力。在Linux上,可以使用sar -B命令并检查pgscan列。在Solaris上,可以使用vmstat(1M)命令并检查sr列。

- 分页:内存分页是系统内存不足的进一步指示。在Linux上,可以使用vmstat(8)命令并检查si和so列(这里,换出一词表示匿名分页)。在Solaris上,vmstat -p显示按类型的分页;要检查匿名分页。

- vmstat:每秒运行vmstat,并检查可用内存的free列。

- OOM killer:仅适用于Linux,在系统日志/var/log/messages中可以看到这些事件,也可以使用dmesg(1)命令。搜索“Out of memory”。

- 交换:仅适用于Solaris,通常在事后注意到,通过运行vmstat并检查w列来指示已交换出的线程。要实时查看交换情况,使用vmstat -S并检查si和so。

- top/prstat:查看哪些进程和用户是最大的物理内存消耗者(驻留),以及虚拟内存消耗者(请参阅man手册以获取列名,根据版本不同名称可能会有所不同)。这些工具还总结了可用内存。

- dtrace/stap/perf:使用堆栈跟踪跟踪内存分配,以确定内存使用的原因。

如果发现问题,请从可用工具的所有字段中检查,以获取更多上下文信息。有关每个工具的更多信息,请参阅第7.5节“分析”。其他方法可能会识别更多类型的问题。

7.4.2 USE Method

USE 方法用于在性能调查早期跨所有组件识别瓶颈和错误,这样可以在深入和耗时更长的策略之前进行检查。

系统范围内需要检查以下内容:

- 利用率:内存使用量及可用量。应检查物理内存和虚拟内存。

- 饱和度:页面扫描程度、分页、交换以及Linux OOM killer 的牺牲次数,作为减轻内存压力的措施。

- 错误:内存分配失败。

饱和度可能首先进行检查,因为持续饱和是内存问题的迹象。这些指标通常可以从操作系统工具中轻松获取,包括 vmstat(1)、sar(1) 和用于 OOM killer sacrifices 的 dmesg(1)。对于配置有单独磁盘交换设备的系统,任何与交换设备的活动也是内存压力的迹象。

利用率通常较难阅读和解释。通过饱和度指标,您可以了解物理内存是否不足:系统开始分页或进程被牺牲(OOM)。要确定物理利用率,您需要知道有多少可用内存(free)。不同工具可能以不同方式报告这一点,这取决于它们是否考虑了未引用的文件系统缓存页面或非活动页面。系统可能报告只剩下 10MB 可用内存,但实际上有 10GB 文件系统缓存,可以在需要时立即被应用程序回收。查看工具文档以了解其中包含哪些内容。

根据系统是否执行过量承诺,还可能需要检查虚拟内存利用率。对于那些不执行过量承诺的系统,一旦虚拟内存耗尽,内存分配将失败,这是一种内存错误。

历史上,内存错误一直由应用程序报告,尽管并非所有应用程序都这样做(而且在 Linux 过量承诺的情况下,开发人员可能认为没有必要这样做)。最近,SmartOS 添加了系统错误计数器,用于报告每个区域的失败 brk() 调用,作为一种内存相关错误计数器。

对于实施内存限制或配额(资源控制)的环境,如某些云计算环境,可能需要以不同方式测量内存饱和度。例如,在基于 Solaris 的系统上实施 OS 虚拟化时,对于每个客户实例强制执行内存配额的机制不同,并将其与传统的页面扫描器报告的方式有所不同。您的 OS 实例可能已达到其内存限制并进行分页,尽管系统并未使用传统的页面扫描器进行扫描。

7.4.3 Characterizing Usage

对内存使用情况进行表征是进行容量规划、基准测试和模拟工作负载时的重要练习。通过识别配置错误,它也可以带来一些最大的性能增益。例如,数据库缓存可能配置过小,导致命中率低,或者配置过大,引起系统分页。

对于内存,这涉及识别内存使用的位置和数量:

- 系统范围内的物理和虚拟内存利用率

- 饱和度程度:页面扫描、交换、OOM kill

- 内核和文件系统缓存内存使用

- 每个进程的物理和虚拟内存使用

- 如果存在,内存资源控制的使用

下面是一个示例描述,展示了如何将这些属性结合在一起表达:

该系统有 256GB 的主内存,仅利用了 1%,其中有 30% 存储在文件系统缓存中。最大的进程是一个数据库,消耗了 2GB 的主内存(RSS),这是它从之前迁移的系统中配置的限制。

随着更多内存用于缓存工作数据,这些特征可能随时间变化。由于内存泄漏(软件错误)而导致的内核或应用程序内存也可能随时间持续增长,而不仅仅是常规缓存增长。

高级用法分析/检查清单

可能需要包含更多详细信息以更详细地了解使用情况。以下列出了一些考虑问题的问题,这些问题在彻底研究内存问题时也可以作为检查清单:

- 内核内存用于哪里?每个 slab?

- 文件系统缓存(或页面缓存)中有多少是活动的,而不是非活动的?

- 进程内存用于哪里?

- 为什么进程分配内存(调用路径)?

- 为什么内核分配内存(调用路径)?

- 哪些进程正在被分页/交换出?

- 哪些进程以前曾被分页/交换出?

- 进程或内核可能存在内存泄漏吗?

- 在 NUMA 系统中,内存分布在内存节点上的情况如何?

- CPI 和内存停顿周期率是多少?

- 内存总线平衡程度如何?

- 本地内存 I/O 相对于远程内存 I/O 执行了多少?

接下来的章节可以帮助回答其中的一些问题。请参阅第二章“方法论”,了解此方法论的更高级摘要以及要测量的特征(谁、为什么、什么、如何)。

7.4.4 Cycle Analysis

可以通过检查 CPU 性能计数器(CPCs)来确定内存总线负载,这些计数器可以被编程为计算内存停顿周期。它们也可以用来测量每指令周期(CPI),作为衡量 CPU 负载对内存依赖程度的一种指标。请参阅第六章“CPU”了解更多信息。

7.4.5 Performance Monitoring

性能监测可以识别长期内的活跃问题和行为模式。内存的关键指标包括:

- 利用率:已使用百分比,可以从可用内存中推断出

- 饱和度:页面扫描、交换、OOM kill

对于实施内存限制或配额(资源控制)的环境,还可能需要收集与施加限制相关的统计信息。

还可以监视错误(如果可用),这些错误在第7.4.2节“USE 方法”中与利用率和饱和度一起描述。

随时间监视内存使用情况,尤其是按进程监视,可以帮助识别内存泄漏的存在和速率。

7.4.6 Leak Detection

当应用程序或内核模块不断增长,从空闲列表、文件系统缓存,最终从其他进程中消耗内存时,就会出现这个问题。首次注意到这个问题是因为系统正在分页,以应对不断增长的内存压力。

这种问题可能是由以下原因引起的:

- 内存泄漏:一种软件缺陷,内存被遗忘但永远不会释放。可以通过修改软件代码或应用补丁或升级(修改代码)来解决。

- 内存增长:软件正常消耗内存,但速度远高于系统所需。可以通过更改软件配置或软件开发人员更改应用程序消耗内存的方式来解决。

内存增长问题经常被误认为是内存泄漏。首先要问的问题是:它是否应该那样做?检查配置。

如何分析内存泄漏取决于软件和语言类型。一些分配器提供调试模式,用于记录分配细节,然后可以在事后进行分析,以确定责任调用路径。开发人员还可以使用工具进行内存泄漏调查。

7.4.7 Static Performance Tuning

静态性能调优侧重于已配置环境的问题。对于内存性能,需要检查静态配置的以下方面:

- 总共有多少主内存?

- 应用程序配置为使用多少内存(它们自己的配置)?

- 应用程序使用哪些内存分配器?

- 主内存的速度是多少?它是最快的类型吗?

- 系统架构是什么?NUMA,UMA?

- 操作系统是否具有NUMA意识?

- 存在多少内存总线?

- CPU缓存的数量和大小是多少?TLB?

- 是否配置并使用了大页?

- 是否可用并进行了超额承诺?

- 其他系统内存可调参数正在使用吗?

- 是否存在软件规定的内存限制(资源控制)?

回答这些问题可能会揭示被忽视的配置选择。

7.4.8 Resource Controls

操作系统可能为内存分配给进程或进程组提供细粒度控制。这些控制可能包括主内存和虚拟内存使用的固定限制。它们的工作方式是特定于实现的,并在第7.6节“调优”中进行了讨论。

7.4.9 Micro-Benchmarking

微基准测试可用于确定主存储器的速度和CPU缓存以及缓存行大小等特性。在分析系统之间的差异时,它可能会有所帮助,因为内存访问速度可能对性能的影响大于CPU时钟速度,这取决于应用程序和工作负载。在第6章“CPU”中,在CPU缓存下的延迟部分(第6.4.1节),展示了微基准测试内存访问延迟的结果,以确定CPU缓存的特性。

7.5 Analysis

这一部分介绍了针对基于Linux和Solaris的操作系统的内存分析工具。请参阅前一部分,了解在使用它们时应遵循的策略。本节中的工具列在表7.4中。

这是一些工具和功能的选择,用于支持第7.4节“方法论”,从系统范围的内存使用统计开始,然后深入到每个进程和分配的跟踪。请查看工具文档,包括man手册,以获取有关其功能的完整参考资料。此外,请参阅第8章“文件系统”,了解更多用于调查文件系统内存使用情况的工具。

虽然您可能只关注基于Linux或Solaris的系统,但请考虑其他操作系统工具以及它们提供的可观察性,以获得不同的视角。

7.5.1 vmstat

虚拟内存统计命令vmstat提供了系统内存健康状况的高层视图,包括当前空闲内存和分页统计信息。CPU统计信息也包括在内,如第6章“CPU”所述。

这个命令是由Bill Joy和Ozalp Babaoglu于1979年为BSD引入的。最初的man手册包括一个BUGS部分:打印出来的数字太多,有时很难弄清楚要观察什么。许多列自第一个版本以来基本保持不变,特别是对于Solaris。接下来的部分将展示Linux和基于Solaris的版本的列和选项。

Linux

以下是示例输出:

这个vmstat(8)版本在输出的第一行不打印自引导以来内存列的总结数值,而是立即显示当前状态。默认情况下,这些列的单位是千字节,并分别表示以下内容:

- swpd: 交换出的内存量

- free: 可用空闲内存

- buff: 缓冲区中的内存

- cache: 页面缓存中的内存

- si: 交换入的内存(分页)

- so: 交换出的内存(分页)

缓冲区和页面缓存在第8章“文件系统”中有描述。在系统引导后,系统中的可用空闲内存通常会减少,并被这些缓存使用以提高性能。当需要时,它可以被释放供应用程序使用。如果si和so列持续不为零,说明系统面临内存压力,并且正在向交换设备或文件进行分页(参见swapon(8))。可以使用其他工具,包括按进程查看内存使用情况,来调查内存的消耗情况。在拥有大量内存的系统上,这些列可能会变得不对齐并且有点难以阅读。您可以尝试使用-S选项将输出单位更改为兆字节。

还有一个-a选项,用于打印页面缓存中不活跃和活跃内存的详细信息:

可以使用-s选项将这些内存统计信息打印为列表。

Solaris

在基于Solaris的系统上,vmstat(1)命令更接近于BSD的原始版本。有许多字段显示了页面写出守护程序的活动情况,这对于尚未了解页面扫描器内部工作原理的用户来说可能有点不太友好。

以下是示例输出:

在拥有大量内存的系统上,这些列可能会变得不对齐。输出的第一行是自引导以来的总结情况。与内存相关的列包括:

- w: 被交换出的线程数

- swap: 可用虚拟内存(千字节)

- free: 可用空闲内存,包括页面缓存和空闲列表(千字节)

- re: 从页面缓存中回收的页面(缓存命中)

- mf: 小错误

- pi: 分页进入的内存,所有类型(千字节)

- po: 分页出去的内存,所有类型(千字节)

- fr: 页面缓存内存由页面扫描器或文件系统释放(千字节)

- de: 不足—预期的短期内存不足(千字节)(参见第7.3.2节“软件”的Solaris部分)

- sr: 被页面写出守护程序扫描的页面

示例输出显示了一个过去曾经出现问题的系统,有113个线程被交换出(w)。页面扫描器目前没有运行(sr),因此系统目前没有过多的内存压力。有少量的页面进入(pi),尽管它们可能是正常的(文件系统)或异常的(匿名)。-p选项显示了页面进入、页面退出和释放的详细情况:

该系统存在匿名页面进入的频率(api),这是“不良”的分页行为。这会在应用程序运行时引起同步磁盘I/O级别的延迟。在这种情况下,这可能是由于先前的内存压力事件导致了内存页面出去,而活动线程目前正在被重新分页回来。

如果需要的话,可以通过kstat针对每个CPU观察许多这些统计信息。请参阅cpu::vm:统计数据组。kstat是在第4章“可观测性工具”中介绍的。

系统启动后,可用空闲内存(free)下降是正常的,因为内存被页面缓存和其他内核缓存使用。当需要时,这部分内存可以返回给应用程序使用。系统持续进行分页扫描(sr)并不正常,这是内存压力问题的迹象。如果是这种情况,请使用其他工具(例如按进程查看内存使用情况)来查看内存的使用情况。

7.5.2 sar

系统活动报告工具sar(1)可用于观察当前活动,并可配置为存档和报告历史统计数据。在本书的各个章节中提到了它,因为它提供了不同的统计信息。

Linux

Linux版本通过以下选项提供内存统计信息:

- B: 分页统计

- H: 大页面统计

- r: 内存利用率

- R: 内存统计

- S: 交换空间统计

- W: 交换统计

这些选项涵盖了内存使用情况、页面写出守护程序的活动以及大页面的使用情况。有关这些主题的背景,请参阅第7.3节“架构”。

提供的统计数据包括表7.5中列出的内容。

许多统计名称包括衡量单位:pg表示页面,kb表示千字节,%表示百分比,/s表示每秒。请查阅man手册获取完整列表,其中包括一些额外的基于百分比的统计数据。

重要的是要记住,在需要时可以获得关于高级内存子系统的使用和操作的如此详细的信息。要更深入地了解这些信息,您可能需要浏览mm目录下特定的源代码文件mm/vmscan.c。此外,linux-mm邮件列表中有许多帖子提供了进一步的见解,开发人员在讨论统计数据应该是什么。

%vmeff指标是页面回收效率的一个有趣的度量。高值表示页面成功从非活动列表中被窃取(健康);低值表示系统正在努力应对。man手册将近100%描述为高效,小于30%描述为低效。

Solaris版本提供以下选项:

- g: 分页统计

- k: 内核内存分配统计

- p: 分页活动

- r: 未使用内存指标

- w: 交换统计

这些选项涵盖了内存使用、内核分配、分页和交换等内容。有关这些主题的背景,请参阅第7.3节“架构”。

提供的统计数据包括表7.6中列出的内容。

将“-k”分解为“small”和“large”池在今天看来似乎有些不同寻常。我怀疑这是一个历史遗留问题,支持SVR4的延迟伙伴分配器所使用的大内存池和小内存池[Vahalia 96]。

更多有关内存子系统的统计信息可以通过kstat读取,或者使用DTrace动态构建。

7.5.3 slabtop

Linux的slabtop(1)命令从slab分配器中打印内核slab缓存的使用情况。类似于top(1),它实时刷新屏幕。

以下是一些示例输出:

输出内容顶部有一个摘要,下面是一个slab列表,包括它们的对象数量(OBJS)、活跃对象数量(ACTIVE)、使用百分比(USE)、对象大小(OBJ SIZE,字节)和缓存的总大小(CACHE SIZE,字节)。

在这个例子中,使用了-sc选项按缓存大小排序,最大的在顶部。

这些slab统计数据来自/proc/slabinfo,也可以使用vmstat -m打印出来。

7.5.4 ::kmastat

在基于Solaris的系统上,用于mdb(1)的::kmastat调试器命令(dcmd)总结了内核内存的使用情况。输出分为三部分:slab分配器缓存使用情况、使用摘要和vmem使用摘要。

以下是一些示例输出:

输出内容超过了500行,这里进行了截断。尽管冗长,但在追踪内核内存增长的源头时可能是非常宝贵的。

其他有用的与内存相关的dcmd包括::kmem_slabs、::kmem_slabs -v和::memstat。例如:

虽然这是一个有用的摘要,但缺点是您必须是超级用户(root)并且正在运行mdb -k才能查看它。

7.5.5 ps

进程状态命令ps(1)列出了所有进程的详细信息,包括内存使用统计数据。其用法在第六章“CPU”中介绍。

例如,使用BSD风格选项:

这些输出包括以下列:

- %MEM:主内存使用量(物理内存,RSS)占系统总量的百分比

- RSS:常驻集大小(KB)

- VSZ:虚拟内存大小(KB)

尽管RSS显示了主内存的使用量,但它包括了诸如系统库之类的共享段,这些共享段可能被数十个进程映射。如果你对RSS列进行求和,你可能会发现它超过了系统中可用的内存,这是由于对这些共享内存的重复计数。请参阅后面的pmap(1)命令以分析共享内存的使用情况。

可以使用SVR4风格的-o选项选择这些列,例如:

Linux版本还可以打印主要和次要错误列(maj_flt,min_flt)。

在Solaris上,主要和次要错误信息可以在/proc中找到,但目前未从ps(1)中公开。另外请注意,aux输出中存在一个bug,导致RSS和VSZ列可能会合并——缺少空格分隔符。这个问题在最近的illumos/SmartOS中已经修复。

ps(1)的输出可以在内存列上进行后排序,以便快速识别消耗最高的进程。或者尝试使用top(1)和prstat(1M)工具,它们提供了排序选项。

7.5.6 top

top(1)命令监视当前运行的前几个进程,并包括内存使用统计数据。它在第六章“CPU”中介绍。例如,在Linux系统中:

顶部的摘要显示了主内存(Mem)和虚拟内存(Swap)的总量、已使用量和空闲量。同时也显示了缓冲缓存(buffers)和页面缓存(cached)的大小。

在这个例子中,通过配置top命令并改变排序顺序,按%MEM对每个进程的输出进行了排序。在这个例子中,最大的进程是node,它使用了2.2 GB的主内存和将近3 GB的虚拟内存。

主内存百分比列(%MEM)、虚拟内存大小(VIRT)和常驻集大小(RES)的含义与之前描述的ps(1)中相应的列相同。

7.5.7 prstat

prstat(1M)命令是为基于Solaris的系统引入的类似于top的工具,并在第6章“CPU”中介绍过。例如:

在这个例子中,排序顺序被设置为RSS(-s rss),以便将最大的内存消耗者列在顶部。进程名为redis-server的进程远远是最大的,占用45 GB的主内存(RSS)和65 GB的虚拟内存(SIZE)。

prstat(1M)可以打印微状态账户统计信息,其中包括文本和数据错误时间。对于这台服务器:

这个庞大的redis-server进程在等待数据错误(DFL)的时间百分比较高。这是之前vmstat -p示例中显示匿名页面换入率的相同服务器,这两者可能有关联:系统内存可能不足,将redis-server换出,并且现在正在等待(DFL)将其换回。

7.5.8 pmap

pmap(1)命令列出了进程的内存映射,显示它们的大小、权限和映射的对象。这允许更详细地检查进程的内存使用情况,并量化共享内存。例如,在基于Solaris的系统上:

这显示了一个PostgreSQL数据库的内存映射,包括虚拟内存(Kbytes)、主内存(RSS)、私有匿名内存(Anon)和权限(Mode)。对于大多数映射,很少有内存是匿名的,大部分是只读(r-x),这意味着这些页面可以与其他进程共享。这在系统库中尤其如此。这个例子中消耗的大部分内存位于一个共享内存段(ism)中。

Linux版本的pmap(1)类似,并基于Solaris版本。更新的版本使用Dirty一词代替Anon。

Solaris版本提供了一个-s选项来显示映射的页面大小:

这个PostgreSQL数据库的共享内存段主要使用了2兆字节的页面。

pmap(1)的输出对于具有许多映射的进程来说可能很长。它在报告内存使用情况时会暂停进程,这可能会影响正在进行的活动工作的性能。它在需要诊断和分析时很有用,但不应作为定期监控工具定期运行。

7.5.9 DTrace

DTrace可以用于跟踪用户级和内核级分配、次要和主要页面错误,以及页面换出守护进程的操作。这些功能支持对使用情况的表征和深入分析。

以下各节介绍了在基于Solaris和Linux的系统上进行内存分析的DTrace。除非另有说明,DTrace命令适用于两个操作系统。DTrace入门内容已包含在第4章“可观察性工具”中。

分配跟踪

如果可用,可以使用pid提供程序跟踪用户级分配器。这是一个动态跟踪提供程序,这意味着软件可以在任何时刻进行插装,无需重新启动,也无需事先配置分配器以运行在调试模式下。

以下示例总结了对malloc()调用的请求大小,针对PID 15041(一个Riak数据库):

所有请求的分配大小介于512字节和16,383字节之间,大部分在1-2 K字节的范围内。

这个一行代码总结了malloc()的请求字节数,即将第一个参数(arg0)传递给二次幂quantize()聚合函数。如果需要,还可以跟踪malloc()的返回值,以检查分配是否成功。

关键是将其设置为“请求字节”,仅用于使用ustack()动作装饰输出时包含用户级堆栈跟踪。

在这种情况下,输出非常长,已经被截断以适应。它显示了导致分配的用户级堆栈跟踪,以及请求分配大小的分布情况。

由于分配是频繁发生的活动,尽管每个事件的追踪速度很快,但在追踪过程中成本可能会累积,并引起性能开销。

还可以调查用户级分配器的其他内部情况。例如,列出libumem分配器的入口探测点:

输出列出了163个入口探测点。这些可以用于构建更复杂的一行代码和脚本,以调查分配器的内部情况。

内核级分配器可以使用类似的方式进行跟踪,使用动态fbt提供程序。例如,在基于Solaris的系统上,以下一行代码跟踪slab分配器:

输出包括缓存的名称,后跟用于分配的内核堆栈跟踪,然后是跟踪时的计数。

以下一行代码展示了跟踪用户级和内核级分配器的不同方式。

一行代码示例

总结进程PID的用户级malloc()请求大小:

![]()

总结进程PID的带调用堆栈的用户级malloc()请求大小:

![]()

统计libumem函数调用次数:

![]()

统计用户级堆增长(通过brk()函数)的堆栈数:

![]()

跟踪Solaris系统中按缓存名称和堆栈跟踪的内核级slab分配:

故障跟踪

页面错误的跟踪可以进一步揭示系统如何提供内存。 可以使用动态fbt提供程序或可用的稳定vminfo提供程序来执行此操作。

例如,在基于Solaris的系统上,以下一行代码跟踪名为"beam.smp"的进程(这是 Erlang VM,在本例中运行 Riak 数据库)的次要错误,并统计用户级堆栈跟踪,深度为五层:

这总结了消耗内存并引起次要错误的代码路径。在这种情况下,是 Erlang 垃圾回收代码。也可以使用vminfo:::maj_fault探测点跟踪主要错误。

另一个有用的与故障相关的探测点是vminfo:::anonpgin,用于匿名页面导入。例如:

这条跟踪了系统范围内的匿名页面导入,统计了进程ID和进程名称。这与之前vmstat(1)示例所展示的相同系统,该示例确定了匿名页面导入,并且与prstat(1M)示例相同,该示例确定了redis-server在数据错误中花费的时间。这个DTrace一行代码连接了这些信息,确认了redis-server正花费时间在匿名页面导入上,这是由于系统内存不足和分页引起的。

页面输出守护进程

如果需要,也可以使用fbt提供程序跟踪页面输出守护进程的内部操作。具体操作取决于内核版本。

7.5.10 SystemTap

在Linux系统上,也可以使用SystemTap进行文件系统事件的动态跟踪。请参阅第4章“可观测性工具”中的第4.4节“SystemTap”,以及附录E,了解如何将之前的DTrace脚本转换为SystemTap脚本。

7.5.11 Other Tools

其他Linux内存性能工具包括以下内容:

- free:报告空闲内存,包括缓冲区缓存和页面缓存(请参阅第8章“文件系统”)。

- dmesg:检查来自OOM killer的“内存不足”消息。

- valgrind:一个性能分析套件,包括memcheck,用于内存使用分析和泄漏检测的用户级分配器包装器。这会带来显著的开销;手册建议可能导致目标运行速度减慢20到30倍。

- swapon:用于添加和观察物理交换设备或文件。

- iostat:如果交换设备是物理磁盘或分区,可以使用iostat(1)观察设备I/O,指示系统正在分页。

- perf:在第6章“CPU”中介绍,可用于调查CPI、MMU/TSB事件以及来自CPU性能测试计数器的内存总线停顿周期。它还提供用于页面故障和多个内核内存(kmem)事件的探针。

- /proc/zoneinfo:内存区域(NUMA节点)的统计信息。

- /proc/buddyinfo:内核伙伴分配器页面的统计信息。

其他Solaris内存性能工具包括以下内容:

- prtconf:显示已安装物理内存大小(可以使用|grep Mem或在更新版本中使用-m进行过滤)。

- prtdiag:显示物理内存布局(适用于支持的系统)。

- swap:交换统计信息:列出交换设备(-l),并总结使用情况(-s)。

- iostat:如果交换设备是物理磁盘或分区,可以使用iostat(1)观察设备I/O,指示系统正在分页或交换。

- cpustat:在第6章“CPU”中介绍,可用于调查CPI、MMU/TSB事件以及来自CPU性能测试计数器的内存总线停顿周期。

- trapstat:打印陷阱统计信息,包括不同页面大小的TLB/TSB缺失率和消耗的CPU百分比。目前仅在SPARC处理器上受支持。

- kstat:包含更多统计信息,用于了解内核内存使用情况。对于其中大多数内容,唯一的文档是源代码(如果可用)。

应用程序和虚拟机(例如Java虚拟机)也可能提供自己的内存分析工具。请参阅第5章“应用程序”。

一些分配器维护自己的统计信息以便观察。例如,可以使用Solaris上的mdb(1) dcmds来调查libumem库。

这显示了::vmem,它打印了由libumem使用的内部虚拟内存结构及其使用情况,以及::umem_malloc_info,它显示按缓存分配的统计信息,可以指示内存按大小的使用模式(将BUFSZ与MALLOCED进行比较)。虽然只提供基本属性,但这些命令可以揭示通常是不透明的进程堆中的情况。

7.6 Tuning

最重要的内存调优是确保应用程序保持在主内存中,避免频繁发生分页和交换。识别这个问题已经在第7.4节“方法论”和第7.5节“分析”中讨论过。本节讨论其他内存调优内容:内核可调参数、配置大页面、分配器和资源控制。

调优的具体内容——可用的选项以及如何设置它们——取决于操作系统版本和预期的工作负载。下面按调优类型组织的各节提供了可能可用的示例,以及为什么可能需要进行调优。

7.6.1 Tunable Parameters

这一部分描述了最近的Linux和基于Solaris的内核的可调参数示例。

Linux

各种内存可调参数在内核源代码文档Documentation/sysctl/vm.txt中有描述,并可以使用sysctl(8)进行设置。表7.7中的示例来自3.2.6内核,其中默认值来自Fedora 16。

这些可调参数采用了包含单位的一致命名方案。请注意,dirty_background_bytes和dirty_background_ratio是互斥的,同样dirty_bytes和dirty_ratio也是互斥的(只能设置一个)。

vm.min_free_kbytes的大小会动态设置为主内存的一部分。选择此数值的算法并非线性,因为空闲内存需求与主内存大小并不呈线性比例关系(有关详细信息,请参阅mm/page_alloc.c中的文档)。vm.min_free_kbytes可以减少以释放一些内存供应用程序使用,但这也可能导致在内存压力下内核被迫更早地使用OOM。

另一个避免OOM(Out of Memory)的参数是vm.overcommit_memory,可以将其设置为2以禁用过度承诺,并避免导致OOM的情况发生。如果希望根据每个进程进行OOM killer的控制,请查看您的内核版本是否具有/proc可调参数,例如oom_adj或oom_score_adj。这些内容应该在Documentation/filesystems/proc.txt中有所描述。

vm.swappiness可调参数在早于预期开始交换应用程序内存时可能会显著影响性能。该可调参数的值可以介于0和100之间,较高的值有利于交换应用程序,从而保留页面缓存。可能希望将其设置为零,以便尽可能长时间地保留应用程序内存,以牺牲页面缓存为代价。当仍然存在内存短缺时,内核仍然可以使用交换。

Solaris

表7.8显示了内存的关键可调参数,可以在/etc/system中设置,同时列出了典型的默认值。请参阅供应商文档以获取完整列表、设置说明、描述和警告。其中一些在图7.11中已经展示过。

可以使用pagesize(1)命令来确定这些单位的含义。

请注意,有时公司或供应商政策可能禁止调整内核可调参数(请先检查)。这些参数应该已经设置为适当的值,并且不需要进行调整。

对于大容量内存系统(超过100 GB),调整其中一些参数至较低值可能是值得的,以释放更多内存供应用程序使用。在具有多个存储设备(例如存储阵列)的系统中,可能需要增加maxpgio,以使队列长度更适合可用的I/O容量。

7.6.2 Multiple Page Sizes

大页面大小可以通过提高TLB缓存的命中率(增加其范围)来改善内存I/O性能。大多数现代处理器支持多种页面大小,例如4 K字节的默认大小和2 M字节的大页面。

在Linux上,可以以多种方式配置大页面(称为巨大页面)。有关详细信息,请参阅Documentation/vm/hugetlbpage.txt。

这些通常始于创建巨大页面:

一个应用程序使用巨大页面的方法是通过共享内存段,并在shmget()中使用SHM_HUGETLBS标志。

另一种方法涉及为应用程序创建基于巨大页面的文件系统,以便进行内存映射:

其他方法包括在mmap()中使用MAP_ANONYMOUS|MAP_HUGETLB标志,并使用libhugetlbfs API[4]。

最近,对透明巨大页面(THP)的支持已经得到开发。这在适当时使用巨大页面,无需系统管理员手动操作[5]。有关详细信息,请参阅Documentation/vm/transhuge.txt。

在基于Solaris的系统上,可以通过配置应用程序环境以使用libmpss.so.1库来配置大页面。例如:

这些可以被放置在应用程序的启动脚本中。大页面是由内核动态创建的,只有当有足够的页面可用来创建它们时才会成功(否则将使用默认的较小页面)。

使用Oracle Solaris Studio编译的程序可能会自动使用大页面,因此不需要手动预加载mpss。

7.6.3 Allocators

不同的用户级分配器可能可用,为多线程应用程序提供改进的性能。这些可以在编译时选择,也可以通过设置LD_PRELOAD环境变量在执行时选择。

例如,在Solaris上,可以使用libumem分配器进行选择

![]()

这可以放置在其启动脚本中。

7.6.4 Resource Controls

基本的资源控制,包括设置主内存限制和虚拟内存限制,可以使用ulimit(1)来实现。

对于Linux,容器组(cgroups)内存子系统提供各种额外的控制。其中包括

- memory.memsw.limit_in_bytes:允许的最大内存和交换空间,以字节为单位

- memory.limit_in_bytes:允许的最大用户内存,包括文件缓存使用量,以字节为单位

- memory.swappiness:类似于前面描述的vm.swappiness,但可以为cgroup设置

- memory.oom_control:可以设置为0,以允许为此cgroup启用OOM killer,或设置为1以禁用它

在基于Solaris的系统上,可以使用资源控制和prctl(1)命令应用每个区域或每个项目的内存限制。这些可以通过页面出内存来强制执行它们的限制,而不是失败的分配,这可能更适用于目标应用程序,具体内容请参见第11章云计算中的第11.2节OS虚拟化。

8 File Systems

在研究应用程序I/O性能时,文件系统的性能比磁盘性能更重要。文件系统使用缓存、缓冲和异步I/O来避免将应用程序暴露于磁盘级(或远程系统)的延迟中。然而,性能分析和可用的工具集通常过去主要关注磁盘的性能。

在动态跟踪的时代,文件系统分析现在变得简单和实用。本章展示了如何详细检查文件系统请求,包括使用动态跟踪从应用程序上下文中测量启动到完成时间。这通常可以快速排除文件系统及其底层磁盘设备作为性能不佳的源头,从而使调查可以转向其他领域。

本章由五部分组成,前三部分提供文件系统分析的基础,后两部分展示其在基于Linux和Solaris的系统中的实际应用。各部分内容如下:

- 背景介绍了与文件系统相关的术语、基本模型,说明文件系统原则和关键文件系统性能概念。

- 架构介绍了通用和特定的文件系统架构。

- 方法论描述了性能分析方法论,包括观察性和实验性方法。

- 分析展示了针对基于Linux和Solaris系统的文件系统性能工具,包括静态和动态跟踪。

- 调优描述了文件系统可调参数。

8.1 Terminology

在本章中使用的与文件系统相关的术语包括以下内容:

- 文件系统:将数据组织为文件和目录的一种方式,提供基于文件的接口来访问它们,并使用文件权限来控制访问。额外的内容可能包括用于设备、套接字和管道的特殊文件类型,以及包含文件访问时间戳等元数据。

- 文件系统缓存:主存储器(通常是DRAM)中用于缓存文件系统内容的区域,可能包括不同的缓存用于各种数据和元数据类型。

- 操作:文件系统操作是对文件系统的请求,包括read()、write()、open()、close()、stat()、mkdir()和其他操作。

- I/O:输入/输出。文件系统I/O可以用多种方式定义;这里仅表示直接读取和写入(执行I/O)的操作,包括read()、write()、stat()(读取统计信息)和mkdir()(写入新目录条目)。I/O不包括open()和close()。

- 逻辑I/O:应用程序向文件系统发出的I/O。

- 物理I/O:由文件系统直接(或通过原始I/O)发出到磁盘的I/O。

- 吞吐量:应用程序与文件系统之间的当前数据传输速率,以每秒字节数为单位衡量。

- inode:索引节点(inode)是一个包含文件系统对象元数据的数据结构,包括权限、时间戳和数据指针。

- VFS:虚拟文件系统,是一个内核接口,用于抽象和支持不同的文件系统类型。在Solaris中,VFS inode被称为vnode。

- 卷管理器:用灵活的方式管理物理存储设备的软件,从中创建虚拟卷供操作系统使用。

本章还介绍了其他术语。术语表包括用于参考的基本术语,包括fsck、IOPS、操作速率和POSIX。另请参阅第2章和第3章的术语部分。

8.2 Models

以下简单模型说明了文件系统及其性能的一些基本原理。

8.2.1 File System Interfaces

图8.1展示了一个文件系统的基本模型,涉及到其接口。

在图中还标记了逻辑和物理操作发生的位置。有关这些内容的更多信息,请参阅第8.3.12节《逻辑I/O与物理I/O》。研究文件系统性能的一种方法是将其视为黑匣子,重点放在对象操作的延迟上。这在第8.5.2节《延迟分析》中有更详细的解释。

8.2.2 File System Cache

图8.2中展示了存储在主内存中的通用文件系统缓存,用于执行读取操作。读取操作可以从缓存中返回(缓存命中)或从磁盘中返回(缓存未命中)。缓存未命中的数据会被存储到缓存中,填充缓存(使其变热)。

文件系统缓存还可以缓冲待写入(刷新)的数据。对于不同的文件系统类型,执行这一操作的机制各不相同,具体描述请参见第8.4节《架构》。

8.2.3 Second-Level Cache

二级缓存可以是任何内存类型;图8.3将其展示为闪存。这种缓存类型最初是为ZFS开发的。

8.3 Concepts

以下是关于文件系统性能的一些重要概念。

8.3.1 File System Latency

文件系统延迟是文件系统性能的主要度量标准,指的是从逻辑文件系统请求到完成所需的时间。它包括在文件系统、内核磁盘I/O子系统以及等待磁盘设备上花费的时间 — 即物理I/O。应用程序线程在应用程序请求期间通常会阻塞,等待文件系统请求完成,文件系统延迟直接且成比例地影响应用程序性能。

应用程序可能不直接受到影响的情况包括使用非阻塞I/O,或者当I/O是从异步线程(例如后台刷新线程)发出时。如果应用程序提供了其文件系统使用的详细指标,那么可以通过这些指标来识别这些情况。如果没有,一个通用的方法是使用可以显示导致逻辑文件系统I/O的用户级堆栈跟踪的内核跟踪工具。然后可以研究此堆栈跟踪,以查看是哪些应用程序例程发出了它。

操作系统在历史上并未使文件系统延迟易于观察,而是提供磁盘设备级别的指标。但有许多情况下,这些指标不会直接影响应用程序,使它们很难解释,甚至毫无意义。例如,文件系统执行写入数据的后台刷新,这可能会表现为高延迟磁盘I/O的突发。从磁盘设备级别的指标来看,这看起来令人担忧;然而,没有任何应用程序在等待这些操作完成。有关更多情况,请参阅第8.3.12节《逻辑I/O与物理I/O》。

8.3.2 Caching

启动后,文件系统通常会使用主内存(RAM)作为缓存以提高性能。对于应用程序来说,这个过程是透明的:它们的逻辑I/O延迟变得更低,因为可以从主内存中提供而不是从速度慢得多的磁盘设备中提供。

随着时间的推移,缓存会增长,而操作系统的空闲内存会减少。这可能会让新用户感到困扰,但这是完全正常的。原则是:如果有多余的主内存,就记住一些有用的东西。当应用程序需要更多内存时,内核应该迅速从文件系统缓存中释放空间供其使用。

文件系统使用缓存来提高读取性能,并使用缓冲区(在缓存中)来提高写入性能。文件系统和块设备子系统通常会使用多种类型的缓存,其中可能包括表8.1中的缓存。具体的缓存类型在第8.4节“架构”中进行了描述,第3章“操作系统”列出了缓存的完整列表(包括应用程序级和设备级)。

8.3.3 Random versus Sequential I/O

一系列逻辑文件系统I/O操作可以根据每个I/O的文件偏移量描述为随机或顺序。顺序I/O中,下一个I/O从上一个I/O的末尾开始。随机I/O之间没有明显的关系,偏移量会随机变化。随机文件系统工作负载也可能指随机访问许多不同的文件。图8.4说明了这些访问模式,展示了有序的I/O系列和示例文件偏移量。

由于某些存储设备的性能特征(在第9章“磁盘”中描述),文件系统在历史上一直试图通过将文件数据连续和顺序地放置在磁盘上来减少随机I/O。碎片化一词描述了当文件系统执行不佳时,导致文件分布在驱动器上变得散乱,使得顺序逻辑I/O导致随机物理I/O。

文件系统可以测量逻辑I/O访问模式,以便它们可以识别顺序工作负载,然后使用预取或预读取来提高性能。接下来的部分将涵盖这些主题。

8.3.4 Prefetch

常见的文件系统工作负载涉及顺序读取大量文件数据,例如进行文件系统备份。这些数据可能太大而无法放入缓存,或者可能只读取一次,并且不太可能被保留在缓存中(取决于缓存淘汰策略)。这样的工作负载表现相对较差,因为它的缓存命中率较低。

预取是解决这个问题的常见文件系统特性。它可以基于当前和先前的文件I/O偏移量检测顺序读取工作负载,然后在应用程序请求数据之前预测并发出磁盘读取指令。这会填充文件系统缓存,因此如果应用程序确实执行了期望的读取操作,就会导致缓存命中(所需数据已经存在于缓存中)。

以下是一个示例场景,假设一开始没有数据被缓存:

1. 应用程序发出文件read()请求,将执行权交给内核。

2. 文件系统向磁盘发出读取指令。

3. 将先前的文件偏移量指针与当前位置进行比较,如果它们是顺序的,文件系统就会发出额外的读取指令。

4. 第一次读取完成,内核将数据和执行权交还给应用程序。

5. 任何额外的读取完成后,填充了缓存,以供未来应用程序读取使用。

这个场景也在图8.5中有所说明,应用程序首先读取偏移量1,然后触发对接下来的三个偏移量的预取。

当预取检测工作良好时,应用程序表现出显著提高的顺序读取性能;磁盘能够在应用程序请求之前提前读取数据。当预取检测效果不佳时,会发出不必要的I/O请求,这些请求是应用程序不需要的,会污染缓存并消耗磁盘和I/O传输资源。文件系统通常允许根据需要调整预取设置。

8.3.5 Read-Ahead

在历史上,预取功能也被称为read-ahead。更近期,Linux采用了read-ahead这个术语作为系统调用readahead(2),该系统调用允许应用程序明确地预热文件系统缓存。

8.3.6 Write-Back Caching

写回缓存通常被文件系统用来提高写入性能。它的工作方式是将写入视为在传输到主内存后完成,并稍后异步地将其写入磁盘。文件系统处理将这些“脏”数据写入磁盘的过程称为刷新。一个示例序列如下:

1. 应用程序发出文件write()请求,将执行权交给内核。

2. 来自应用程序地址空间的数据被复制到内核中。

3. 内核将write()系统调用视为已完成,并将执行权返回给应用程序。

4. 稍后,异步的内核任务找到已写入的数据并发出磁盘写入操作。

这种折衷是可靠性。基于DRAM的主内存是易失性的,在断电事件发生时,即使应用程序认为写入已完成,脏数据也可能会丢失。它也可能未完全写入磁盘,留下一个磁盘上状态损坏的情况。

如果文件系统元数据损坏,文件系统可能无法加载。这种状态可能只能从系统备份中恢复,导致长时间的停机时间。更糟糕的是,如果损坏影响应用程序读取和使用的文件内容,业务可能会受到威胁。

为了平衡速度和可靠性的需求,文件系统可以默认提供写回缓存,并提供同步写选项以绕过此行为直接写入持久存储设备。

8.3.7 Synchronous Writes

同步写入只有在完全写入持久存储(例如磁盘设备)时才算完成,这包括写入任何必要的文件系统元数据更改。与异步写入(写回缓存)相比,同步写入要慢得多,因为同步写入会产生磁盘设备I/O延迟。一些应用程序,如数据库日志编写器,使用同步写入,因为异步写入可能导致数据损坏风险不可接受。

同步写入有两种形式:单个I/O是同步写入,以及先前写入的组合是同步提交。

单个同步写入

当使用标志O_SYNC或其变体之一O_DSYNC和O_RSYNC(截至Linux 2.6.31时由glib映射为O_SYNC)打开文件时,写入I/O是同步的。一些文件系统具有挂载选项,强制所有文件的写入I/O都是同步的。

同步提交先前的写入

应用程序可以在代码中的检查点处同步提交先前的异步写入,而不是同步写入单个I/O,使用fsync()系统调用。这可以通过分组同步写入来提高性能。

还有其他情况会提交先前的写入,例如关闭文件句柄,或者文件上存在太多未提交的缓冲区时。前一种情况在解压包含许多文件的归档文件时经常会注意到,特别是在NFS上。

8.3.8 Raw and Direct I/O

这些是应用程序可能使用的其他类型的I/O:

原始I/O直接发出到磁盘偏移量,完全绕过文件系统。一些应用程序,特别是数据库,可以比文件系统缓存更好地管理和缓存它们自己的数据而使用原始I/O。一个缺点是管理上的困难:常规文件系统工具集无法用于备份/恢复或可观性。

直接I/O允许应用程序使用文件系统但绕过文件系统缓存。这类似于同步写入(但不提供O_SYNC提供的保证),它也适用于读取。它不像原始设备I/O那样直接,因为文件偏移量到磁盘偏移量的映射仍然必须由文件系统代码执行,I/O也可能被调整大小以匹配文件系统用于磁盘布局的大小(其记录大小)。根据文件系统的不同,这不仅会禁用读取缓存和写入缓冲,还可能禁用预取。

直接I/O可用于执行文件系统备份的应用程序,以避免将只读取一次的数据污染文件系统缓存。原始I/O和直接I/O均可用于避免双重缓存,适用于在进程堆中使用自己的应用程序级缓存的应用程序。

8.3.9 Non-Blocking I/O

通常,文件系统I/O要么立即完成(例如,来自缓存),要么在等待一段时间后完成(例如,等待磁盘设备I/O)。如果需要等待,应用程序线程将被阻塞并释放CPU,允许其他线程在等待期间执行。虽然被阻塞的线程无法执行其他工作,但这通常不是问题,因为多线程应用程序可以创建额外的线程来执行,而有些线程被阻塞。

在某些情况下,非阻塞I/O是可取的,例如当需要避免线程创建的性能或资源开销时。可以通过在open()系统调用中使用O_NONBLOCK或O_NDELAY标志来执行非阻塞I/O,这会导致读取和写入返回EAGAIN错误而不是阻塞,告诉应用程序稍后再试。 (对此的支持取决于文件系统,该文件系统可能只针对咨询或强制文件锁而支持非阻塞。)非阻塞I/O也在第5章“应用程序”中进行了讨论。

8.3.10 Memory-Mapped Files

对于某些应用程序和工作负载,可以通过将文件映射到进程地址空间并直接访问内存偏移量来改善文件系统I/O性能。这样可以避免在调用read()和write()系统调用以访问文件数据时产生的系统调用执行和上下文切换开销。如果内核支持直接将文件数据缓冲区复制到进程地址空间,还可以避免数据的双重复制。

内存映射是使用mmap()系统调用创建的,并使用munmap()删除。可以使用madvise()对映射进行调优,如第8.8节“调优”中总结的那样。一些应用程序在其配置中提供了使用mmap系统调用的选项(可能称为“mmap模式”)。例如,Riak数据库可以使用mmap来进行内存数据存储。

我注意到人们倾向于在分析问题之前尝试使用mmap()来解决文件系统性能问题。如果问题是来自磁盘设备的高I/O延迟,那么通过mmap()避免小的系统调用开销可能意义不大,因为高磁盘I/O延迟仍然存在并且占主导地位。

在多处理器系统上使用映射的一个缺点是保持每个CPU的MMU同步的开销,特别是用于移除映射的CPU交叉调用(TLB shootdowns)。根据内核和映射的不同,这些开销可以通过延迟TLB更新(延迟shootdowns)[Vahalia 96]来最小化。

8.3.11 Metadata

数据描述文件和目录的内容,而元数据描述与它们有关的信息。元数据可能指的是可以从文件系统接口(POSIX)读取的信息,或者实现磁盘上文件系统布局所需的信息。这分别称为逻辑元数据和物理元数据。

逻辑元数据

逻辑元数据是由消费者(应用程序)读取和写入文件系统的信息,可以通过以下方式进行:

- 明确地:读取文件统计信息(stat()),创建和删除文件(creat(),unlink())和目录(mkdir(),rmdir())

- 隐式地:文件系统访问时间戳更新,目录修改时间戳更新

一个“元数据密集型”的工作负载通常指的是逻辑元数据,例如,Web服务器使用stat()函数检查文件是否自缓存以来未更改的频率远高于实际读取文件数据内容。

物理元数据

物理元数据是指在磁盘上记录所有文件系统信息所必需的元数据。所使用的元数据类型取决于文件系统类型,可能包括超级块、inode、数据指针块(主要的、次要的等),以及空闲列表。

逻辑和物理元数据是逻辑I/O和物理I/O之间差异的原因之一。

8.3.12 Logical versus Physical I/O

尽管这可能看起来违反直觉,应用程序向文件系统请求的I/O(逻辑I/O)可能与磁盘I/O(物理I/O)不匹配,原因有几个。文件系统做的远不止提供持久存储(磁盘)作为基于文件的接口。它们会缓存读取、缓冲写入,并创建额外的I/O 来维护需要记录一切位置的磁盘上物理布局元数据。这可能导致与应用程序I/O 不相关、间接、膨胀或紧缩的磁盘I/O。以下是一些示例。

不相关

这是与应用程序无关的磁盘I/O,可能是由于以下因素:

- 其他应用程序:磁盘I/O 来自另一个应用程序。

- 其他租户:磁盘I/O 来自另一个租户(在某些虚拟化技术下可通过系统工具看到)。

- 其他内核任务:例如,当内核正在重建软件RAID卷或执行异步文件系统校验和验证(请参见8.4节,体系结构)。

间接

这是应用程序I/O 没有直接对应的磁盘I/O,可能是由于以下因素:

- 文件系统预取:添加可能或可能不被应用程序使用的额外I/O。

- 文件系统缓冲:使用写回缓存延迟和合并写入以后刷新到磁盘。一些系统可能在写入前缓冲数十秒,然后以大且不经常的突发形式出现。

紧缩

这是磁盘I/O 小于应用程序I/O,甚至不存在的情况,可能是由于以下因素:

- 文件系统缓存:从主存储器中满足读取而不是磁盘。

- 文件系统写取消:相同的字节偏移在刷新到磁盘之前多次修改。

- 压缩:将逻辑I/O 数据量减少至物理I/O。

- 合并:在发送给磁盘之前合并顺序I/O。

- 内存中文件系统:内容可能永远不会写入磁盘(例如tmpfs)。

膨胀

在这种情况下,磁盘I/O 大于应用程序I/O,可能是由于以下因素:

- 文件系统元数据:添加额外的I/O。

- 文件系统记录大小:调整I/O 大小(增加字节),或分片I/O(增加计数)。

- 卷管理器奇偶校验:读-修改-写循环,添加额外的I/O。

示例

为了展示这些因素如何同时发生,以下列举的示例描述了应用程序进行1字节写入时可能发生的情况:

1. 应用程序对现有文件执行1字节写入。

2. 文件系统将该位置识别为128KB文件系统记录的一部分(未缓存,但其元数据已被引用)。

3. 文件系统请求从磁盘加载记录。

4. 磁盘设备层将128KB读取分成适合设备的较小读取。

5. 磁盘执行多个较小读取,总计128KB。

6. 文件系统现在将记录中的1字节替换为新字节。

7. 一段时间后,文件系统请求将128KB脏记录写回磁盘。

8. 磁盘写入128KB记录(如有必要,进行分解)。

9. 文件系统写入新的元数据,例如引用(用于写时复制)或访问时间。

10. 磁盘执行更多写入。

因此,虽然应用程序只执行了单个1字节写入,但磁盘执行了多次读取(总计128KB)和更多写入(超过128KB)。

8.3.13 Operations Are Not Equal

正如前面的部分所述,文件系统操作的性能可能会根据它们的类型而有所不同。仅仅从速率来看,你无法判断“每秒500次操作”的工作负载情况。一些操作可能会从文件系统缓存以主存储器速度返回,而另一些可能会从磁盘返回,速度慢得多。其他确定性因素包括操作是随机的还是顺序的,是读取还是写入,是同步写入还是异步写入,它们的I/O大小,是否包含其他操作类型,以及它们的CPU执行成本。

常见做法是对不同的文件系统操作进行微基准测试,以确定这些性能特征。例如,表8.2中的结果来自一个在Intel Xeon 2.4 GHz多核处理器上的ZFS文件系统。

这些测试没有涉及存储设备,而是测试文件系统软件和CPU速度。一些特殊的文件系统从不访问存储设备。

8.3.14 Special File Systems

文件系统的目的通常是持久存储数据,但也有用于其他目的的特殊文件系统类型,包括临时文件(/tmp)、内核设备路径(/dev)和系统统计信息(/proc)。

8.3.15 Access Timestamps

许多文件系统支持访问时间戳,记录每个文件和目录的访问(读取)时间。这会导致在读取文件时更新文件元数据,从而产生写入工作负载,消耗磁盘I/O资源。第8.8节“调整”展示了如何关闭这些更新。一些文件系统通过延迟和分组访问时间戳写入来优化,以减少对活动工作负载的干扰。

8.3.16 Capacity

当文件系统填满时,性能可能会因为几个原因而下降。在写入新数据时,可能需要更多时间来定位磁盘上的空闲块以进行计算,并执行任何磁盘I/O操作。磁盘上的空闲空间很可能更小,分布更稀疏,这会导致由于更小的I/O或随机I/O而降低性能。这个问题有多严重取决于文件系统类型、其在磁盘上的布局和存储设备。接下来的部分将介绍各种文件系统类型。

8.4 Architecture

本节介绍通用和特定的文件系统架构,从I/O堆栈、VFS、文件系统缓存和特性、常见文件系统类型、卷和池开始。在确定要分析和优化哪些文件系统组件时,这样的背景知识非常有用。要了解更深入的内部结构和其他文件系统主题,请参考源代码(如果可用)和外部文档。本章末尾列出了一些相关资源。

8.4.1 File System I/O Stack

图8.6展示了文件系统I/O堆栈的一般模型。具体的组件和层取决于操作系统类型、版本和使用的文件系统。完整的图表请参见第3章“操作系统”。这显示了I/O通过内核的路径。从系统调用直接到磁盘设备子系统的路径称为原始I/O。通过VFS和文件系统的路径是文件系统I/O,包括跳过文件系统缓存的直接I/O。

8.4.2 VFS

VFS(虚拟文件系统接口)为不同的文件系统类型提供了一个通用接口。其位置显示在图8.7中。

一些操作系统(包括最初的SunOS实现)将VFS视为两个接口:VFS和vnode,如在早期文件系统模型中逻辑上划分的那样[McDougall 06a]。VFS包括文件系统范围的操作,如挂载和卸载。vnode接口包括VFS索引节点(vnode)文件操作,例如打开、关闭、读取和写入。

Linux VFS接口使用的术语可能有点令人困惑,因为它重用术语inode和superblock来引用VFS对象,这些术语源自Unix文件系统的磁盘数据结构。Linux中用于描述这些对象的术语磁盘数据结构通常以它们的文件系统类型作为前缀,例如,ext4_inode 和 ext4_super_block。这些 VFS 索引节点和 VFS 超级块仅存在于内存中。

VFS 接口还可以作为衡量任何文件系统性能的共同位置。通过使用操作系统提供的统计信息或静态或动态跟踪,可能可以实现这一点。

8.4.3 File System Caches

Unix最初只有缓冲高速缓存来提高块设备访问性能。如今,Linux和Solaris拥有多种不同类型的高速缓存。

本节从基于Solaris系统开始,讨论其中一些高速缓存的起源。

Solaris

图8.8显示了基于Solaris系统的文件系统缓存概况,显示了UFS和ZFS的缓存。

这些高速缓存中有三个是操作系统通用的:旧缓冲高速缓存、页面高速缓存和目录名称缓存(DNLC)。其余的是特定于文件系统的,稍后会进行解释。

旧缓冲高速缓存

最初的Unix在块设备接口处使用缓冲高速缓存来缓存磁盘块。这是一个单独的、固定大小的高速缓存,并且随着页面高速缓存的添加,在平衡它们之间的不同工作负载以及双重缓存和同步开销方面存在调优问题。通过使用页面高速缓存来存储缓冲高速缓存,即SunOS引入的一种称为统一缓冲高速缓存的方法,这些问题在很大程度上得到了解决,如图8.9所示。

在Solaris中,原始的(“旧的”)缓冲高速缓存仍然存在,仅用于UFS索引节点和文件元数据,这些数据是通过它们的块位置而不是文件进行寻址。其大小是动态的,访问计数可以从kstat中观察到。

索引节点高速缓存也是动态增长的,至少保存所有已打开文件(已引用)的索引节点,以及由DNLC映射的那些索引节点。还会在一个空闲队列上保留一些额外的索引节点。

页面缓存

页面缓存是在1985年SunOS 4进行虚拟内存重写期间引入的,并在SVR4中添加[Vahalia 96]。它缓存虚拟内存页面,包括映射的文件系统页面。对于文件访问,它比需要为每次查找从文件偏移量转换为磁盘偏移量的缓冲高速缓存更有效。

多个文件系统类型使用页面缓存,包括最初的消费者UFS和NFS(但不包括ZFS)。页面缓存的大小是动态的,它会增长以利用可用内存,在应用程序需要时再次释放内存。

脏页内存,正在用于文件系统的页面,由一个称为文件系统刷新守护程序(fsflush)的内核线程写入磁盘,该守护程序定期扫描整个页面缓存。如果存在系统内存不足,另一个内核线程——分页守护程序(pageout,也称为页面扫描器)可能会找到并调度脏页写入磁盘,以便释放内存页面供重新使用(请参阅第7章,内存)。为了可观察性,pageout和fsflush显示为PID 2和3,即使它们是内核线程而不是进程。

页面缓存有两个主要的内核驱动程序:segvn,用于将文件映射到进程地址空间,以及segmap,用于缓存文件系统的读取和写入。有关这些内容以及页面扫描器的更多详细信息,请参见第7章,内存。

DNLC

目录名称查找缓存(DNLC)记住目录条目到vnode的映射,由Kevin Robert Elz在上世纪80年代初开发。它提高了路径名查找(例如,通过open())的性能,因为当遍历路径名时,每个名称查找都可以检查DNLC以获取直接vnode映射,而不必逐个遍历目录内容。DNLC被设计用于性能和可伸缩性,条目存储在一个哈希表中,由父vnode和目录条目名称进行哈希。

多年来,Solaris的DNLC已经添加了各种功能和性能特性。DNLC最初使用指针作为哈希链的一部分,以及LRU列表的附加指针。Solaris 2.4放弃了LRU指针,从而避免了LRU列表锁竞争。然后通过从哈希链的末端释放来实现LRU行为。Solaris 8增加了两个新特性:负缓存,用于记住不存在条目的查找,以及目录缓存,用于有意地缓存整个目录。负缓存有助于提高失败查找的性能,通常用于库路径查找。目录缓存通过避免扫描目录以查看新文件名是否已被使用,提高了文件创建时的性能。

DNLC的大小可以通过可调参数进行调整,当前大小以及命中和未命中计数可以从kstat中观察到。

Linux

图8.10概述了Linux上的文件系统缓存,展示了标准文件系统类型可用的通用缓存。

缓冲缓存

Linux最初使用类似Unix的缓冲缓存。自Linux 2.4以来,缓冲缓存已存储在页面缓存中(因此在图8.10中有虚线边框),遵循SunOS统一缓冲区方法,避免了双重缓存和同步开销。缓冲缓存功能仍然存在,改善了块设备I/O的性能。

缓冲缓存的大小是动态的,并且可以从/proc中观察到。

页面缓存

页面缓存缓存虚拟内存页面,包括文件系统页面,提高了文件和目录I/O的性能。页面缓存的大小是动态的,当应用程序需要时,它会增长以利用可用内存,并在应用程序需要时再次释放它(以及通过swappiness控制的页面调度;参见第7章,内存)。

已修改并供文件系统使用的内存页会被内核线程刷新到磁盘上。在Linux 2.6.32之前,有一个页面脏数据刷新(pdflush)线程池,根据需要在两个到八个之间。这些线程现已被刷新线程(命名为flush)取代,每个设备创建一个以更好地平衡每个设备的工作负载并提高吞吐量。页面被刷新到磁盘的原因包括:

- 经过一段时间间隔(30秒)

- sync()、fsync()或msync()系统调用

- 脏页过多(dirty_ratio)

- 页面缓存中没有可用页

如果系统内存不足,另一个内核线程——页面换出守护进程(kswapd,也称为页面扫描器)也可能找到并调度脏页写入磁盘,以便释放内存页供重用(参见第7章,内存)。就可观察性而言,从操作系统性能工具中可以看到kswapd和flush线程作为内核任务。

有关页面扫描器的更多详细信息,请参阅第7章,内存。

目录项缓存

目录项缓存(Dcache)记住从目录项(struct dentry)到VFS索引节点的映射,类似于早期的Unix DNLC。这提高了路径名查找的性能(例如,通过open()),因为在遍历路径名时,每个名称查找都可以检查Dcache以获取直接的索引节点映射,而不是逐个遍历目录内容。Dcache条目存储在哈希表中,以进行快速和可扩展的查找(由父级目录项和目录项名进行哈希处理)。

多年来,性能已经得到进一步改善,包括使用读-拷贝-更新-行走(RCU-walk)算法[1]。这试图在不更新目录项引用计数的情况下遍历路径名,因为在多CPU系统上高速率导致缓存一致性问题,这些问题会影响可伸缩性。如果在缓存中遇到不在缓存中的目录项,RCU-walk将恢复到较慢的引用计数遍历(ref-walk),因为在文件系统查找和阻塞过程中需要引用计数。对于繁忙的工作负载,预计目录项很可能被缓存,因此RCU-walk方法将成功。

Dcache还执行负面缓存,记住不存在条目的查找。这提高了失败查找的性能,这种情况通常发生在库路径查找中。

Dcache会动态增长,在系统需要更多内存时通过LRU缩小。其大小可以通过/proc查看。

索引节点缓存

此缓存包含VFS索引节点(struct inode),每个描述文件系统对象的属性,其中许多属性通过stat()系统调用返回。这些属性经常用于文件系统工作负载,例如在打开文件时检查权限,或在修改时更新时间戳。这些VFS索引节点存储在哈希表中,以进行快速和可扩展的查找(通过索引号和文件系统超级块进行哈希处理),尽管大多数查找将通过目录项缓存进行。

索引节点缓存会动态增长,至少保存目录项映射的所有索引节点。当系统内存压力较大时,索引节点缓存将缩小,删除没有相关目录项的索引节点。其大小可以通过/proc查看。

8.4.4 File System Features

除了缓存之外,影响性能的其他关键文件系统特性如下所述。

块与区段

基于块的文件系统将数据存储在固定大小的块中,这些块由存储在元数据块中的指针引用。对于大文件,这可能需要许多块指针和元数据块,并且块的放置可能会变得分散,导致随机I/O。一些基于块的文件系统尝试将块连续放置以避免这种情况。另一种方法是使用可变大小的块,使得文件增大时可以使用更大的块大小,这也减少了元数据开销。

基于区段的文件系统为文件预先分配连续空间(区段),根据需要进行扩展。虽然需要付出空间开销,但这提高了流式传输性能,并且可以改善随机I/O性能,因为文件数据是局部化的。

日志记录

文件系统日志(或日志)记录文件系统的更改,以便在系统崩溃时可以原子地重放这些更改——要么完全成功,要么失败。这使得文件系统可以快速恢复到一致状态。非日志记录的文件系统在系统崩溃时可能会损坏,如果与更改相关的数据和元数据写入不完整。要从这样的崩溃中恢复需要遍历所有文件系统结构,对于大型(几TB)文件系统可能需要数小时。

日志是同步写入磁盘的,并且对于一些文件系统,可以配置为使用单独的设备。一些日志记录同时记录数据和元数据,这会消耗存储I/O资源,因为所有I/O都会被写入两次。其他的只写入元数据,并通过采用写时复制来保持数据完整性。

有一种只包含一个日志的文件系统类型:日志结构化文件系统,其中所有数据和元数据更新都写入连续循环日志。这优化了写入性能,因为写入始终是顺序的,并且可以合并以使用更大的I/O大小。

写时复制

写时复制(COW)文件系统不会覆盖现有块,而是按照以下步骤进行:

1. 将块写入新位置(新副本)。

2. 更新到新块的引用。

3. 将旧块添加到空闲列表中。

这有助于在系统失败时保持文件系统的完整性,并通过将随机写入转换为顺序写入来提高性能。

巡检

这是一个文件系统特性,异步读取所有数据块并验证校验和,以尽早检测到故障驱动器,理想情况下在仍然可以通过RAID恢复的时候。然而,巡检读I/O可能会对性能产生负面影响,因此应该以低优先级发出。

8.4.5 File System Types

这一章的大部分内容描述了可以应用于所有文件系统类型的通用特性。以下部分总结了常用文件系统的特定性能特征。它们的分析和调优将在后续部分中进行。

FFS

许多文件系统都基于FFS,这是为了解决原始Unix文件系统存在的问题而设计的。一些背景信息可以帮助解释当前文件系统的状态。

原始Unix文件系统的磁盘布局包括inode表、512字节的存储块以及用于分配资源时使用的超级块。inode表和存储块将磁盘分区划分为两个范围,这在两者之间进行寻址时会导致性能问题。另一个问题是使用了固定的小块大小512字节,这限制了吞吐量,并增加了存储大文件所需的元数据(指针)量。一项试验将此块大小翻倍至1,024字节,然后遇到的瓶颈被描述如下:

尽管吞吐量翻了一番,但旧文件系统仍然只使用了大约四分之一的磁盘带宽。主要问题在于,尽管空闲列表最初按最佳方式排序以进行访问,但随着文件的创建和删除,它很快就变得混乱起来。最终,空闲列表变得完全随机,导致文件在磁盘上随机分配其块。这迫使在每次块访问之前进行寻道。尽管旧文件系统在最初创建时提供了高达175千字节/秒的传输速率,但由于数据块放置的随机化,经过几周适度使用后,该速率降至30千字节/秒。

这段摘录描述了空闲列表碎片化,随着文件系统的使用,这会随着时间的推移而降低性能。

伯克利快速文件系统(FFS)通过将分区分成多个柱面组来改善性能,如图8.11所示,每个柱面组都有自己的inode数组和数据块。文件inode和数据尽可能保持在同一个柱面组内,如图8.12所示,从而减少了磁盘寻址。相关的其他数据也被放置在附近,包括目录及其条目的inode。inode的设计类似(这里没有显示三重间接块)。

块大小增加到最小的4 K字节,提高了吞吐量。这减少了存储文件所需的数据块数量,因此间接块需要引用这些数据块的数量也减少了。由于间接指针块也更大,所以需要的间接指针块数量进一步减少了。为了在处理小文件时提高空间效率,每个块可以分成1 K字节的片段。

FFS的另一个性能特征是块交错:将磁盘上的顺序文件块之间放置一个或多个块的间隔[Doeppner 10]。这些额外的块给了内核和处理器时间来发出下一个顺序文件读取,因为它们在那时与控制磁盘更直接相关。如果没有交错,下一个块可能会在准备发出读取之前经过磁头,导致等待几乎完整旋转的延迟。

UFS

1984年,FFS作为UFS([McDougall 06a]中的SunOS 1.0)引入。在接下来的二十年中,向SunOS UFS添加了各种功能:I/O聚类、文件系统增长、多TB支持、日志记录、直接I/O、快照、访问控制列表(ACL)、扩展属性。Linux目前支持读取UFS,但不支持写入,而是支持另一个类似UFS的文件系统(ext3)。

UFS的关键性能特征包括以下内容:

- I/O聚类:通过延迟写入,将数据块分组在磁盘上,直到填满一个聚类,从而使它们被顺序放置。当检测到顺序读工作负载时,UFS执行预取(称为读取前瞻),通过读取这些聚类来执行。

- 日志记录(日志化):仅针对元数据。这提高了系统崩溃后的启动性能,因为日志重放可以避免运行fsck(文件系统检查)的需要。它还可以通过合并元数据写入来改善某些写入工作负载的性能。

- 直接I/O:绕过页面缓存,避免为数据库等应用程序进行双重缓存。

可配置功能在mkfs_ufs(1M)手册页中有文档。有关UFS及其内部的更多信息,请参阅Solaris Internals第2版,第15章[McDougall 06a]。

ext3

Linux扩展文件系统(ext)于1992年开发,是Linux及其VFS的第一个文件系统,基于原始Unix文件系统。第二个版本,1993年的ext2,包括来自FFS的多个时间戳和柱组。1999年的第三个版本,ext3,包括文件系统增长和日志记录。

关键性能特征,包括自发布以来添加的功能,包括:

- 日志记录:有序模式或日志模式,仅针对元数据或元数据和数据。日志记录提高了系统在崩溃后的启动性能,避免运行fsck的需要。它还可以通过合并元数据写入来改善某些写入工作负载的性能。

- 日志设备:可以使用外部日志设备,以便日志工作负载不与读取工作负载竞争。

- Orlov块分配器:将顶级目录分布在柱组中,使子目录和内容更有可能共同定位,减少随机I/O。

- 目录索引:为文件系统添加了散列B树,用于加快目录查找速度。

可配置功能在MKE2FS(8)手册页中有文档。

ext4

Linux ext4文件系统于2008年发布,通过添加各种功能和性能改进扩展了ext3:范围、大容量、使用fallocate()进行预分配、延迟分配、日志校验、更快的fsck、多块分配器、纳秒级时间戳和快照。

关键性能特征,包括自发布以来添加的功能,包括:

- 范围:范围改善连续放置,减少随机I/O并增加顺序I/O的I/O大小。

- 预分配:通过fallocate()系统调用,允许应用程序预先分配空间,这些空间可能是连续的,从而提高后续写入性能。

- 延迟分配:块分配被延迟至刷新到磁盘,允许写入组(通过多块分配器)以减少碎片化。

- 更快的fsck:未分配的块和inode条目被标记,减少fsck时间。

可配置功能在MKE2FS(8)手册页中有文档。某些功能,例如范围,可以应用于ext3文件系统。

ZFS

ZFS是由Sun Microsystems开发并于2005年发布的,它将文件系统与卷管理器相结合,并包括许多企业级特性:池化存储、日志记录、写时复制、自适应替换缓存(ARC)、大容量、可变大小块、动态条带化、多预读流、快照、克隆、压缩、数据校验和128位校验和。随着更新,还添加了其他功能,包括(其中一些将在下文中进一步解释)热备份、双奇偶校验RAID、gzip压缩、SLOG、L2ARC、用户和组配额、三重奇偶校验RAID、数据去重、混合RAID分配和加密。这些功能使ZFS成为文件服务器(文件存储器)的理想选择,Sun/Oracle和其他公司基于开源的ZFS版本开发了这些服务器。

自发布以来增加的主要性能特性包括:

池化存储:所有存储设备都放置在一个池中,从中创建文件系统。这允许所有设备并行使用,以获得最大吞吐量和IOPS。可以使用不同的RAID类型:0、1、10、Z(基于RAID-5)、Z2(双奇偶校验)和Z3(三重奇偶校验)。

写时复制(COW):按组顺序写入数据。

日志记录:ZFS刷新更改的事务组(TXGs),这些更改作为整体成功或失败,因此磁盘上的格式始终保持一致。这也批处理写操作,提高异步写入吞吐量。

自适应替换缓存(ARC):通过同时使用多种缓存算法(最近使用的(MRU)和最频繁使用的(MFU)),实现高缓存命中率。主存储器在这些算法之间进行平衡,根据它们的性能进行调整,通过维护额外的元数据(幽灵列表)来了解如果其中一个算法占据了整个主存储器将如何执行。

可变块大小:每个文件系统都有一个可配置的最大块大小(记录大小),可以选择以匹配工作负载。较小的大小用于较小的文件。

动态条带化:这在所有存储设备上进行条带化,以获得最大吞吐量,并在添加设备时将额外的设备包含在条带中。

智能预读:ZFS根据需要应用不同类型的预读:对于元数据、znodes(文件内容)和vdevs(虚拟设备)。

多预读流:单个文件上的多个流式读取器可以创建随机I/O工作负载,因为文件系统在它们之间寻找(这在UFS中是一个问题)。ZFS跟踪各个预读流,允许新的流加入它们,并有效地发出I/O。

快照:由于COW架构,可以几乎即时创建快照,推迟复制新块直到需要为止。

ZIO管道:设备I/O经过一系列阶段的处理,每个阶段由一组线程提供服务,以提高性能。

压缩:支持多种算法,通常由于CPU开销而降低性能。lzjb(Lempel-Ziv Jeff Bonwick)选项是轻量级的,通过降低I/O负载(因为它被压缩)可以在一定程度上提高存储性能,但会牺牲一些CPU性能。

SLOG:ZFS单独的意向日志允许将同步写入写入到单独的设备中,避免与池磁盘工作负载发生冲突。在系统故障时,写入SLOG只能被读取,以进行回放。这可以极大地提高同步写入的性能。

L2ARC:第二级缓存,用于在基于闪存的固态硬盘(SSD)上缓存随机读取工作负载。它不缓冲写入工作负载,只包含已经存在于存储池磁盘上的干净数据。L2ARC扩展了系统的缓存范围,有助于避免工作负载超出主存储器缓存时的性能急剧下降。它还提供滞后效应,因为与主存储器相比,它的填充速度较慢,它将包含长期数据的副本。如果干扰污染了主存储器缓存,L2ARC可以快速恢复“热”主存储器缓存状态。

vdev缓存:类似于原始缓冲缓存的作用,ZFS使用每个虚拟设备的独立vdev缓存,支持LRU和预读。(这在某些操作系统中可能已被禁用。)

数据去重:避免记录相同数据的多个副本的文件系统级特性。这个功能对性能有显著的影响,既有利(减少设备I/O),也有弊(当哈希表不再适合主存储器时,设备I/O会膨胀,可能会显著增加)。初始版本仅适用于哈希表预计始终适合主存储器的工作负载。

L2ARC和SLOG是ZFS混合存储池(HSP)模型的一部分,智能地在ZFS存储池中使用读取和写入优化的固态硬盘(SSD)。读取优化的SSD的价格/性能比介于主存储器和磁盘之间,使其适用于作为额外缓存层使用。

还包括其他次要的性能特性,例如“不在乎间隙”,在适当时发出更大的读取,即使不需要小部分(间隙);以及混合RAID,支持一个池中的不同策略。

与其他文件系统相比,ZFS的一个行为可能会降低性能:默认情况下,ZFS向存储设备发出缓存刷新命令,以确保写入在断电情况下已完成。这是ZFS的完整性特性之一;然而,代价是可能会导致必须等待缓存刷新的ZFS操作产生延迟,并且某些工作负载在ZFS上的表现可能会比其他文件系统差。可以调整ZFS以避免执行缓存刷新以提高性能;然而,与其他文件系统一样,这会引入部分写入和断电时数据损坏的风险,取决于所使用的存储设备。

有两个项目正在将ZFS引入Linux。一个是由劳伦斯利弗莫尔国家实验室[2]开发的ZFS on Linux,它是一个本地内核端口。另一个是ZFS-FUSE,在用户空间运行ZFS,由于上下文切换开销,其性能预计会较差。

btrfs

Btrfs(B-tree文件系统)基于写时复制的B树结构。这是一种现代文件系统和卷管理器相结合的架构,类似于ZFS,并且预计最终会提供类似的功能集。当前的功能包括池化存储、大容量、范围、写时复制、卷增长和收缩、子卷、块设备添加和移除、快照、克隆、压缩和CRC-32C校验和。该项目由甲骨文公司于2007年启动,目前仍在积极开发中,并被认为是不稳定的。

关键的性能特性包括以下内容:

- 池化存储:存储设备被放置在一个卷中,从中创建文件系统。这允许所有设备并行使用,以获得最大吞吐量和IOPS。可以使用不同的RAID类型:0、1和10。

- 写时复制(COW):按组顺序写入数据。

- 在线平衡:对象可以在存储设备之间移动,以平衡它们的工作负载。

- 范围:改善了顺序布局和性能。

- 快照:由于采用了写时复制的架构,可以几乎即时创建快照,推迟复制新块直到需要为止。

- 压缩:支持zlib和LZO。

- 日志记录:可以创建每个子卷的日志树,以记录同步写入的COW工作负载。

计划中与性能相关的特性包括RAID-5和6、对象级RAID、增量转储和数据去重。

8.4.6 Volumes and Pools

历史上,文件系统是建立在单个磁盘或磁盘分区之上的。卷和存储池允许文件系统建立在多个磁盘上,并可以使用不同的RAID策略进行配置(见第9章《磁盘》)。

卷将多个磁盘呈现为一个虚拟磁盘,文件系统建立在其上。如果建立在整个磁盘上(而不是切片或分区),卷会隔离工作负载,减少争用的性能问题。

卷管理软件包括Linux系统的逻辑卷管理器(LVM)和Solaris卷管理器(SVM)。卷或虚拟磁盘也可以由硬件RAID控制器提供。

存储池包括存储池中的多个磁盘,可以从中创建多个文件系统。在图8.13中显示了与卷进行对比的存储池。存储池比卷存储更灵活,因为无论支持设备如何,文件系统都可以增长和收缩。这种方法被现代文件系统(包括ZFS和btrfs)所采用。

存储池可以使用所有磁盘设备来支持所有文件系统,提高性能。工作负载不会被隔离;在某些情况下,可以使用多个存储池来分隔工作负载,尽管这会导致一定的灵活性降低,因为磁盘设备必须最初放置在一个池中或另一个池中。

在使用软件卷管理器或存储池时,额外的性能考虑包括以下内容:

- 条带宽度:与工作负载匹配。

- 可观察性:虚拟设备利用可能会令人困惑;请检查单独的物理设备。

- CPU开销:特别是在执行RAID奇偶校验计算时。随着现代更快的CPU,这已经不再是问题。

- 重建:也称为重新同步,当向RAID组添加空白磁盘(例如替换故障磁盘)并用必要的数据填充以加入组时。这可能会显著影响性能,因为它会消耗I/O资源,可能持续数小时甚至数天。

随着存储设备容量增长速度超过吞吐量的增长,未来重建可能会成为更严重的问题。

8.5 Methodology

这一部分介绍了文件系统分析和调优的各种策略和练习。这些主题在表8.3中有总结。

更多策略和这些主题的介绍,请参见第2章《方法论》。

这些策略可以单独遵循,也可以组合使用。我的建议是按照以下顺序开始使用这些策略:延迟分析、性能监控、工作负载特征化、微基准测试、静态分析和事件跟踪。您可以提出不同的组合和顺序,在您的环境中找到最佳的方法。

第8.6节《分析》展示了应用这些方法的操作系统工具。

8.5.1 Disk Analysis

一个常见的策略是忽略文件系统,而是专注于磁盘性能。这种做法假设最糟糕的I/O是磁盘I/O,因此通过仅分析磁盘,您便方便地聚焦于问题的预期来源。

在文件系统较简单且缓存较小的情况下,这通常是有效的。然而,如今这种方法变得令人困惑,并且忽略了整个类别的问题(请参见第8.3.12节《逻辑I/O与物理I/O之间的区别》)。

8.5.2 Latency Analysis

对于延迟分析,首先要测量文件系统操作的延迟。这应该包括所有对象操作,而不仅仅是I/O(例如,包括sync())。

操作延迟 = 时间(操作完成) - 时间(操作请求)

这些时间可以从附近的四个层中的任何一个进行测量,如表8.4所示。

选择层可能取决于工具的可用性。请检查以下内容:

应用程序文档:一些应用程序已经提供文件系统延迟指标,或者具有启用收集这些指标的功能。

操作系统工具:操作系统通常也会提供指标,最好是针对每个文件系统或应用程序分别统计。

动态跟踪:如果您的系统支持动态跟踪,可以通过自定义脚本检查所有层,无需重新启动任何内容。

延迟可能呈现为

每个间隔的平均值:例如,每秒的平均读取延迟

完整分布:作为直方图或热力图;请参见第8.6.18节《可视化》

每个操作的延迟:列出每个操作;请参见第8.5.5节《事件跟踪》

对于高缓存命中率(超过99%)的文件系统,每个间隔的平均值可能会受到缓存命中延迟的影响。当存在重要但难以从平均值中看到的高延迟实例(离群值)时,这可能是不幸的。检查完整分布或每个操作的延迟允许调查这些离群值,以及不同延迟层级(包括文件系统缓存命中和未命中)的影响。

一旦发现高延迟,继续深入分析文件系统以确定来源。

Transaction Cost

将文件系统延迟表示为应用程序事务(例如,数据库查询)中等待文件系统的总时间的另一种方法是:

文件系统中百分比时间 = 100 * 总阻塞文件系统延迟 / 应用程序事务时间

这允许以应用程序性能的术语量化文件系统操作的成本,并预测性能改进。该指标可以表示为在间隔期间所有事务的平均值,或者针对单个事务。

图8.14显示了用于服务事务的应用程序线程所花费的时间。该事务发出单个文件系统读取请求;应用程序阻塞并等待其完成,转移到了非 CPU 状态。在这种情况下,总阻塞时间是单个文件系统读取的时间。如果在事务期间调用了多个阻塞 I/O,则总时间为它们的总和。

作为具体示例,一个应用程序事务需要 200 毫秒,期间在多个文件系统 I/O 上等待了总共 180 毫秒。应用程序由文件系统阻塞的时间为 90%(100 * 180 毫秒 / 200 毫秒)。消除文件系统延迟可能最多可以将性能提高 10 倍。

另一个例子,如果一个应用程序事务需要 200 毫秒,在此期间仅花费了 2 毫秒在文件系统中,则文件系统——以及整个磁盘 I/O 栈——仅占事务运行时间的 1%。这个结果非常有用,因为它可以将性能调查引导到真正的延迟源,并避免浪费时间在不必要的地方进行调查。

如果应用程序正在发出非阻塞 I/O,那么在文件系统响应时应用程序可以继续在 CPU 上执行。在这种情况下,阻塞文件系统延迟仅度量应用程序在非 CPU 上阻塞的时间。

8.5.3 Workload Characterization

在容量规划、基准测试和模拟工作负载时,对所施加的负载进行特征化是一项重要的任务。通过识别可以消除的不必要工作,它还可以带来最大的性能提升。

以下是描述文件系统工作负载的基本属性:

- 操作速率和操作类型

- 文件 I/O 吞吐量

- 文件 I/O 大小

- 读/写比例

- 同步写入比例

- 随机与顺序文件偏移访问

操作速率和吞吐量的定义可参考第8.1节中的术语。同步写入和随机与顺序的描述可参考第8.3节中的概念。

这些特征可以从秒到秒地变化,特别是对于按间隔执行的定时应用程序任务。为了更好地描述工作负载,捕获最大值和平均值是必要的。更好的做法是对随时间变化的值进行完整的分布分析。

以下是一个工作负载描述的示例,展示了如何将这些属性结合起来表达:

在一个金融交易数据库中,文件系统具有随机读取的工作负载,平均每秒处理 18,000 次读取,平均读取大小为 2 Kbytes。总操作速率为 21,000 ops/s,其中包括读取、统计、打开、关闭以及约 200 次同步写入每秒。写入速率稳定,而读取速率则有所变化,最高峰可达到每秒 39,000 次读取。

这些特征可以描述单个文件系统实例,也可以描述同类型系统上的所有实例。

高级工作负载特征化/检查清单

可以包含额外细节来描述工作负载。以下列出了一些考虑的问题,这些问题也可以作为一个检查清单,在彻底研究文件系统问题时使用:

- 文件系统缓存命中率是多少?未命中率呢?

- 文件系统缓存容量和当前使用情况是多少?

- 还有哪些其他缓存存在(目录、inode、缓冲),它们的统计数据是什么?

- 哪些应用程序或用户正在使用文件系统?

- 正在访问哪些文件和目录?创建和删除了哪些?

- 是否遇到过任何错误?这是由于无效请求还是文件系统问题引起的?

- 文件系统 I/O 为何发出(用户级调用路径)?

- 文件系统 I/O 应用程式是多么同步?

- I/O 到达时间的分布是怎样的?

这些问题中的许多可以针对每个应用程序或每个文件提出。任何一个问题也可以随着时间的推移进行检查,以寻找最大值和最小值,以及基于时间的变化。此外,还请参阅第2章方法论中的2.5.10节,工作负载特征化,提供了要测量的特征的更高级摘要(谁、为什么、什么、如何)。

性能特性

以下问题(与之前的工作负载特性对比)描述了工作负载的结果性能:

- 平均文件系统操作延迟是多少?

- 是否有任何高延迟的异常值?

- 操作延迟的完整分布是什么样的?

- 系统资源控制是否存在并且对文件系统或磁盘 I/O 有效?

前三个问题可以分别针对每种操作类型进行提问。

8.5.4 Performance Monitoring

性能监控可以识别出活动问题和随时间变化的行为模式。文件系统性能的关键指标是:

- 操作速率

- 操作延迟

操作速率是应用负载的最基本特性,而延迟则是产生的性能结果。正常或不良延迟的值取决于您的工作负载、环境和延迟要求。如果您不确定,可以进行已知良好和不良工作负载的微基准测试,以调查延迟情况(例如,通常从文件系统缓存中命中的工作负载与通常未命中的工作负载)。请参阅第8.7节,实验。

操作延迟指标可以作为每秒平均值进行监控,并可以包括其他值,如最大值和标准偏差。理想情况下,可以检查延迟的完整分布,例如使用直方图或热力图,以查找异常值和其他模式。

速率和延迟也可以记录每种操作类型(读取、写入、stat、打开、关闭等)的情况。这将极大地帮助工作负载和性能变化的调查,通过识别特定操作类型的差异。

对于实施了基于文件系统的资源控制(例如ZFS I/O限流)的系统,可以包含统计信息,以显示何时使用了限流。

8.5.5 Event Tracing

事件跟踪捕获每个文件系统操作的详细信息。对于观察性分析来说,这是最后的手段。由于捕获和保存这些详细信息会增加性能开销,通常将它们写入日志文件以供后续检查。这些日志文件可以包含每个操作的以下详细信息:

- 文件系统类型

- 文件系统挂载点

- 操作类型:读取、写入、stat、打开、关闭、mkdir等

- 操作大小(如果适用):字节

- 操作开始时间戳:操作发出到文件系统的时间

- 操作完成时间戳:文件系统完成操作的时间

- 操作完成状态:错误

- 路径名(如果适用)

- 进程ID

- 应用程序名称

开始和完成时间戳允许计算操作延迟。许多跟踪框架允许在跟踪过程中进行计算,因此可以计算并将延迟包含在日志中。它还可以用于过滤输出,只记录超过某个阈值的操作。文件系统操作速率可以达到每秒数百万次,因此在适当的情况下进行过滤可能是一个很好的主意。

事件跟踪可以在第8.5.2节中列出的四个层级中的任何一个执行。有关示例,请参阅第8.6节,分析。

8.5.6 Static Performance Tuning

静态性能调优侧重于已配置环境的问题。对于文件系统性能,要检查静态配置的以下方面:

- 挂载和活动使用的文件系统数量是多少?

- 文件系统记录大小是多少?

- 是否启用了访问时间戳?

- 是否启用了其他文件系统选项(压缩、加密等)?

- 文件系统缓存如何配置?最大大小是多少?

- 其他缓存(目录、inode、缓冲区)如何配置?

- 是否存在并使用二级缓存?

- 存在和使用的存储设备数量是多少?

- 存储设备的配置是什么?RAID吗?

- 使用了哪些文件系统类型?

- 文件系统(或内核)的版本是什么?

- 是否存在应考虑的文件系统错误/补丁?

- 是否对文件系统I/O使用了资源控制?

回答这些问题可以揭示被忽视的配置选择。有时系统被配置为适应一种工作负载,然后被重新用于另一种用途。这种方法将重新审视这些选择。

8.5.7 Cache Tuning

内核和文件系统可能使用许多不同的缓存,包括缓冲区缓存、目录缓存、inode缓存和文件系统(页)缓存。各种缓存在第8.4节“架构”中进行了描述,可以按照第2章“方法论”中第2.5.17节“缓存调优”的描述进行调整。总的来说,检查存在哪些缓存,检查它们是否正常工作,检查它们的工作情况如何,检查它们的大小,然后为缓存调整工作负载,为工作负载调整缓存。

8.5.8 Workload Separation

某些类型的工作负载在配置为使用自己的文件系统和磁盘设备时可以获得更好的性能。这种方法被称为使用“独立的磁盘”,因为通过在两个不同的工作负载位置之间进行寻址来创建随机I/O对于旋转磁盘尤其不利(详见第9章“磁盘”)。

例如,数据库可以从为其日志文件和数据库文件使用单独的文件系统和磁盘受益。

8.5.9 Memory-Based File Systems

另一种改善性能的配置方法是使用基于内存的文件系统。这些文件系统保留在内存中,以便尽快提供文件内容。它们通常仅作为解决方案部署,因为许多应用程序在进程内存中具有自己的(可配置的)应用程序特定缓存,通过文件和系统调用接口访问比通过文件更高效。在现代系统中,使用大型文件系统缓存,通常不值得使用基于内存的文件系统。

/tmp

标准的/tmp文件系统用于存储临时文件,通常配置为基于内存。例如,Solaris使用tmpfs作为/tmp,它是一个由交换设备支持的基于内存的文件系统。Linux也有一个tmpfs,用于几个特殊的文件系统类型。

8.5.10 Micro-Benchmarking

用于文件系统和磁盘基准测试的基准工具(有很多种)可以用来测试不同文件系统类型或文件系统内的设置在给定工作负载下的性能。可能测试的典型因素包括:

操作类型:读取、写入和其他文件系统操作的速率

I/O 大小:从 1 字节到 1 M 字节及更大

文件偏移模式:随机或顺序

随机访问模式:均匀随机或帕累托分布

写入类型:异步或同步(O_SYNC)

工作集大小:它在文件系统缓存中的适应程度

并发性:正在进行中的 I/O 数量,或执行 I/O 的线程数量

内存映射:通过 mmap() 进行文件访问,而不是 read()/write()

缓存状态:文件系统缓存是“冷”(未填充)还是“热”

文件系统可调参数:可能包括压缩、数据去重等

常见的组合包括随机读取、顺序读取、随机写入和顺序写入。

最关键的因素通常是工作集大小:在基准测试期间访问的数据量。根据基准测试的不同,这可能是正在使用的文件的总大小。小的工作集大小可能完全从主内存中的文件系统缓存中返回(DRAM)。大的工作集大小可能主要从存储设备(磁盘)返回。性能差异可能是多个数量级。

考虑不同基准测试的一般期望,其中包括文件的总大小(工作集大小),见表 8.5。

一些文件系统基准测试工具并不清楚它们正在测试什么,并可能暗示进行磁盘基准测试,但使用小的总文件大小并完全从缓存中返回。参见第 8.3.12 节,逻辑与物理 I/O,了解测试文件系统(逻辑 I/O)与测试磁盘(物理 I/O)之间的区别。

一些磁盘基准测试工具通过使用直接 I/O 绕过缓存和缓冲来操作文件系统。文件系统仍然扮演较小的角色,增加了代码路径开销和文件与磁盘位置之间的映射差异。这有时是测试文件系统的一种有意策略:分析最坏情况性能(0% 缓存命中率)。随着内存系统变得越来越大,这种策略越来越不现实,因为应用程序通常期望有显著的缓存命中率。

有关这个主题的更多信息,请参见第12章“基准测试”。

8.6 Analysis

本节介绍了针对基于Linux和Solaris操作系统的文件系统性能分析工具。有关使用这些工具时要遵循的策略,请参见前一节。

本节中列出的工具如表8.6所示。

这是一些工具和功能的选择,用于支持前面的方法论部分,从系统范围和每个文件系统的可观测性开始,然后进行操作和延迟分析,并最后完成缓存统计。有关它们功能的完整参考,请参阅工具文档,包括man手册。

虽然您可能只对基于Linux或Solaris的系统感兴趣,但考虑一下其他操作系统工具以及它们提供的可观测性,可以获得不同的视角。

8.6.1 vfsstat

vfsstat(1) 是一个类似于 iostat(1M) 的工具,用于 VFS 层级,最初由 Bill Pijewski 为 SmartOS 开发。它会打印文件系统操作(逻辑 I/O)的每个时间间隔摘要,包括用户级应用程序经历的平均延迟。与 iostat(1) 中显示的磁盘 I/O(物理 I/O),包括异步类型的统计信息相比,这些信息对应用程序性能更为相关。

输出的第一行是自启动以来的摘要,其后是每秒的摘要。列包括:

- r/s, w/s:每秒的文件系统读取和写入次数

- kr/s, kw/s:每秒的文件系统读取和写入的千字节数

- ractv, wactv:服务中的读取和写入操作的平均数量

- read_t, writ_t:平均的VFS读取和写入延迟(毫秒)

- %r, %w:VFS读取和写入操作挂起的时间百分比

- d/s, del_t:每秒的I/O节流延迟,以及平均延迟(微秒)

vfsstat(1) 提供了用于描述工作负载以及其结果性能的信息。它还包括有关ZFS I/O节流的信息,该信息在SmartOS云计算环境中用于平衡租户。前面的示例显示了读取工作负载介于1.5到2K读取/秒之间,吞吐量介于73到92兆字节/秒之间。平均延迟非常小,以至于已被舍入为0.0毫秒。这种工作负载很可能是从文件系统缓存返回的,它使文件系统处于忙碌(活动)状态的时间仅占3%到4%。

8.6.2 fsstat

Solaris的fsstat工具报告各种文件系统统计信息:

这些信息可用于工作负载特征化,并且可以根据每个文件系统进行检查。请注意,fsstat不包括延迟统计信息。

8.6.3 strace, truss

以前用于详细测量文件系统延迟的操作系统工具包括针对系统调用接口的调试器,例如Linux中的strace(1)和Solaris中的truss(1)。这些调试器可能会影响性能,并且只有在性能开销可接受且无法使用其他方法分析延迟时才适合使用。

以下示例显示了在ext4文件系统上使用strace(1)定时读取的情况:

-tt选项在左侧打印相对时间戳,-T在右侧打印系统调用时间。每个read()调用读取64 KB,第一个调用花费了18毫秒,接着是56微秒(可能是缓存),然后是5毫秒。这些读取是对文件描述符9的。要检查这是否是对文件系统的读取(而不是套接字),要么open()系统调用将在较早的strace(1)输出中可见,要么可以使用其他工具如lsof(8)。

8.6.4 DTrace

DTrace可以从系统调用接口、VFS接口和文件系统内部来检查文件系统行为。这些功能支持工作负载特征化和延迟分析。以下部分介绍了在基于Solaris和Linux的系统上进行文件系统分析的DTrace。除非另有说明,否则DTrace命令适用于两种操作系统。在第四章《可观测性工具》中包括了一个DTrace入门指南。

操作计数

通过应用程序和类型对文件系统操作进行汇总,提供了有用的工作负载特征化的指标。

这个Solaris的一行命令通过应用程序名称,使用fsinfo(文件系统信息)提供程序统计文件系统操作次数:

输出显示,在跟踪期间,名为node的进程执行了25,340次文件系统操作。可以添加一个tick-1s探针来报告每秒的汇总情况,以便观察速率。

操作的类型可以通过对probename进行聚合来报告。例如:

这也展示了如何检查特定应用程序,本例中过滤条件是"splunkd"。

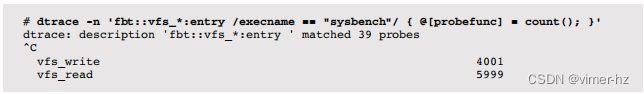

在Linux上,可以从syscall和fbt提供程序观察文件系统操作,直到fsinfo可用为止。例如,使用fbt跟踪内核VFS函数:

在这个跟踪过程中,执行最多文件系统操作的应用程序名为sysbench(一个基准测试工具[3])。

通过对probefunc进行聚合来计算操作类型的数量:

这与sysbench进程匹配,该进程在执行随机读写基准测试时显示了操作的比率。要从输出中去掉vfs_,而不是使用@[probefunc],可以使用@[probefunc + 4](指针加偏移量)。

文件打开

之前的一行命令使用DTrace来汇总事件计数。接下来的示例演示了单独打印所有事件数据,即在此情况下,系统范围内open()系统调用的详细信息:

opensnoop是来自DTraceToolkit的基于DTrace的工具;它默认包含在Oracle Solaris 11和Mac OS X中,并可用于其他操作系统。它提供了对文件系统工作负载的某种视图,显示了open()的进程、路径名和错误,这对性能分析和故障排除都很有用。在这个示例中,nginx进程遇到了一个打开失败的情况(ERR 2 == 文件未找到)。其他常用的DTraceToolkit脚本包括rwsnoop和rwtop,它们跟踪和汇总逻辑I/O。rwsnoop跟踪read()和write()系统调用,而rwtop使用sysinfo提供程序汇总吞吐量(字节)。

系统调用延迟

这个一行命令在系统调用接口处测量文件系统的延迟,并将其汇总为以纳秒为单位的直方图:

该分布显示了两个峰值,第一个在4到16微秒之间(缓存命中),第二个在2到8毫秒之间(磁盘读取)。与quantize()不同,avg()函数可以用于显示平均值(均值)。然而,这将对两个峰值进行平均,这可能会产生误导性。

这种方法跟踪单个系统调用,本例中为read()。要捕获所有文件系统操作,需要跟踪所有相关的系统调用,包括每种类型的变体(例如,pread()、pread64())。这可以通过构建一个脚本来捕获所有类型,或者针对给定的应用程序,通过DTrace检查它使用的系统调用类型,然后只跟踪那些类型来执行。

这种方法还捕获了所有文件系统活动,包括非存储文件系统,如sockfs。对于这个一行命令,文件系统类型通过检查fds[arg0].fi_fs的值来进行过滤,该值将文件描述符(read()的arg0)转换为文件系统类型(fds[].fi_fs)。在这种情况下,还可以应用其他有用的过滤器,例如按应用程序名称或PID、挂载点或路径名组件进行过滤。

请注意,此延迟可能会直接影响应用程序的性能,如第8.3.1节“文件系统延迟”所述。这取决于延迟是在应用程序请求期间遇到的,还是在异步后台任务期间遇到的。您可以使用DTrace开始回答这个问题,方法是捕获用于系统调用I/O的用户级堆栈跟踪,这可能会解释为什么执行了该操作(例如,使用@[ustack(), "ns"]进行聚合)。这可能会根据应用程序的复杂性和其源代码变得更加复杂。

VFS延迟

VFS接口可以通过静态提供程序(如果存在)或通过动态跟踪(fbt提供程序)进行跟踪。

在Solaris上,可以通过fop_*()函数跟踪VFS,例如:

与先前的系统调用示例不同,这显示了一个完全缓存的工作负载。这个一行命令还具有更广泛的可见性,因为它匹配了所有的读取变体。

其他VFS操作也可以类似地进行跟踪。列出入口探针:

请注意,fbt提供程序被认为是一个不稳定的接口,因此任何基于fbt的一行命令或脚本可能需要更新,以匹配随着内核变化而变化的情况(尽管VFS实现并不经常更改)。

在Linux上,可以使用DTrace原型:

这次的谓词匹配的是ext4文件系统。可以看到缓存命中和未命中的峰值,伴随着预期的延迟。

列出VFS函数入口探针:

块设备I/O堆栈

检查块设备I/O的内核堆栈跟踪是了解文件系统内部工作原理以及导致磁盘I/O的代码路径的绝佳方法。它还可以帮助解释超出预期工作负载的附加磁盘I/O(异步、元数据)的原因。

通过在发出块设备I/O时对内核堆栈跟踪进行频率计数来暴露ZFS内部:

输出显示了跟踪过程中堆栈跟踪及其出现次数。

顶部堆栈显示了一个异步的ZFS I/O(来自运行ZIO管道的taskq线程)和一个源自读取系统调用的同步I/O。为了收集更多细节,可以使用DTrace fbt提供程序对这些堆栈的每一行进行单独跟踪,采用相同的方法来暴露ext4:

这条路径显示了一个read()系统调用触发了页面缓存的预读取。

文件系统内部

必要时,可以通过跟踪其实现来确定文件系统中的延迟。

在Solaris上列出ZFS函数入口探针:

ZFS与VFS有直接的映射关系,使得高级跟踪变得简单。例如,跟踪ZFS读取延迟:

输出显示了大约8μs(缓存命中)左右的I/O峰值,另一个在大约4毫秒(缓存未命中)左右。这是因为zfs_read()在系统调用上同步阻塞。在ZFS内部更深处,函数会发出I/O,但不会阻塞等待其完成,因此测量I/O时间变得更加复杂。

在Linux上,可以以类似的方式跟踪ext4文件系统的内部实现:

一些函数是同步的,例如ext4_readdir(),其延迟可以像前面的zfs_read()示例一样进行测量。

其他函数则不是同步的,包括ext4_readpage()和ext4_readpages()。要测量它们的延迟,需要将I/O发出和完成之间的时间相关联并进行比较。或者,可以在堆栈中更高的位置进行跟踪,就像VFS示例中演示的那样。

慢事件跟踪

DTrace可以打印每个文件系统操作的详细信息,就像第9章“磁盘”中的iosnoop打印每个磁盘I/O一样。然而,在文件系统级别进行跟踪可能会产生更大量的输出,因为它包括文件系统缓存命中。解决这个问题的一种方法是只打印慢操作,这有助于分析特定类别的问题:延迟异常值。

zfsslower.d脚本[4]打印了比设定的毫秒数慢的ZFS级别操作:

这个经过编辑的输出显示了比10毫秒慢的文件系统操作。

高级跟踪

在需要进行高级分析时,动态跟踪可以更详细地探索文件系统。为了提供可能性的想法,表8.7显示了来自DTrace的《文件系统》章节(共108页)的脚本[Gregg 11](这些脚本也可以在网上找到[4])。

尽管这种程度的可观察性令人难以置信,但许多这些动态跟踪脚本都与特定的内核内部绑定在一起,并且需要进行维护以匹配新内核版本中的更改。

作为高级跟踪的一个示例,以下是一个DTraceToolkit脚本,它在从UFS读取50KB文件时跟踪了多个层面的事件:

第一个事件是一个8千字节的系统调用读取(sc-read),它被处理为VFS读取(fop_read),然后是磁盘读取(disk_io),随后是下一个8千字节的预读(disk_ra)。接下来的偏移8千字节的系统调用读取不会触发磁盘读取,因为它已经被缓存,而是触发了从偏移16开始的预读,以获取下一个34千字节的数据——50千字节文件的剩余部分。其余的系统调用都从缓存中返回,只有VFS事件可以看到。

8.6.5 SystemTap

SystemTap也可以用于Linux系统中对文件系统事件进行动态跟踪。有关如何将先前的DTrace脚本转换的帮助,请参阅第4章可观测性工具中的第4.4节SystemTap,以及附录E。

8.6.6 LatencyTOP

LatencyTOP是一种报告延迟来源的工具,可以汇总系统范围和每个进程的延迟[5]。它最初是为Linux开发的,后来已经移植到基于Solaris的系统上。

LatencyTOP会报告文件系统的延迟。例如:

顶部部分是系统范围的摘要,底部是一个单独的gzip(1)进程,正在压缩一个文件。gzip(1)的大部分延迟是由于文件读取,占70.2%,而同步写入占27.2%,因为新压缩的文件正在写入。

LatencyTOP需要以下内核选项:CONFIG_LATENCYTOP和CONFIG_HAVE_LATENCYTOP_SUPPORT。

8.6.7 free

Linux的free(1)命令显示内存和交换空间的统计信息:

buffers列显示缓冲区缓存大小,cached列显示页面缓存大小。使用了-m选项以兆字节为单位呈现输出。

8.6.8 top

一些版本的top(1)命令包括文件系统缓存的详细信息。这来自Linux top的一行包括缓冲区缓存大小,这也由free(1)报告:

![]()

有关top(1)的更多信息,请参阅第6章的CPU部分。

8.6.9 vmstat

vmstat(1)命令,类似于top(1),也可能包括有关文件系统缓存的详细信息。有关vmstat(1)的更多详细信息,请参阅第7章内存部分。

Linux

以下命令运行vmstat(1),间隔为1,以提供每秒更新:

buff列显示缓冲区缓存大小,cache列显示页面缓存大小,单位均为千字节(kilobytes)。

Solaris

Solaris vmstat(1)的默认输出不显示缓存大小,但在这里值得一提:

free列的单位为千字节(kilobytes)。自Solaris 9以来,页面缓存被视为空闲内存,并且其大小包含在此列中。

-p选项显示按类型的页面进入/退出详细信息:

这允许将文件系统分页与匿名分页(低内存)区分开来。不幸的是,文件系统列目前不包括ZFS文件系统事件。

8.6.10 sar

系统活动报告工具sar(1)提供各种文件系统统计信息,并可以配置记录历史信息。sar(1)在本书的各个章节中都提到了,因为它提供了不同的统计信息。

Linux

执行sar(1)以报告当前活动的间隔:

-v选项提供以下列:

- dentunusd:目录条目缓存未使用计数(可用条目)

- file-nr:正在使用的文件句柄数

- inode-nr:正在使用的索引节点数

还有一个-r选项,用于打印缓冲区和页面缓存大小的kbbuffers和kbcached列,单位为千字节(kilobytes)。

Solaris

通过指定间隔和次数执行sar(1)以报告当前活动:

-v选项提供inod-sz,显示索引节点缓存大小和最大值。

还有一个-b选项,提供有关旧缓冲区缓存的统计信息。

8.6.11 slabtop

Linux的slabtop(1)命令打印有关内核slab缓存的信息,其中一些用于文件系统缓存:

在没有-o输出模式的情况下,slabtop(1)将刷新并更新屏幕。

Slabs可能包括:

- dentry:目录项缓存

- inode_cache:索引节点缓存

- ext3_inode_cache:用于ext3的索引节点缓存

- ext4_inode_cache:用于ext4的索引节点缓存

slabtop(1)使用/proc/slabinfo,如果启用了CONFIG_SLAB选项,则会存在该文件。

8.6.12 mdb ::kmastat

Solaris上可以使用mdb -k中的::kmastat查看详细的内核内存分配器统计信息,其中包括文件系统使用的各种缓存:

输出很长,显示所有的内核分配器缓存。可以研究正在使用的内存列,以确定哪些缓存存储了大量数据,从而了解内核内存使用情况。在此示例中,ZFS 8K字节文件数据缓存使用了23.5GB的内存。如果需要,还可以动态跟踪到特定缓存的分配,以识别代码路径和消费者。

8.6.13 fcachestat

这是一个针对基于Solaris的系统的开源工具,使用Perl的Sun::Solaris::Kstat库,并打印适合在UFS上进行缓存活动分析的摘要:

第一行是自启动以来的摘要。有五组列,用于各种缓存和驱动程序。ufsbuf是旧的缓冲区缓存,segmap和segvn显示页面缓存的驱动程序。列显示命中/未命中比例的百分比(%hit)和总访问数(total)。

fcachestat可能需要更新才能正常工作;这里包括它是为了展示系统可以提供哪些信息。

8.6.14 /proc/meminfo

Linux的/proc/meminfo文件提供了内存细分的摘要,并被像free(1)这样的工具所读取:

其中包括缓冲区缓存(Buffers)和页面缓存(Cached),并提供系统内存使用的其他高级细分。这些内容在第7章“内存”中有所涉及。

8.6.15 mdb ::memstat

Solaris中,使用mdb -k的::memstat命令可以提供Solaris内存使用的高级细分:

其中包括由ARC缓存的ZFS文件数据,以及包括UFS缓存数据的页面缓存。

8.6.16 kstat

前述工具的原始统计数据可以通过kstat获得,可以通过Perl的Sun::Solaris::Kstat库、C的libkstat库或kstat(1)命令来访问。表8.8中的命令显示了文件系统统计信息的组,以及可用数量(来自最近的内核版本)。

以下是其中一个示例:

虽然kstats可以提供丰富的信息,但它们在历史上并没有被文档化。有时统计名称是自说明的;有时需要查看内核源代码(如果可用)来确定每个统计数据的含义。

可用的统计数据也会因内核版本而异。在最近的SmartOS/illumos内核中,以下计数器已添加:

这些计数器记录了超出描述周期的文件系统操作,并按区域进行记录。在追踪云计算环境中的文件系统延迟时,这些信息可能非常宝贵。

8.6.17 Other Tools

其他工具和可观察性框架可能存在用于调查文件系统性能并描述其使用情况的情况。其中包括:

- df(1):报告文件系统使用情况和容量统计信息

- mount(8):可以显示文件系统挂载选项(静态性能调优)

- inotify:Linux的一个框架,用于监视文件系统事件

一些文件系统类型除了操作系统提供的工具外,还有自己特定的性能工具,例如ZFS。

ZFS

ZFS附带了zpool(1M),它具有用于观察ZFS池统计信息的iostat子选项。它报告池操作速率(读取和写入)和吞吐量。

一个受欢迎的附加工具是arcstat.pl工具,它报告ARC和L2ARC的大小以及命中率和未命中率。例如:

这些统计数据是按照间隔来统计的,其中包括:

- read, miss:总的 ARC 访问次数,未命中次数

- miss%,dm%,pm%,mm%:ARC 未命中百分比的总和,需求访问,预取访问,元数据访问

- dmis,pmis,mmis:需求访问,预取访问,元数据访问的未命中次数

- arcsz,c:ARC 大小,ARC 目标大小

arcstat.pl 是一个 Perl 程序,从 kstat 中读取统计数据。

8.6.18 Visualizations

应用于文件系统的负载可以随时间绘制成折线图,以帮助识别基于时间的使用模式。为了更好地理解,可以分别绘制读取、写入和其他文件系统操作的不同图表。

文件系统延迟的分布预计是双峰的:一个峰值代表文件系统缓存命中时的低延迟,另一个峰值代表缓存未命中(存储设备 I/O)时的高延迟。因此,将分布表示为单一值——如平均值、众数或中位数——是误导性的。

解决这个问题的一种方法是使用能够显示完整分布的可视化工具,比如热力图(热力图在第二章“方法论”中介绍过)。图 8.15 中给出了一个例子,它将时间的变化显示在 x 轴上,将 I/O 延迟显示在 y 轴上。

这个热力图展示了随机读取一个 1 G 字节文件时的文件系统情况。在热力图的前半部分,可以看到介于 3 到 10 毫秒之间的延迟云,这很可能反映了磁盘 I/O。底部的线表示文件系统缓存命中(DRAM)。在超过一半的位置,文件完全被缓存在了DRAM中,磁盘I/O云消失了。

这个例子来自 Joyent Cloud Analytics,它允许选择和隔离文件系统操作类型。

8.7 Experimentation

本节描述了用于主动测试文件系统性能的工具。请参阅第8.5.10节“微基准测试”,了解建议的跟随策略。

在使用这些工具时,建议始终保持 iostat(1) 运行,以确认达到磁盘的工作负载是否符合预期。例如,当测试应轻松适合文件系统缓存的工作集大小时,对于读取工作负载的期望是100%的缓存命中,因此 iostat(1) 不应显示磁盘I/O。iostat(1) 在第9章“磁盘”中有介绍。

8.7.1 Ad Hoc

dd(1) 命令(设备到设备复制)可用于执行顺序文件系统性能的临时测试。以下命令用于以 1 M 字节的 I/O 大小写入,然后读取名为 file1 的 1 G 字节文件:

Linux 版本的 dd(1) 在完成时会打印统计信息。

8.7.2 Micro-Benchmark Tools

有许多可用的文件系统基准测试工具,包括Bonnie、Bonnie++、iozone、tiobench、SysBench、fio和FileBench。以下是一些讨论的工具,按照递增复杂性的顺序排列。还请参阅第12章“基准测试”。

Bonnie, Bonnie++

Bonnie工具是一个简单的C程序,用于在单个文件上测试多个工作负载,从单个线程执行。它最初由Tim Bray于1989年编写。使用方法很简单:

使用 -s 参数设置要测试的文件大小。默认情况下,Bonnie使用100兆字节,该大小在此系统上完全被缓存:

输出包括每个测试期间的CPU时间,当CPU时间达到100%时,这表明Bonnie从未在磁盘I/O上阻塞,而总是从缓存中命中并保持在CPU上。

有一个称为Bonnie-64的64位版本,允许测试更大的文件。还有一个由Russell Coker重写的C++版本,名为Bonnie++。

不幸的是,像Bonnie这样的文件系统基准测试工具可能会误导人,除非您清楚地了解正在测试的内容。第一个结果是一个putc()测试,它可能会因系统库的实现而异,这样就会成为测试的目标,而不是文件系统本身。请参阅第12章“基准测试”的12.3.2节“主动基准测试”中的示例。

fio

The Flexible IO Tester (fio),由Jens Axboe开发,是一个可定制的文件系统基准测试工具,具有许多高级功能[8]。导致我选择使用它而不是其他基准测试工具的两个特点是:

1. 非均匀随机分布,可以更准确地模拟实际访问模式(例如,-random_distribution=pareto:0.9)。

2. 报告延迟百分位数,包括99.00、99.50、99.90、99.95、99.99。

以下是一个示例输出,显示了一个随机读取工作负载,其中包括8 K字节的I/O大小、5 G字节的工作集大小和非均匀访问模式(pareto:0.9):

延迟百分位数(clat)清楚地显示了缓存命中的范围,本例中可达到50th百分位数,因为它们的延迟较低。其余百分位数显示了缓存未命中的影响,包括队列的尾部;在本例中,99.99th百分位数显示了63毫秒的延迟。

尽管这些百分位数缺乏信息来真正理解可能是多模式分布的情况,但它们确实专注于最有趣的部分:较慢模式的尾部(磁盘I/O)。

如果你想要一个类似但更简单的工具,你可以尝试SysBench。另一方面,如果你想要更多的控制权,可以尝试FileBench。

FileBench

FileBench是一个可编程的文件系统基准测试工具,可以通过描述它们的工作负载模型语言来模拟应用程序工作负载。这允许模拟具有不同行为的线程,并指定同步线程行为。它附带了各种这些配置,称为个性化配置,包括用于模拟Oracle 9i I/O模型的配置。不幸的是,FileBench不是一个易于学习和使用的工具,可能只对全职从事文件系统工作的人感兴趣。

8.7.3 Cache Flushing

Linux提供了一种清空(从中删除条目)文件系统缓存的方法,这对于从一致且“冷”缓存状态进行性能基准测试可能很有用,比如在系统启动后。这个机制在内核源代码文档(Documentation/sysctl/vm.txt)中被非常简单地描述为:

目前Solaris系统中没有类似的机制。

8.8 Tuning

已经在第8.5节“方法论”中涵盖了许多调优方法,包括缓存调优和工作负载特征化。后者通过识别和消除不必要的工作,可能会带来最高的调优效果。本节包括具体的调优参数(可调参数)。

调优的具体方式——可用选项和如何设置它们——取决于操作系统版本、文件系统类型和预期的工作负载。以下各节提供了可能可用的示例以及它们可能需要进行调优的原因。涵盖的内容包括应用程序调用和两种示例文件系统类型:ext3和ZFS。有关页面缓存的调优,请参阅第7章“内存”。

8.8.1 Application Calls

第8.3.7节《同步写入》提到,通过使用fsync()来刷新一组逻辑写入,而不是在使用O_DSYNC/O_RSYNC open()标志时单独刷新,可以改善同步写入工作负载的性能。其他可以提高性能的调用包括posix_fadvise()和madvise(),它们提供了缓存合格性的提示。

posix_fadvise()

这个库调用在文件的一个区域上操作,并具有以下函数原型

![]()

该建议可能如表8.9所示。

内核可以使用这些信息来提高性能,帮助它决定何时最好预取数据,以及何时最好缓存数据。这可以提高高优先级数据的缓存命中率,如应用程序建议的那样。请参阅您系统上的man页,以获取建议参数的完整列表。

posix_fadvise()在第3章《操作系统》的第3.3.4节《差异》中被用作示例,因为支持可能会根据内核的不同而变化。

madvise()

这个库调用在内存映射上操作,并具有概要。

![]()

建议可能如表8.10所示。

与posix_fadvise()类似,内核可以利用这些信息来提高性能,包括做出更好的缓存决策。

8.8.2 ext3

在Linux上,可以使用tune2fs(8)命令来调整ext2、ext3和ext4文件系统。还可以在挂载时设置各种选项,可以手动使用mount(8)命令进行设置,也可以在/boot/grub/menu.lst和/etc/fstab中设置启动时的选项。可用的选项在tune2fs(8)和mount(8)的man页面中,可以使用tunefs -l 设备 和 mount(无选项)命令查看当前设置。可以使用mount(8)中的noatime选项禁用文件访问时间戳更新,这样如果文件系统用户不需要这些更新,则会减少后端I/O,从而提高整体性能。

用于提高性能的tune2fs(8)的一个关键选项是

![]()

它使用哈希B树来加速大型目录中的查找。

e2fsck(8)命令可用于重新索引文件系统中的目录。例如:

![]()

e2fsck(8)的其他选项与检查和修复文件系统相关。

8.8.3 ZFS

ZFS支持每个文件系统的大量可调参数(称为属性),还有一些可以在系统范围内设置(/etc/system)。可以使用zfs(1)命令列出文件系统的属性。例如:

(截断的)输出包括属性名称、当前值和来源的列。来源显示了如何设置属性:是从更高级别的ZFS数据集继承的,是默认值,还是在该文件系统上本地设置的。

这些参数也可以使用命令进行设置,并在man页面中进行了描述。与性能相关的关键参数列在表8.11中。

调整最重要的参数通常是记录大小,以匹配应用程序的I/O。它通常默认为128 KB,这对于小范围的随机I/O可能效率低下。请注意,这不适用于小于记录大小的文件,这些文件使用与其文件长度相等的动态记录大小保存。

如果不需要时间戳,禁用atime也可以提高性能(尽管其更新行为已经经过优化)。

表8.12中显示了示例系统范围的ZFS可调参数。(随着ZFS版本的变化,对性能最重要的参数可能会有所不同;表中的这三个参数在您阅读时可能会再次更改。)

在多年的发展中,zfs_txg_synctime_ms和zfs_txg_timeout可调参数的默认值已经降低,这样TXG就会更小,不太可能因为排队而与其他I/O竞争。与其他内核可调参数一样,请查阅供应商文档以获取完整列表、描述和警告。根据公司或供应商政策,设置这些参数可能也被禁止。

关于ZFS调优的更多信息,您可能会喜欢查阅《ZFS邪恶调优指南》[9]。

9 Disks

磁盘I/O可能会导致应用程序延迟显著增加,因此是系统性能分析的重要目标。在高负载下,磁盘成为瓶颈,导致CPU空闲,系统等待磁盘I/O完成。识别和消除瓶颈可以将性能和应用程序吞吐量提高数个数量级。

术语“磁盘”指的是系统的主要存储设备。它们包括磁性旋转磁盘和基于闪存存储的固态硬盘(SSD)。后者主要是为了提高磁盘I/O性能而引入的,它们确实做到了。然而,对于容量和I/O速率的需求也在增加,闪存存储设备也不免遇到性能问题。

本章包括五个部分,前三部分为磁盘I/O分析提供基础,后两部分展示了它在基于Linux和Solaris的系统中的实际应用。这些部分如下:

- 背景介绍了与存储相关的术语、磁盘设备的基本模型和关键的磁盘性能概念。

- 架构提供了存储硬件和软件架构的通用描述。

- 方法论描述了性能分析方法论,包括观察和实验。

- 分析展示了基于Linux和Solaris的系统上进行分析和实验的磁盘性能工具,包括跟踪和可视化。

- 调优描述了示例磁盘可调参数。

上一章讨论了建立在磁盘上的文件系统的性能。

9.1 Terminology

在本章中使用的与磁盘相关的术语包括以下内容:

- 虚拟磁盘:存储设备的仿真。它在系统中显示为单个物理磁盘;然而,它可能由多个磁盘构成。

- 传输:用于通信的物理总线,包括数据传输(I/O)和其他磁盘命令。

- 扇区:传统上大小为512字节的磁盘上的存储块。

- I/O:严格来说,对于磁盘,这仅指读取和写入,并不包括其他磁盘命令。I/O至少包括方向(读取或写入)、磁盘地址(位置)和大小(字节)。

- 磁盘命令:除了读取和写入之外,磁盘可能被命令执行其他非数据传输命令(例如,缓存刷新)。

- 吞吐量:对于磁盘,吞吐量通常指当前的数据传输速率,以每秒字节计量。

- 带宽:这是存储传输或控制器的最大可能数据传输速率。

- I/O延迟:I/O操作的时间,在操作系统堆栈中广泛使用,不仅仅在设备级别。请注意,网络使用此术语的方式不同,延迟是指启动I/O的时间,然后是数据传输时间。

- 延迟异常值:具有异常高延迟的磁盘I/O。

本章还介绍了其他术语。如果需要,词汇表包括基本术语供参考,包括磁盘、磁盘控制器、存储阵列、本地磁盘、远程磁盘和IOPS。另请参阅第2章和第3章中的术语部分。

9.2 Models

以下简单模型说明了磁盘I/O性能的一些基本原理。

9.2.1 Simple Disk

现代磁盘包括一个用于I/O请求的磁盘队列,如图9.1所示。

磁盘接受的I/O请求可能在队列中等待或正在被处理。

这个简单的模型类似于杂货店的结账,顾客排队等待服务。它也非常适合使用排队理论进行分析。

虽然这可能暗示着一个先来先服务的队列,但磁盘控制器可以应用其他算法来优化性能。这些算法可能包括对旋转磁盘进行电梯搜索(请参阅第9.4.1节,磁盘类型中的讨论),或者为读和写I/O分别设置队列(特别是对于基于闪存的磁盘)。

9.2.2 Caching Disk

在磁盘上添加一个缓存允许一些读取请求从更快的内存类型中得到满足,如图9.2所示。这可以实现为包含在物理磁盘设备内部的少量内存(DRAM)。

虽然缓存命中的延迟非常低(良好),但通常仍然会出现缓存未命中,返回带有高磁盘设备延迟的情况。

磁盘上的缓存也可以用于提高写入性能,通过将其用作写回缓存。这意味着在数据传输到缓存之后,但在较慢的传输到持久磁盘存储之前,将写入标记为已完成。与之相对应的术语是写直通缓存,它仅在完全传输到下一级之后才完成写入。

9.2.3 Controller

图9.3展示了一个简单类型的磁盘控制器,它连接了CPU I/O传输和存储传输,并连接了磁盘设备。这些也被称为主机总线适配器(HBAs)。

性能可能会受到这些总线、磁盘控制器或磁盘的限制。有关磁盘控制器的更多信息,请参阅第9.4节《体系结构》。

9.3 Concepts

以下是磁盘性能中的重要概念。

9.3.1 Measuring Time

存储设备的响应时间(也称为磁盘I/O延迟)是从I/O请求到I/O完成的时间。它由服务时间和等待时间组成:

- 服务时间:I/O被积极处理(服务)所花费的时间,不包括在队列中等待的时间。

- 等待时间:I/O在队列中等待被处理的时间。

这些概念如图9.4所示,还有其他相关术语。

响应时间、服务时间和等待时间都取决于它们所测量的位置。以下是对此进行解释,通过描述操作系统和磁盘上下文中的服务时间(这也是一种简化):

在操作系统(块设备接口)的上下文中,服务时间可以被定义为从发出 I/O 请求到磁盘设备的时间,到完成中断发生的时间。它不包括在操作系统队列中等待的时间,并且仅反映磁盘设备对所请求操作的整体性能。

在磁盘的上下文中,服务时间指的是磁盘积极为 I/O 提供服务的时间,不包括在磁盘自身的磁盘队列上等待的任何时间。 服务时间一词源自于磁盘是由操作系统直接管理的更简单的设备时代,因此操作系统知道磁盘何时在积极为I/O提供服务。 现在磁盘有自己的内部队列,操作系统的服务时间包括在设备队列上等待的时间。 这个操作系统度量标准可能更好地被描述为“磁盘响应时间”。

响应时间这个术语也可以从不同的角度应用。 例如,“磁盘响应时间”可能描述从操作系统观察到的服务时间,而“ I/O响应时间”则是从应用程序的角度来看,可能指系统调用层以下的一切(服务时间,所有等待时间和代码路径执行时间)。

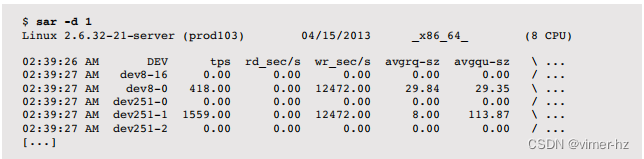

来自块设备接口的服务时间通常被视为磁盘性能的一种度量标准(也是iostat(1)显示的内容); 但是,您应该意识到这是一种简化。 在图9.6中,描绘了一个通用的I/O堆栈,显示了块设备接口下方的三个可能的驱动程序层。 这些任何一个都可以实现自己的队列,或者可能在互斥体上阻塞,从而增加I/O的延迟。 这个延迟包含在从块设备接口测量的服务时间中。

计算时间

通常,操作系统无法直接观察到磁盘服务时间;但是,可以使用IOPS和利用率推断出平均磁盘服务时间:

磁盘服务时间 = 利用率 / IOPS

例如,如果利用率为60%,IOPS为300,则平均服务时间为2毫秒(600毫秒/300 IOPS)。这假设利用率反映了一个只能一次处理一个I/O的单个设备(或服务中心)。磁盘通常可以并行处理多个I/O。

9.3.2 Time Scales

磁盘I/O的时间尺度可以差异巨大,从几十微秒到数千毫秒不等。在时间尺度的最慢端,单个慢速磁盘I/O可能导致应用响应时间不佳;在最快端,磁盘I/O问题可能只会在数量众多时出现(许多快速I/O的总和等于一个慢速I/O)。

为了提供背景信息,表9.1提供了磁盘I/O延迟可能的一般范围的概念。要获取准确和最新的值,请参阅磁盘供应商的文档,并进行您自己的微基准测试。另请参阅第2章《方法论》,了解除磁盘I/O之外的时间尺度。

为了更好地说明涉及的数量级差异,"缩放"列显示了基于虚构的一秒钟内磁盘缓存命中延迟的比较。

这些延迟可能根据环境需求有不同的解释。在企业存储行业工作时,我认为任何超过10毫秒的磁盘I/O都异常缓慢,可能是性能问题的潜在来源。在云计算行业中,对于高延迟有更高的容忍度,特别是在面向网络和客户端浏览器之间已经预期高延迟的Web应用程序中。在这些环境中,磁盘I/O可能只在超过100毫秒(在单个应用程序请求期间或总体上)时成为问题。

这个表格还说明了磁盘可以返回两种类型的延迟:一种是针对磁盘缓存命中的延迟(小于100微秒),另一种是针对未命中的延迟(1–8毫秒或更高,取决于访问模式和设备类型)。由于磁盘将返回这两种延迟的混合,将它们一起表达为平均延迟(正如iostat(1)所做的那样)可能会产生误导,因为这实际上是具有两种模式的分布。请参阅第2章《方法论》中的图2.22,这是一个示例磁盘I/O延迟分布的直方图(使用DTrace测量)。

9.3.3 Caching

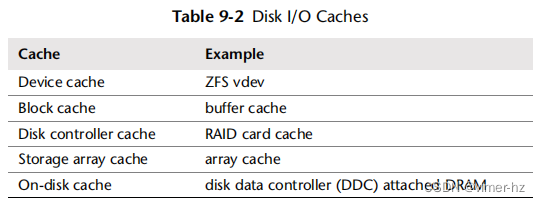

磁盘I/O性能最佳的情况是完全避免磁盘I/O。软件堆栈的许多层次都试图通过缓存读取和缓冲写入来避免磁盘I/O,甚至直到磁盘本身。这些缓存的完整列表在《操作系统》第3章的表3.2中,包括应用程序级别和文件系统级别的缓存。在磁盘设备驱动程序级别及以下,它们可能包括表9.2中列出的缓存。

基于块的缓冲缓存在《文件系统》第8章进行了描述。这些磁盘I/O缓存对于提高随机I/O工作负载的性能尤为重要。

9.3.4 Random versus Sequential I/O

磁盘I/O工作负载可以用随机和顺序两个术语来描述,这取决于I/O在磁盘上的相对位置(磁盘偏移量)。这些术语在第8章《文件系统》中讨论过,涉及到文件访问模式。

顺序工作负载也被称为流式工作负载。流式通常在应用程序级别使用,用于描述“对磁盘”的流式读取和写入。

在磁性旋转盘时代,研究随机与顺序磁盘I/O模式非常重要。对于这些情况,随机I/O会增加额外的延迟,因为磁盘磁头在I/O之间进行寻道并且盘片在其间旋转。如图9.5所示,磁头在扇区1和扇区2之间移动需要进行寻道和旋转(实际路径将尽可能直接)。性能调优涉及识别随机I/O,并尝试通过多种方式消除它,包括缓存、将随机I/O隔离到单独的磁盘以及通过磁盘位置调整以减少寻道距离。

其他类型的磁盘,包括基于闪存的固态硬盘(SSD),通常在随机和顺序I/O模式之间表现不同。根据磁盘的不同,可能会存在一些差异,例如,由于其他因素,如地址查找缓存可能会跨越顺序访问但不跨越随机访问。

请注意,从操作系统中看到的磁盘偏移量可能与物理磁盘上的偏移量不匹配。例如,硬件提供的虚拟磁盘可能会将连续的偏移范围映射到多个磁盘上。磁盘可能会以自己的方式重新映射偏移量(通过磁盘数据控制器)。有时,随机I/O并非通过检查偏移量来识别,而是通过测量增加的服务时间来推断。

9.3.5 Read/Write Ratio

除了识别随机与顺序工作负载之外,另一个特征性指标是读取与写入的比例,指的是IOPS或吞吐量。这可以表示为随时间的比率,以百分比的形式,例如,“系统自启动以来读取占80%”。

了解这个比率有助于在设计和配置系统时。读取率高的系统可能最适合增加缓存。写入率高的系统可能最适合增加更多磁盘以增加最大可用吞吐量和IOPS。

读取和写入本身可能是不同的工作负载模式:读取可能是随机I/O,而写入可能是顺序的(特别是对于写时复制文件系统)。它们也可能展示不同的I/O大小。

9.3.6 I/O Size

平均I/O大小(字节)或I/O大小的分布是另一个工作负载特征。较大的I/O大小通常提供更高的吞吐量,尽管会增加每个I/O的延迟。

I/O大小可能会被磁盘设备子系统改变(例如,量化为512字节的块)。自从应用程序级别发出I/O以来,大小可能已被内核组件(如文件系统、卷管理器和设备驱动程序)进行了膨胀和收缩。请参阅第8章文件系统中第8.3.12节《逻辑与物理I/O》中的膨胀和收缩部分。

一些磁盘设备,特别是基于闪存的,对不同的读写大小表现出非常不同的性能。例如,基于闪存的磁盘驱动器可能会在4KB的读取和1MB的写入时表现最佳。理想的I/O大小可能由磁盘供应商记录,也可以使用微基准测试进行识别。当前使用的I/O大小可以通过观察工具找到(参见第9.6节《分析》)。

9.3.7 IOPS Are Not Equal

由于这些最后三个特性,IOPS并非相等,不能直接在不同设备和工作负载之间进行比较。一个IOPS值单独而言意义不大,不能单独使用来准确比较工作负载。例如,在旋转磁盘上,一个5,000个顺序IOPS的工作负载可能比一个1,000个随机IOPS的工作负载快得多。基于闪存内存的IOPS也很难比较,因为它们的I/O性能通常相对于I/O大小和方向(读或写)而言。

为了理解IOPS,应包括其他细节:随机或顺序、I/O大小、读/写。还应考虑使用基于时间的指标,如利用率和服务时间,这些指标反映了结果性能并且可以更容易地进行比较。

9.3.8 Non-Data-Transfer Disk Commands

除了I/O读取和写入之外,磁盘还可以发送其他命令。例如,具有磁盘缓存(RAM)的磁盘可以被命令将缓存刷新到磁盘。这样的命令不是数据传输;数据先前通过写入命令发送到了磁盘。这些命令可能会影响性能,并导致磁盘被利用,而其他I/O处于等待状态。

9.3.9 Utilization

利用率可以被计算为在一个时间段内磁盘忙于主动执行工作的时间。

利用率为0%的磁盘处于“空闲”状态,而利用率为100%的磁盘则持续忙于执行I/O(和其他磁盘命令)。处于100%利用率的磁盘很可能是性能问题的一个来源,特别是如果它们保持在100%一段时间。然而,任何磁盘利用率都可能导致性能不佳,因为磁盘I/O通常是一个缓慢的活动。

在0%和100%之间可能还存在一个点(比如说,60%),在这个点上,由于排队的可能性增加,磁盘的性能不再令人满意,无论是在磁盘队列上还是在操作系统中。成为问题的确切利用率取决于磁盘、工作负载和延迟要求。在第二章方法论的2.6.5节排队理论中的M/D/1和60%利用率部分有更多信息。

要确认高利用率是否导致应用程序问题,请研究磁盘响应时间以及应用程序是否在此I/O上阻塞。应用程序或操作系统可能会异步执行I/O,因此缓慢的I/O并不直接导致应用程序等待。

请注意,利用率是一个时间段的摘要。磁盘I/O可能会突发发生,特别是由于写入刷新,这可能在长时间间隔内进行摘要时被掩盖。在第二章方法论的2.3.11节利用率中有关于利用率度量类型的进一步讨论。

虚拟磁盘利用率

对于由硬件提供的虚拟磁盘(例如,磁盘控制器提供的),操作系统可能只知道虚拟磁盘何时忙碌,但对其构建所依赖的底层磁盘的性能一无所知。这导致了一种情况,即操作系统报告的虚拟磁盘利用率与实际磁盘情况(并且是违反直觉的)显著不同:

- 包含写回缓存的虚拟磁盘在写工作负载期间可能看起来并不繁忙,因为磁盘控制器立即返回写完成,尽管底层磁盘之后可能忙碌。

- 一个100%繁忙的虚拟磁盘,构建在多个物理磁盘之上,可能能够接受更多的工作。在这种情况下,100%可能意味着某些磁盘一直处于繁忙状态,但并非所有磁盘都一直处于繁忙状态,因此某些磁盘可能处于空闲状态。

出于相同的原因,解释操作系统软件创建的虚拟磁盘(软件RAID)的利用率可能会很困难。然而,操作系统应该也会公开物理磁盘的利用率,可以对其进行检查。

一旦物理磁盘达到100%的利用率并且请求更多I/O,它就会变得饱和。

9.3.10 Saturation

饱和度是排队工作量的度量,超出资源可以提供的范围。对于磁盘设备而言,它可以被计算为操作系统中设备等待队列的平均长度(假设它进行排队)。

这提供了一个超过100%利用率点的性能度量。一个利用率为100%的磁盘可能没有饱和(排队),或者它可能有很多,由于I/O的排队而显著影响性能。

可以假设利用率低于100%的磁盘没有饱和。然而,这取决于利用率间隔:在一个时间段内的50%磁盘利用率可能意味着在其中一半时间内利用率达到100%,而在其余时间内处于空闲状态。任何间隔摘要都可能遇到类似的问题。当需要准确了解发生了什么时,可以使用跟踪来检查I/O事件。

9.3.11 I/O Wait

I/O等待是一个基于每个CPU的性能指标,显示了空闲时间,当CPU调度队列上有线程(处于睡眠状态)被阻塞在磁盘I/O上时。这将CPU的空闲时间分成两部分:一部分是没有任务可执行的时间,另一部分是被阻塞在磁盘I/O上的时间。每个CPU的高I/O等待率表明磁盘可能是一个瓶颈,导致CPU在等待磁盘时处于空闲状态。I/O等待可能是一个非常令人困惑的指标。如果另一个CPU密集型进程出现,I/O等待值可能会下降:CPU现在有任务可执行了,而不是处于空闲状态。然而,尽管I/O等待指标下降,但相同的磁盘I/O仍然存在并阻塞线程。有时,当系统管理员升级应用软件并且新版本更高效、使用的CPU周期更少时,会出现相反的情况,从而暴露了I/O等待。这可能会让系统管理员误以为升级导致了磁盘问题,并使性能变差,但实际上磁盘性能保持不变,CPU性能得到了改善。关于如何在Solaris上计算I/O等待,还存在一些微妙的问题。对于Solaris 10发布版,I/O等待指标已被弃用,并且对于仍需要显示它的工具(为了兼容性),该指标已被硬编码为零。一个更可靠的指标可能是应用线程在磁盘I/O上被阻塞的时间。这捕获了应用线程由于磁盘I/O而遭受的痛苦,而不管CPU可能在做什么其他工作。可以使用静态或动态跟踪来测量此指标。I/O等待仍然是Linux系统上一个流行的指标,尽管它具有令人困惑的性质,但成功地用于识别一种类型的磁盘瓶颈:磁盘繁忙,CPU空闲。解释它的一种方式是将任何等待I/O都视为系统瓶颈的迹象,然后调整系统以将其最小化——即使I/O仍然与CPU利用率同时发生。并发I/O更有可能是非阻塞I/O,不太可能引起直接问题。如I/O等待所指示的非并发I/O更可能是应用阻塞I/O,是一个瓶颈。

9.3.12 Synchronous versus Asynchronous

重要的是要理解,如果应用程序I/O和磁盘I/O是异步操作的话,磁盘I/O延迟可能不会直接影响应用程序性能。这种情况通常发生在写回缓存中,其中应用程序I/O提前完成,而磁盘I/O稍后发出。

应用程序可能会使用预读取来执行异步读取,这可能不会在磁盘完成I/O时阻塞应用程序。文件系统可以自行启动此过程以预热缓存(预取)。

即使一个应用程序正在同步等待I/O,该应用程序代码路径也可能是非关键的并且与客户端应用程序请求异步。

有关更详细的解释,请参阅第8章文件系统中的第8.3.9节“非阻塞I/O”、第8.3.5节“预读取”、第8.3.4节“预取”和第8.3.7节“同步写入”。

9.3.13 Disk versus Application I/O

磁盘I/O是各种内核组件(包括文件系统和设备驱动程序)的最终结果。导致这种磁盘I/O的速率和数量与应用程序发出的I/O不匹配的原因有很多。这些原因包括: