利用ollama 与deepseek r1大模型搭建本地知识库

1.安装运行ollama

ollama下载

https://ollama.com/download/windows

验证ollama是否安装成功

ollama --version

访问ollama本地地址:

http://localhost:11434/

出现如下界面

ollama运行模型

ollama run llama3.2

ollama常用操作命令

启动 Ollama 服务:

ollama serve

停止 Ollama 服务:

ollama stop

重启 Ollama 服务:

ollama restart

更新 Ollama:

ollama update

拉取模型:

ollama pull <model-name>

eg: ollama pull llama2

列出本地模型:

ollama list

2.安装deepseek-r1模型

选择合适本地硬件的deepseek-r1模型

https://ollama.com/library/deepseek-r1

运行deepseek-r1:8b模型

allama run deepseek-r1:8b

运行成功进行提问

3.安装Open WebUI :

pip install open-webui

启动 Open WebUI:

open-webui serve

访问open webui:

http://localhost:8080

出现如下界面,访问成功:

4.搭建本地知识库

安装本地客户端 cherrystudio或RAGFlow或dify:

Cherry Studio - 全能的AI助手

安装词嵌入模型:

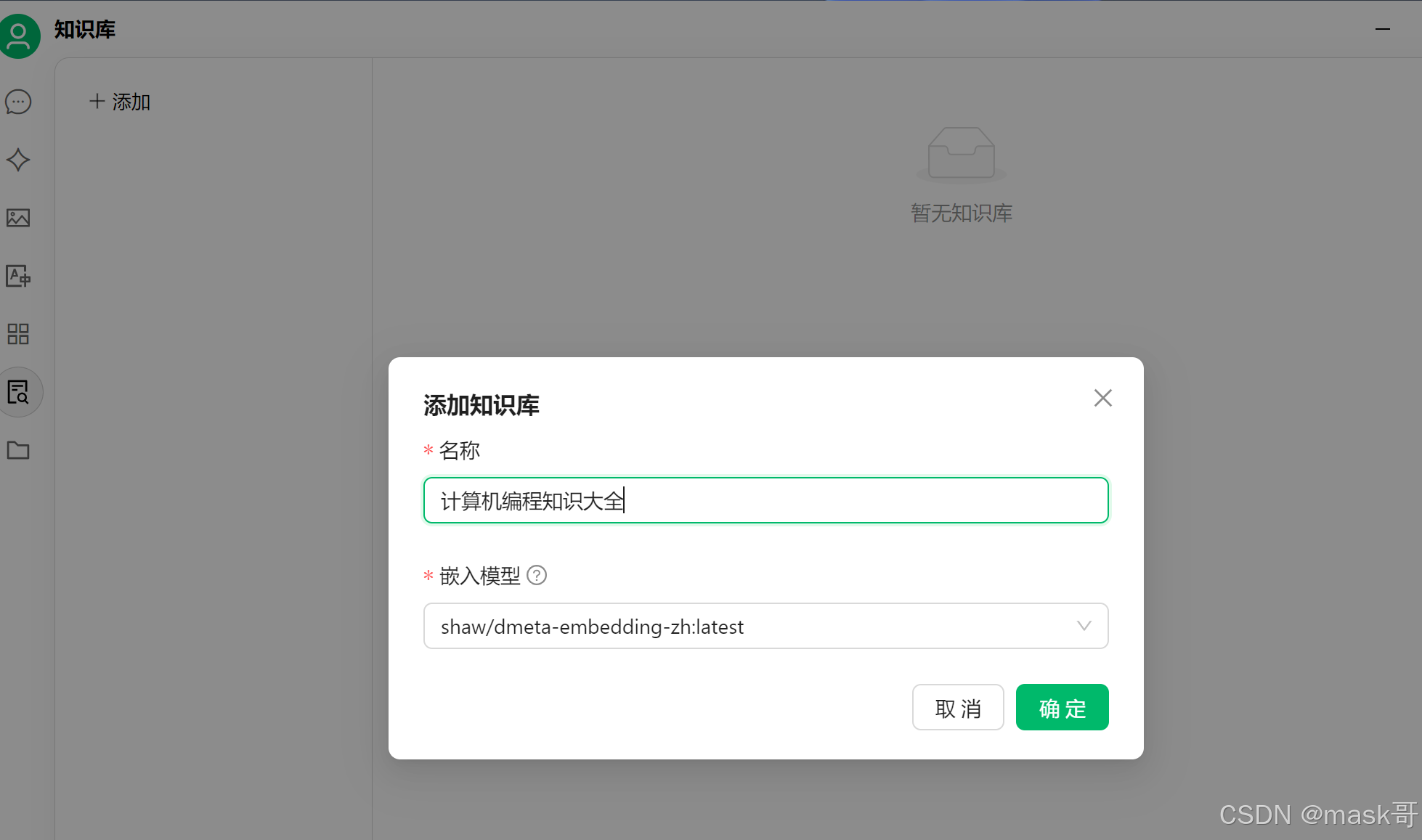

从这个地址搜索 https://ollama.com/shaw/dmeta-embedding-zh

ollama pull shaw/dmeta-embedding-zh

配置 cherrystudio:

1.配置模型与ollama本地访问地址

2.设置默认模型

3.配置知识库

4.导入自己知识体系

5.选择自己搭建的知识库,使用