Ollama+DeepSeek R1+AnythingLLM训练自己的AI智能助手

1.下载Ollama安装

1.1.安装Ollama

Ollama官网:Ollama

下载Ollama,点击“Download”按钮。

根据电脑操作系统,下载合适的版本即可。

下载完成后点击安装,完成后安装窗口会自动关闭,你的系统托盘图标会出现一个Ollama图标。

1.2.Ollama配置环境变量

下载Ollama后点击安装即可,Ollama会默认将下载的模型安装到C盘,一般我们需要将其改到其他盘,避免下载模型过多过大,将C盘占满。

找到“编辑系统环境变量”。

点击后,选择“环境变量”。

在“系统环境变量”选择新增;

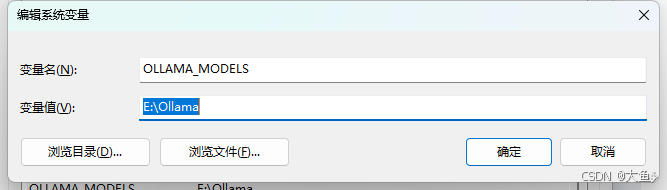

1.2.1.配置Ollama的模型存储路径

默认是C盘,这里我们更改ollama的模型存储为E盘,先打开电脑的E盘创建一个名为“Ollama”的文件夹。然后接上面弹出来的对话框中输入变量名和变量值:

变量名:OLLAMA_MODELS

变量值:E:\Ollama

2.2.配置可被远程访问

监听地址,默认为127.0.0.1(仅限本机访问)。如需远程访问,可设置为0.0.0.0,我们在学习的情况下一般仅限本机访问即可。

变量名:OLLAMA_HOST

变量值:0.0.0.0

修改环境变量后,重启一下Ollama。

1.2.3.重启Ollama

右键这个羊驼图标,选择“Quit Ollama”。

然后找到Ollama应用启动即可。

2.本地化DeepSeek R1 模型

可以在Ollama官网,点击Models找打DeepSeek-R1模型。

点击deepseek-r1模型后,可以查看deepseek-r1模型的详细信息,也有对应的安装脚本。

deepseek-r1有很多版本,我们可以选择其中一个下载。

复制这个命令,在我们的电脑命令窗口里面执行即可。

windows电脑搜索cmd,即可打开命令窗口。

然后复制ollama下载模型命令,在窗口中执行即可开始下载:

ollama run deepseek-r1:7b

等待模型下载完毕。

到此我们的deepseek-r1:7b模型本地化安装完毕,我们可以通过命令行和它简单进行几句对话。

3.下载AnythingLLM与安装

官网地址:Windows Installation ~ AnythingLLM

注意:操作系统需要Windows10+

下载完毕后,我们双击开始安装。

等待其安装完毕即可。

主界面效果如下:

接下来我们开始使用AnythingLLM。

4.AnythingLLM使用

因为我们已经下载Ollama和DeepSeek-R1,所以可以从开始后直接跳到创建工作区。

因为我们需要使用的是本地的模型,所以这里可以选择Ollama。

因为我们需要使用的是本地的模型,所以这里可以选择Ollama。

然后会提示我们选择本地模型,然后我们选择前面下载的:deepseek-r1:7b

然后会提示我们选择本地模型,然后我们选择前面下载的:deepseek-r1:7b

注意后面的Max Token,我们尽可能改大些,让其输出内容可以更多。但是也要根据自己的电脑配置进行合理的配置。

注意:只有理解其对性能和资源使用的影响时才更改此设置。

基本设置:Ollama 自动将上下文限制在 2048 个令牌,减少了 VRAM 的使用。适合大多数用户。

最大值:使用整个上下文窗口(最高 令牌数)。可能会显著增加 VRAM 使用量。

意思是如果配置 Base(Default),会使用 Ollama 默认的 2048 token,主要处于性能考虑。整体效果与 Maximum 对比有差距。 然后保存配置即可。

接下来我们看看效果

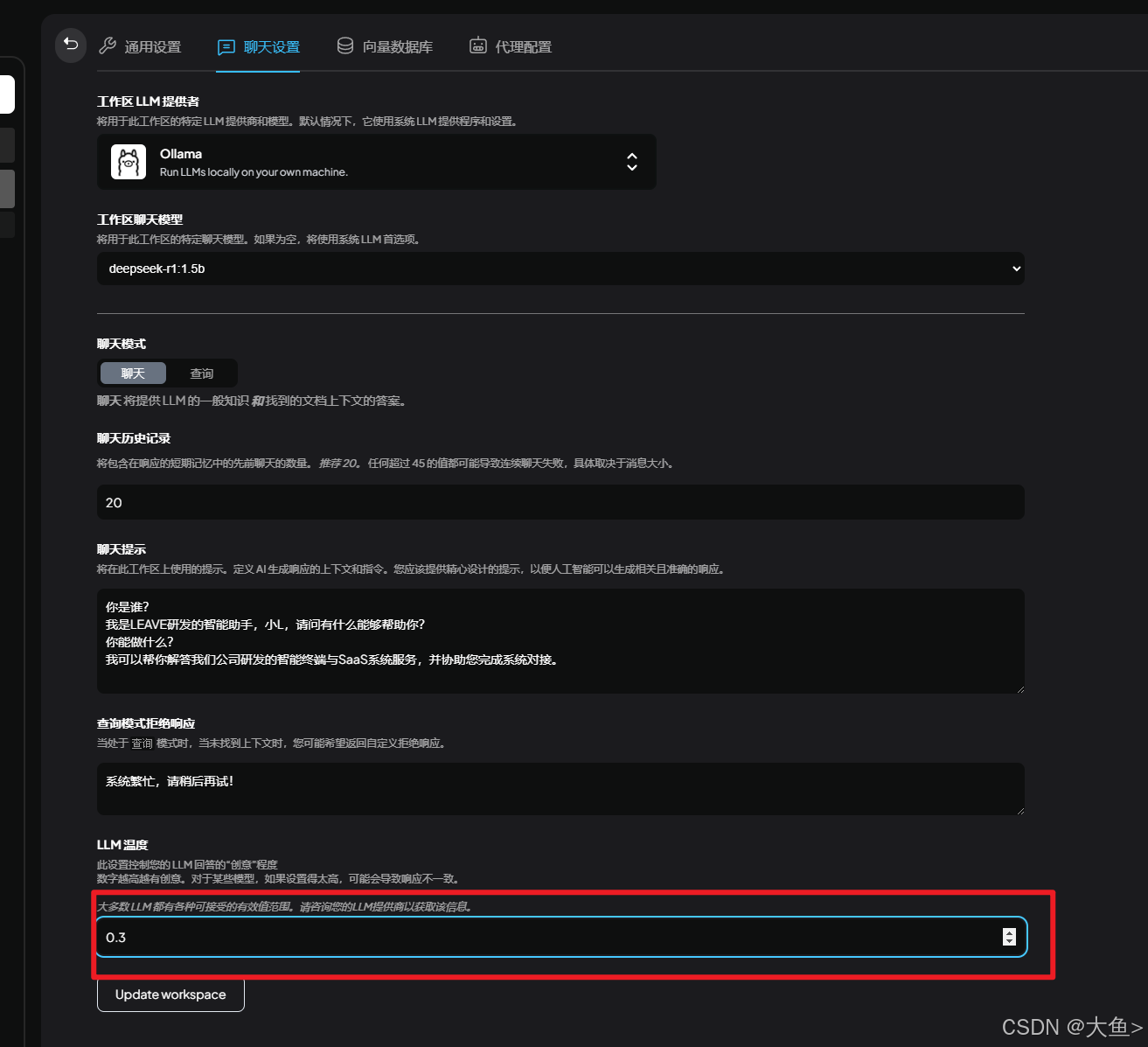

其实我的本意问它是谁,结果回答和不满意,而且思索过程居然是英文的。我们只需要将聊天设置里面的聊天提示用中文增加一下提示即可。

然后我们再看效果:

整体效果很不错,效果也令人满意,接下来我们可以上传一些自定义的知识让其回答。

5.导入本地化知识

点击这个上传按钮可以开始添加些自定义的知识库。

首先我们在上传之前先测试一下是否能回答我们专有知识。

接下来我们上传知识文档

最后注意一定要标记,否则不会被引用。

这里插入一个细节,如果我们想要模型输出的结果更加偏向于我们上传的文档,可以调整一下LLM温度和向量数据库中文档相似性阈值

然后我们再试试。

显然已经知道了些东西,虽然准确性还有待提升。

后续我会持续更新,介绍一下如何接入外部向量数据库、提供远程访问、Linux部署、以及我们怎么慢慢将助手训练的更专业等等。