大白话讲解:多模态大模型综述,通俗易懂!

多模态大型语言模型(Multimodal Large Language Models, MLLM)的出现是建立在大型语言模型(Large Language Models, LLM)和大型视觉模型(Large Vision Models, LVM)领域不断突破的基础上的。

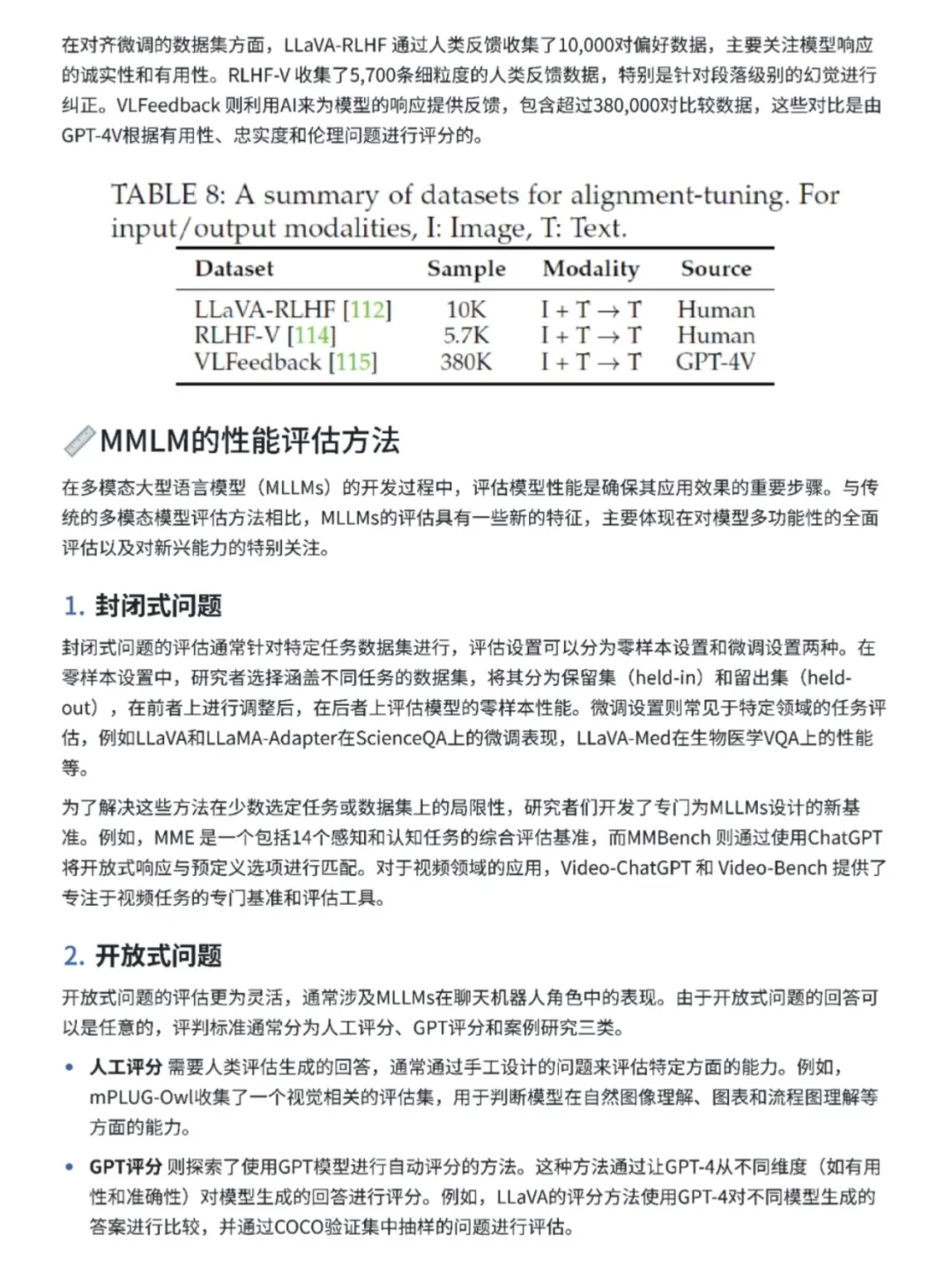

这里给大家总结了多模态大模型的结构,训练,评估方法以及幻觉问题的解决办法,通俗易懂!!

多模态大型语言模型(Multimodal Large Language Models,MLLM)的出现是建立在大型语言模型(Large Language Models, LLM)和大型视觉模型(Large Vision Models,LVM)领域不断突破的基础上的。随着LLM在语言理解和推理能力上的逐步增强,指令微调、上下文学习和思维链工具的应用愈加广泛。然而,尽管LLM在处理语言任务时表现出色,但在感知和理解图像等视觉信息方面仍然存在明显的短板。与此同时,LVM在视觉任务(如图像分割和目标检测)上取得了显著进展,通过语言指令已能够引导模型执行这些任务,但推理能力仍有待提升。

MMLM的基本结构

典型的多模态大型语言模型(MLLM)通常由三个主要组件构成:预训练的多态编码器、预训练的LLM(大型语言模型)、以及连接这两者的多模态接口。多模态编码器负责处理不同模态的输入信号,比如视觉信号(图像编码器)或语音信号(音频编码器);LLM则负责对这些经过编码处理的信号进行理解和推理。多模态接口则起到桥梁作用,使得不同模态的信息能够在模型中有效对齐。此外,一些MLLM还配备了生成器,能够输出文本之外的其他模态内容,如图像或音频。

预训练的多模态编码器

1.1 模态编码器的功能与选择

模态编码器在MLLM中承担着将原始的多模态信息(如图像或音频)转换为紧凑表示的关键角色。与从零开始训练编码器相比,常见的做法是采用已经预训练的编码器,尤其是那些在大规模图像-文本对上预训练过的模型。例如,CLIP的视觉编码器部分就是一个经典的选择,其能够将图像信息有效转化为向量表示,并与文本信息对齐。不同的模型在编码器的选择和优化上各有侧重。

EVA-CLIP编码器

MiniGPT-4采用了EVA-CLIP编码器,这种编码器在性能上优于标准的CLIP,同时所需的训练成本更任。这主要归功于以下三个改进:首先,EVA-CLIP通过使用EVA模型的预训练权重来

初始化图像编码器,从而提升了起始性能;其次,使用了LAMB优化器,这种优化器特别适用于大批量训练,能够通过自适应元素级更新和层级学习率来提高训练效率并加速模型的收敛;最后,采用了FLIP技术,在训练过程中随机遮蔽50%的图像标记,从而大幅度减少了时间复杂度,使得批量大小可以增加一倍而无需额外的内存开销。

此外,EVA模型还通过一种名为MaskImage Modeling的任务在更大数据集上进行了训练,它将遮蔽部分的图像与CLIP模型对应位置的输出进行比对,从而在保持语义学习的同时,也能让模型学习到几何结构。EVA的这种训练方式证明了其能够有效扩展模型参数至十亿量级,并在广泛的下游任务中展现出色的性能。

基于卷积的ConvNext-L编码器

0sprey选择了基于卷积的ConvNext-L编码器,这种编码器能够利用更高分辨率和多层次特征,特别是在开放词汇分割任务中展现了较高的效率。在原文中提到,0sprey是基于像素级别的任务,如果直接使用ViT模型作为编码器,会受到计算负担的限制,图片大小通常只支持224或336。而基于CNN的编码器能够在支持高分辨率的同时保持较高的训练效率和推理速度,而不会牺牲性能。

无编码器的架构

Fuyu-8b就是采用了纯解码器转换器,图像块被线性投影到转换器的第一层,绕过了嵌入查找的过程,将普通Transformer解码器视为图像转换器。这样的设计使得Fuyu-8b对灵活输入的分辨率具有强大的适应性。

1.2 模态编码器的优化策略

在选择多模态编码器时,研究人员通常会考虑分辨率、参数规模和预训练语料库等因素。研究表明,使用更高分辨率的图像输入能够显著提升模型的表现。为了实现这一点,不同的模型采用了多种策略来优化编码器。

直接缩放输入分辨率

Qwen-VL和LLaVA-1.5都通过将图像分割成更小的图像块来提高模型的输入分辨率。具体而言,LLaVA-1.5使用了CLIPViT-L-336px编码器,并发现高分辨率能够提升模型性能。为了进一步优化,该模型将图像分割成视觉编码器原本训练时分辨率的小图像块,并分别对其进行编码,然后将这些特征图组合成一个大特征图,最终输入到LLM中。这种方式不仅保留了高分辨率的细节,还通过降采样图像的特征与合并后的特征图相结合,提供了全局上下文,从而提高了模型对任意分辨率输入的适应性。

Qwen-VL和LLaVA-1.5都通过将图像分割成更小的图像块来提高模型的输入分辨率。具体而言,LLaVA-1.5使用了CLIPViT-L-336px编码器,并发现高分辨率能够提升模型性能。为了进一步优化,该模型将图像分割成视觉编码器原本训练时分辨率的小图像块,并分别对其进行编码,然后将这些特征图组合成一个大特征图,最终输入到LLM中。这种方式不仅保留了高分辨率的细节,还通过降采样图像的特征与合并后的特征图相结合,提供了全局上下文,从而提高了模型对任意分辨率输入的适应性。

这份《多模志大模型综述》已经上传CSDN,还有完整版的大模型 AI 学习资料,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

PDF书籍: 完整版本链接获取

👉[CSDN大礼包🎁:《

多模志大模型综述》免费分享(安全链接,放心点击)]👈