时间序列8个基准Baseline模型及其详细解读

我是从去年11月份开始,选定时间序列预测这个方向,准备在工作之余继续独立进行一些科学研究。选定这个方向是因为我对金融量化一直挺感兴趣,希望能把时间序列中的深度学习算法模型,用到金融数据。现在看来,我太过于理想化了,金融数据的非平稳性,使得这以上两个问题有本质的区别。至少到目前为止,我的“金融数据深度学习建模”的想法还未实现。

但是,在近半年的时间里,我陆续阅读了包括:Transformer、Informer、NS Transformer、Patch TST、PITS、Itransformer、Crossformer、TimesNet、FEDformer、Dlinear等论文,并对模型做了比较详细的解读。梳理下来我发现这些论文构成了时间序列研究绕不开的baseline,也是任何想从事时序研究的人必读的论文。分享过程中,我收获了不少素未谋面的研究者的鼓励,与大家留言交流的过程更受益匪浅,这是我未曾预料到的收获。

本文后续篇幅从以上8个模型挑选了部分代表性baseline进行简单介绍,如果需要每篇论文的详细解读,可以从最后给出的链接挑选阅读。另外,未来我计划持续跟进时间序列高水平论文,除了新SOTA的模型外,也会选取:时序模型可解释性、轻量化、以及与前沿技术如Diffusion、大模型结合的文章进行解读。同时也在考虑做代码的解读分享,与诸君共勉,敬请期待!

1

Patch TST

论文标题:A TIME SERIES IS WORTH 64 WORDS: LONG-TERM FORECASTING WITH TRANSFORMERS(ICLR2023)

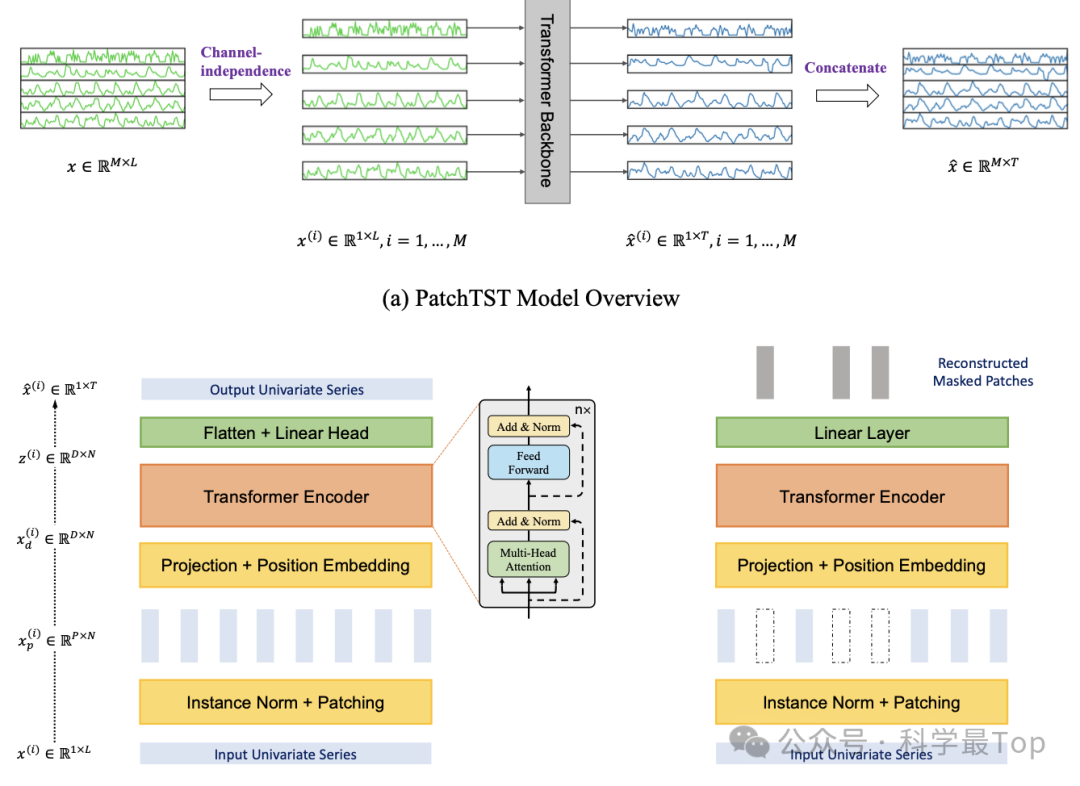

Patch TST发表于ICLR23,无疑是近期时间序列领域绕不开的存在,数据的Patch已成为时序模型的基本操作。它基于两个关键组成部分:(i)将时间序列分割成子序列级别的patch,作为输入token提供给 Transformer;(ii)通道独立性,每个通道包含一个单变量时间序列,共享相同的嵌入和 Transformer 权重。patch的优势在于:保留了局部语义信息;更低的计算和内存使用量;模型可以关注更长的历史信息。PatchTST显著提高了时序预测的准确性,取得了 SOTA。

2

Itransformer

论文标题:ITRANSFORMER : INVERTED TRANSFORMERS ARE EFFECTIVE FOR TIME SERIES FORECASTING(ICLR2024)

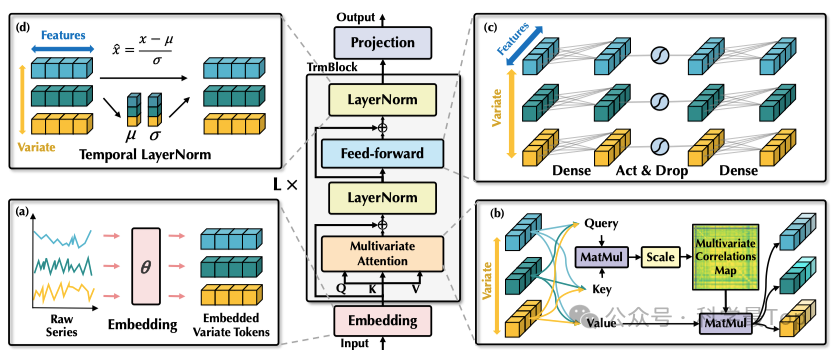

ITRANSFORMER发表于ICLR24,这是一篇热度很高,但是讨论比较激烈的论文。,本质上论文是对数据的维度做了调整,对模型结构本身并无改进,讲故事的能力值得大家学习。Itransformer采取了一种倒置时间序列的做法。具体是将每个变量的整个时间序列独立地嵌入为token,作者称这是 Patch TST的极端情况。相较于已有的基于Transformer的时序工作,本文工作扩大了局部感受视野。通过倒置,每个变量最终嵌入的token聚合了序列的全局特征表示,这可以更加以变量为中心,并且更好地利用注意力机制来进行多变量相关分析。

3

DLinear/NLinear

论文标题:Are Transformers Effective for Time Series Forecasting?(AAAI2023)

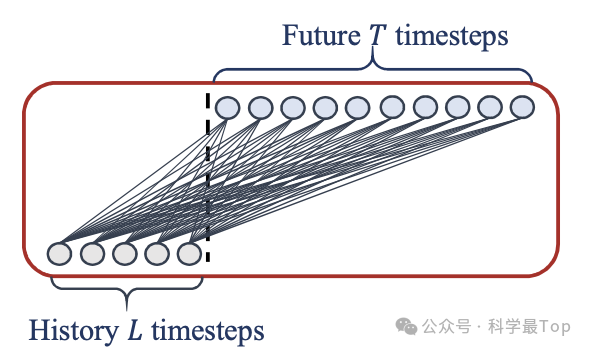

作者认为由于Transformer的自注意力机制是对称的(置换不变性),并且在计算注意力权重时不考虑序列中的位置信息,因此无法有效地捕捉时间序列中的时序依赖关系,导致时间信息的丢失。作者据此提出一组非常简单的一层线性模型,命名为LTSF-Linear (NLinear和DLinear)。DLinear通过特定的分解方法(如移动平均核等)将原始时间序列数据分解为趋势分量和季节性分量。然后,对这两个分量分别应用一层线性模型进行学习和预测。NLinear是另一个线性模型的变体,它采用了不同的预处理方法。在九个真实数据集上的实验结果表明,LTSF-Linear出人意料地在所有情况下都优于现有的复杂Transformer-based LTSF模型,并且领先幅度很大!

4

Crossformer

论文标题:CROSSFORMER : TRANSFORMER UTILIZING CROSS DIMENSION DEPENDENCY FOR MULTIVARIATE TIME SERIES FORECASTING(ICLR2023)

如果你在考虑从注意力或多尺度的角度做一些改进,那Crossformer就是一篇非常典型的在transformer基础上魔改注意力机制的文章,论文质量很高值得学习。(但我个人认为时间序列中的多尺度、注意力基本已经做到头了)

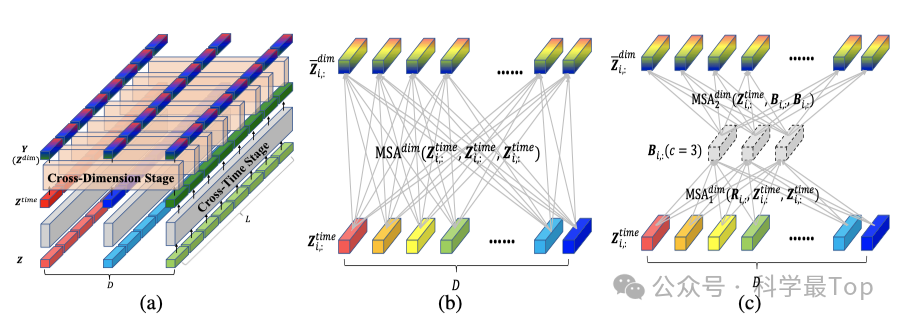

现有的基于 Transformer 的模型主要集中在建模时间依赖关系(跨时间依赖),但往往忽视了不同变量之间的依赖关系(跨维度依赖),而这对于 MTS 预测至关重要。Crossformer利用跨维度依赖关系进行 MTS 预测,通过维度分段式(DSW)嵌入将输入的 MTS 嵌入到二维向量数组中,以保留时间和维度信息。然后,作者还提出了两阶段注意力(TSA)层,以有效地捕获跨时间和跨维度的依赖关系。利用 DSW 嵌入和 TSA 层,Crossformer 建立了一个分层编码器-解码器(HED),以利用不同尺度上的信息进行最终的预测。对六个真实世界数据集的广泛实验结果显示,Crossformer 相对于先前的最新技术具有很高的有效性。

欢迎大家关注我的公众号【科学最top】,专注于时序高水平论文解读。