OpenAI 的最强模型 o1 的“护城河”失守?谷歌 DeepMind 早已揭示相同原理

发布不到一周,OpenAI 的最新模型 o1 的“护城河”似乎已经失守。

近日,有人发现谷歌 DeepMind 早在今年 8 月发表的一篇论文,揭示了与 o1 模型极其相似的工作原理。

这项研究指出,在模型推理过程中增加测试时的计算量,比简单地扩展模型参数更有效。基于论文中提出的计算最优(compute-optimal)测试时计算扩展策略,规模较小的基础模型在某些任务上甚至可以超越一个规模大14倍的模型。

有网友惊呼:这几乎就是 OpenAI o1 的原理!

众所周知,OpenAI CEO 山姆·奥特曼(Sam Altman)喜欢走在谷歌的前面。那么,OpenAI 这次抢先发布 o1 的 preview 版本,难道就是因为他们意识到谷歌已经在研究这个方向了吗?

没有护城河,也不可能有护城河

这引发了一些人的感慨:谷歌在内部文件中曾经说过,没有任何一家企业拥有“护城河”,OpenAI 也不例外。这次的事件似乎再次印证了这一观点。

在这个充满变数的领域,模型发布的速度成为了关键因素。就在大家对 o1 争相讨论时,OpenAI 已经宣布将 o1-mini 的运行速度提高了7倍,并且每天可供使用50次;o1-preview 的使用限制也提升至每周50次。

谷歌 DeepMind:测试时计算更优

谷歌 DeepMind 的这篇论文标题为:优化 LLM 测试时计算比扩大模型参数规模更高效。

研究团队提出的核心思想源于对人类思维模式的观察。面对复杂问题时,人类往往需要更长的时间来思考并改进决策。那么,大型语言模型(LLM)是否也可以利用额外的测试时计算来提升性能呢?

一些先前的研究已经证明,这种方法确实可行,但效果较为有限。谷歌团队的目标是探索,在使用有限的额外推理计算时,能在多大程度上提升模型性能。

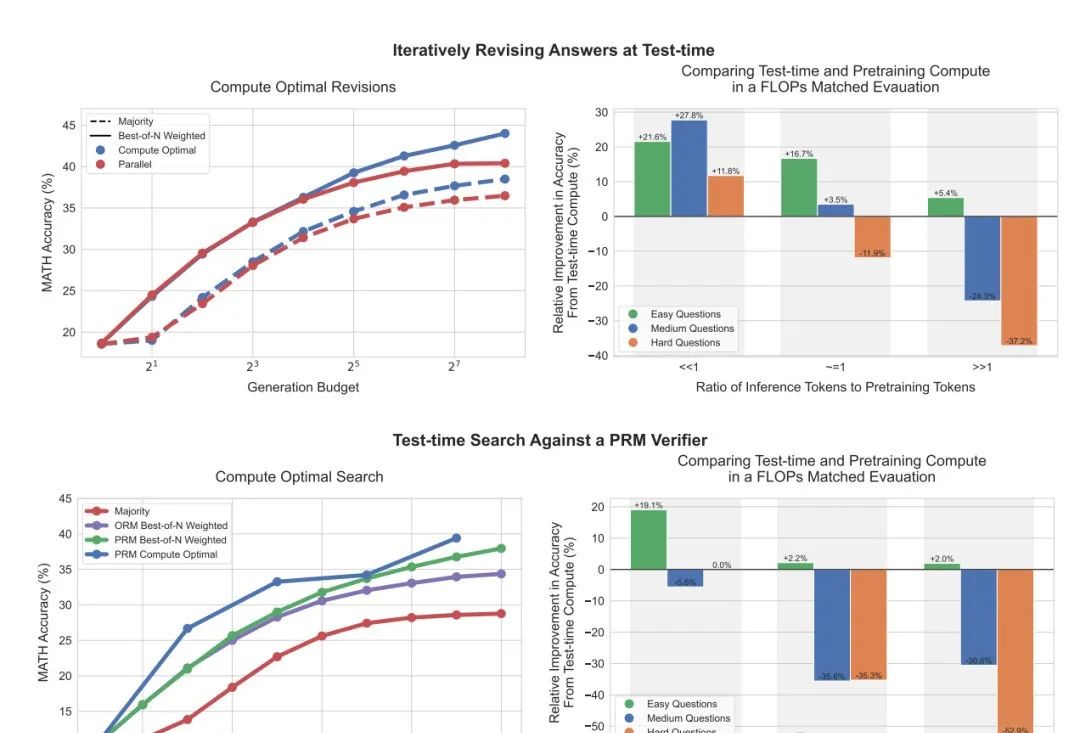

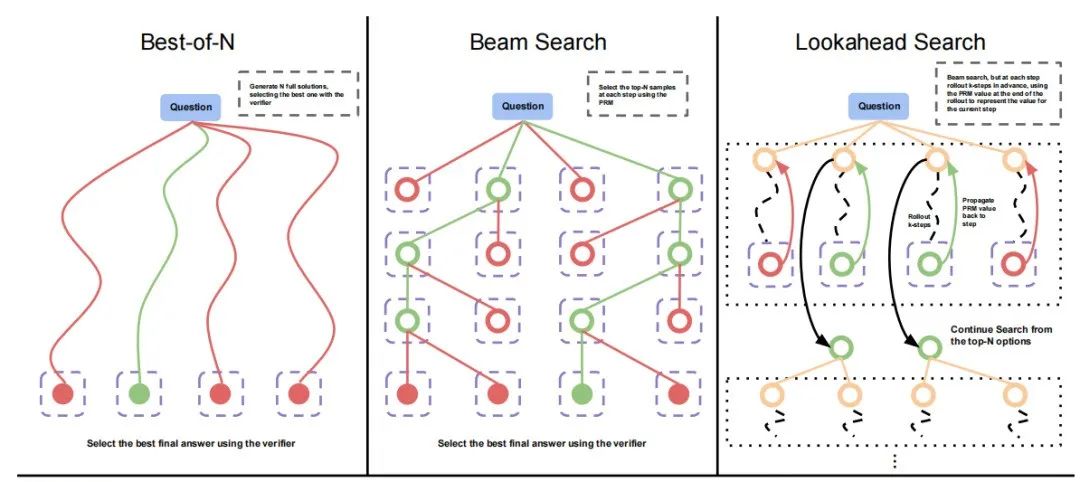

为此,他们设计了一组实验,使用 PaLM2-S* 在 MATH 数据集上进行了测试,主要分析了两种方法:

-

迭代自我修订:让模型多次尝试回答一个问题,在每次尝试后对答案进行修订以期获得更好的结果。

-

搜索:模型生成多个候选答案,然后选择最佳答案。

实验结果显示,使用自我修订方法时,随着测试时计算量的增加,标准最佳 N 策略(Best-of-N)与计算最优扩展策略之间的差距逐渐拉大。使用搜索方法,计算最优扩展策略在初期表现出明显优势,并在某些情况下能以仅1/4的计算量达到与最佳 N 策略相同的效果。

在计算量与预训练计算相当的情况下,团队将 PaLM 2-S*(采用计算最优策略)与一个不进行额外推理、规模大14倍的预训练模型进行了对比。结果表明,当推理 tokens 远少于预训练 tokens 时,使用测试时计算策略的效果更佳。然而,随着比率增加,或在更难的问题上,预训练模型的表现仍然更好。

研究还表明,在计算量有限的情况下,使用计算最优策略最多可节省 4 倍的计算资源。

对比 OpenAI o1:原理如出一辙

对比 OpenAI 的 o1 模型,这篇研究几乎得出了相同的结论。o1 模型通过强化学习和思维链的不断完善,在推理时采取不同的策略,并能够认识和纠正自己的错误。随着更多的强化学习和延长思考时间,o1 的性能持续提升。

不同的是,OpenAI 更快地发布了该模型,而谷歌则在 PaLM2 之后尚未将其更新至 Gemini2。

网友感慨:护城河只剩下硬件了?

这一新发现不禁让人想起去年谷歌内部文件中提出的观点:“我们没有护城河,OpenAI 也没有。开源模型可以打败 ChatGPT。”

如今看来,各家科技巨头的研究速度都非常迅猛,谁都无法保证自己始终领先。唯一可能的护城河,似乎只剩下硬件了。

因此,有人猜测,这或许是为什么马斯克近期积极建立自己的算力中心的原因。目前,英伟达在算力领域拥有绝对主导地位。但如果谷歌或微软开发出更具优势的定制芯片,情况又将如何呢?

值得注意的是,不久前有消息称,OpenAI 正在研发首颗专属芯片,并将采用台积电最先进的 A16 纳米级工艺,专为 Sora 视频应用打造。这进一步显示,当前的大模型竞争不仅仅在于模型本身,硬件资源和算力也成了决定胜负的关键因素。

谷歌 DeepMind 的研究表明,通过增加测试时计算量,可以让规模较小的模型在某些任务上媲美甚至超越更大规模的模型。这一原理与 OpenAI 的 o1 模型不谋而合,体现了在 AI 领域中“思考时间”与“性能提升”之间的关系。

然而,谁将最终在这场竞争中胜出,目前仍是未知数。对于各大科技公司而言,硬件和算力正逐渐成为一场没有硝烟的战争的新战场。

参考链接:

https://www.reddit.com/r/singularity/comments/1fhx8ny/deepmind_understands_strawberry_there_is_no_moat/

ChatGPT-4o需要直接私信!!!