GpuMall智算云:QwenLM/Qwen1.5/Qwen1.5-7B-Chat

Qwen 是阿里巴巴集团 Qwen 团队的大型语言模型和大型多模态模型系列,现在大型语言模型已经升级到 Qwen1.5 版本。

GpuMall智算云 | 省钱、好用、弹性。租GPU就上GpuMall,面向AI开发者的GPU云平台

无论是语言模型还是多模态模型,都在大规模的多语言和多模态数据上进行了预训练,并在优质数据上进行了后训练,以符合人类偏好。Qwen 具备自然语言理解、文本生成、视觉理解、音频理解、工具使用、角色扮演、扮演 AI 代理等功能。#autodl#恒源云#矩池云#算力云#恒源云 实例迁移#autodl 官网#autodi#GpuMall#GPU云#AutoDL#AotuDL 算力云#GpuMall智算云#AI#大数据#算力租赁#大模型#深度学习#人工智能#算力变现

GpuMall智算云 | 省钱、好用、弹性。租GPU就上GpuMall,面向AI开发者的GPU云平台![]() https://gpumall.com/image-details?shareImageId=SIMGEzvrcMTMjNjV&comment

https://gpumall.com/image-details?shareImageId=SIMGEzvrcMTMjNjV&comment

最新版本 Qwen1.5 具有以下特点:

- 拥有 6 种模型尺寸,包括 0.5B、1.8B、4B、7B、14B 和 72B;

- 每种尺寸都有基础模型和聊天模型,聊天模型符合人类偏好;

- 基础模型和聊天模型均支持多语言;

- 稳定支持所有尺寸模型的 32K 上下文长度;

- 支持工具使用、RAG、角色扮演和扮演 AI 代理。

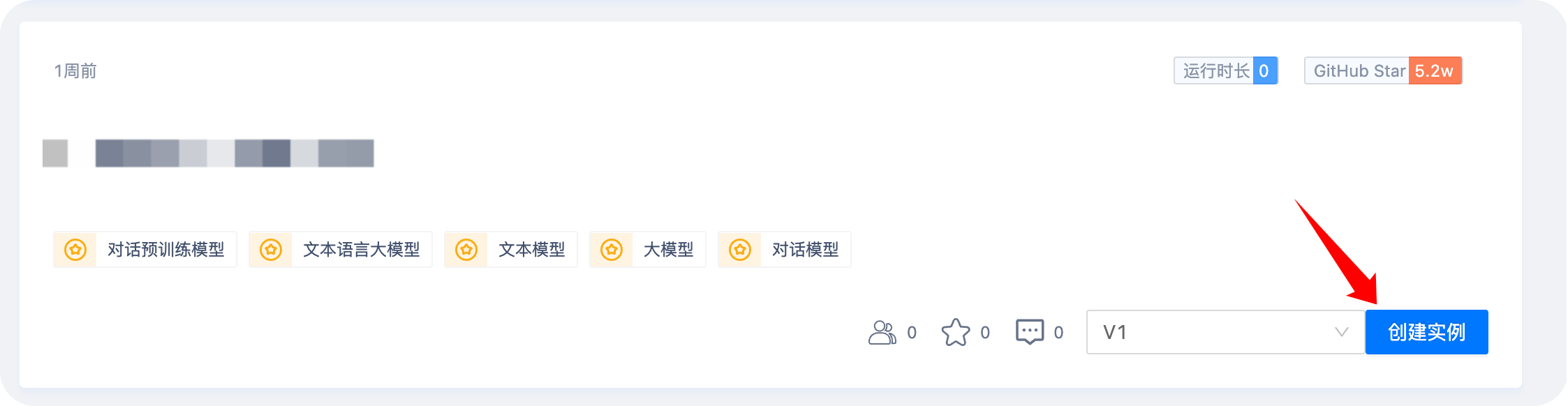

1. 选择 Qwen1.5-7B-Chat 镜像创建实例

选择高可用云

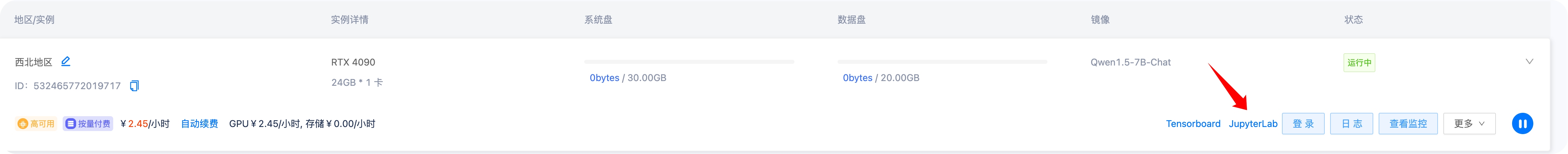

2. 通过 JupyterLab 登陆实例

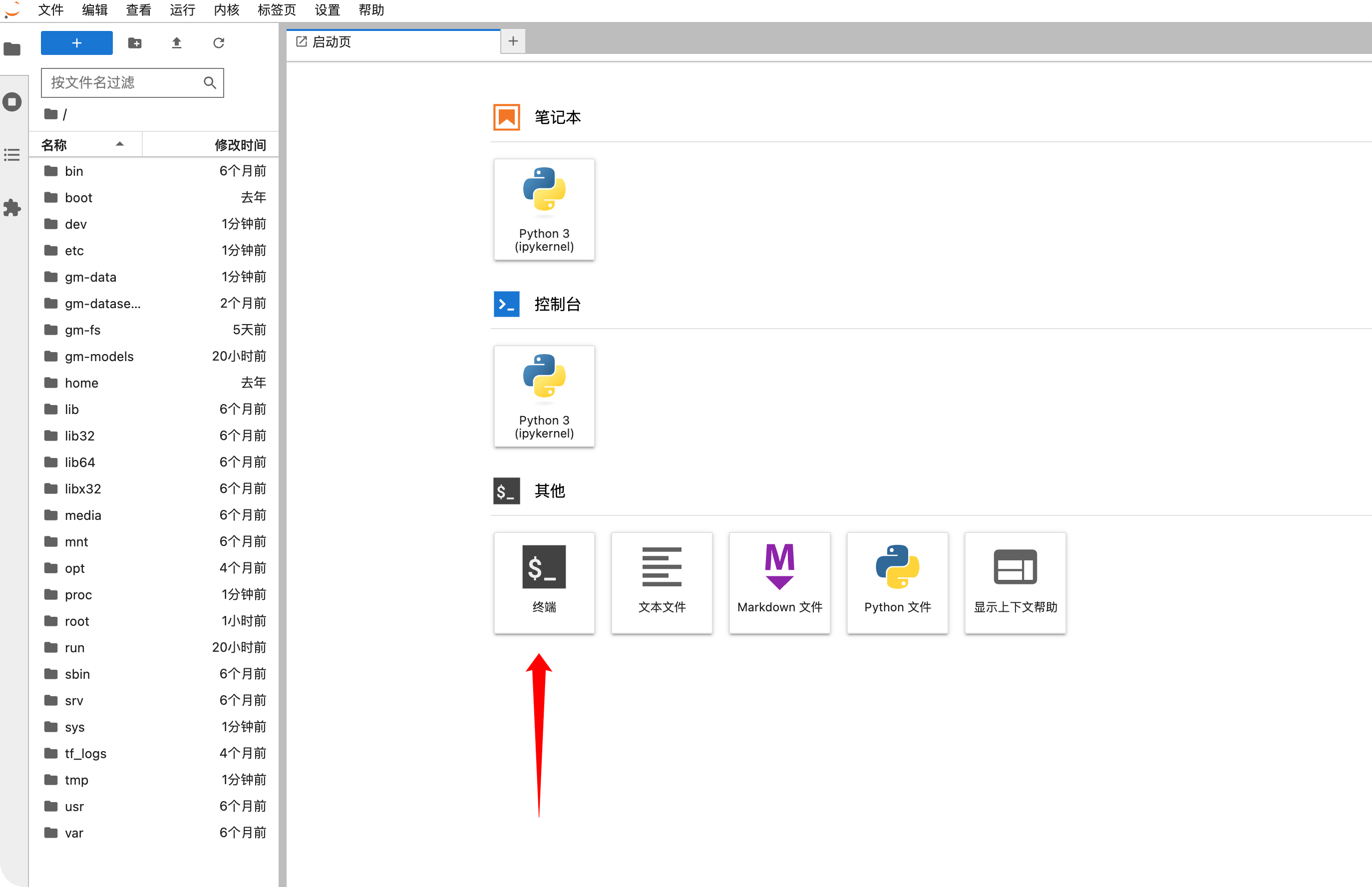

打开终端

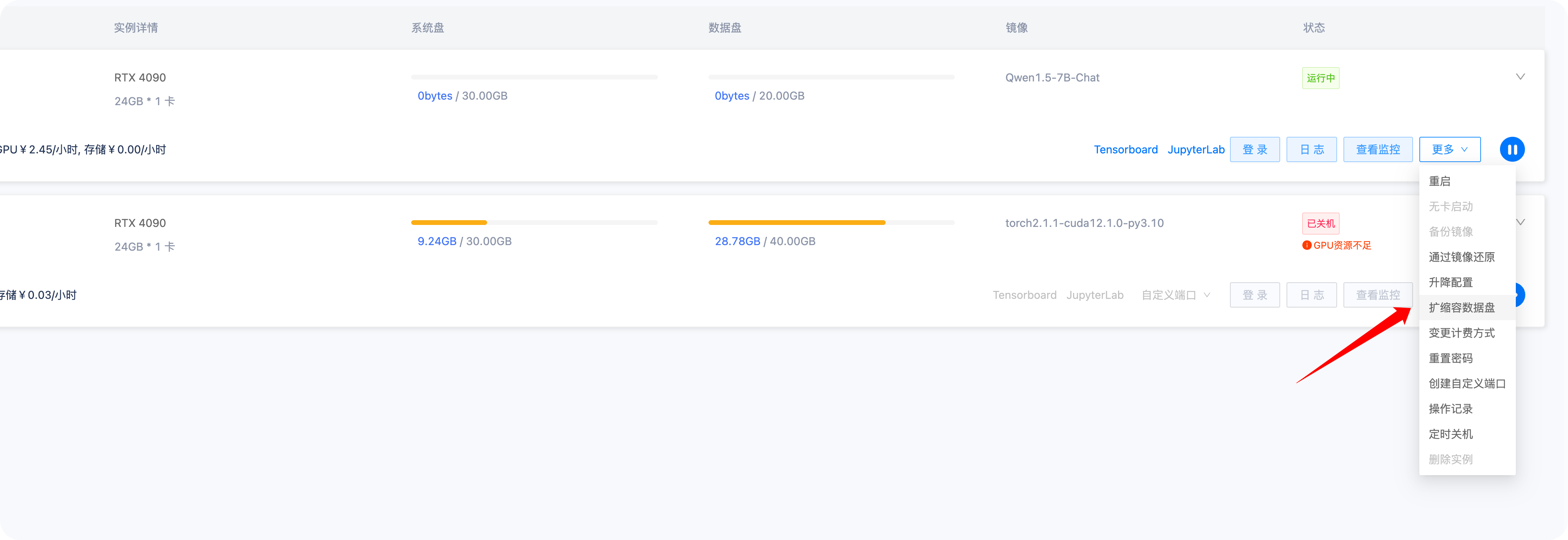

3. 实例数据盘扩容

点击更多-扩容数据盘

Qwen1.5-7B-Chat模型大小为29G,建议扩容至40G来存储模型

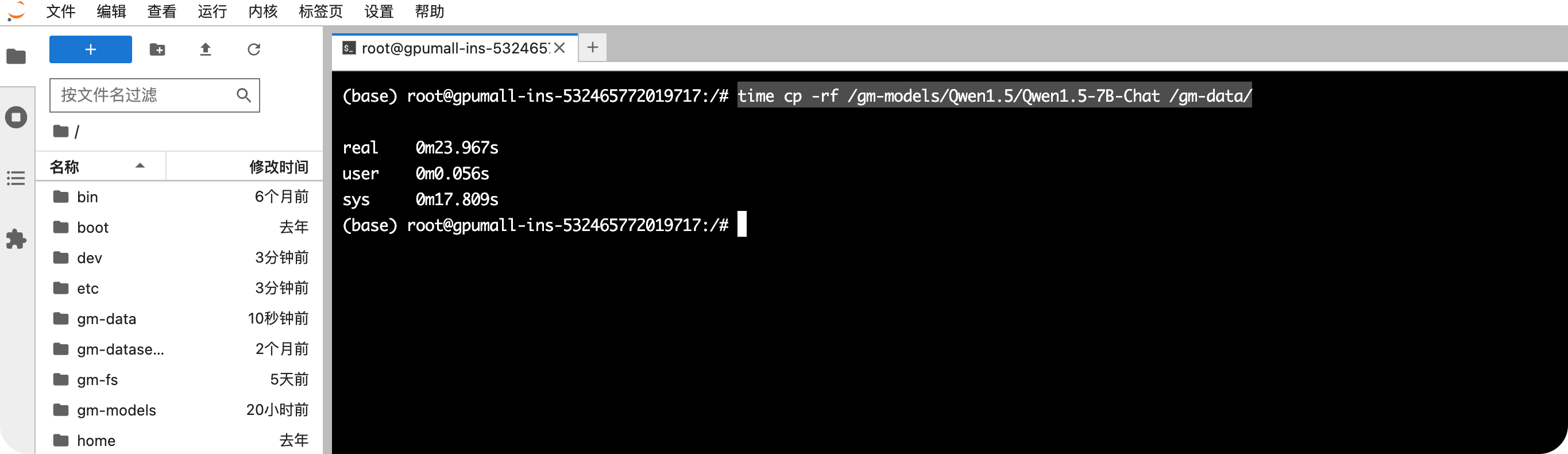

4. 拷贝模型到实例数据盘

实例数据盘扩容后通过如下命令将Qwen1.5-7B-Chat模型拷贝至数据盘

time cp -rf /gm-models/Qwen1.5/Qwen1.5-7B-Chat /gm-data/

1

5. 通过 vLLM 部署模型

通过如下指令来部署模型

python -m vllm.entrypoints.openai.api_server --host 0.0.0.0 --port 8000 --gpu-memory-utilization 0.9 --max-model-len 8192 --model /gm-data/Qwen1.5-7B-Chat --tensor-parallel-size 1

1

参数说明:

--host 0.0.0.0 #vLLM监听的IP地址--port 8000 #vLLM监听的端口--gpu-memory-utilization 0.9 #占用GPU显存比例,值为 0-1之间,值越高占用显存越多--max-model-len 29856 #上下文长度--model /gm-data/Qwen1.5-7B-Chat #模型文件位置--tensor-parallel-size 1 #指定1张卡运行,如果有2张卡则写为2,以此类推

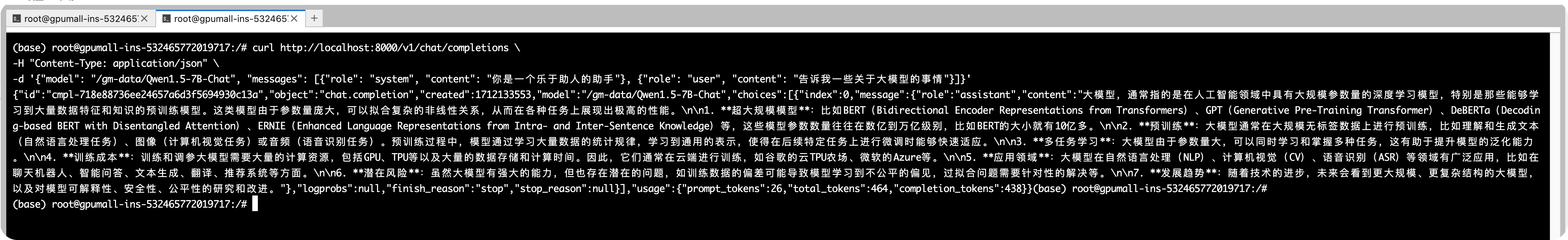

6. curl命令调用 vLLM 接口

curl http://localhost:8000/v1/chat/completions \

-H "Content-Type: application/json" \

-d '{"model": "/gm-data/Qwen1.5-7B-Chat", "messages": [{"role": "system", "content": "你是一个乐于助人的助手"}, {"role": "user", "content": "告诉我一些关于大模型的事情"}]}'

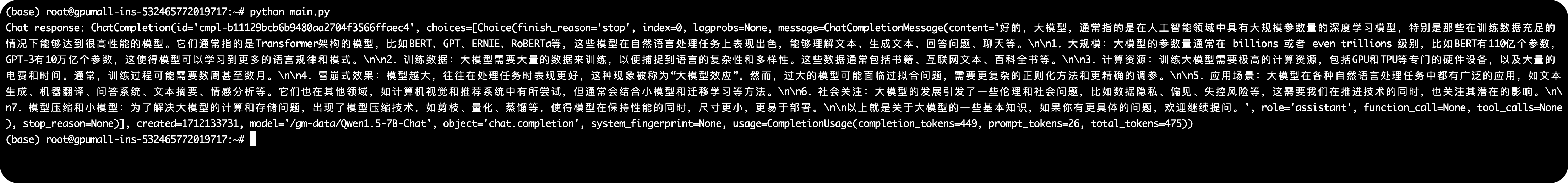

7. 使用Python调用 vLLM 接口

需先安装openai库

pip install openai

1

from openai import OpenAI

# Set OpenAI's API key and API base to use vLLM's API server.

openai_api_key = "EMPTY"

openai_api_base = "http://localhost:8000/v1"client = OpenAI(api_key=openai_api_key,base_url=openai_api_base,

)chat_response = client.chat.completions.create(model="/gm-data/Qwen1.5-7B-Chat",messages=[{"role": "system", "content": "你是一个乐于助人的助手"},{"role": "user", "content": "告诉我一些关于大模型的事情"},]

)

print("Chat response:", chat_response)