ChatGPT带火的HBM是什么?

“ChatGPT是人工智能领域的iPhone时刻,也是计算领域有史以来最伟大的技术之一。” 英伟达创始人兼CEO黄仁勋此前这样盛赞ChatGPT。

ChatGPT突然爆火,对大算力芯片提出了更高更多的要求。近日,据韩国经济日报报道,受惠于ChatGPT,三星、SK海力士HBM(high bandwidth memory,高带宽内存)接单量大增。

HBM是什么?

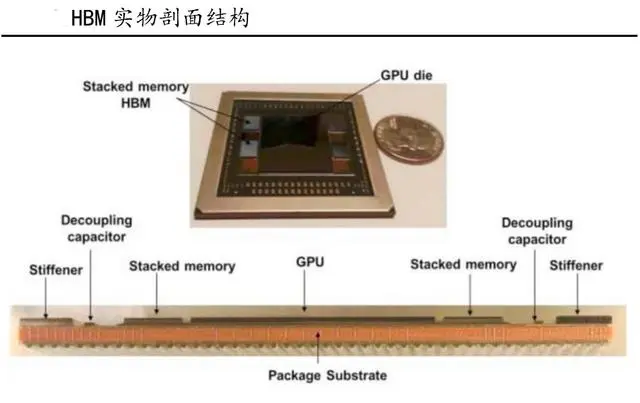

HBM(High Bandwidth Memory)即高带宽存储器,是基于硅通孔(TSV)和微凸点(Microbump)技术将多个DRAMdie和Logicdie堆叠而成的具有三维结构的存储产品。

GPU的主流存储方案目前有GDDR和HBM两种。在冯·诺依曼计算机体系结构中,存在着“内存墙”和“功耗墙”问题,由于传统显存GDDR5面临着带宽低、功耗高等瓶颈,HBM则能通过3D封装工艺实现DRAMdie的垂直方向堆叠封装,可以极大程度节约存储芯片占据的面积,实现更高的集成度和更大存储容量。

在传输速率方面,基于TSV工艺可以在存储芯片上制造多个内存通道、且更高集成度使得HBM和处理器之间物理距离得以缩短,因此HBM在位宽、带宽等关键性能上均明显优于GDDR。根据SAMSUNG,3DTSV工艺较传统POP封装形式节省了35%的封装尺寸,降低了50%的功耗,并且对比带来了8倍的带宽提升,有效解决了内存墙问题和功耗墙问题,成为当前满足AI需求的最佳方案,被所有主流AI芯片采用。

为什么需要HBM?

主要是因为随着GPU 的功能越来越强大,需要更快地从内存中访问数据,以缩短应用处理时间。例如,AI和视觉,具有巨大内存和计算和带宽要求。

为了减小“内存墙”的影响,提升内存带宽一直是存储芯片聚焦的关键问题。

半导体的先进封装为克服阻碍高性能计算应用程序的内存访问障碍提供了机会,内存的延迟和密度都是可以在封装级别解决的挑战。基于对先进技术和解决方案开展的研究,内存行业在新领域进行了更深入的探索。

为了克服这些挑战,半导体封装设计人员采用了异构集成路线,以在更靠近处理器的位置包含更多内存。而HBM就为现代处理器和嵌入式系统当前面临的内存障碍问题提供了解决方案。这些存储器为系统设计人员提供了两个优势:一是减少组件占用空间和外部存储器要求;二是更快的内存访问时间和速率。

叠起来之后,直接结果就是接口变得更宽,其下方互联的触点数量远远多于DDR内存连接到CPU的线路数量。因此,与传统内存技术相比,HBM具有更高带宽、更多I/O数量、更低功耗、更小尺寸。

目前,HBM产品以HBM(第一代)、HBM2(第二代)、HBM2E(第三代)、HBM3(第四代)、HBM3E(第五代)的顺序开发,最新的HBM3E是HBM3的扩展版本。

当然,存储器的容量也在不断加大:HBM2E的最大容量为16GB,目前,三星正在利用其第四代基于EUV光刻机的10nm制程(14nm)节点来制造24GB容量的HBM3芯片,此外8层、12层堆叠可在HBM3E上实现36GB(业界最大)的容量,比HBM3高出50%。

此前SK海力士、美光均已宣布推出HBM3E芯片,皆可实现超过1TB/s的带宽。

同时,三星也宣布HBM4内存将采用更先进的芯片制造和封装技术,虽然HBM4的规格尚未确定,但有消息称业界正寻求使用2048位内存接口,并使用FinFET晶体管架构来降低功耗。三星希望升级晶圆级键合技术,从有凸块的方式转为无凸块直接键合。因此,HBM4的成本可能会更高。

HBM的未来应用前景

随着AI大模型、智能驾驶等新技术的崛起,人们对高带宽的内存的需求越来越多。

首先,AI服务器的需求会在近两年爆增,如今在市场上已经出现了快速的增长。AI服务器可以在短时间内处理大量数据,GPU可以让数据处理量和传输速率的大幅提升,让AI服务器对带宽提出了更高的要求,而HBM基本是AI服务器的标配。

除了AI服务器,汽车也是HBM值得关注的应用领域。汽车中的摄像头数量,所有这些摄像头的数据速率和处理所有信息的速度都是天文数字,想要在车辆周围快速传输大量数据,HBM具有很大的带宽优势。

另外,AR和VR也是HBM未来将发力的领域。因为VR和AR系统需要高分辨率的显示器,这些显示器需要更多的带宽来在 GPU 和内存之间传输数据。而且,VR和AR也需要实时处理大量数据,这都需要HBM的超强带宽来助力。

此外,智能手机、平板电脑、游戏机和可穿戴设备的需求也在不断增长,这些设备需要更先进的内存解决方案来支持其不断增长的计算需求,HBM也有望在这些领域得到增长。并且,5G 和物联网 (IoT) 等新技术的出现也进一步推动了对 HBM 的需求。

并且,AI的浪潮还在愈演愈烈,HBM今后的存在感或许会越来越强。据semiconductor-digest预测,到2031年,全球高带宽存储器市场预计将从2022年的2.93亿美元增长到34.34亿美元,在2023-2031年的预测期内复合年增长率为31.3%。

HBM需要克服的问题

1:HBM需要较高的工艺从而导致大幅度提升了成本。

针对更大数据集、训练工作负载所需的更高内存密度要求,存储厂商开始着手研究扩展Die堆叠层数和物理堆叠高度,以及增加核心Die密度以优化堆叠密度。

但就像处理器芯片摩尔定律发展一样,当技术发展到一个阶段,想要提升更大的性能,那么成本反而会大幅提升,导致创新放缓。

2:产生大量的热,如何散热是GPU极大的挑战。

行业厂商需要在不扩大现有物理尺寸的情况下增加存储单元数量和功能,从而实现整体性能的飞跃。但更多存储单元的数量让GPU的功耗大幅提升。新型的内存需要尽量减轻内存和处理器之间搬运数据的负担。

最后总结

随着人工智能、机器学习、高性能计算、数据中心等应用市场的兴起,内存产品设计的复杂性正在快速上升,并对带宽提出了更高的要求,不断上升的宽带需求持续驱动HBM发展。相信未来,存储巨头们将会持续发力、上下游厂商相继入局,让HBM得到更快的发展和更多的关注。

参考资料

[01] 《An Overview of the Development of a GPU with integrated HB Mon Silicon Interposer》,IEEE

[02] https://www.eepw.com.cn/article/202312/454189.htm

[03] https://www.eet-china.com/news/202302168387.html

[04] 李川,郑浩,王彦辉.硅转接层高带宽存储互连通道信号完整性设计及仿真

[J]. 计算机工程与科学. 2022 (02)

[05] 吴铁彬,过锋,王谛.

面向E级计算的高性能处理器核心运算架构研究进展[J]. 计算机工程与科学. 2023 (05)