spark数据倾斜的解决思路

数据倾斜是:多个分区中,某个分区的数据比其他分区的数据多的多

数据倾斜导致的问题:

- 导致某个spark任务耗时较长,导致整个任务耗时增加,甚至出现OOM

- 运行速度慢:主要发生在shuffle阶段,同样的key的数据太多了,导致了某个key所在的task需要处理的数据量太大了,远超其他的task的处理时间

一条经验:一般出现运行速度异常慢,或者OOM的主要原因是数据倾斜

数据倾斜的解决方案:

- 过滤不需要的key:有些key是脏数据,直接过滤,降低数据量

- 调整并行度:增大partition的数量,这个每个task要处理的数据量就降低了,各个key可以均匀的分配到多个partition中。但是如果某个key的数据量就是很多,还是会出现数据倾斜

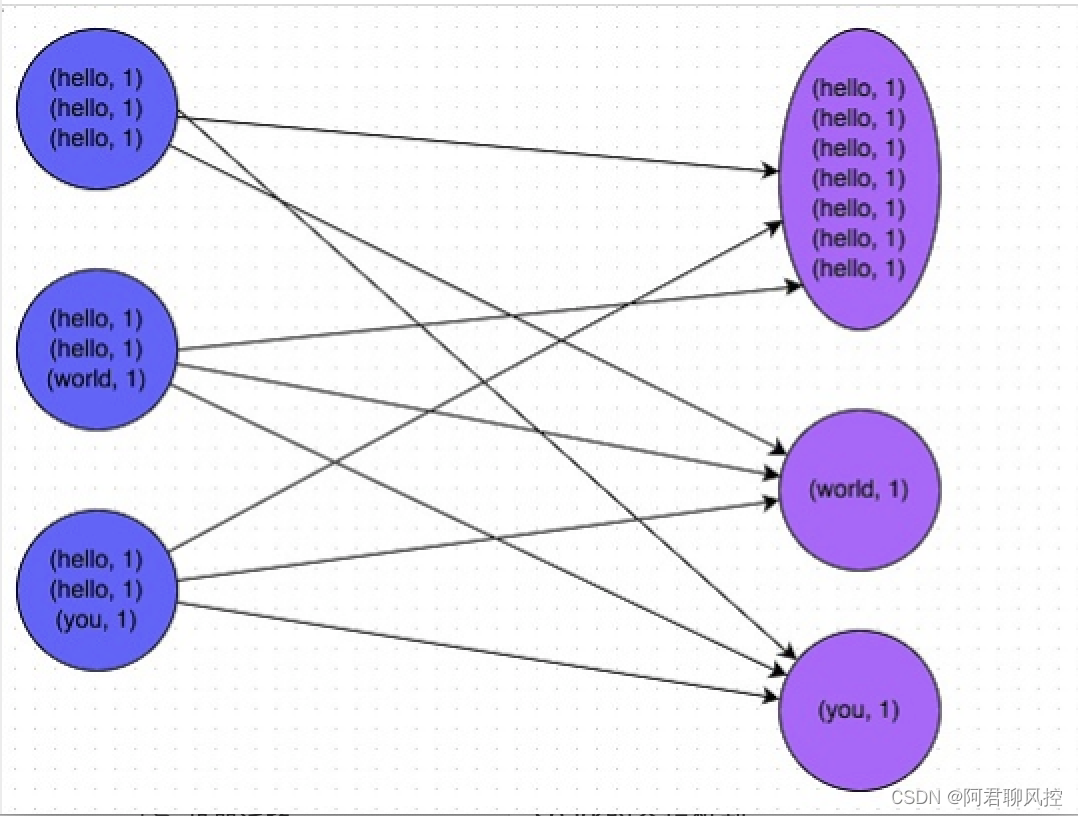

- 将reduce侧的join转化为map侧join:如用reduceBykey来替换groupByKey,让map侧也发生aggr聚合,减少shuffle的数据量

- 随机前缀扩容:如果某个key就是很多,在此key之前加随机数,来打散key,然后聚合

- 如果在加载数据时就发生了数据倾斜,可以在加载后进行repartition

- 对于join数据倾斜,一般是小表join大表,用map join ,避免reduce join(shuffle join)

总结:一般在shuffle时容易发生数据倾斜,因此主要思路是降低shuffle的量

spark的map join 和reduce join的区别?

都是将2个数据集进行join连接的操作,但是实现方式不同

- map join:小表join 大表, 将小表通过广播的方式,广播到所有excutors节点的内存中,然后在每个excutor节点上将大数据和小数据进行连接,这样可以快速连接,从而提高了join的效率;优点:由于将小数据加载到内存中,join的速度很快;缺点:由于数据会加载到内存中,会导致内存溢出的问题。

- reduce join : 大表join大表, 将2个数据集都进行分区,然后将相同的key的数据分发到同一个节点上进行连接操作。因为同一个key的数据被分发到同一个节点上,所以每个节点只需要处理一部分数据,从而减少了每个节点需要处理的数据量,提高了join的效率;优点:通过分布式的方式能够处理大数据集; 缺点:需要进行shuffle网络传输,如果传输速度较慢,可能会导致连接操作的效率较低。