日志平台搭建第六章:logstash通过kafka通道采集日志信息

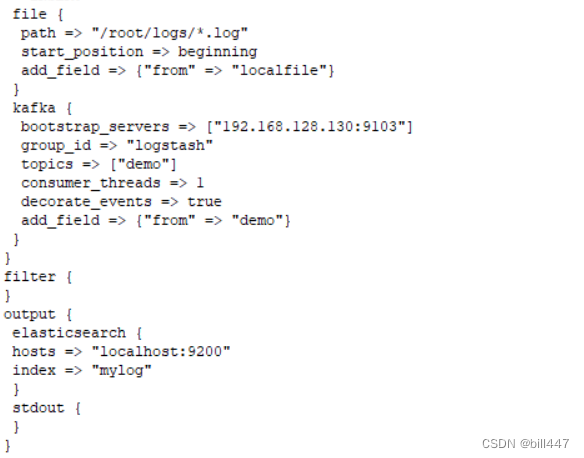

1.修改文件/opt/app/elk/logstash-7.5.1/config.d/config1.conf,在input下添加kafka采集配置

#192.168.128.130:9103:kafka地址

#topics:主题

kafka {bootstrap_servers => ["192.168.128.130:9103"]group_id => "logstash"topics => ["demo"]consumer_threads => 1decorate_events => trueadd_field => {"from" => "demo"}

}

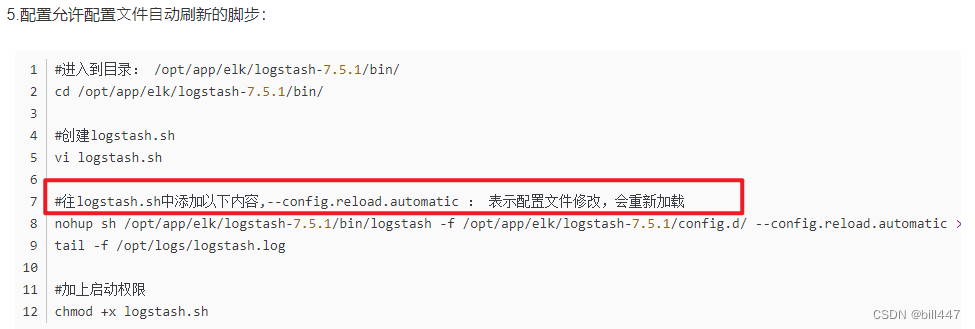

修改完配置文件后,不需要手动重启,因为之前在启动logstash时,配置了以下内容

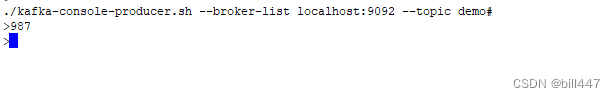

kafka消息发送端发送消息

#进入kafka容器

docker exec -it kafka sh#进入到/opt/kafka/bin目录

cd /opt/kafka/bin#启动消息发送端

./kafka-console-producer.sh --broker-list localhost:9092 --topic demo

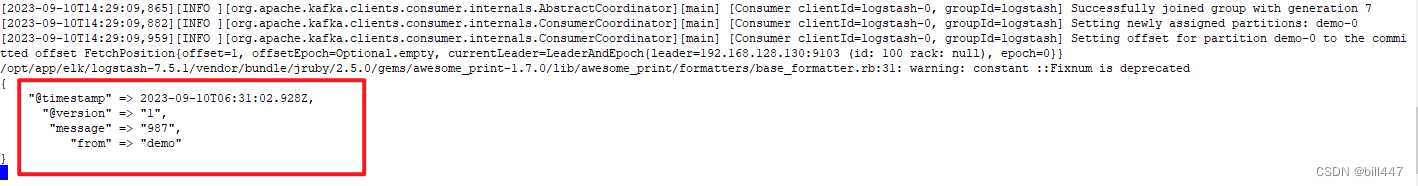

logstash控制台会输出以下内容

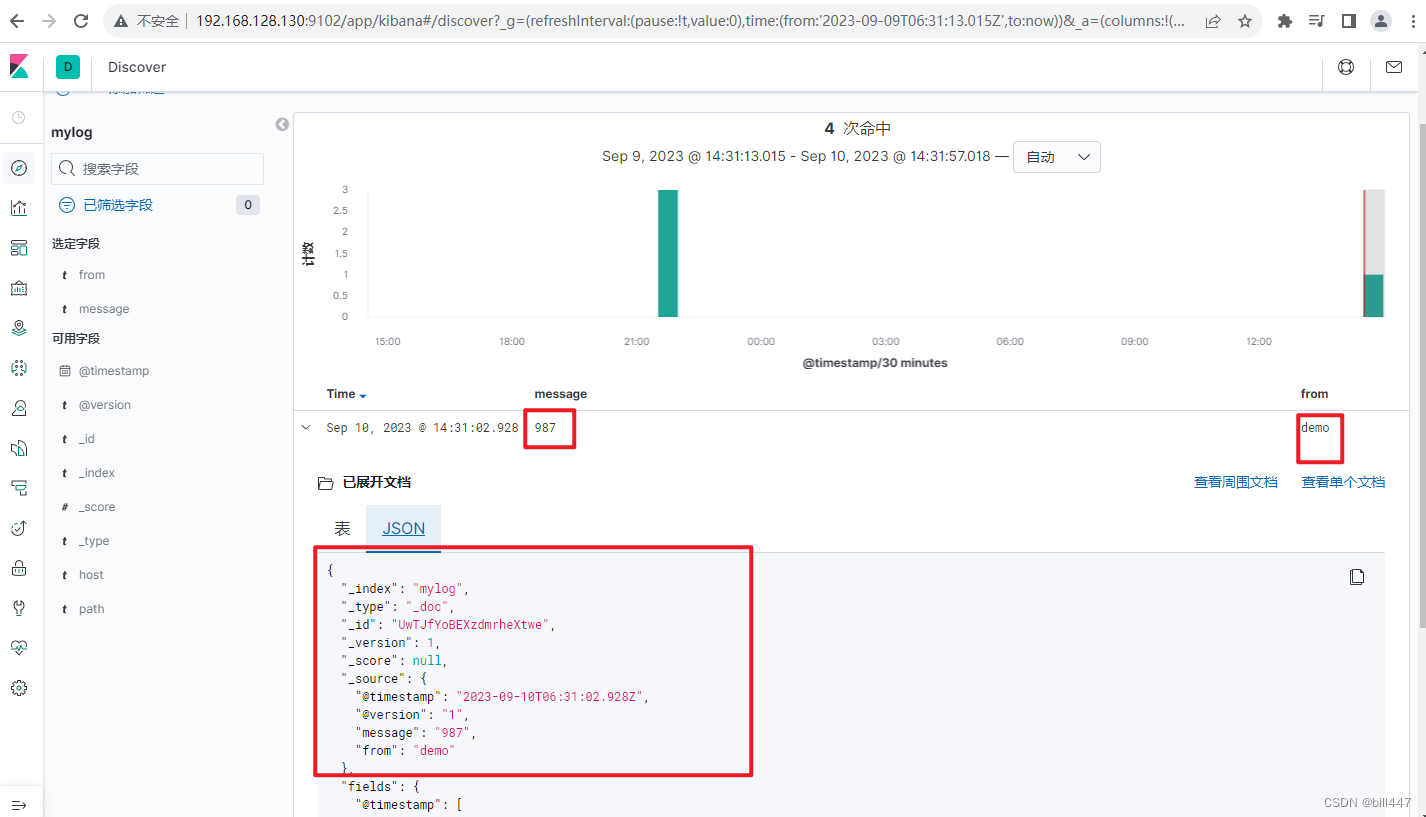

kibana服务中查询出es的mylog索引中会采集到kafka的信息