八 动手学深度学习v2 ——卷积神经网络之卷积+填充步幅+池化+LeNet

目录

- 1. 图像卷积总结

- 2. 填充和步幅 padding和stride

- 3. 多输入多输出通道

- 4. 池化层

- 5. LeNet

1. 图像卷积总结

- 二维卷积层的核心计算是二维互相关运算。最简单的形式是,对二维输入数据和卷积核执行互相关操作,然后添加一个偏置。

- 核矩阵和偏移是可学习的参数

- 核矩阵大小是超参数

2. 填充和步幅 padding和stride

- 填充:

在应用多层卷积时,我们常常丢失边缘像素。 由于我们通常使用小卷积核,因此对于任何单个卷积,我们可能只会丢失几个像素。 但随着我们应用许多连续卷积层,累积丢失的像素数就多了。 解决这个问题的简单方法即为填充(padding):在输入图像的边界填充元素(通常填充元素是0)。 - 步幅:

在计算互相关时,卷积窗口从输入张量的左上角开始,向下、向右滑动。 在前面的例子中,我们默认每次滑动一个元素。 但是,有时候为了高效计算或是缩减采样次数,卷积窗口可以跳过中间位置,每次滑动多个元素。 - 总结:

- 填充和步幅是卷积层的超参数

- 填充在输入周围添加额外的行/列,来控制输出形状的减少量。

- 步幅是每次滑动卷积核的行/列的步长,可以成倍的减少输出的形状。

3. 多输入多输出通道

总结:

- 输出通道数是卷积层的超参数

- 每个输入通道有独立的二维卷积核,所有输入通道结果相加一个输出通道结果

- 每个输出通道 有 独立的三维卷积核

4. 池化层

- max-pooling

- average-pooling

总结: - 池化层返回窗口中的最大或者平均值

- 缓解卷积层对位置的敏感性

- 同样有窗口大小、填充、和步幅作为 超参数

为什么池化层用的少了

池化层有两个作用

- 减少计算,如果用到stride>1,如果stride放在卷积,池化这个功能就没了。

- 缓解卷积层对位置的敏感性,但是我们会对数据本身做一些操作,放大,旋转,缩小,这样淡化了池化层的作用。

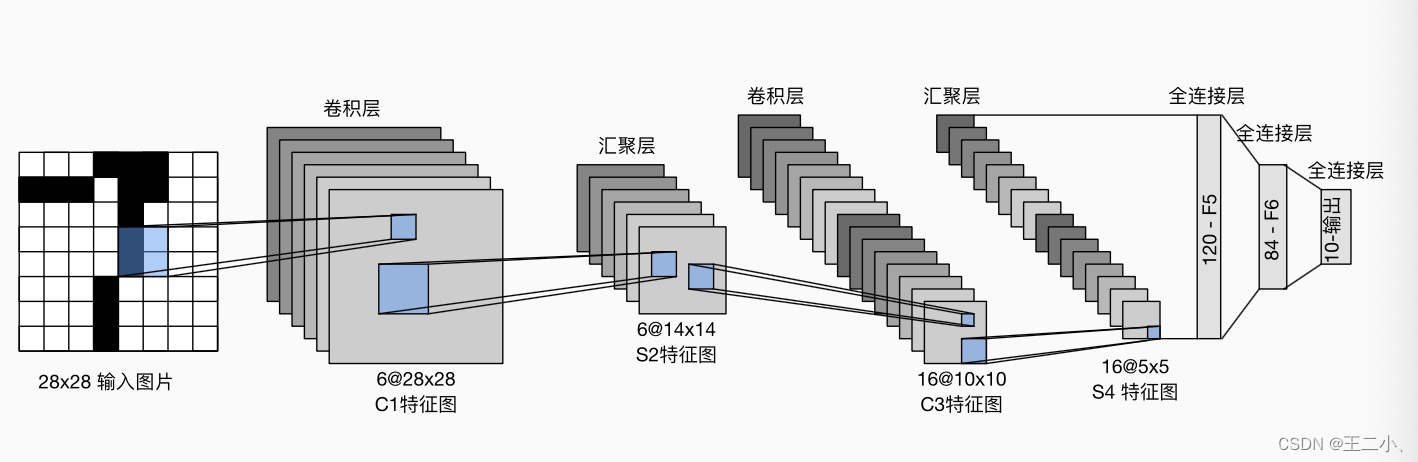

5. LeNet