LLM 生成式配置的推理参数温度 top k tokens等 Generative configuration inference parameters

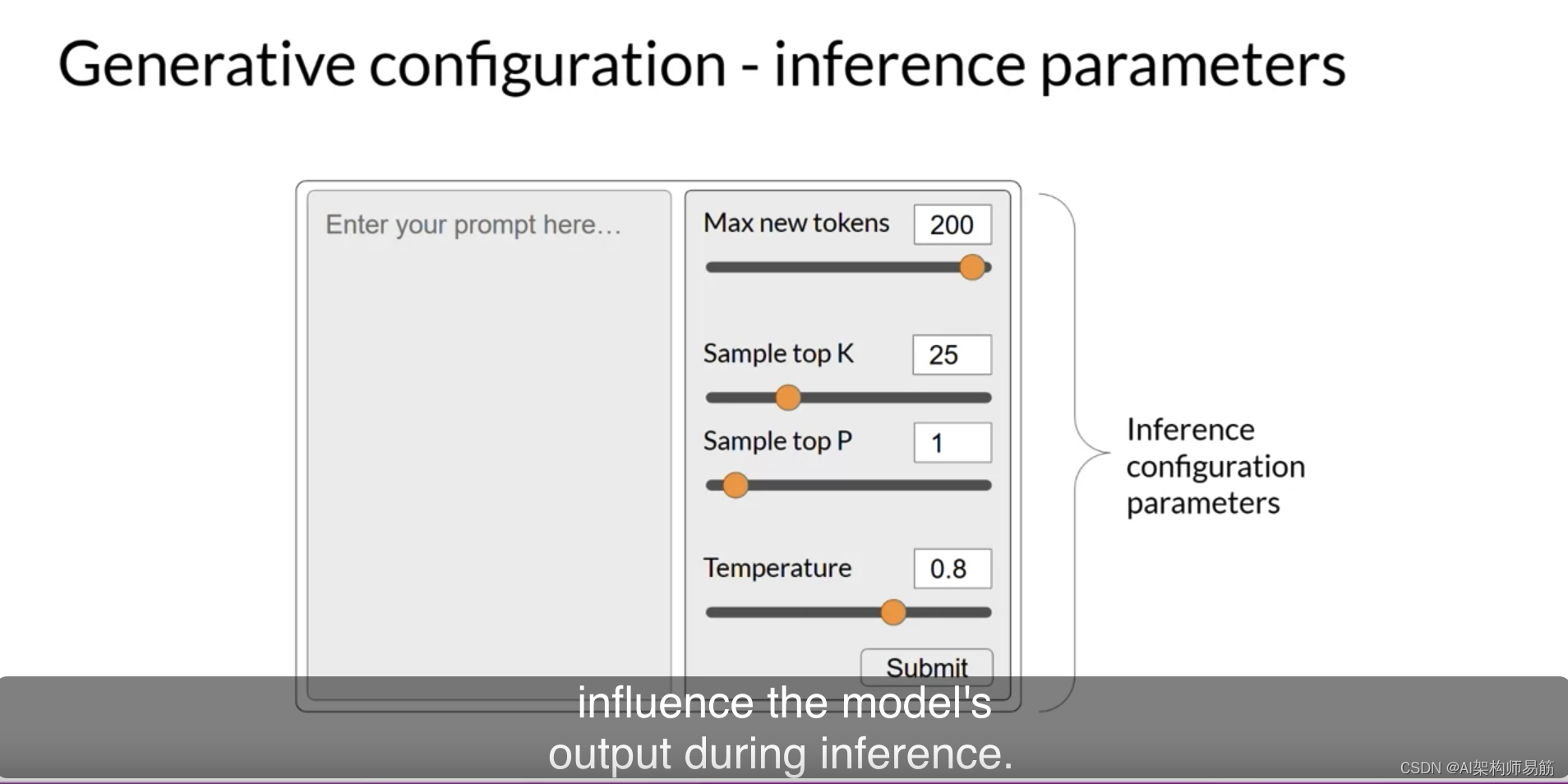

在这个视频中,你将了解一些方法和相关的配置参数,这些参数可以用来影响模型在下一个词生成时的最终决策方式。如果你在Hugging Face网站或AWS的游乐场中使用过LLMs,你可能已经看到了这些控制选项,用来调整LLM的行为。每个模型都暴露了一组配置参数,可以在推断过程中影响模型的输出。

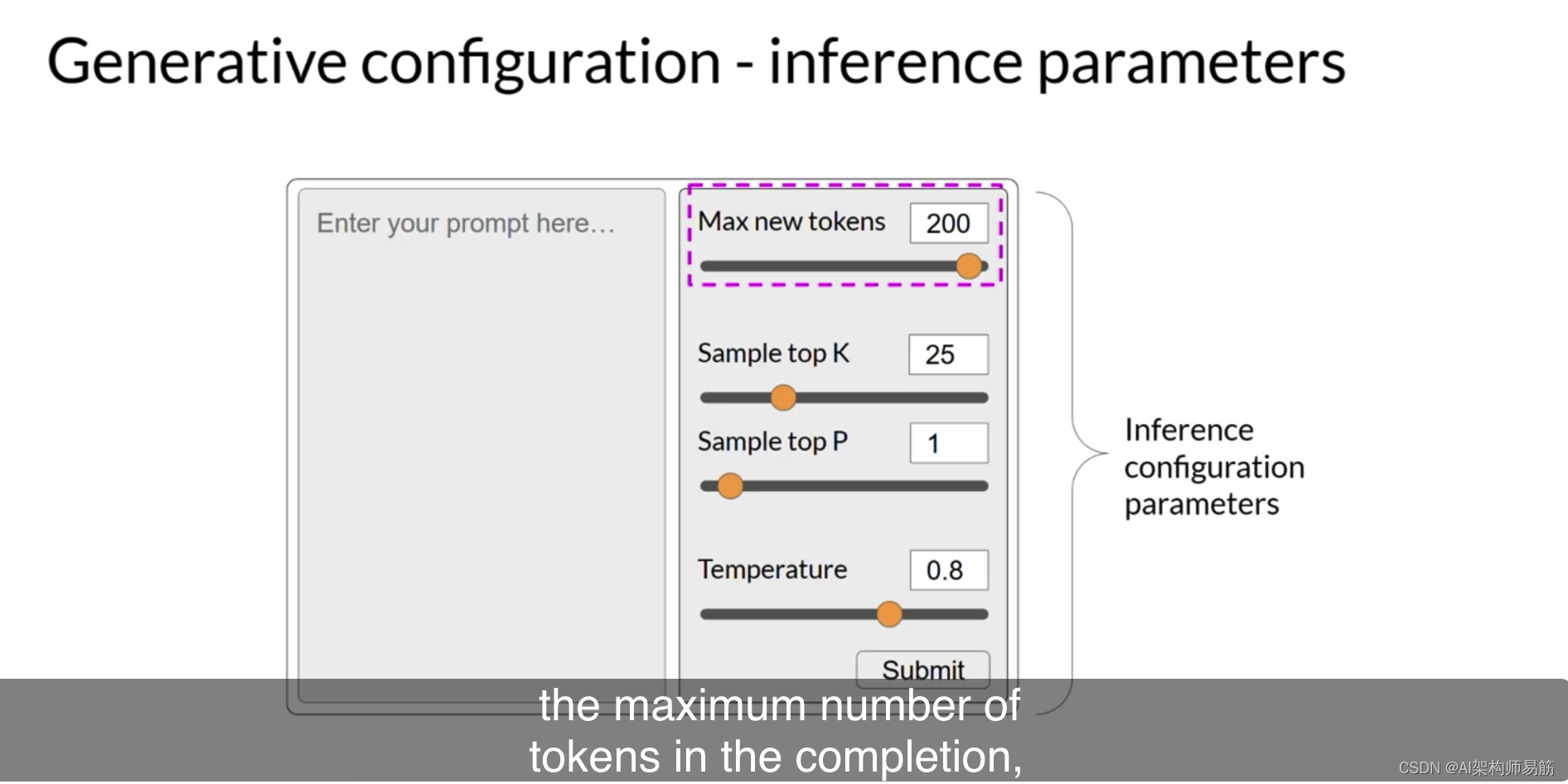

请注意,这些参数与训练参数不同,训练参数是在训练时学习的。相反,这些配置参数是在推断时调用的,允许你控制完成中的最大令牌数

和输出的创意程度。

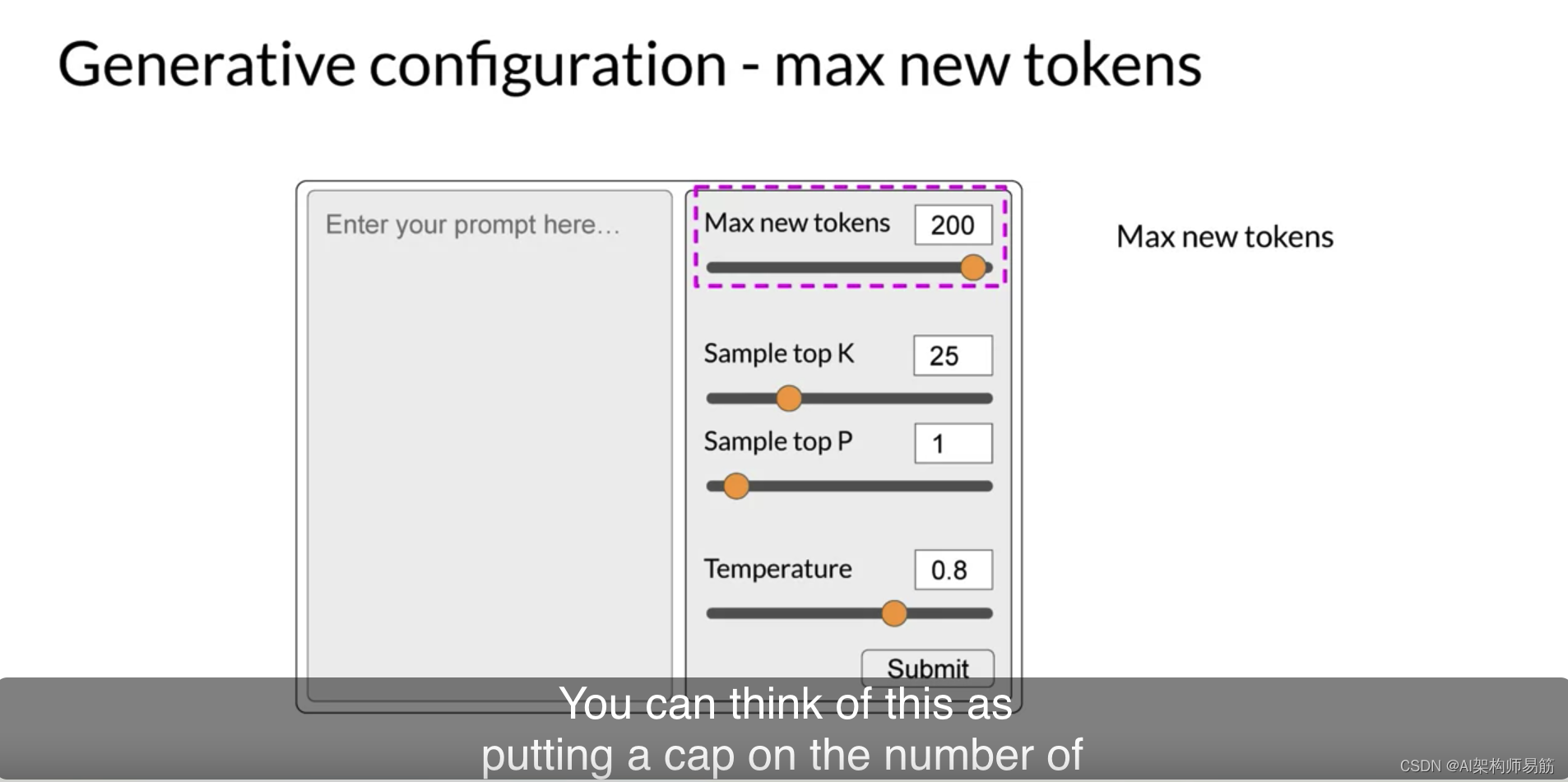

Max new tokens可能是这些参数中最简单的,你可以使用它来限制模型生成的令牌数。你可以将其视为限制模型经历选择过程的次数。

这里你可以看到max new tokens设置为100、150或200的示例。但请注意,200的示例中完成的长度较短。这是因为达到了另一个停止条件,例如模型预测了序列结束令牌。请记住,这是最大的新令牌,而不是生成的新令牌的硬数字。

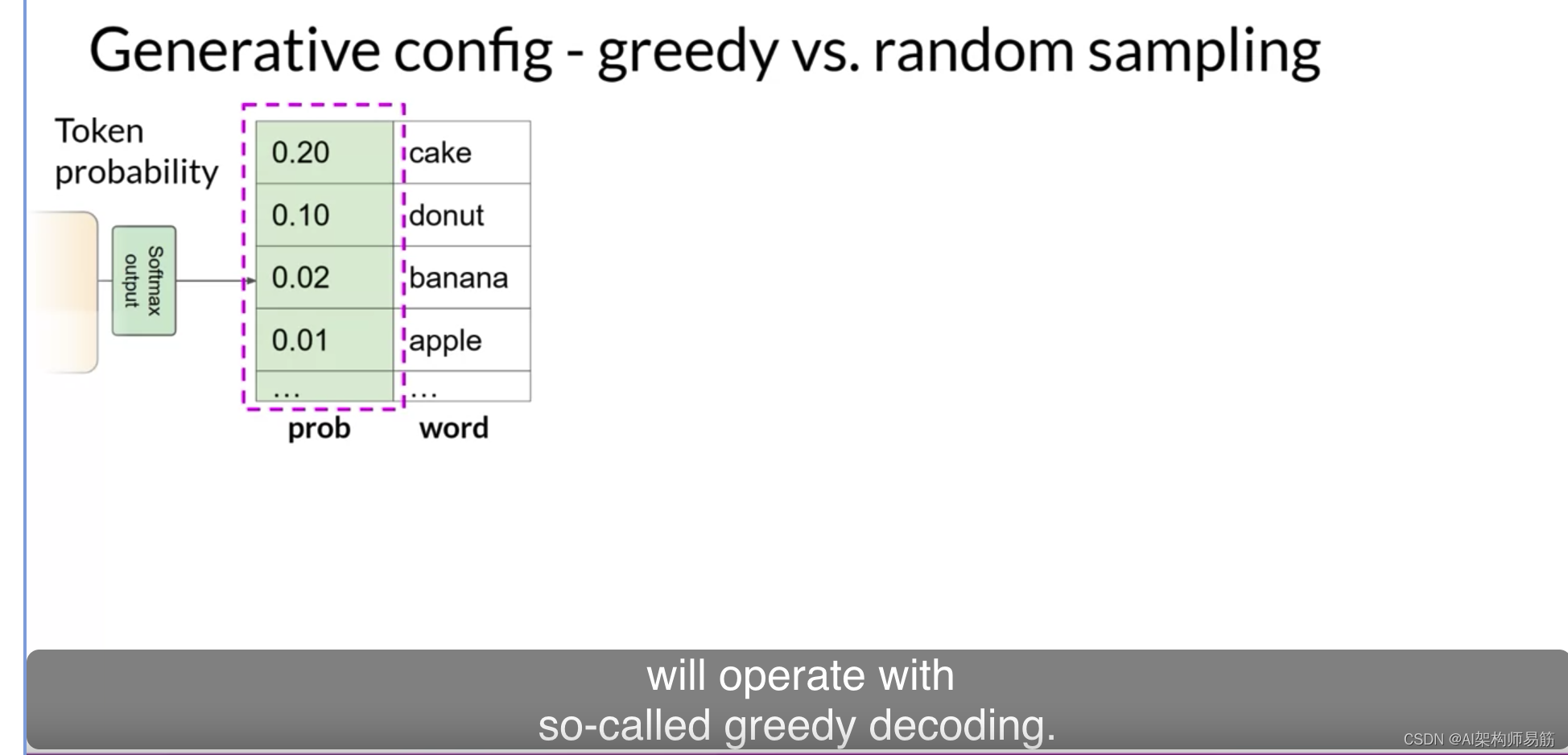

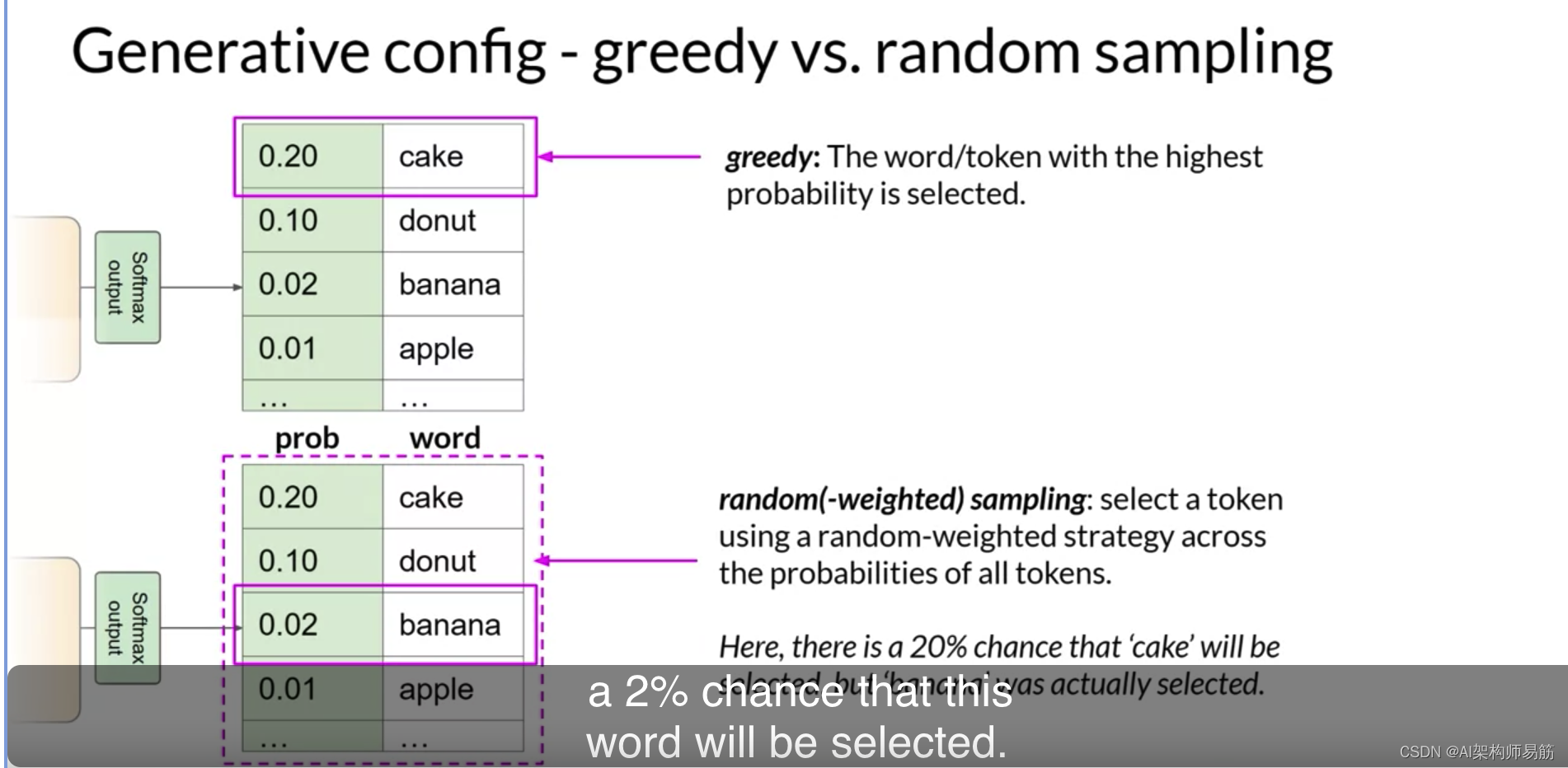

Transformers的softmax层的输出是模型使用的整个词典上的概率分布。这里你可以看到一些单词及其旁边的概率分数。尽管我们这里只显示了四个单词,但想象一下,这是一个继续到完整词典的列表。

大多数大型语言模型默认使用所谓的贪婪解码。这是下一个词预测的最简单形式,模型总是选择概率最高的词。这种方法对于短期生成效果很好,但容易重复单词或重复单词序列。如果你想生成更自然、更有创意且避免重复单词的文本,你需要使用其他控制。随机采样是引入一些变化的最简单方法。与随机采样不同,模型不是每次都选择最可能的词,而是使用概率分布对输出词进行随机选择。例如,在插图中,单词banana的概率分数为0.02。使用随机采样,这相当于这个词被选择的概率为2%。使用这种采样技术,我们减少了单词重复的可能性。

然而,根据设置,可能会产生过于创意的输出,产生导致生成偏离主题或根本没有意义的单词。请注意,在某些实现中,你可能需要显式地禁用贪婪并启用随机采样。例如,我们在实验室中使用的Hugging Face Transformers实现要求我们将do sample设置为true。让我们探索top k和top p采样技术,以帮助限制随机采样并增加输出合理的机会。

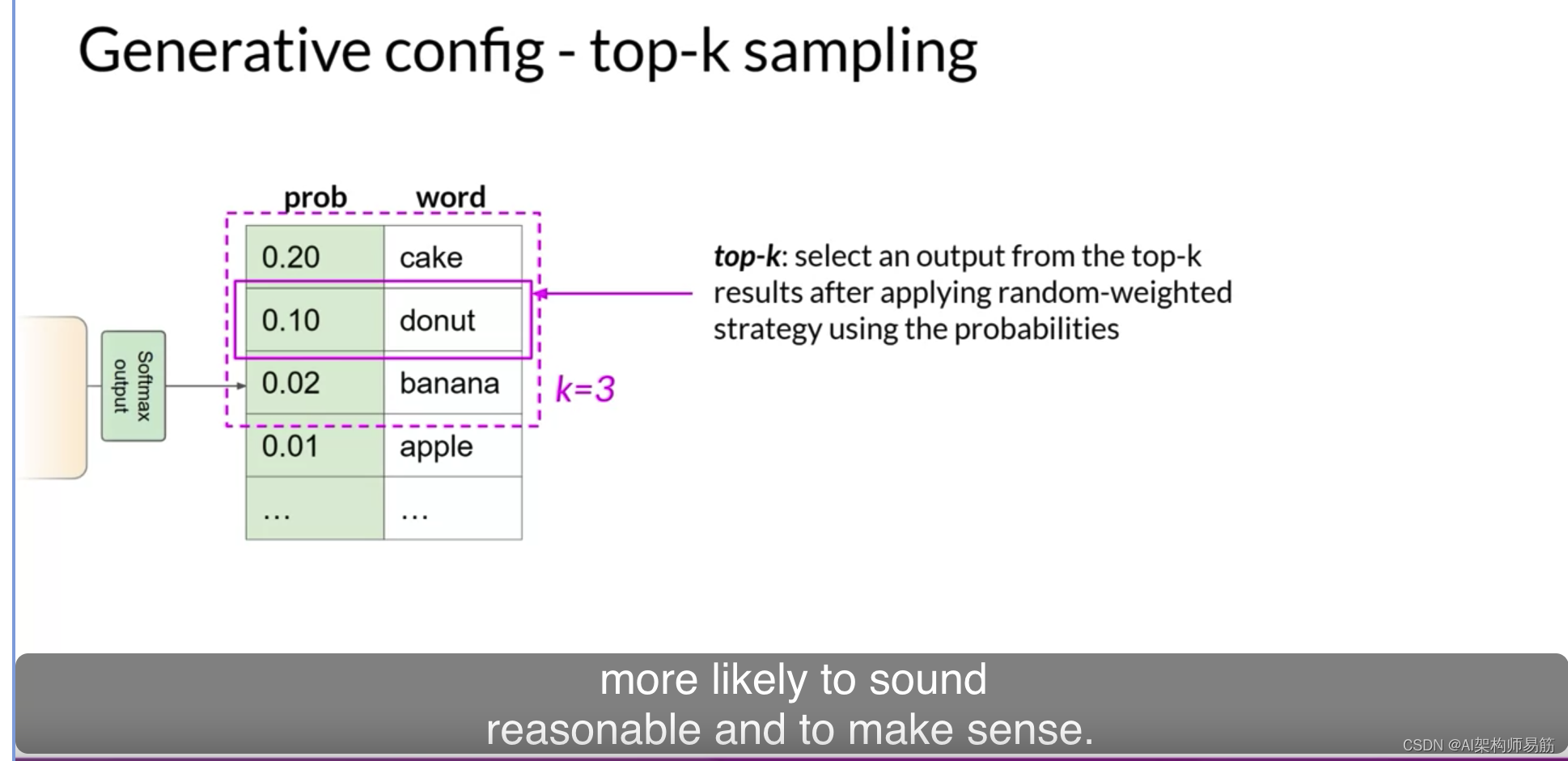

为了限制选项,同时仍允许一些变化,你可以指定一个top k值,该值指示模型只从概率最高的k个令牌中选择。在这里的示例中,k设置为三,所以你限制模型只从这三个选项中选择。然后,模型使用概率加权选择这些选项,在这种情况下,它选择甜甜圈作为下一个词。这种方法可以帮助模型有一些随机性,同时防止选择高度不可能的完成词。

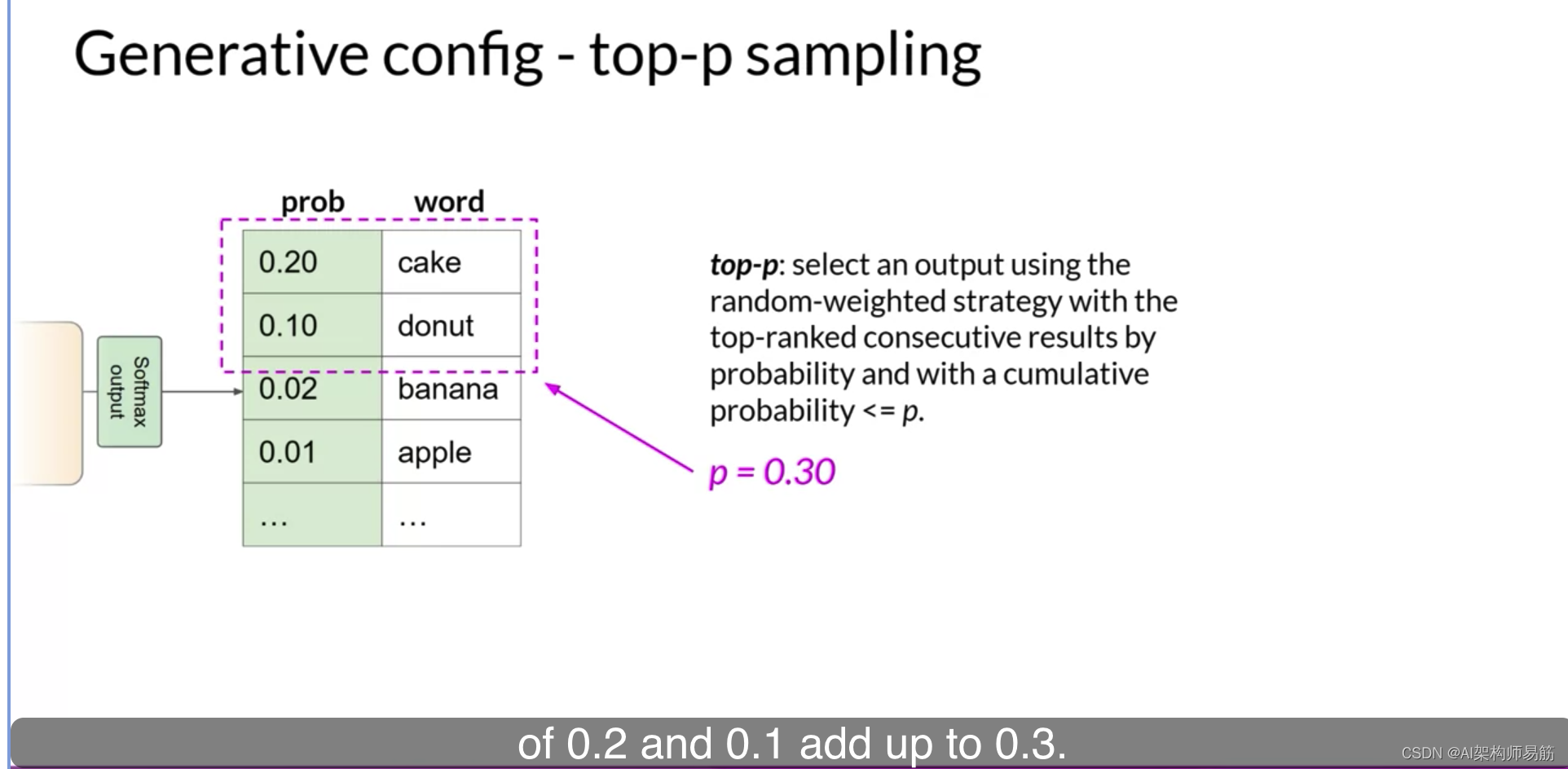

这反过来使得你的文本生成更有可能听起来合理并有意义。或者,你可以使用top p设置来限制随机采样,只对其组合概率不超过p的预测进行采样。例如,如果你将p设置为0.3,选项是蛋糕和甜甜圈,因为它们的概率为0.2和0.1,加起来为0.3。然后,模型使用随机概率加权方法从这些令牌中选择。

使用top k,你指定要随机选择的令牌数,使用top p,你指定你希望模型选择的总概率。

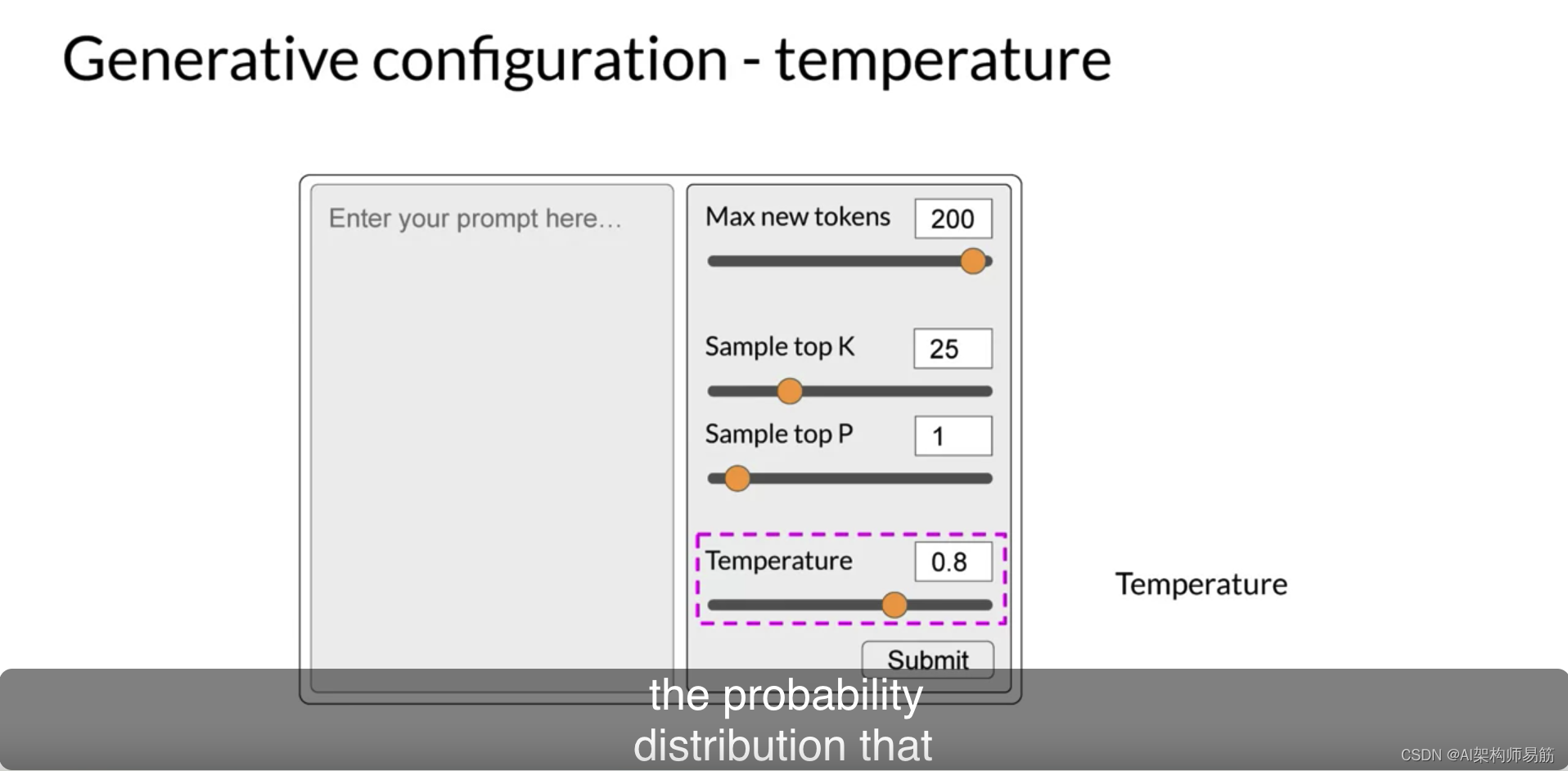

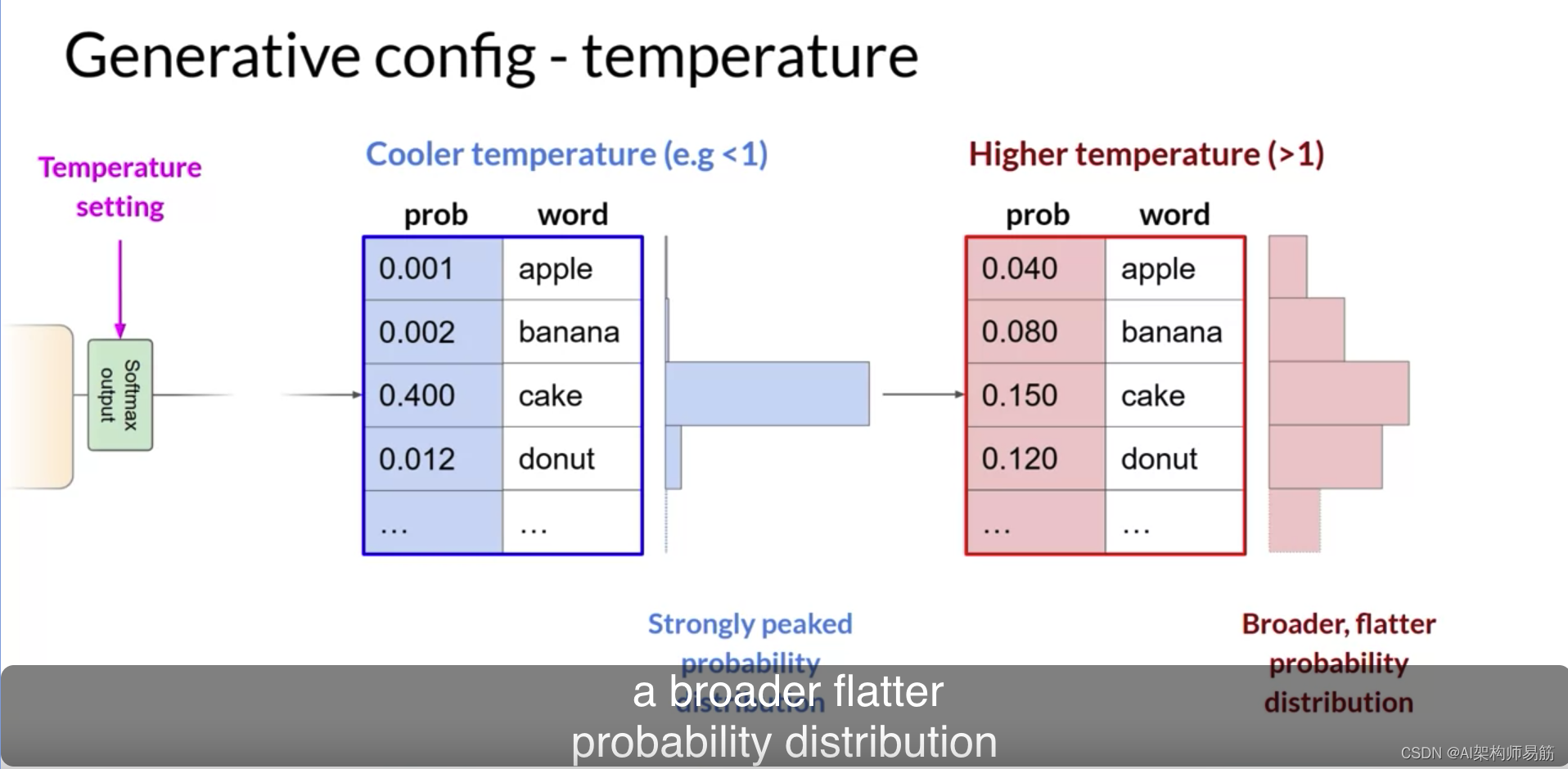

你还可以使用一个称为温度的参数来控制模型输出的随机性。这个参数影响模型为下一个令牌计算的概率分布的形状。

大致说来,温度越高,随机性越高,温度越低,随机性越低。温度值是应用于模型的最终softmax层的缩放因子,影响下一个令牌的概率分布的形状。与top k和top p参数相反,改变温度实际上会改变模型的预测。如果你选择一个低的温度值,比如小于1,那么从softmax层得到的概率分布将更强烈地峰值,概率将集中在较少的单词上。你可以在这里看到这一点,在表旁边的蓝色条上,显示了一个概率条形图。大部分的概率都集中在单词cake上。模型将使用随机采样从这个分布中选择,生成的文本将不那么随机,并且更接近模型在训练期间学到的最可能的词序列。相反,如果你将温度设置为一个较高的值,比如大于1,那么模型将计算下一个令牌的更广泛、更平坦的概率分布。注意,与蓝色条相比,概率在令牌上更均匀地分布。

这使得模型生成文本具有更高的随机性和与冷温度设置相比的输出变化性。这可以帮助你生成听起来更有创意的文本。如果你将温度值设置为1,这将使softmax函数保持默认状态,将使用未更改的概率分布。

你已经涵盖了很多内容。你已经检查了LLMs能够执行的任务类型,并了解了Transformers,这是驱动这些惊人工具的模型架构。你还探索了如何使用提示工程和通过尝试不同的推断配置参数来从这些模型中获得最佳性能。

在下一个视频中,你将开始在这个基础知识上建立,思考开发和启动Transformers-powered应用程序所需的步骤。

参考

https://www.coursera.org/learn/generative-ai-with-llms/lecture/18SPI/generative-configuration