认识Transformer:入门知识

视频链接:

https://www.youtube.com/watch?v=ugWDIIOHtPA&list=PLJV_el3uVTsOK_ZK5L0Iv_EQoL1JefRL4&index=60

文章目录

- Self-Attention layer

- Multi-head self-attention

- Positional encoding

- Seq2Seq with Attention

- Transformer

- Universal Transformer

Seq2Seq

RNN不容易被平行化

提出用CNN来代替RNN,CNN 可以平行化,但是需要的层数比较深,才能看完所有的输入内容。

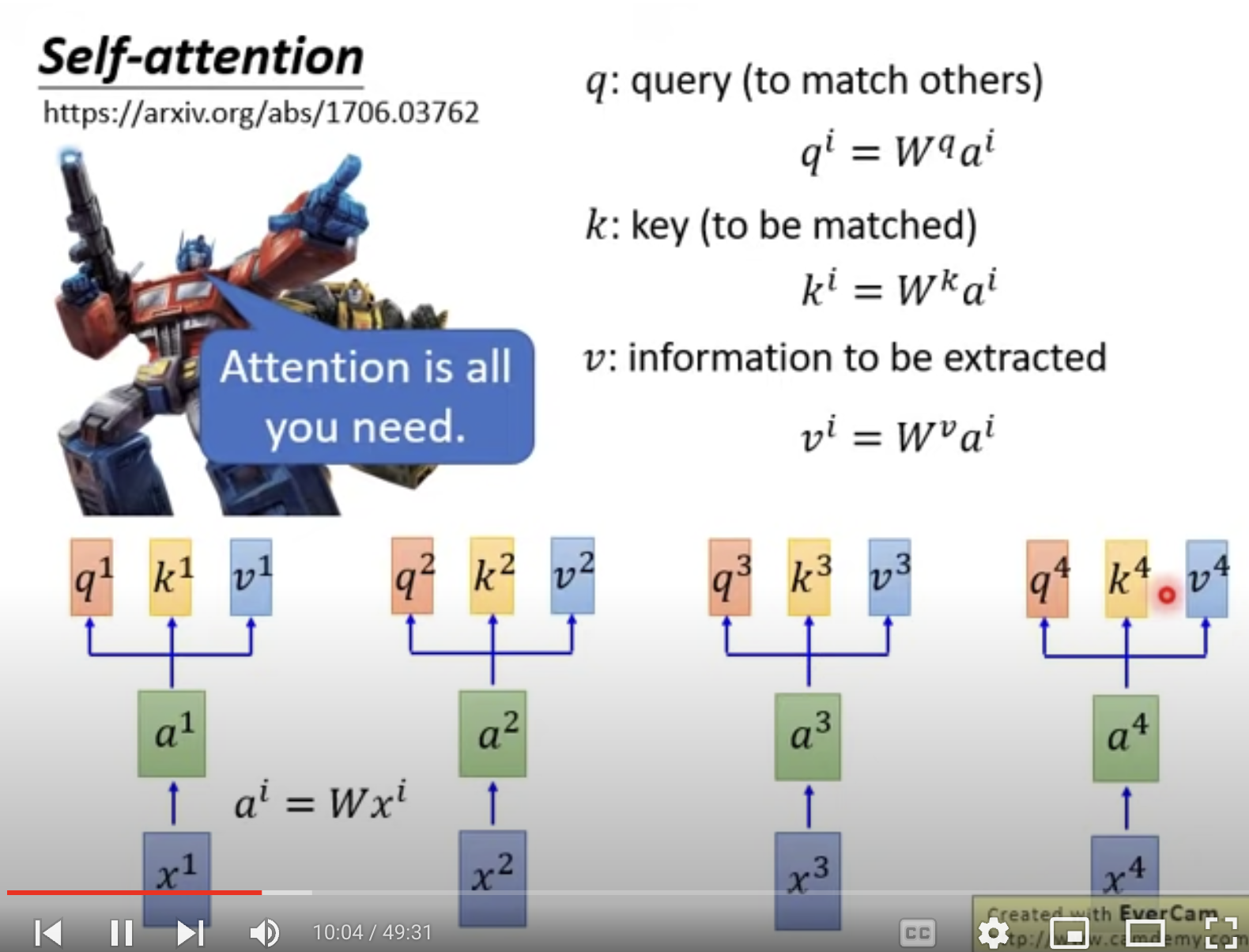

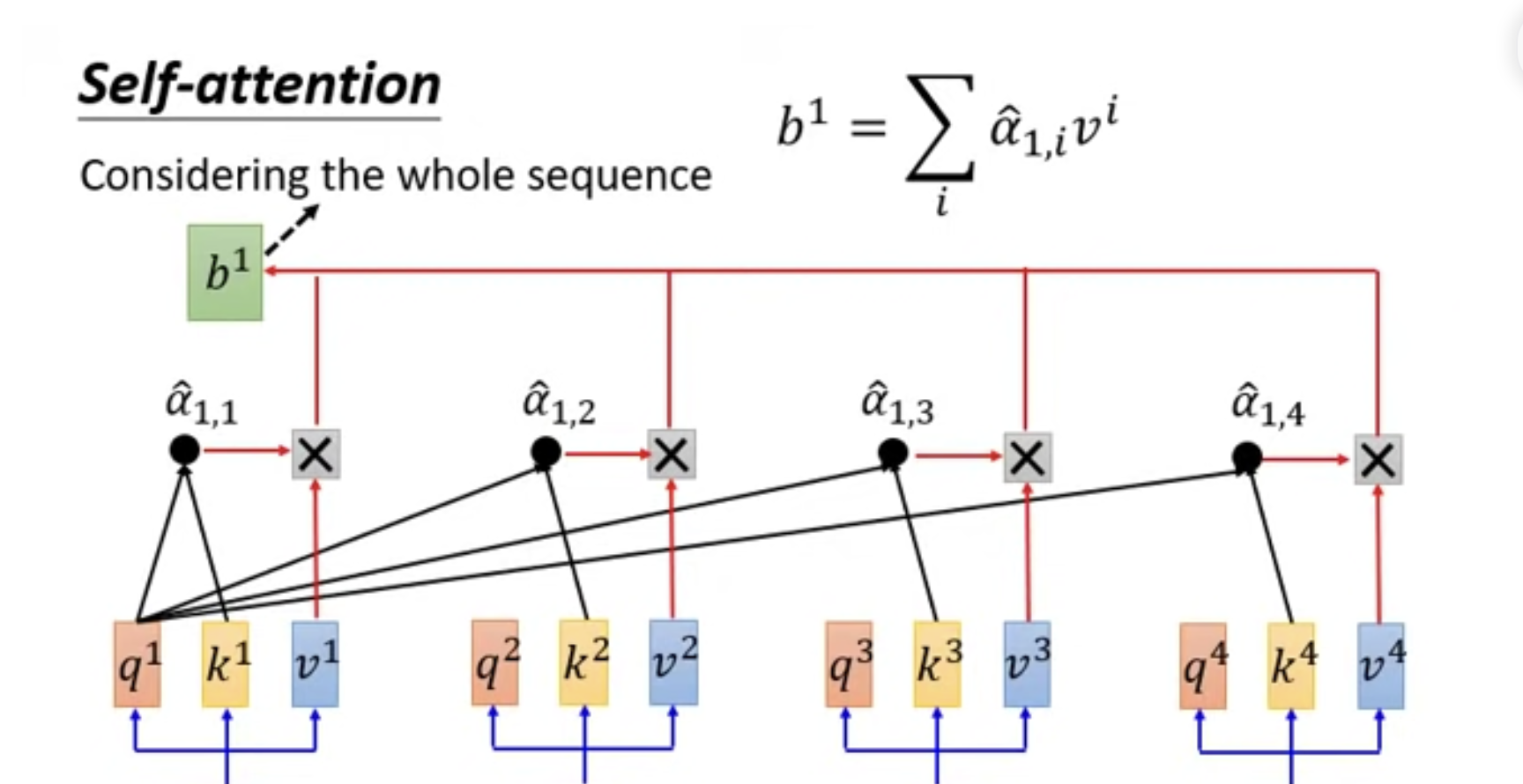

Self-Attention layer

b1 到b4 是可以同时被算出。

可以用来取代RNN。

来源: Attention is all you need

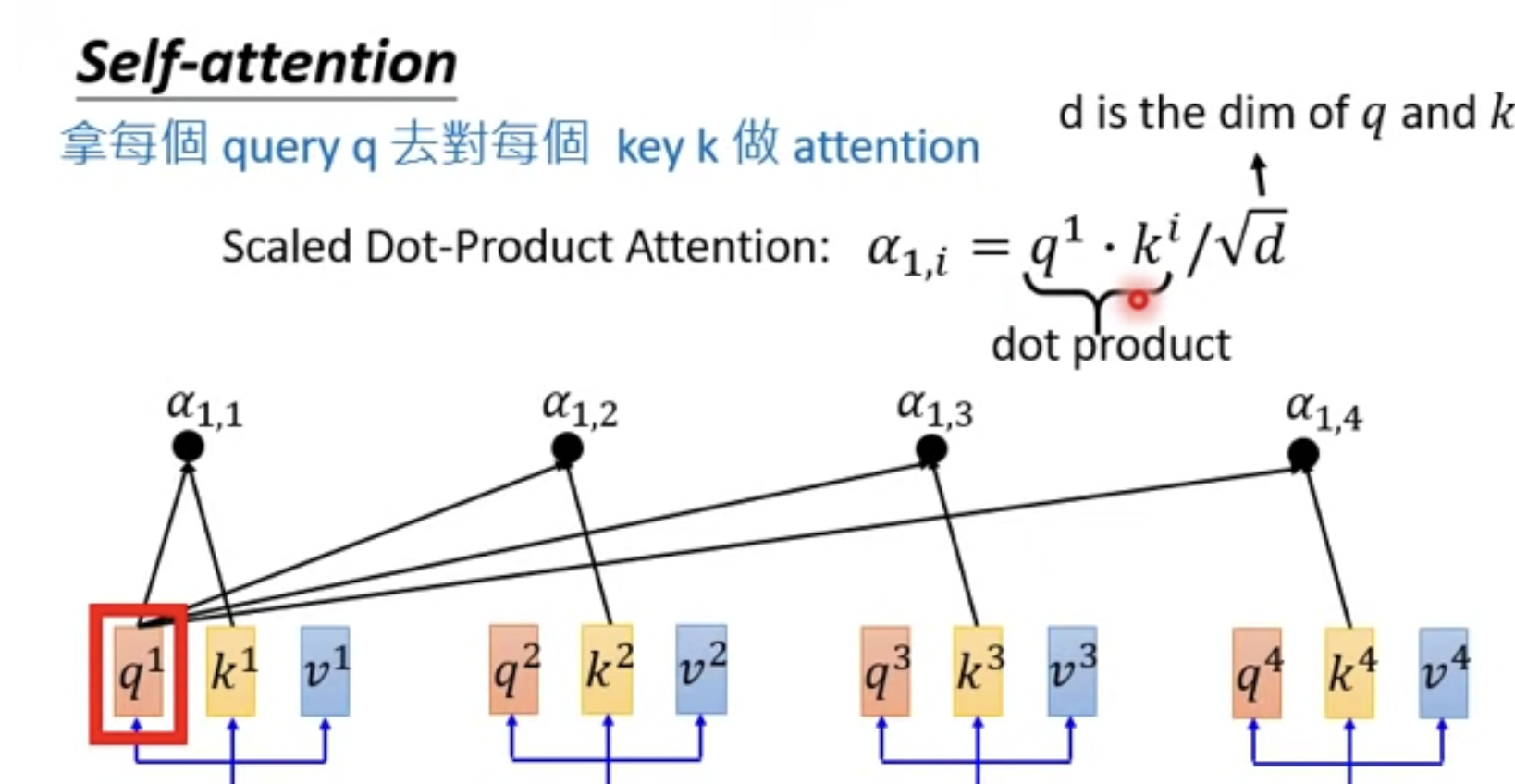

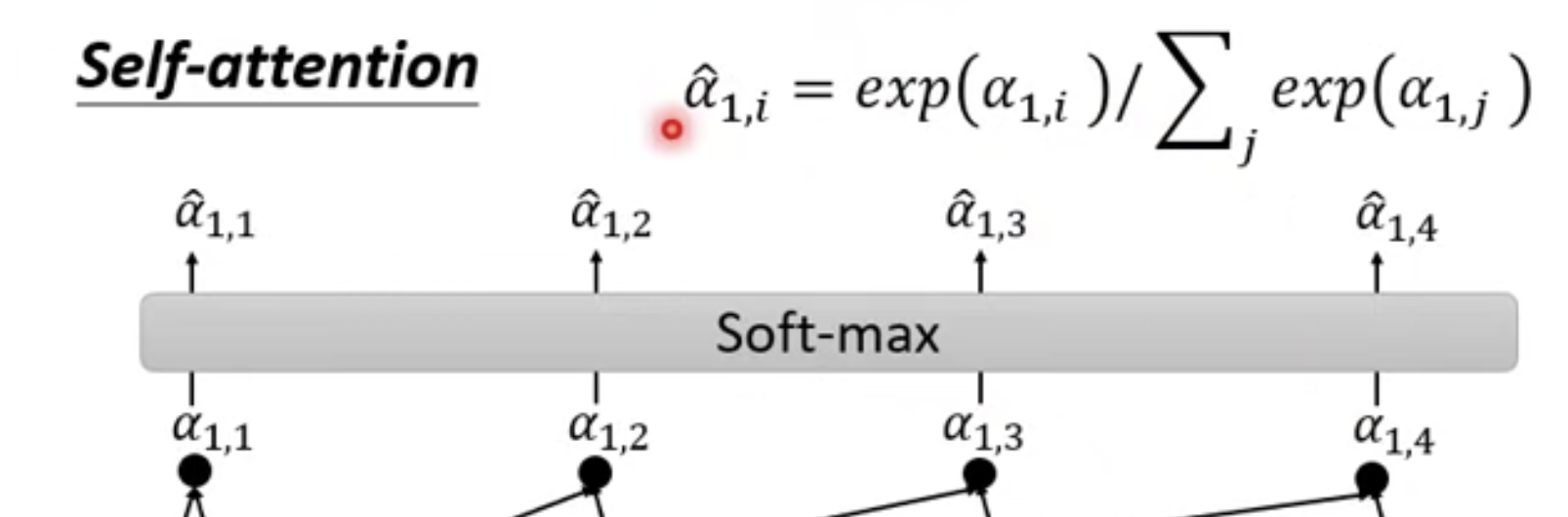

然后用每一个a 去对每个k 做attention

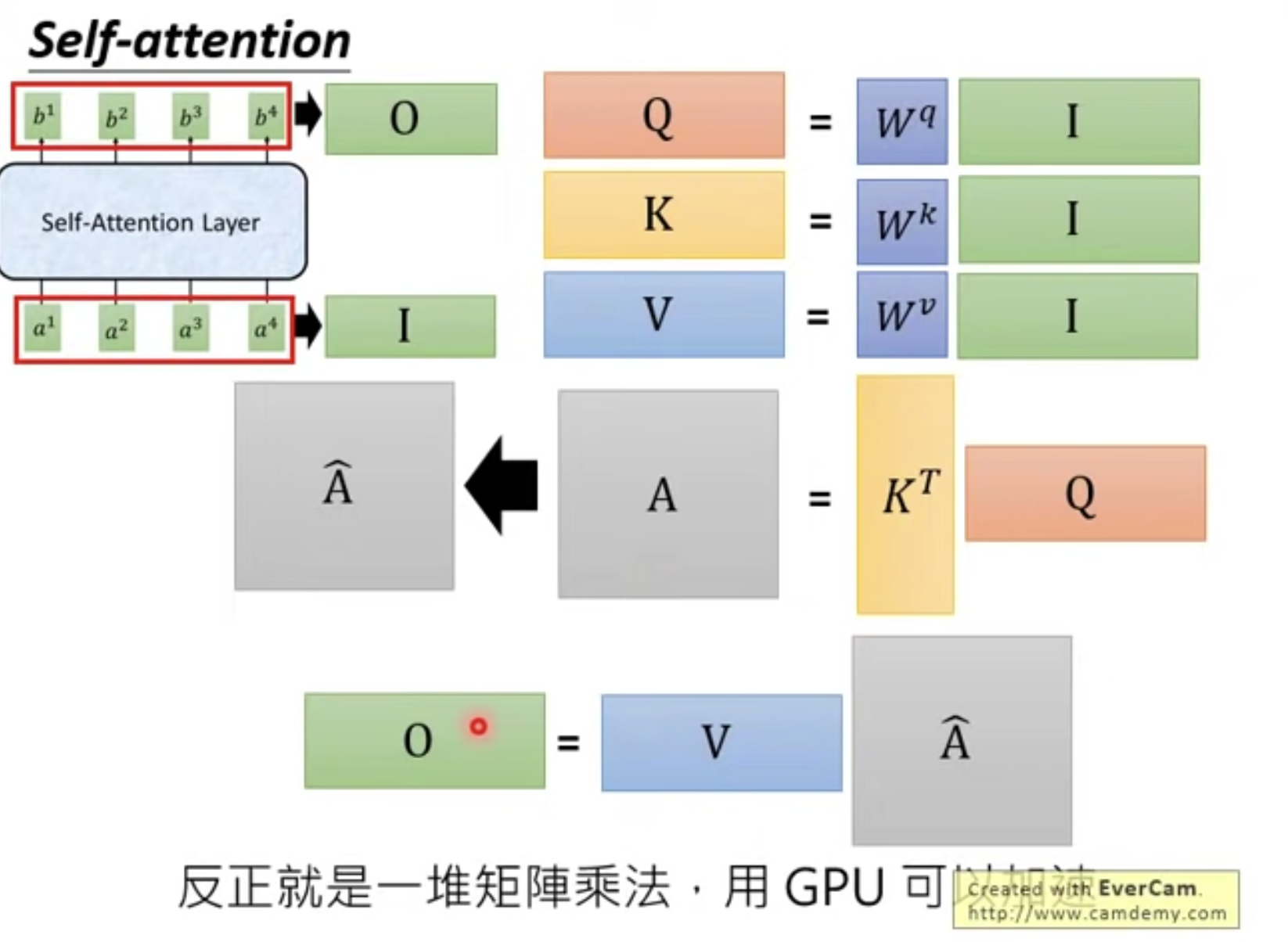

加速的矩阵乘法过程

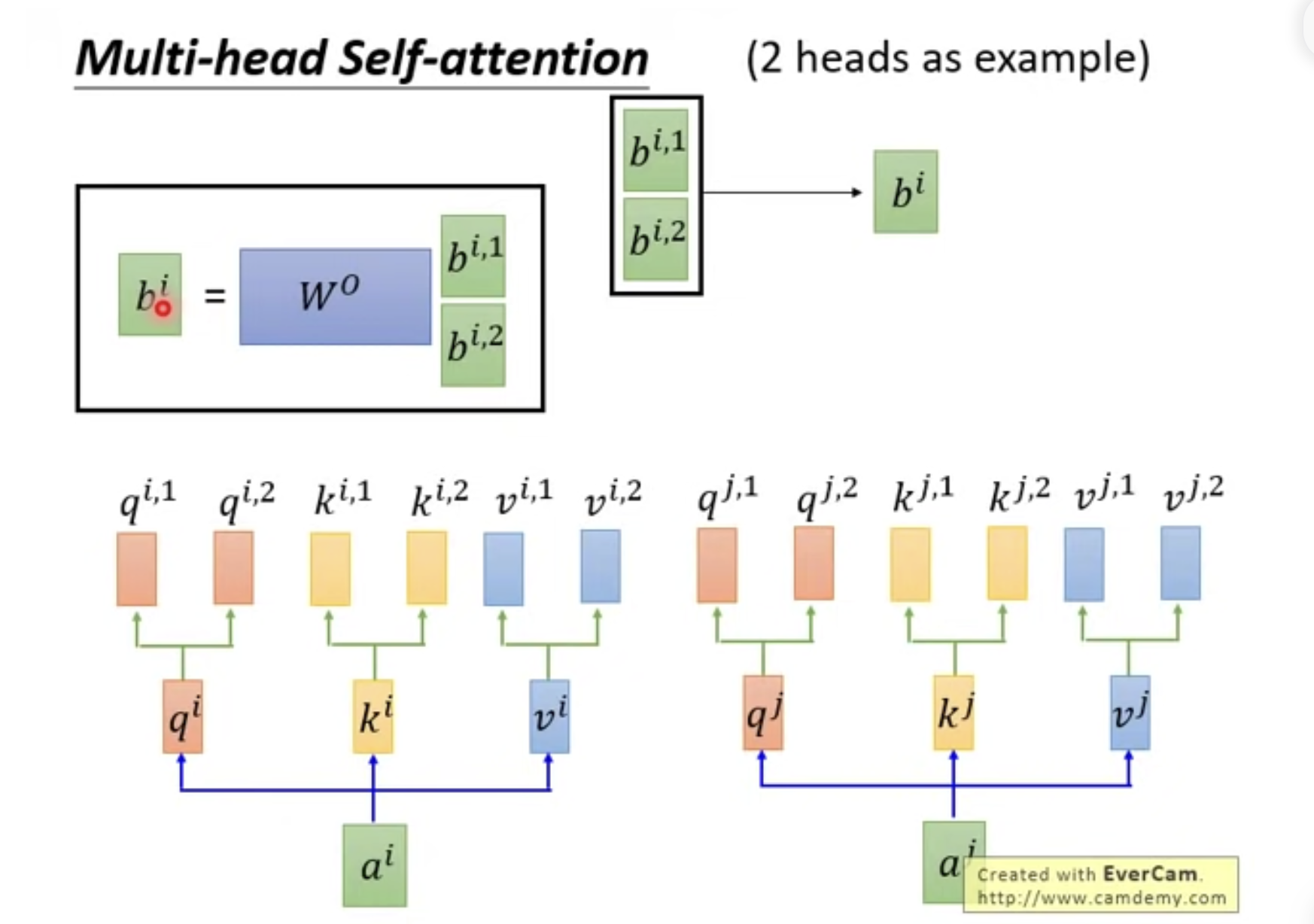

Multi-head self-attention

不同的head 可以关注不同的内容,达到一个更好的注意力效果。

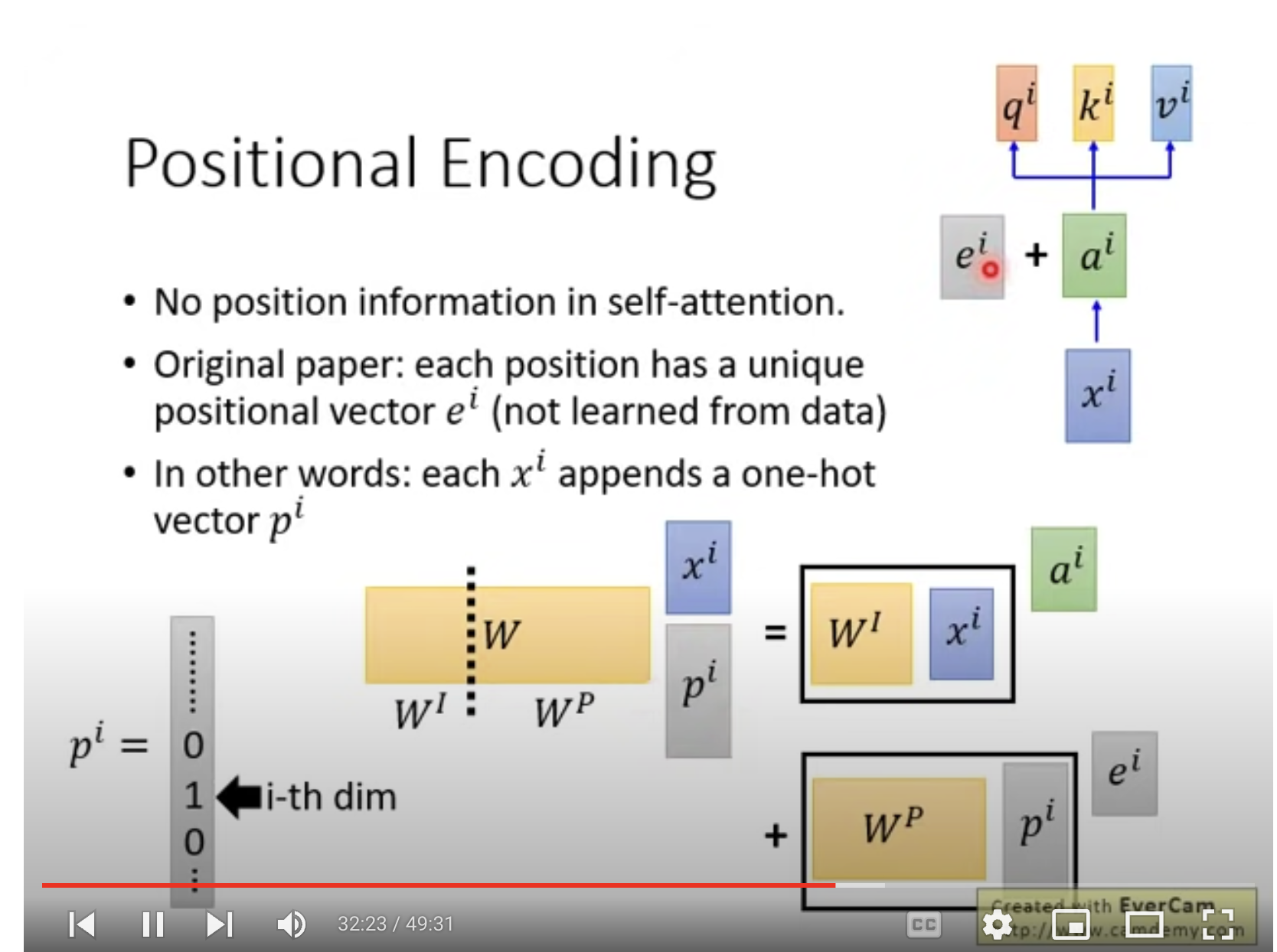

Positional encoding

self-attention 没有考虑位置信息。

因此需要再ai的同时加ei,表示位置信息,有人工控制。

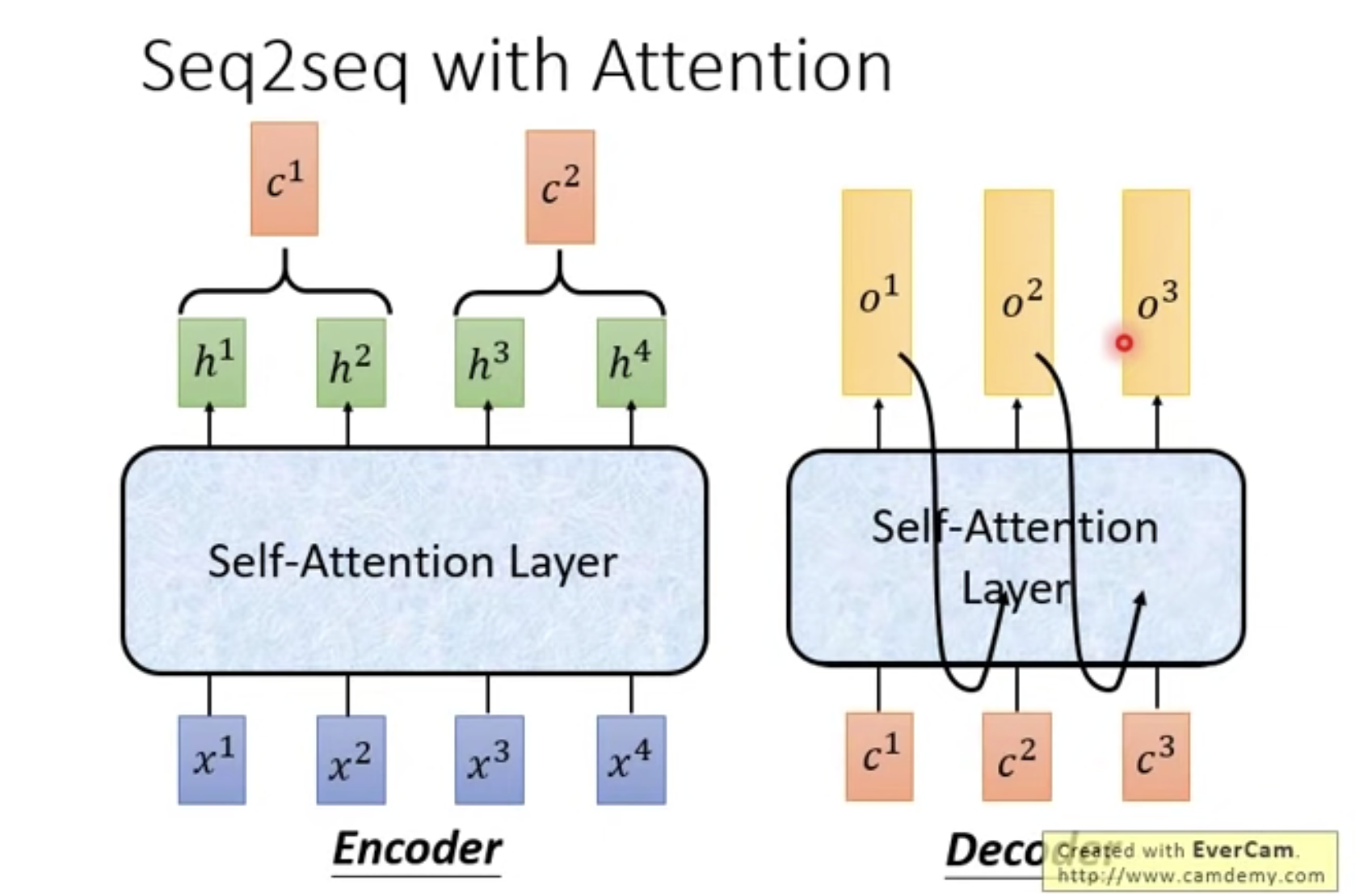

Seq2Seq with Attention

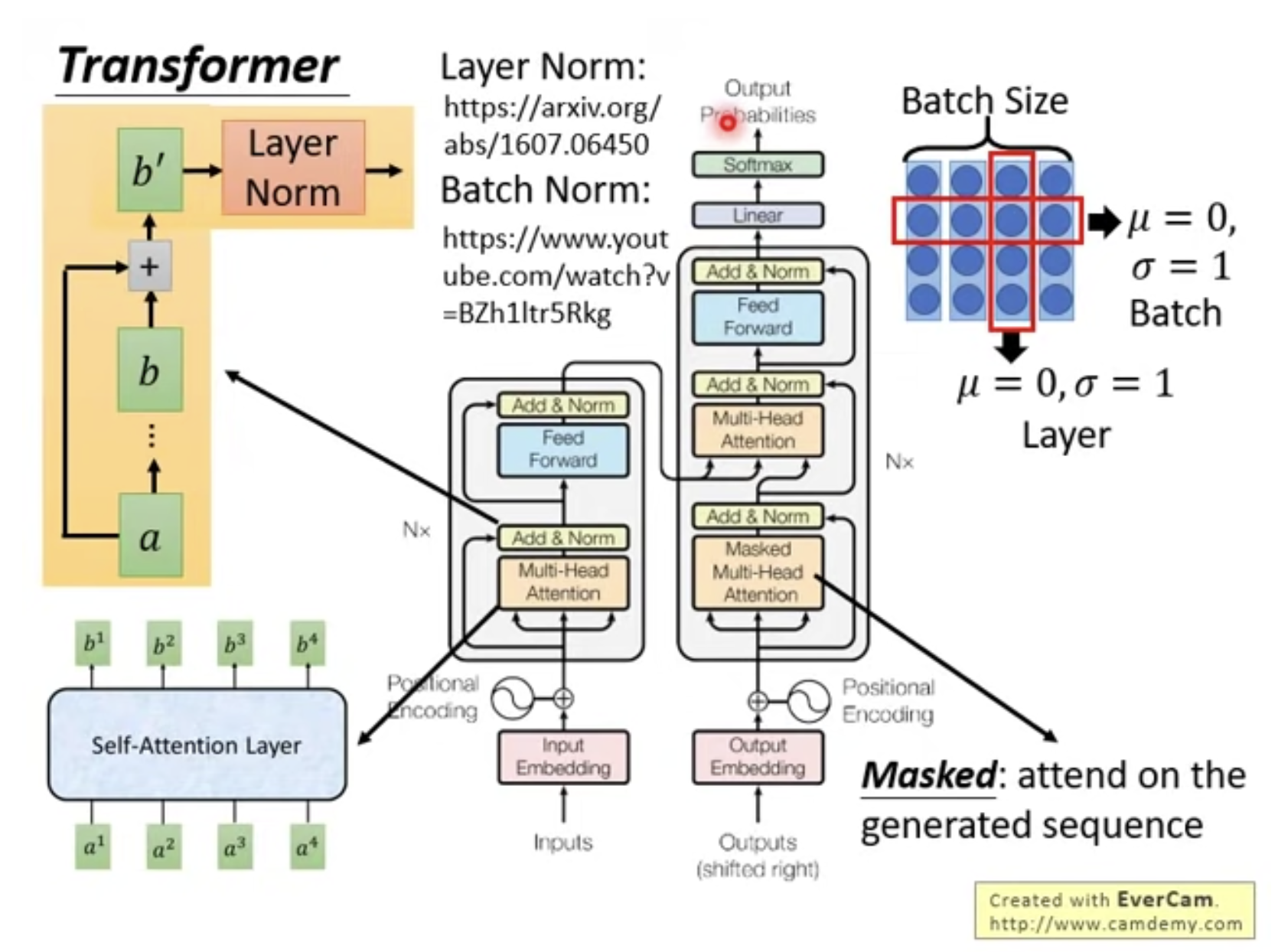

Transformer

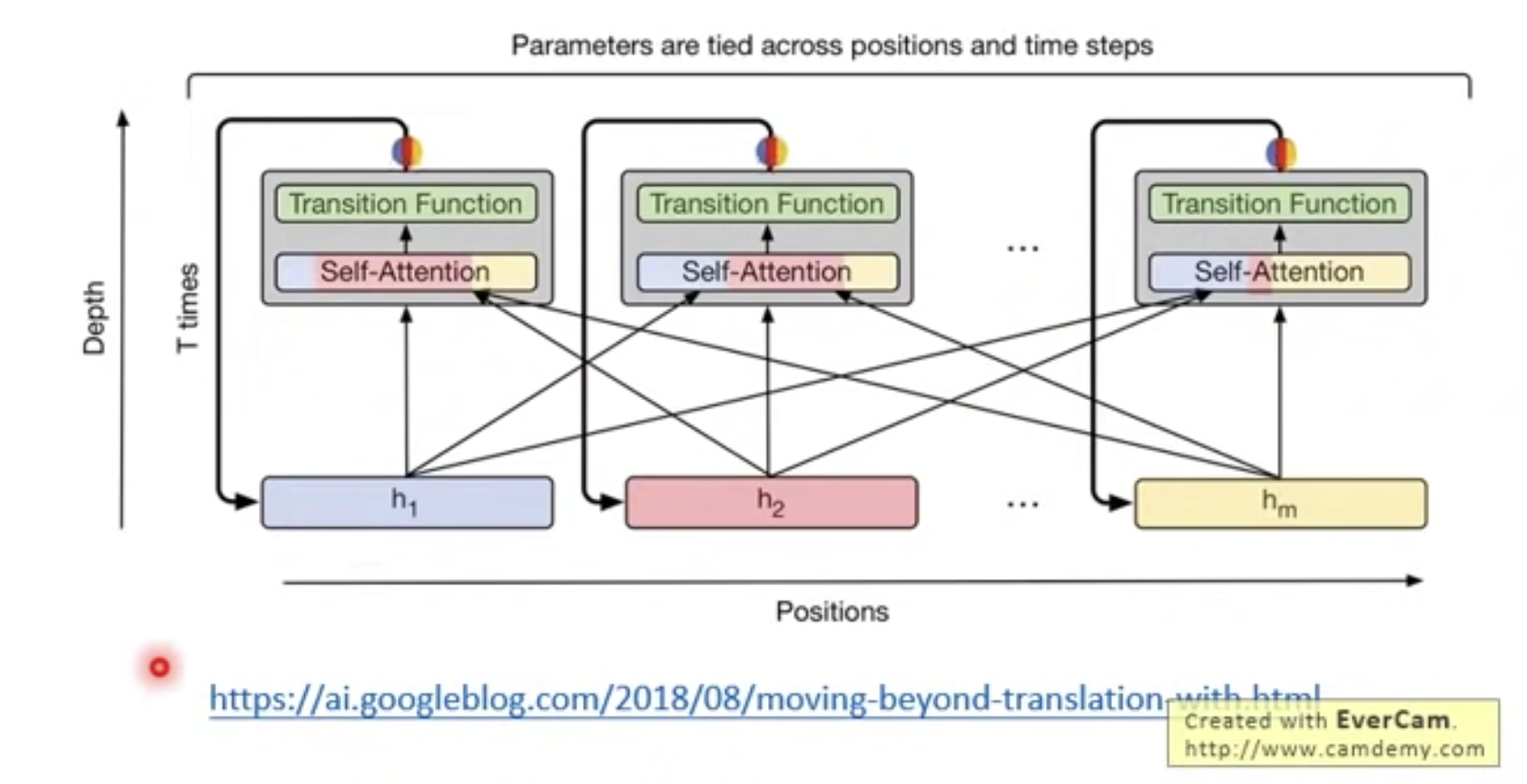

Universal Transformer