AI技术快讯:清华开源ChatGLM2双语对话语言模型

ChatGLM2-6B是一个开源项目,提供了ChatGLM2-6B模型的代码和资源。根据提供的搜索结果,以下是对该项目的介绍:

论文:https://arxiv.org/pdf/2103.10360.pdf

ChatGLM2-6B是一个开源的双语对话语言模型,是ChatGLM-6B模型的第二代版本。它保留了初代模型的对话流畅和部署门槛较低的特点,并引入了一些新的特性和改进。

ChatGLM2-6B具有以下特点和功能:

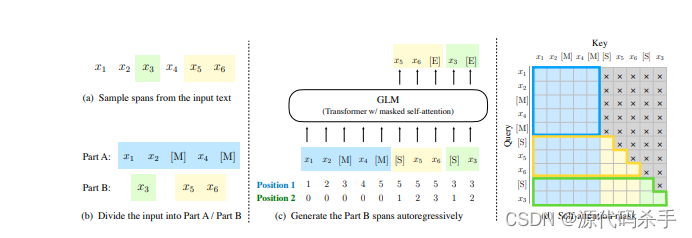

更强大的性能:ChatGLM2-6B使用了GLM的混合目标函数,并经过了大规模的预训练和人类偏好对齐训练。评测结果显示,在多个数据集上,ChatGLM2-6B相比初代模型在性能上有了显著的提升,具有较强的竞争力。

更长的上下文:通过引入FlashAttention技术,ChatGLM2-6B将基座模型的上下文长度从ChatGLM-6B的2K扩展到了32K,并在对话阶段使用8K的上下文长度进行训练。这使得ChatGLM2-6B能够处理更长的上下文信息。

更高效的推理:基于Multi-Query Attention技术,ChatGLM2-6B具有更高效的推理速度和更低的显存占用。在官方的模型实现下,ChatGLM2-6B相比初代模型的推理速度提升了42%,并且在INT4量化下,6G显存支持的对话长度从1K提升到了8K。

开放的协议:ChatGLM2-6B的权重对学术研究完全开放,并且在填写问卷进行登记后,也允许免费商业使用。

源码:https://github.com/THUDM/ChatGLM2-6B