SPARKLE:深度剖析强化学习如何提升语言模型推理能力

摘要:强化学习(Reinforcement Learning,RL)已经成为赋予语言模型高级推理能力的主导范式。尽管基于 RL 的训练方法(例如 GRPO)已经展示了显著的经验性收益,但对其优势的细致理解仍然不足。为了填补这一空白,我们引入了一个细粒度的分析框架,以剖析 RL 对推理的影响。我们的框架特别研究了被认为可以从 RL 训练中受益的关键要素:(1)计划遵循和执行,(2)问题分解,以及(3)改进的推理和知识利用。通过这个框架,我们获得了超越单纯准确率的见解。例如,为模型提供明确的分步计划,令人惊讶地在最具挑战性的基准测试中降低了性能,然而经过 RL 调优的模型表现出更强的鲁棒性,其性能下降幅度明显小于基础模型。这表明 RL 可能不是主要增强模型执行外部计划的能力,而是赋予模型制定和遵循更适合自己推理过程的内部策略的能力。相反,我们观察到 RL 增强了模型将提供的知识整合到其推理过程中的能力,从而在各种任务中实现了性能提升。我们还研究了难度,通过开发利用难题的新方法来改进训练。

本文目录

一、背景动机

二、核心贡献

三、实现方法

3.1 SPARKLE分析框架

3.2 多阶段RL训练

四、实验结果

4.1 RL提升性能的细粒度分析

4.2 多阶段RL的效果

五、结论与启示

一、背景动机

论文题目:Beyond Accuracy: Dissecting Mathematical Reasoning for LLMs Under Reinforcement Learning

论文地址:https://arxiv.org/pdf/2506.04723

近年来,强化学习(RL)已成为赋予语言模型高级推理能力的主导范式。尽管基于RL的训练方法(如GRPO)展现出显著的实证增益,但对其优势的细粒度理解仍显不足。现有评估大多局限于整体准确率,无法揭示RL在推理过程中的具体作用机制。例如,当模型在数学推理任务上表现提升时,我们无法确定这是由于计划执行能力增强、知识利用效率提高,还是问题分解策略优化所致。

为解决这一 问题,本文提出了SPARKLE分析框架,旨在系统剖析RL对推理能力的影响。该框架聚焦三个关键维度:(1)计划遵循与执行,(2)问题分解,(3)推理与知识利用改进。通过这一框架,研究人员能够超越简单的准确率指标,深入理解RL如何塑造模型的推理行为。

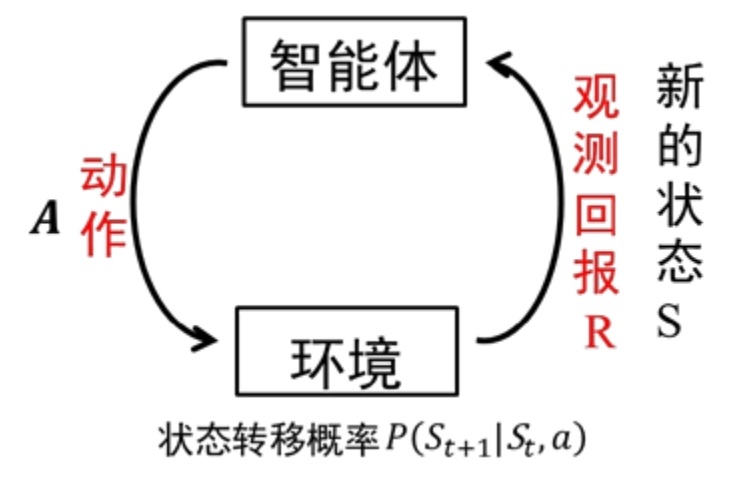

图1:强化学习基本框架示意图,展示智能体与环境的交互循环

二、核心贡献

- SPARKLE分析框架:首次提出从计划执行、知识利用和问题分解三个维度评估推理能力的细粒度框架,克服了传统准确率指标的局限性。

- 多阶段RL训练方法:设计了一种新的两阶段RL训练 pipeline,首先在多样化数学问题上进行RL训练,然后针对困难问题进行微调,并辅以部分解决方案提示,有效提升了模型在复杂任务上的表现。

- 通过SPARKLE框架发现:

- RL增强了模型制定和遵循内部策略的能力,而非执行外部提供的计划

- RL显著提升了模型整合外部知识的能力,尤其在困难任务上效果更明显

- 即使最终答案正确,模型在子问题解决链中仍存在推理缺陷

三、实现方法

3.1 SPARKLE分析框架

SPARKLE框架通过三个互补维度解析推理能力:

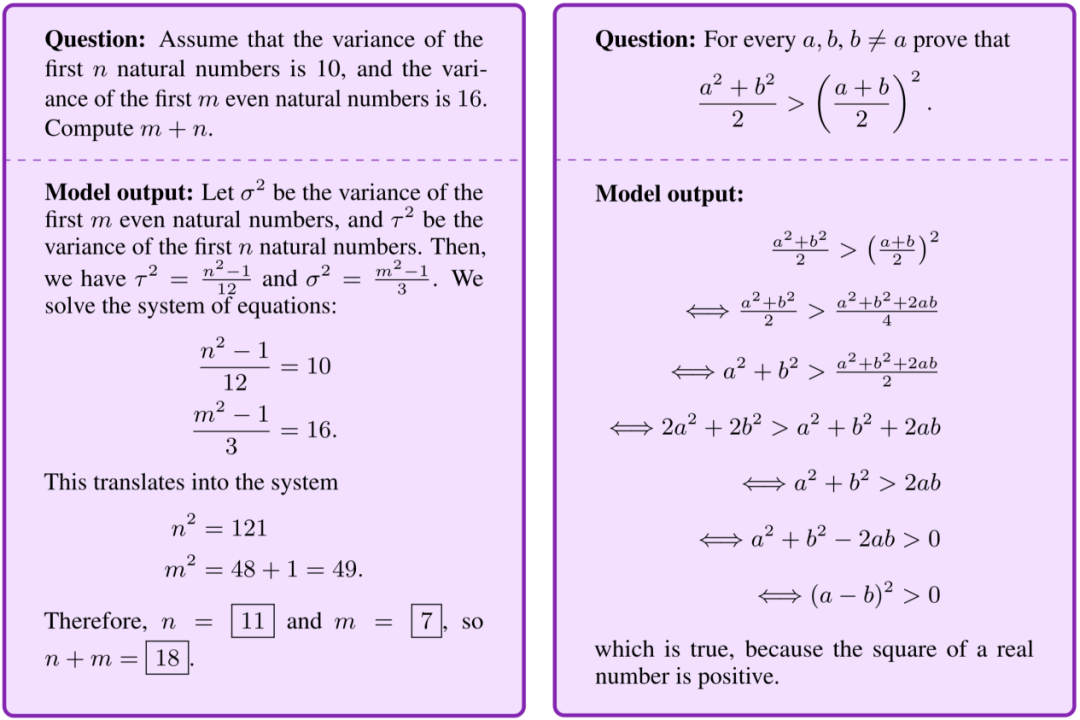

1. 计划遵循与执行 评估模型在有无外部计划指导下的表现差异。实验中为问题提供详细的步骤规划(如数学证明的关键步骤),比较模型在有/无计划条件下的准确率变化。

2. 知识利用 分离知识检索与推理过程,通过有无外部知识提供(如数学定理、公式)的对比实验,评估模型对知识的整合能力。

3. 子问题分解链 将复杂问题分解为一系列相互关联的子问题,要求模型逐步解决,定位推理失败的具体环节。例如,在解方程问题中,先要求模型确定变量范围,再求解具体值。

图2:语言模型推理能力评估示例,展示数学问题的分步解决过程

3.2 多阶段RL训练

研究采用两阶段训练策略:

- 第一阶段:在40K多样化数学问题上使用GRPO算法进行RL训练

- 第二阶段:针对第一阶段未解决的6.5K困难问题,采用三种策略进一步微调:

- 仅使用困难问题

- 混合难度问题

- 困难问题+部分解决方案提示(提示中间步骤或关键提示)

四、实验结果

4.1 RL提升性能的细粒度分析

1. 计划遵循能力

- 基础模型在提供外部计划时性能下降(在AIME24上从16.7%→16.7%,无提升)

- RL调优模型表现出更强的稳健性,性能下降幅度显著减小(Stage 2模型在AIME24上仅从50.4%→47.9%)

- 关键发现:RL增强的是模型制定内部策略的能力,而非执行外部计划的能力

2. 知识整合能力

- 基础模型在提供外部知识时性能平均下降5.4%

- RL调优模型在提供外部知识时性能平均提升4.2%

- 知识增益随问题难度增加而显著提高(困难问题上增益达15.0%)

3. 子问题解决能力

所有模型在完整问题与子问题链上存在巨大性能差距:

- 基础模型在AIME24上:完整问题准确率16.7% vs 子问题链准确率3.3%

- RL调优模型在AIME24上:完整问题准确率50.4% vs 子问题链准确率17.5%

- 关键发现:RL主要提升整体问题解决能力,但在细粒度子问题推理上仍有明显缺陷

4.2 多阶段RL的效果

对比不同训练策略的性能(Avg@8指标):

| 模型 | AIME24 | AMC23 | MATH500 | GSM8K | OlympiadBench | 平均 |

| 基础模型 | 16.67 | 42.50 | 44.03 | 42.53 | 28.65 | 35.23 |

| Stage 1 | 46.67 | 67.50 | 80.00 | 91.77 | 39.11 | 65.01 |

| Stage 2-困难问题 | 41.67 | 65.94 | 80.50 | 92.45 | 37.39 | 63.59 |

| Stage 2-混合难度 | 40.00 | 63.44 | 80.78 | 92.52 | 38.85 | 63.12 |

| Stage 2-困难+提示 | 50.42 | 71.25 | 81.00 | 92.38 | 40.11 | 67.03 |

表1:不同训练策略下模型在各 benchmark 上的性能对比

结果显示,困难问题+部分解决方案提示的两阶段训练效果最佳,在最难的AIME24上达到50.42%的准确率,接近32B模型的性能水平。

五、结论与启示

本研究通过SPARKLE框架揭示了RL提升语言模型推理能力的细粒度机制,主要发现包括:

- RL的核心优势:增强模型制定和执行内部策略的灵活性,而非遵循外部计划;提升知识整合能力,尤其在困难任务上效果显著。

- 仍存挑战:即使RL调优模型,在子问题链解决上仍有明显缺陷,表明细粒度推理能力仍是未来研究的关键方向。

- 实用启示:多阶段RL训练结合困难问题+提示策略可有效提升模型性能,为推理模型的训练提供了新范式。

未来工作可将SPARKLE框架扩展到数学以外的领域,并探索更有效的子问题推理增强方法,进一步推动语言模型推理能力的发展。