【机器学习深度学习】为什么要将模型转换为 GGUF 格式?

目录

前言

一. GGUF 格式的背景

二. GGUF 格式的优势

2.1 可扩展性

2.2 内存映射支持(mmap)

2.3 易于使用

2.4 模型信息的完整性

2.5 模型量化支持

三.GGUF格式核心优势对比

补充说明表格关键点

总结

前言

随着深度学习技术的快速发展,模型的规模和复杂度不断增加。对于开发者和研究人员来说,使用高效、易于管理和扩展的模型格式,成为了模型部署和使用的关键问题。在这一背景下,GGUF 格式应运而生,解决了传统深度学习模型格式中存在的诸多问题,成为了新一代模型存储和部署的首选格式。

一. GGUF 格式的背景

在传统的深度学习模型开发中,PyTorch、TensorFlow 等框架的模型通常需要依赖大量的库和工具,这在部署时会带来版本兼容、库依赖和资源管理等问题。为了克服这些挑战,开源社区推出了优化后的模型格式,如 GGML、GGMF 和 GGIT 等。而 GGUF(General Graph Unifying Format)则是在开源社区的持续迭代中,产生的一种全新格式。

GGUF 格式基于 GGJT(General Graph JSON Format)进行了优化,旨在解决以往格式的局限性,并提供更加灵活、高效的功能,使深度学习模型能更好地适应不同的使用场景。

二. GGUF 格式的优势

2.1 可扩展性

GGUF 格式的最大优势之一就是其 可扩展性。

它允许开发者轻松为模型添加新功能或新特性,而不会破坏现有模型的兼容性。比如:

-

新功能的添加:你可以为模型增加新的算法或优化方法,且不会影响之前的模型版本。

-

硬件支持扩展:支持未来硬件的不断发展,能够快速适应新的计算平台。

与传统的格式相比,GGUF 提供了更加灵活的架构,能够快速适应技术的更新换代。

2.2 内存映射支持(mmap)

GGUF 格式在性能方面也做了显著优化,尤其是在 内存映射(mmap) 支持方面。

-

提高加载速度:模型通过 mmap 技术加载文件时,可以像操作内存一样快速地访问和处理数据。

-

节省资源:内存映射使得模型的内存使用更加高效,避免了传统方法中因加载大规模模型而带来的内存浪费。

这种优化非常适合需要快速加载和高效存储的大规模深度学习模型。

2.3 易于使用

GGUF 格式非常简洁,使用少量代码就能轻松加载和存储模型,无需依赖复杂的库。这使得 GGUF 格式特别适合跨平台和跨编程语言的开发环境。

-

简化依赖:不需要安装额外的框架和库。

-

跨语言支持:支持多种编程语言,包括 Python、C++、Java 等。

开发者只需几行代码,即可在不同平台上完成模型的加载和使用。

2.4 模型信息的完整性

GGUF 格式的一大亮点是 模型信息的完整性。

与传统格式不同,GGUF 将所有加载模型所需的信息都包含在文件中,无需额外编写配置文件。比如:

-

模型架构、参数、优化方法等信息

-

所有依赖的设置都已封装在模型文件中

这意味着,在使用 GGUF 格式时,开发者无需管理复杂的配置文件,简化了开发和部署过程。

2.5 模型量化支持

随着模型规模的增大,GPU 内存(VRAM) 成为了一大瓶颈。为了解决这个问题,GGUF 格式支持 模型量化,包括 4 位、8 位和 16 位量化方式。

-

降低内存占用:通过量化技术,减少模型占用的显存,尤其适合在硬件资源有限的情况下使用。

-

保持精度:即便在量化后,模型仍然可以保持较高的精度。

量化技术不仅提升了硬件利用率,还降低了运行成本,使得大规模模型部署变得更加高效。

三.GGUF格式核心优势对比

| 核心痛点 | GGUF解决方案 | 技术优势 | 用户价值 |

|---|---|---|---|

| 依赖复杂 (PyTorch部署困难) | 极致的易用性 | 轻量级/无依赖加载器(如llama.cpp) 跨语言支持(Python/C++/Rust/JS等) 简洁API(数行代码加载模型) | ✅ 免环境配置 ✅ 快速集成 ✅ 多平台兼容 |

| 版本锁死 (旧格式扩展性差) | 卓越的可扩展性 | 向前兼容设计 支持动态添加新特性/元数据 不破坏旧模型读取能力 | 🔄 生态持续进化 🚫 无需频繁转换格式 💡 无缝兼容新工具 |

| 加载效率低 (大模型启动慢) | mmap内存映射支持 | 操作系统按需加载权重 多进程共享物理内存 近乎零等待启动 | ⚡ 秒级加载模型 📉 内存占用降低70%+ 💻 支持超大模型运行 |

| 信息分散 (需额外配置文件) | 模型自包含 | 内置架构/上下文长度/分词器配置 完整量化元数据(类型/粒度) 作者/许可证等丰富信息 | 📦 单文件部署 🚫 免配置文件 🔒 减少出错风险 |

| 量化支持弱 (资源成本高昂) | 原生量化支持 | 多精度原生支持(Q4_K_M/Q5_K_S/F16等) 细粒度混合量化(张量/层级) 自动化量化工具链 | 🚀 推理速度提升3-5倍 💾 VRAM占用减少50-75% 💰 降低GPU成本 |

补充说明表格关键点

-

量化类型示例

-

Q4_K_M:4位中粒度量化(平衡精度/速度) -

Q5_K_S:5位小粒度量化(更高精度) -

F16:半精度浮点(GPU高效运行)

-

-

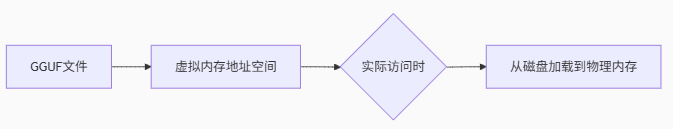

mmap技术原理

3.典型应用场景

| 角色 | GGUF价值 |

|---|---|

| 模型发布者 | 单文件分发,降低用户使用门槛 |

| 应用开发者 | 10行代码集成,免依赖部署 |

| 终端用户 | 消费级GPU/CPU流畅运行70B+大模型 |

此表格说明:GGUF通过技术革新彻底解决了传统格式的部署瓶颈,成为开源大模型部署的事实标准。其核心价值在于将复杂的模型部署简化为“单文件+轻量加载器”的极致体验,同时通过量化与内存映射显著降低资源消耗。

总结

随着深度学习模型的日益庞大,传统的模型格式在管理和部署上面临越来越多的挑战。GGUF 格式作为一种新兴的模型存储格式,凭借其在可扩展性、内存映射支持、易用性、模型信息完整性和量化支持等方面的优势,逐渐成为了深度学习开发者和研究人员的首选格式。

-

高效管理:减少了版本管理和库依赖带来的困扰。

-

快速加载:通过内存映射和简洁的代码实现,提高了模型的加载速度。

-

节省资源:量化技术大幅度减少了硬件资源的占用,降低了运行成本。

对于深度学习的应用场景,GGUF 格式的出现无疑是一次技术飞跃。如果你也在从事深度学习模型的开发或部署工作,GGUF 格式无疑是一个值得关注并尝试的技术选择。

结语:

GGUF 格式为深度学习模型的管理、部署和扩展提供了一种更加高效和灵活的方式。随着深度学习技术的不断发展,GGUF 格式将在模型的优化、部署和应用中发挥越来越重要的作用。