针对BERT模型的理解

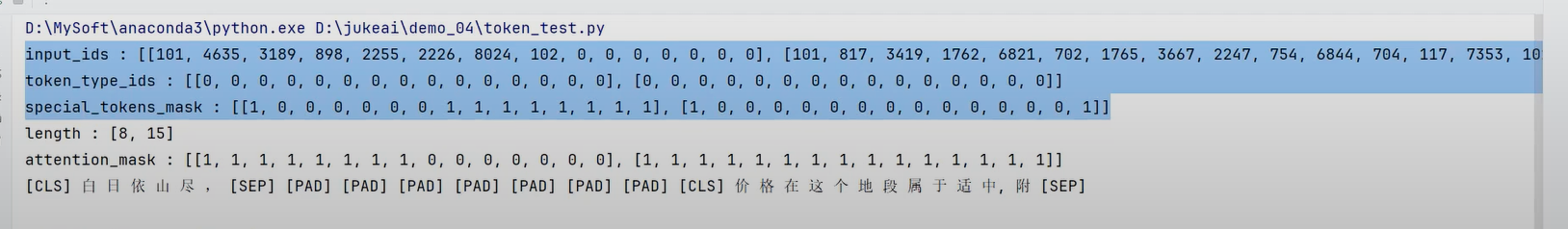

这段代码和输出展示了使用BERT(Bidirectional Encoder Representations from Transformers)或其他类似的预训练模型进行文本处理时的一些关键概念。让我们逐一解析这些概念:

-

input_ids:这是输入文本被转换成的数字序列,每个数字代表一个词汇在词表中的位置。例如,

[101, 4635, 3189, ...]表示第一个句子被编码后的结果,其中101通常代表特殊标记[CLS],用于分类任务;而0可能代表填充标记[PAD],用于将所有输入调整到相同的长度。 -

token_type_ids:这个列表用于区分句子对中的不同句子。在处理单句时,它通常是全零数组,如图中所示。但在处理两个句子时,第一个句子的所有token会被标记为0,第二个句子的所有token会被标记为1,以帮助模型理解句子之间的关系。

-

special_tokens_mask:这个掩码用于标识特殊标记的位置,如

[CLS]、[SEP]和[PAD]。在图示的例子中,[1, 0, 0, ..., 1]表明第一个和最后一个位置是特殊标记,其余位置是普通文本。 -

length:这表示原始文本的实际长度,不包括填充的部分。在这个例子中,两个句子的实际长度分别是8和15个token。

-

attention_mask:这个掩码用于告诉模型哪些部分是有效的输入,哪些是填充。对于有效的token,其值为1;对于填充部分,其值为0。这样可以避免模型在计算注意力时考虑填充部分。

-

最后一行显示了原始文本及其对应的特殊标记。

[CLS]和[SEP]是BERT模型中用于开始和结束句子的特殊标记,而[PAD]用于填充,使所有输入具有相同的长度。

通过这些信息,我们可以看到模型如何处理和理解输入文本,这对于自然语言处理任务,如文本分类、情感分析等,至关重要。

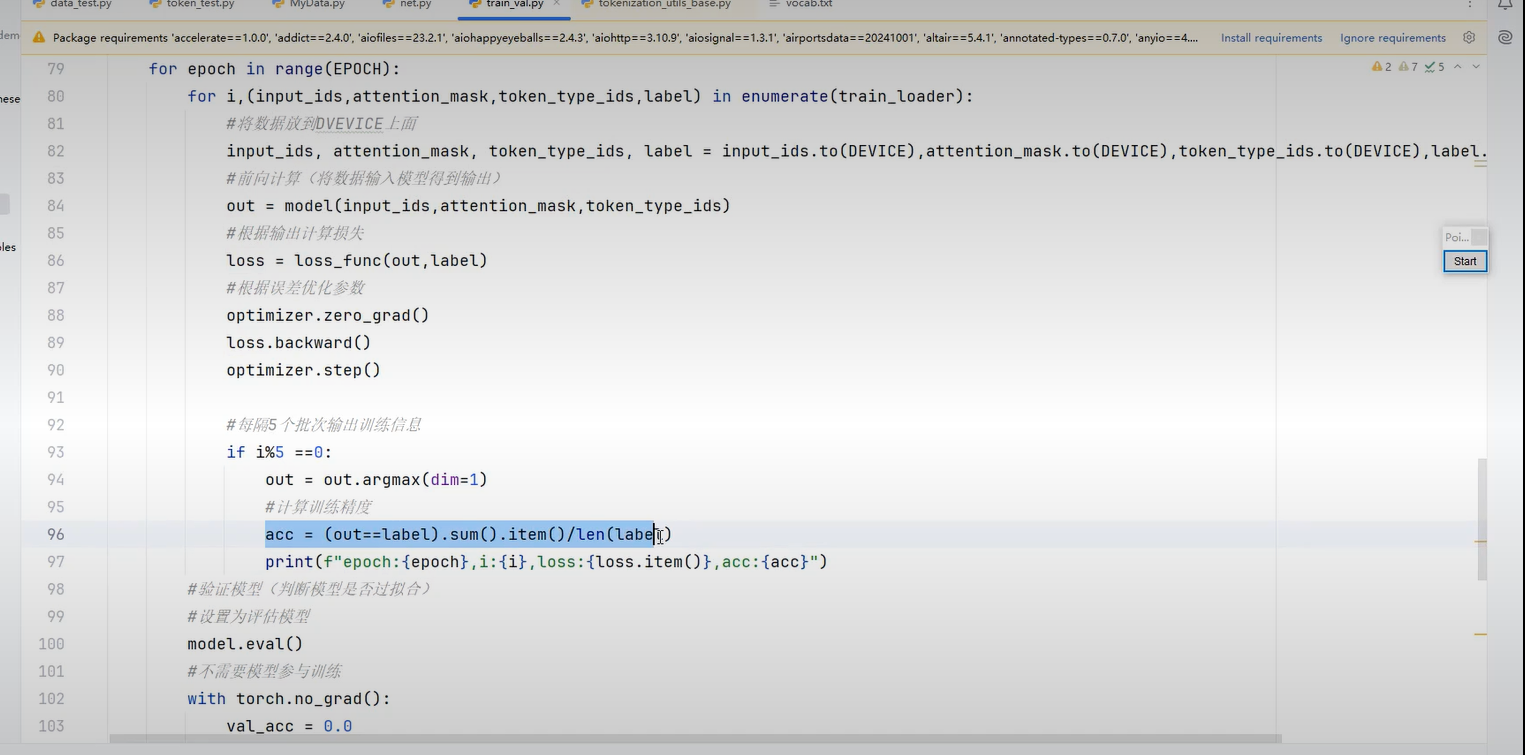

这段代码展示了一个典型的深度学习模型训练过程,特别是针对自然语言处理任务。让我们逐行解析其内容:

-

for epoch in range(EPOCH): 这行代码表示整个训练过程将进行EPOCH次迭代,每次迭代称为一个epoch。

-

for i, (input_ids, attention_mask, token_type_ids, label) in enumerate(train_loader): 这里使用了Python的

enumerate函数来遍历数据加载器(train_loader),它会返回每个批次的数据和对应的索引i。每个批次包含四个部分:input_ids、attention_mask、token_type_ids和label,这些是预处理后的输入数据和标签。 -

input_ids, attention_mask, token_type_ids, label = input_ids.to(DEVICE), attention_mask.to(DEVICE), token_type_ids.to(DEVICE), label.to(DEVICE): 这一步将所有数据转移到指定的设备上(如GPU),以便加速计算。

-

out = model(input_ids, attention_mask, token_type_ids): 将处理好的数据输入到模型中,得到模型的输出。

-

loss = loss_func(out, label): 计算模型输出与真实标签之间的损失,这是评估模型性能的关键指标。

-

optimizer.zero_grad(): 在每次反向传播之前,清空优化器的梯度信息,防止累积。

-

loss.backward(): 执行反向传播,计算损失相对于模型参数的梯度。

-

optimizer.step(): 根据计算出的梯度更新模型参数,这是模型学习的过程。

-

if i%5 == 0: 每隔5个批次打印一次训练信息,包括当前epoch、批次编号、损失值和准确率。

-

acc = (out.argmax(dim=1)==label).sum().item()/len(label): 计算模型预测的准确率,通过比较模型输出的最大值位置与真实标签是否一致来实现。

-

model.eval() 和 with torch.no_grad(): 在验证阶段,设置模型为评估模式,并禁用梯度计算,以节省内存和提高速度。

这段代码是一个标准的训练循环,包含了前向传播、损失计算、反向传播和参数更新等关键步骤,同时在训练过程中定期输出训练状态,帮助监控模型的学习进度。