Kubeadm搭建K8S

目录

一、部署步骤

1、实验环境

2、环境准备

3、所有节点安装Docker

4、 所有节点配置K8S源

5、所有节点安装kubeadm,kubelet和kubectl

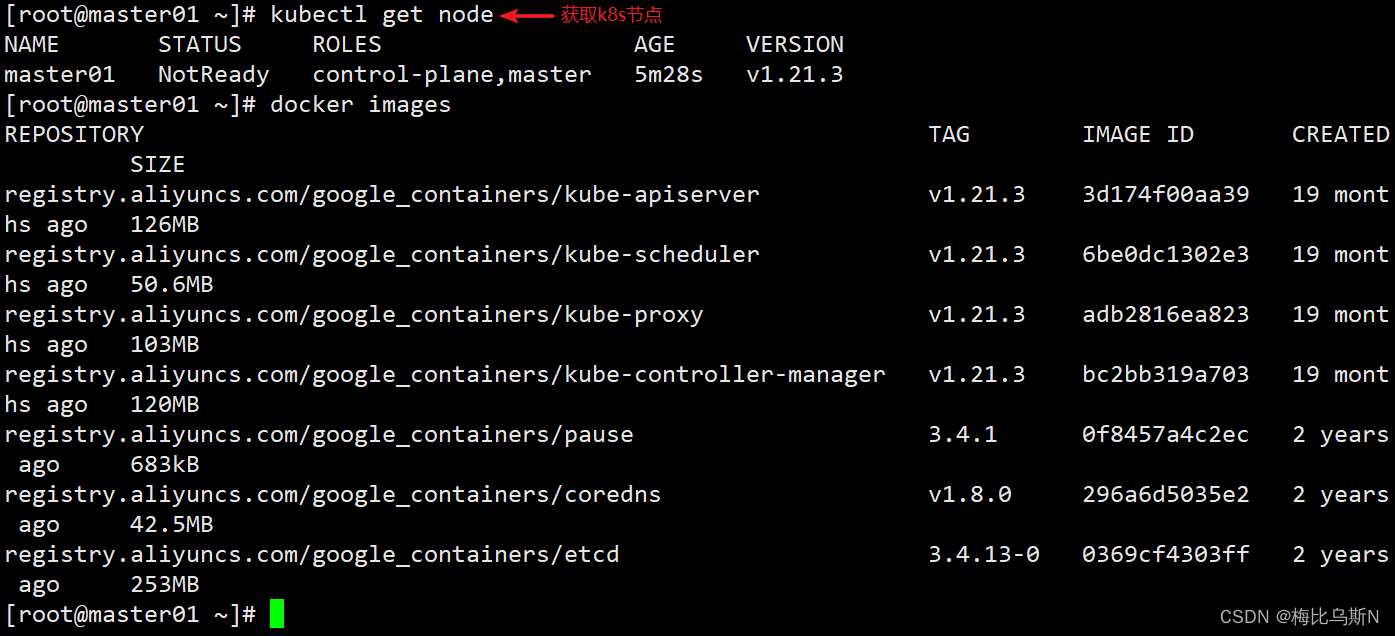

6、部署 kubernetes Master 节点

7、token制作

8、k8s-node节点加入master节点

9、 master节点安装部署pod网络插件(flannel)

10、给node节点添加标签

11、master检查

12、查询服务是否正常

13、 测试 k8s 集群,在集群中创建一个 pod,验证是否能正常运行

一、部署步骤

1、实验环境

| 服务器类型 | IP地址 |

|---|---|

| master | 192.168.80.5 |

| node01 | 192.168.80.8 |

| node02 | 192.168.80.9 |

2、环境准备

所有节点,关闭防火墙规则,关闭selinux,关闭swap交换

#所有节点,关闭防火墙规则,关闭selinux,关闭swap交换

systemctl stop firewalld

systemctl disable firewalld

setenforce 0

iptables -F && iptables -t nat -F && iptables -t mangle -F && iptables -X

swapoff -a #交换分区必须要关闭

sed -ri 's/.*swap.*/#&/' /etc/fstab #永久关闭swap分区,&符号在sed命令中代表上次匹配的结果修改主机名,并写入三台服务器的host中

cat >> /etc/hosts << EOF

192.168.80.5 master

192.168.80.8 node01

192.168.80.9 node02

EOF调整内核参数,将桥接的 IPV4 流量传递到 iptables 链

#调整内核参数cat > /etc/sysctl.d/kubernetes.conf << EOF

net.bridge.bridge-nf-call-ip6tables=1

net.bridge.bridge-nf-call-iptables=1

net.ipv6.conf.all.disable_ipv6=1

net.ipv4.ip_forward=1

EOF#加载参数

sysctl --system

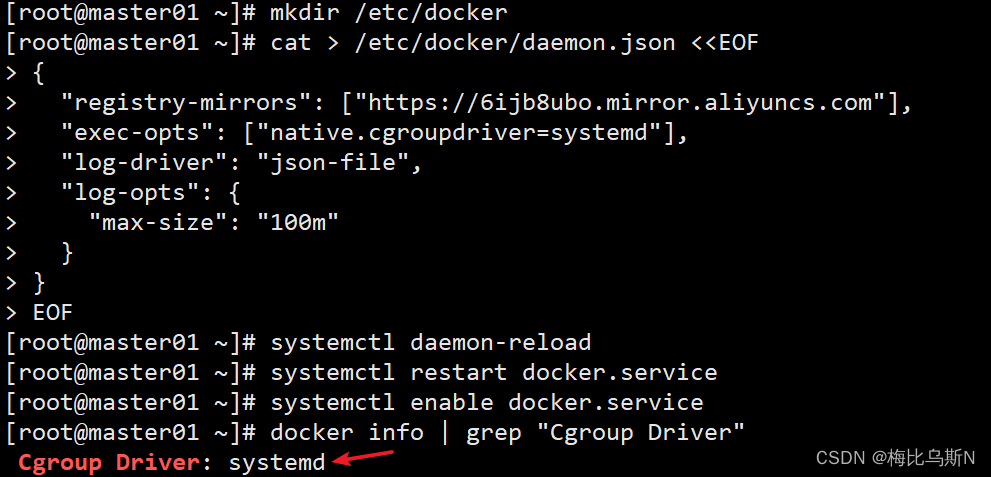

3、所有节点安装Docker

yum install -y yum-utils device-mapper-persistent-data lvm2

yum-config-manager --add-repo https://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo

yum install -y docker-ce docker-ce-cli containerd.iomkdir /etc/docker

cat > /etc/docker/daemon.json <<EOF

{"exec-opts": ["native.cgroupdriver=systemd"],"log-driver": "json-file","log-opts": {"max-size": "100m"}

}

EOFsystemctl daemon-reload

systemctl restart docker.service

systemctl enable docker.servicedocker info | grep "Cgroup Driver"

4、 所有节点配置K8S源

#定义kubernetes源

cat > /etc/yum.repos.d/kubernetes.repo << EOF

[kubernetes]

name=Kubernetes

baseurl=https://mirrors.aliyun.com/kubernetes/yum/repos/kubernetes-el7-x86_64

enabled=1

gpgcheck=0

repo_gpgcheck=0

gpgkey=https://mirrors.aliyun.com/kubernetes/yum/doc/yum-key.gpg https://mirrors.aliyun.com/kubernetes/yum/doc/rpm-package-key.gpg

EOF5、所有节点安装kubeadm,kubelet和kubectl

yum install -y kubelet-1.21.3 kubeadm-1.21.3 kubectl-1.21.3#开机自启kubelet

systemctl enable kubelet.service

systemctl start kubelet

#K8S通过kubeadm安装出来以后都是以Pod方式存在,即底层是以容器方式运行,所以kubelet必须设置开机自启6、部署 kubernetes Master 节点

master 节点上执行

kubeadm init \

--apiserver-advertise-address=192.168.80.5 \

--image-repository registry.aliyuncs.com/google_containers \

--kubernetes-version v1.21.3 \

--service-cidr=10.96.0.0/12 \

--pod-network-cidr=10.244.0.0/16可选参数:

--apiserver-advertise-address:apiserver通告给其他组件的IP地址,一般应该为Master节点的用于集群内部通信的IP地址,0.0.0.0表示节点上所有可用地址

--apiserver-bind-port:apiserver的监听端口,默认是6443

--cert-dir:通讯的ssl证书文件,默认/etc/kubernetes/pki

--control-plane-endpoint:控制台平面的共享终端,可以是负载均衡的ip地址或者dns域名,高可用集群时需要添加

--image-repository:拉取镜像的镜像仓库,默认是k8s.gcr.io

--kubernetes-version:指定kubernetes版本

--pod-network-cidr:pod资源的网段,需与pod网络插件的值设置一致。Flannel网络插件的默认为10.244.0.0/16,Calico插件的默认值为192.168.0.0/16;

--service-cidr:service资源的网段

--service-dns-domain:service全域名的后缀,默认是cluster.local

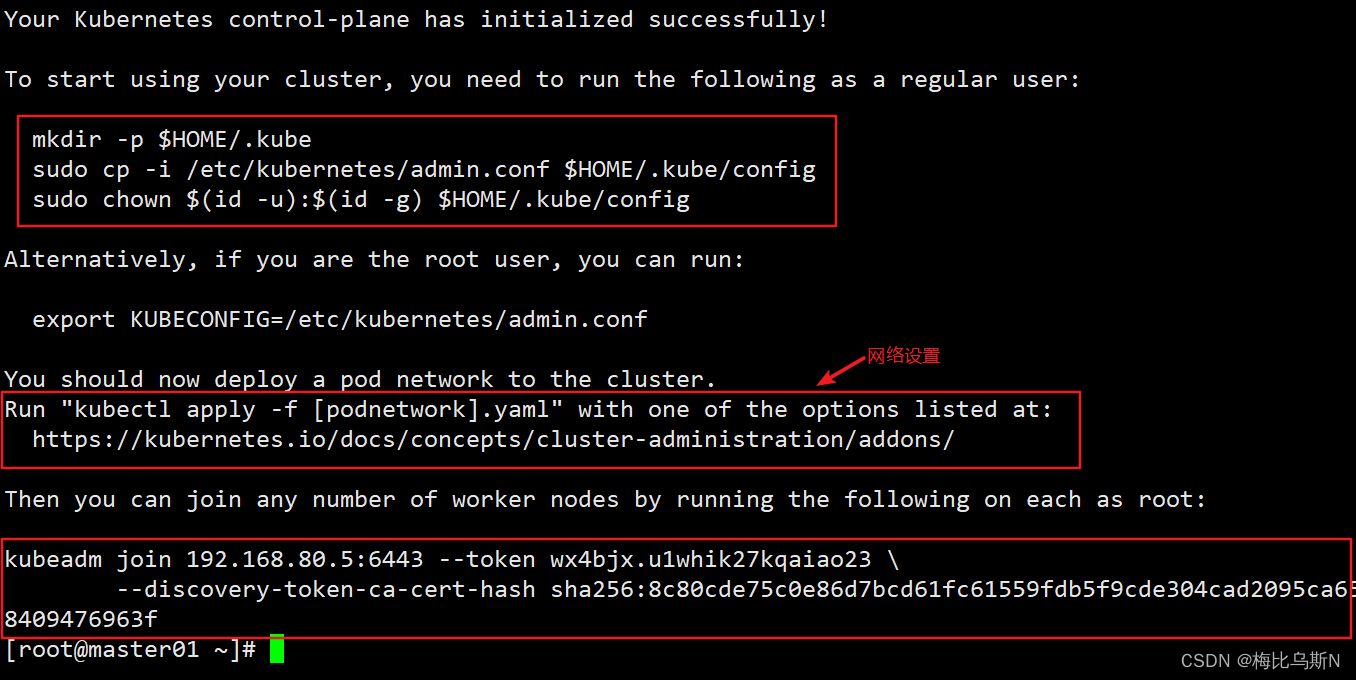

执行以下命令可使用kubectl管理工具

mkdir -p $HOME/.kube

sudo cp -i /etc/kubernetes/admin.conf $HOME/.kube/config

sudo chown $(id -u):$(id -g) $HOME/.kube/config

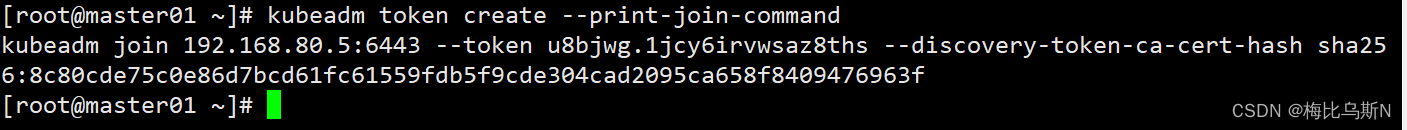

7、token制作

kubeadm token create --print-join-command

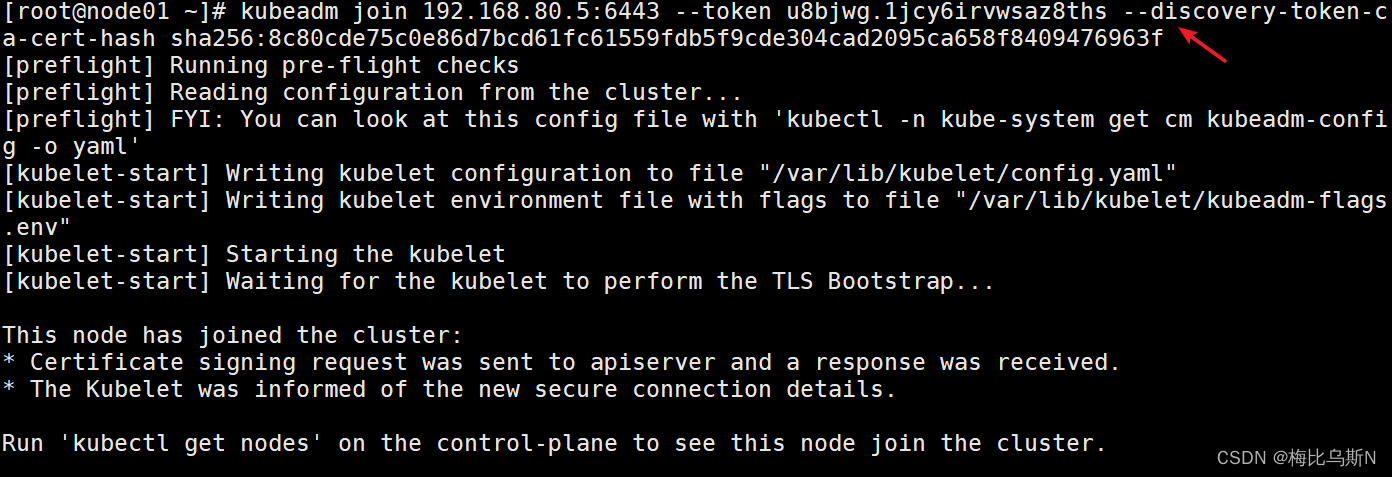

8、k8s-node节点加入master节点

两个node执行(这里只举例一个)

获取前面创建好的token令牌

kubeadm join 192.168.80.5:6443 --token u8bjwg.1jcy6irvwsaz8ths --discovery-token-ca-cert-hash sha256:8c80cde75c0e86d7bcd61fc61559fdb5f9cde304cad2095ca658f8409476963f

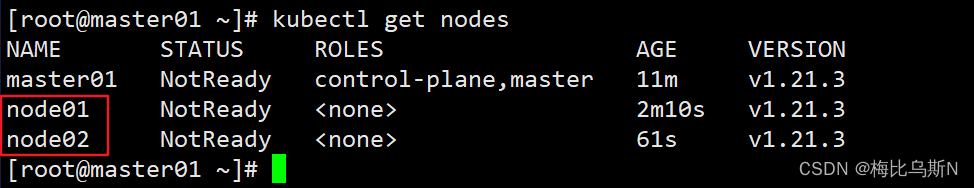

节点显示 NotReady 状态,需要安装网络插件

9、 master节点安装部署pod网络插件(flannel)

所有节点上传flannel镜像 flannel.tar 到 /opt 目录,master节点上传 kube-flannel.yml 文件

wget https://raw.githubusercontent.com/coreos/flannel/master/Documentation/kube-flannel.yml在 master 节点创建 flannel 资源

kubectl apply -f kube-flannel.yml

如果kube-flannel没有成功运行,解决办法:

#修改flannel插件文件,这个版本比较低,高版本k8s尽量选择一些高一些的版本flannel

sed -i -r "s#quay.io/coreos/flannel:.*-amd64#lizhenliang/flannel:v0.12.0-amd64#g" kube-flannel.yamlkubectl apply -f kube-flannel.yaml

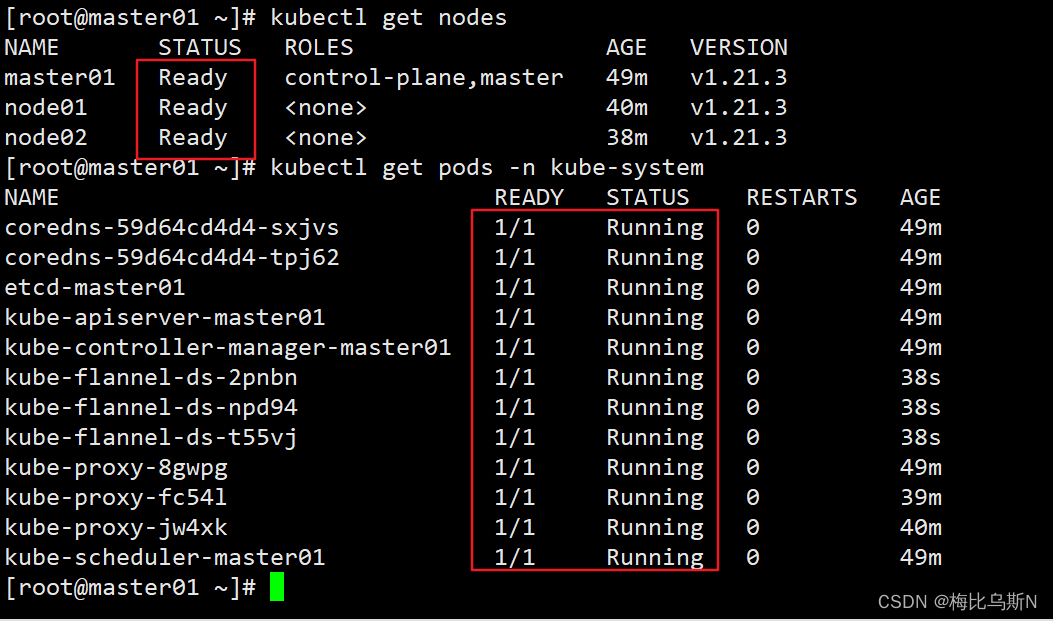

kubectl get pods -n kube-system

kubectl get node #部署好网络插件,node 准备就绪10、给node节点添加标签

kubectl label node node01 node-role.kubernetes.io/node=node1

kubectl label node node02 node-role.kubernetes.io/node=node2

#获取节点信息

kubectl get nodes11、master检查

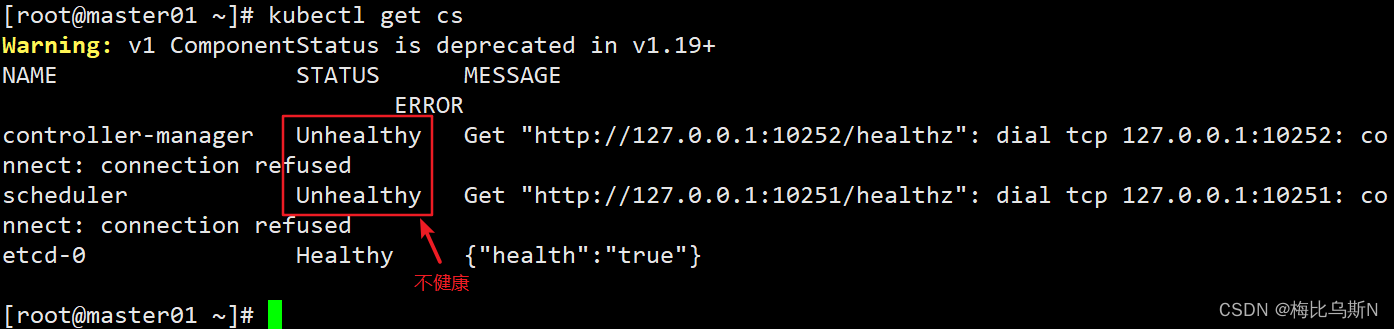

#查询master是否正常

kubectl get cs

#若为unhealthy

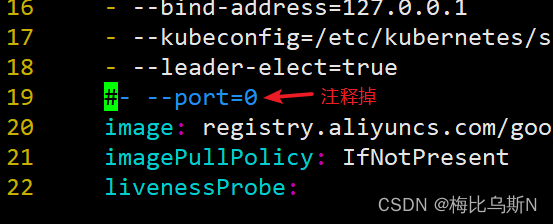

vim /etc/kubernetes/manifests/kube-scheduler.yaml

vim /etc/kubernetes/manifests/kube-controller-manager.yaml

#将- --port=0注释掉

12、查询服务是否正常

监测K8s集群是否正常后,再运行服务部署

#查询所有pod是否正常运行

kubectl get pods -A

#查询master是否正常

kubectl get cs

#查询node节点是否ready

kubectl get nodes

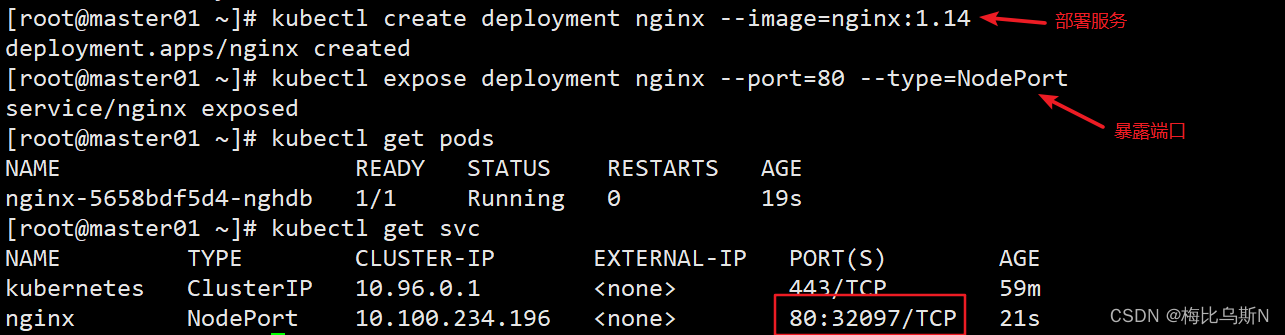

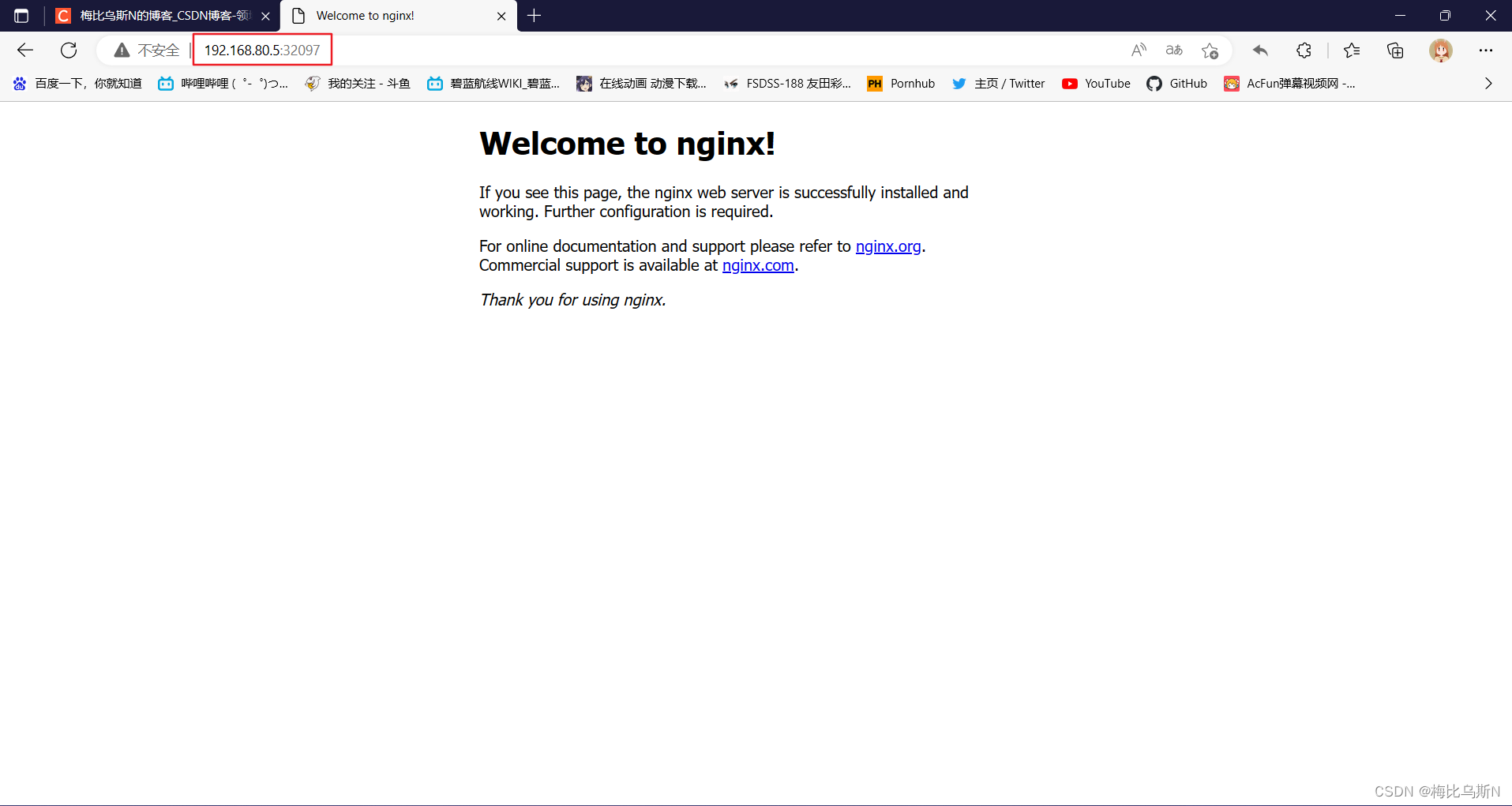

13、 测试 k8s 集群,在集群中创建一个 pod,验证是否能正常运行

#部署服务

kubectl create deployment nginx --image=nginx:1.14

#暴露端口

kubectl expose deployment nginx --port=80 --type=NodePort

kubectl get pods

kubectl get svc