深入理解数据分析的使用流程:从数据准备到洞察挖掘

数据分析是企业和技术团队实现价值的核心。 5 秒内你能否让数据帮你做出决策? 通过本文,我们将深入探讨如何将原始数据转化为有意义的洞察,帮助你快速掌握数据分析的关键流程。

目录

- 数据分析的五个核心步骤

- 1. 数据获取

- 常用数据获取方式

- 2. 数据清洗

- 常见数据清洗步骤:

- 3. 数据转换

- 数据标准化

- 特征工程

- 4. 数据建模

- 选择模型

- 5. 数据展示与洞察

- 示例代码:

- 结论

无论你是大数据开发者、数据科学家,还是企业决策者,理解并掌握高效的数据分析流程都至关重要。今天我们将剖析一个简化而详细的流程,通过具体案例带你逐步深入,直至掌握数据分析的核心要义。

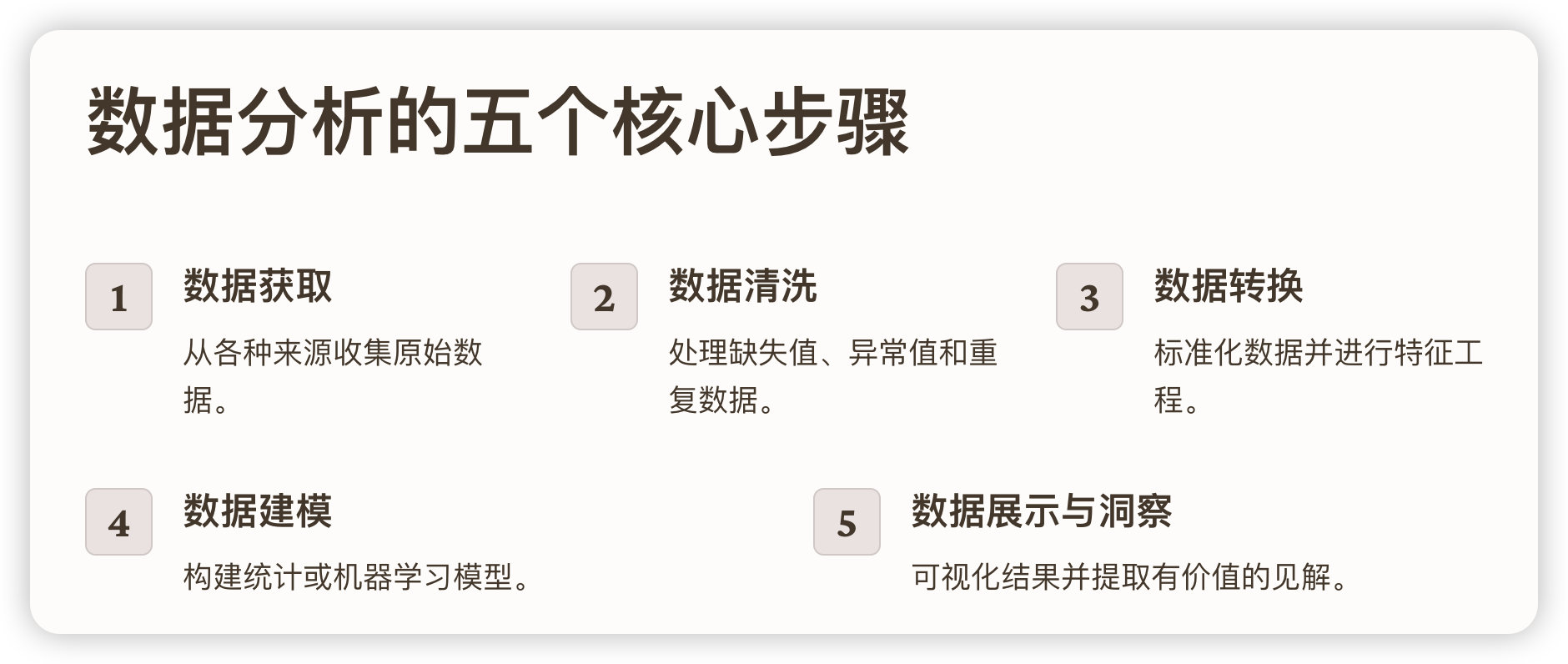

数据分析的五个核心步骤

数据分析可以被拆分为五个主要步骤:

- 数据获取

- 数据清洗

- 数据转换

- 数据建模

- 数据展示与洞察

每一步都承载着不同的目标和挑战,我们将逐步展开讨论。

1. 数据获取

数据分析的第一步是收集和获取数据,这可以是从API接口、数据库、或者是直接读取本地的文件。这是整个流程的基础,确保数据来源的可靠性至关重要。

常用数据获取方式

- 数据库查询:使用SQL从关系型数据库中提取数据。

- API调用:通过API获取外部数据。

- 文件读取:例如CSV文件、Excel文件等。

示例代码:

import pandas as pd# 从本地读取CSV文件

data = pd.read_csv('data.csv')# 从SQL数据库中查询数据

import sqlalchemy

engine = sqlalchemy.create_engine('mysql+pymysql://user:password@localhost/db_name')

df = pd.read_sql('SELECT * FROM table_name', con=engine)

在数据获取的阶段,你需要确认数据的准确性与时效性,确保后续分析不会因数据质量问题受阻。

2. 数据清洗

数据清洗是数据分析中不可或缺的一步,主要包括缺失值处理、异常值处理、重复数据删除等。数据清洗直接决定了模型分析结果的可靠性。

常见数据清洗步骤:

- 缺失值处理:填补缺失值或删除含有缺失值的记录。

- 异常值处理:检测并处理明显异常的数据点。

- 重复数据处理:删除数据集中可能存在的重复记录。

示例代码:

# 检查缺失值

print(data.isnull().sum())# 删除缺失值

data_cleaned = data.dropna()# 填充缺失值

data_filled = data.fillna(method='ffill')# 删除重复值

data_deduped = data.drop_duplicates()

这一步的目标是将原始数据转化为高质量、整洁的数据集,为后续的建模和分析打下坚实的基础。

3. 数据转换

在数据清洗之后,你可能需要对数据进行转换,使其适合分析。数据转换包括数据标准化、特征工程、类别数据编码等。

数据标准化

标准化是指将数据转化为相同量纲,以避免某些特征因值域较大对模型产生过大影响。

示例代码:

from sklearn.preprocessing import StandardScaler# 对数值特征进行标准化

scaler = StandardScaler()

data_scaled = scaler.fit_transform(data[['feature1', 'feature2']])

特征工程

特征工程是通过选择、创建和转换特征来增强模型的表现力。包括生成衍生变量、类别数据的数值化等。

示例代码:

# One-hot编码

data_encoded = pd.get_dummies(data, columns=['categorical_feature'])

有效的特征工程可以极大地提升分析的精度,帮助模型更好地理解数据的内在关系。

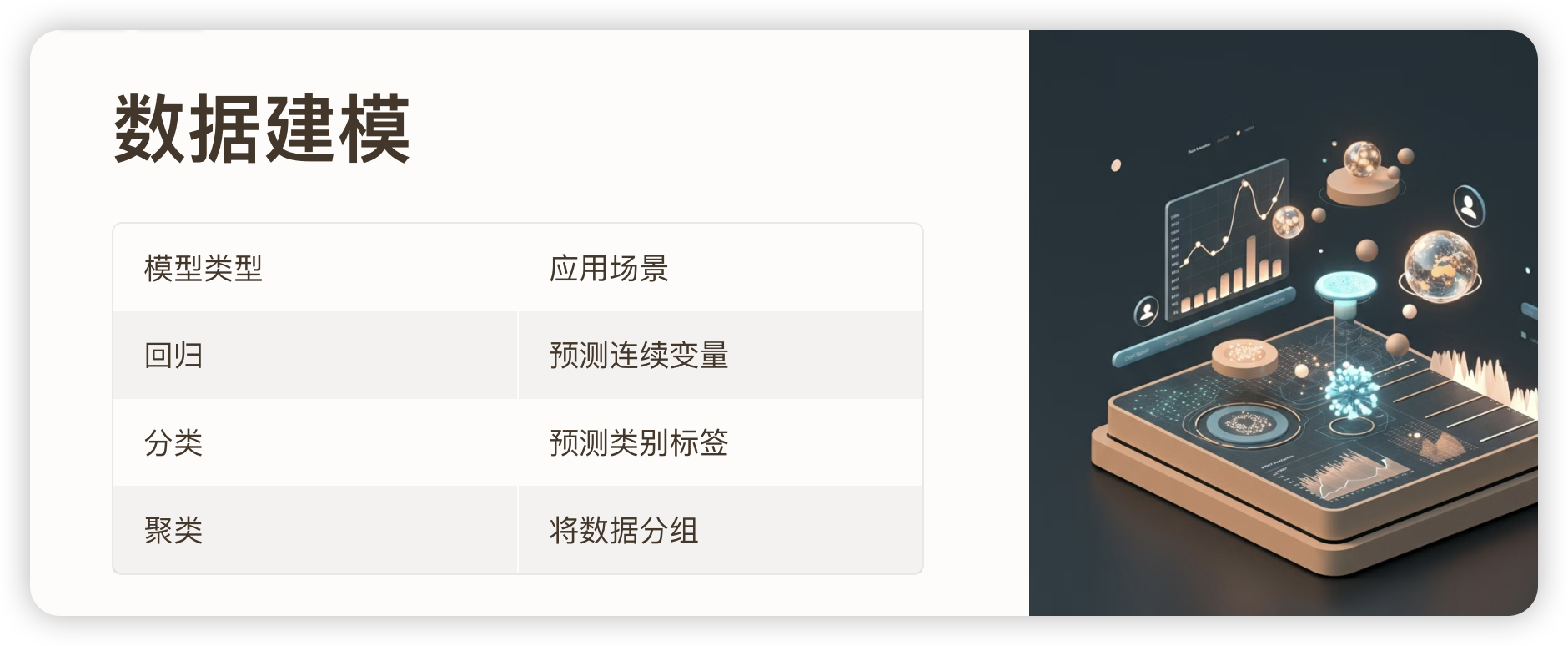

4. 数据建模

数据建模是通过构建统计模型或机器学习模型来对数据进行预测、分类或聚类等操作。根据你的业务目标,可以选择不同的建模方法,如回归、分类、聚类等。

选择模型

不同的分析目标需要选择合适的模型。例如:

- 回归:用于预测连续变量。

- 分类:用于预测类别标签。

- 聚类:用于将数据分组。

示例代码:

from sklearn.linear_model import LinearRegression

from sklearn.model_selection import train_test_split# 数据划分为训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(data_scaled, target, test_size=0.2, random_state=42)# 构建线性回归模型

model = LinearRegression()

model.fit(X_train, y_train)# 预测

y_pred = model.predict(X_test)

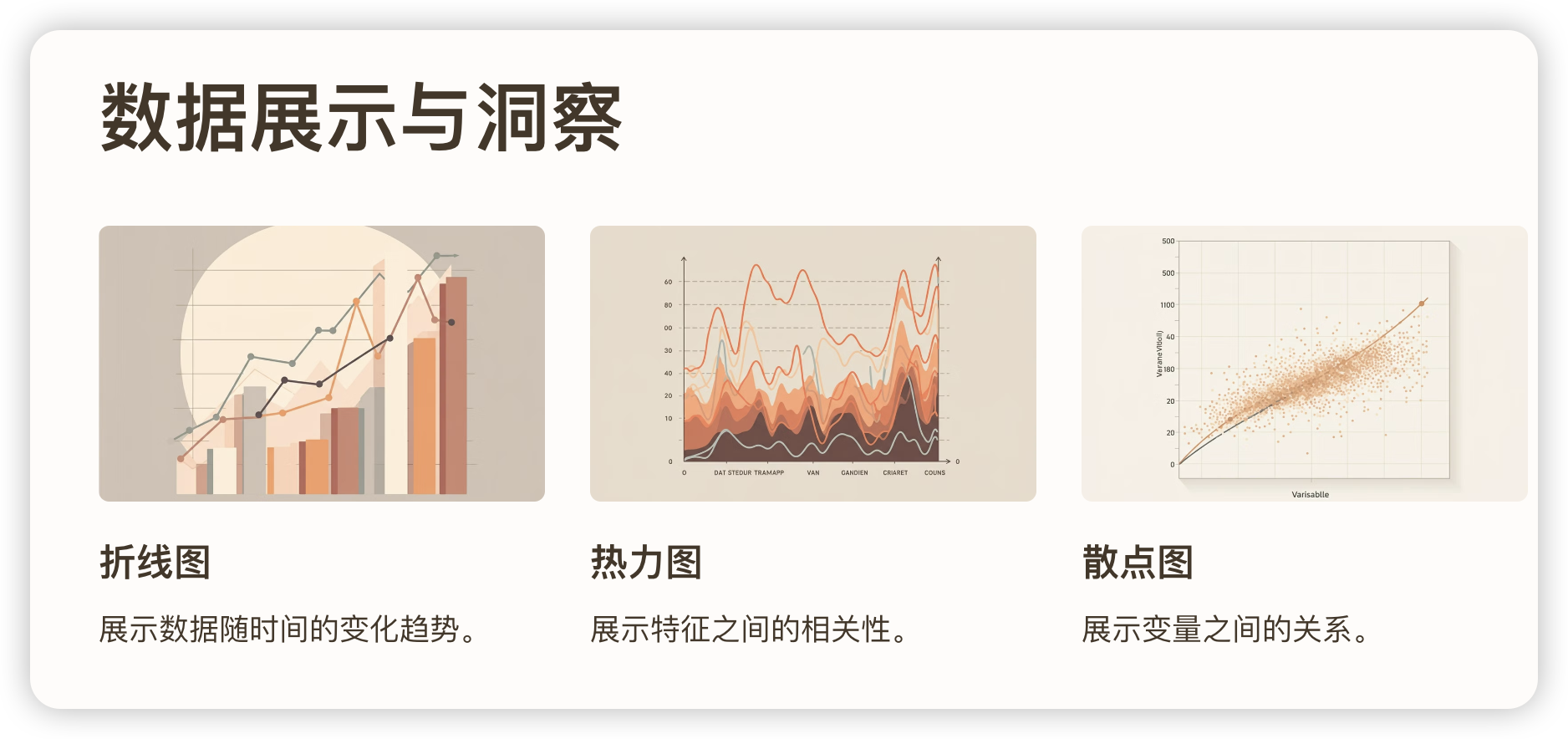

5. 数据展示与洞察

数据展示是让分析结果可视化的关键步骤,它可以帮助我们从数据中挖掘有价值的洞察,做出明智的决策。

常用的数据可视化工具有 matplotlib、seaborn 等,具体的展示方式可以根据分析结果选择适当的图表类型,如折线图、柱状图、散点图等。

示例代码:

import matplotlib.pyplot as plt

import seaborn as sns# 绘制散点图

plt.scatter(X_test, y_pred)

plt.title("实际值 vs 预测值")

plt.xlabel("实际值")

plt.ylabel("预测值")

plt.show()# 使用seaborn绘制热力图

sns.heatmap(data.corr(), annot=True, cmap="coolwarm")

plt.title("特征相关性")

plt.show()

通过清晰的可视化,我们可以迅速识别数据中的趋势、异常和模式,帮助决策者更好地理解数据,最终推动业务增长。

结论

数据分析的流程并不复杂,但要在每一步都做到精益求精,需要技术人员拥有清晰的逻辑和缜密的执行力。从数据获取、清洗到建模和可视化展示,每一步都为最终的洞察奠定了基础。